Die Landschaft der künstlichen Intelligenz und der natürlichen Sprachverarbeitung hat mit der Einführung von SOLAR-10.7B-Instruct-v1.0 von Upstage einen bemerkenswerten Durchbruch erlebt. Dieses bahnbrechende Modell ist nicht nur ein Schritt nach vorn im Bereich des Sprachmodellierens, sondern ein gewaltiger Sprung, der mit seinen 10,7 Milliarden Parametern beispiellose Fähigkeiten demonstriert. Im folgenden Abschnitt werden wir detailliert auf die technischen Einzelheiten des Modells SOLAR-10.7B-Instruct-v1.0 eingehen.

Hauptmerkmale

- Innovative Architektur: Nutzung der Depth-Up-Scaling-Technik in Verbindung mit der Llama2-Architektur.

- Hervorragende Leistung: Übertrifft Modelle mit bis zu 30 Milliarden Parametern, einschließlich des bemerkenswerten Mixtral 8X7B.

- Spezialisiertes Fine-Tuning: Überzeugt bei Einzelgesprächen. SOLAR-10.7B-Instruct-v1.0 setzt einen neuen Maßstab für Präzision und Effizienz.

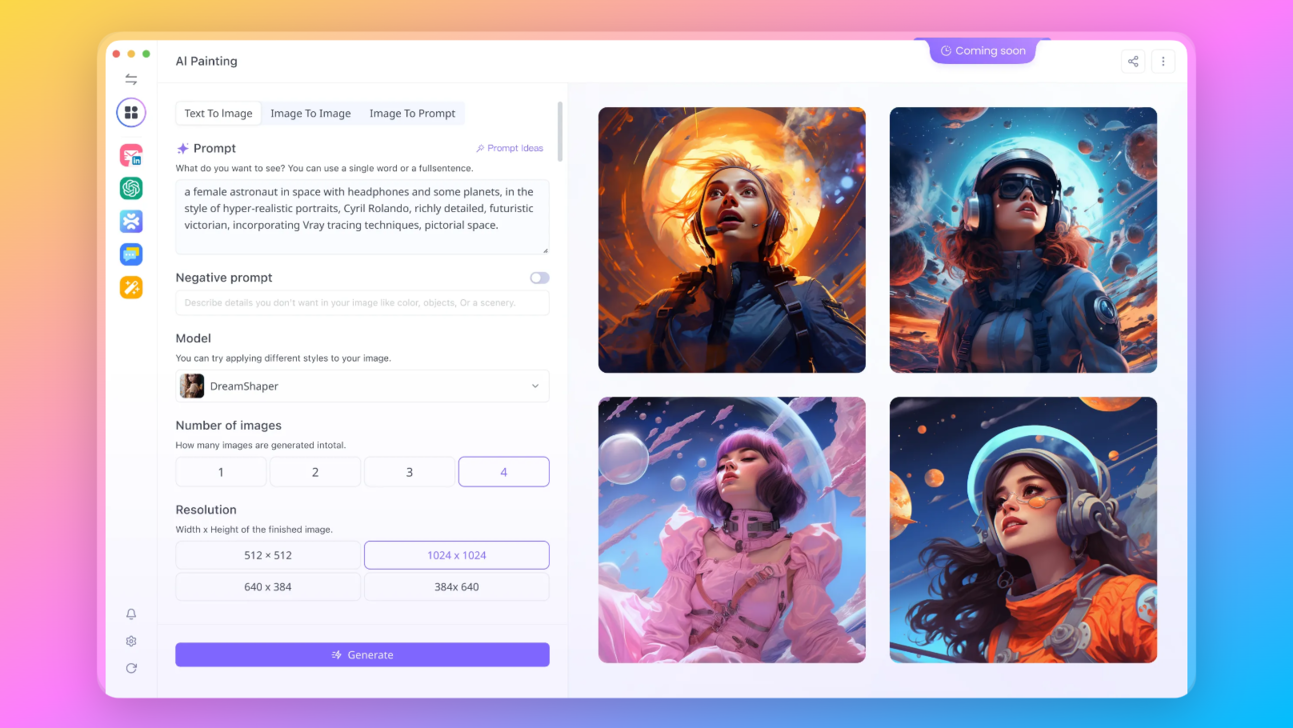

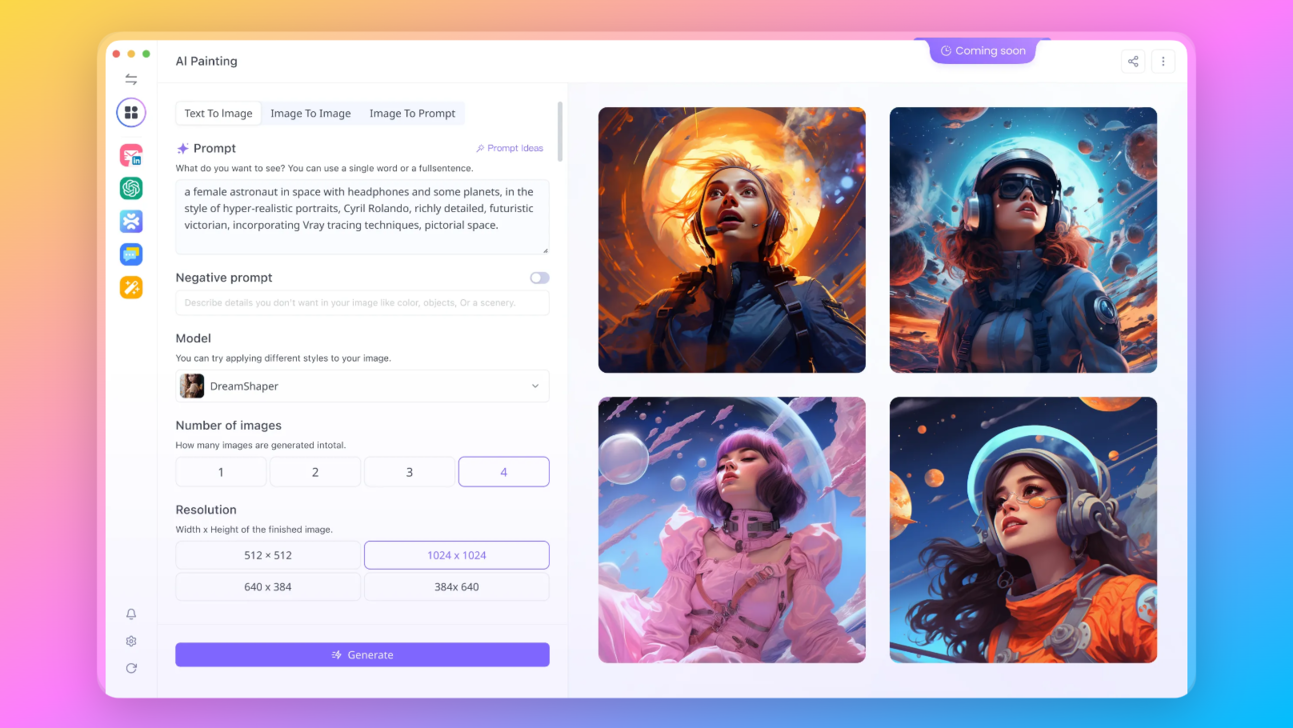

Wollen Sie all diese fantastischen LLMs online testen? Probieren Sie Anakin AI aus!

Anakin AI ist eine der bequemsten Möglichkeiten, um einige der beliebtesten KI-Modelle zu testen, ohne sie herunterladen zu müssen!

Hier sind weitere Open-Source- und kostenlose Modelle, die von Anakin AI unterstützt werden:

- Mistral 7B und 8x7B: die heißesten Namen für Open-Source-LLMs!

- Dolphin-2.5-Mixtral-8x7b: erleben Sie den wilden Westen von unzensiertem Mixtral 8x7B!

- OpenHermes-2.5-Mistral-7B: Eines der leistungsstärksten Mistral-7B-Feinabstimmungsmodelle, probieren Sie es aus!

- OpenChat: Jetzt können Sie Open-Source-Sprachmodelle entwickeln, selbst wenn Ihre Daten unvollkommen sind!

Weitere Modelle sind unter anderem:

- GPT-4: Mit einem beeindruckenden Kontextfenster von bis zu 128k bringt dieses Modell das Deep Learning auf ein neues Level.

- Google Gemini Pro: Googles KI-Modell, das für Präzision und Tiefe bei der Informationen abrufen konzipiert wurde.

- DALLE 3: Erstellen Sie atemberaubende, hochauflösende Bilder aus textuellen Beschreibungen.

- Stable Diffusion: Generieren Sie Bilder mit einem einzigartigen künstlerischen Flair, perfekt für kreative Projekte.

Wollen Sie all diese fantastischen LLMs online testen? Probieren Sie Anakin AI aus!

Anakin AI ist eine der bequemsten Möglichkeiten, um einige der beliebtesten KI-Modelle zu testen, ohne sie herunterladen zu müssen!

Wie funktioniert SOLAR-10.7B-Instruct?

- SOLAR-10.7B-Instruct-v1.0 beherrscht das Befolgen von Anweisungen sehr gut, sogar so gut, dass es dazu neigt, übermäßige Details in seinen Antworten zu berücksichtigen. Diese Präzision erfordert jedoch eine sorgfältige Vorgabe, um das Detailniveau in den Antworten zu steuern.

- Der Schreibstil von SOLAR-10.7B-Instruct-v1.0 ist sehr förmlich und komplex.

- SOLAR-10.7B-Instruct-v1.0 wird durch Vereinigung mit den Gewichten von Mistral 7B erstellt, was seine Lernfähigkeit verbessert und es ihm ermöglicht, Informationen effektiver zu verarbeiten und aufzunehmen.

- Die Grundlage des Modells in der Llama2-Architektur garantiert eine Mischung aus Geschwindigkeit und Genauigkeit und macht es zu einem herausragenden Werkzeug in der Sprachverarbeitung.

Depth Up-Scaling: Eine bahnbrechende Technik?

SOLAR-10.7B stellt die revolutionäre Technik des Depth Up-Scalings vor, die es von herkömmlichen Sprachmodellen unterscheidet. Diese Technik beinhaltet die Verbesserung der Tiefe der neuronalen Netzwerkschichten des Modells, ohne dass dafür eine proportionale Erhöhung der Rechenanforderungen erforderlich ist. Diese Innovation verbessert nicht nur die Effizienz des Modells, sondern steigert auch signifikant dessen Leistung.

Wichtige Aspekte der Tiefenskalierung:

- Integration mit Mistral 7B-Gewichten:

- Auf Llama2-Architektur aufgebaut:

- Weiteres Pre-Training: Nach der Integration unterzieht sich das Modell einer umfangreichen Vor-Trainingsphase, in der seine Fähigkeiten und Anpassungsfähigkeit weiter verfeinert werden.

Das Ergebnis dieser kombinierten Bemühungen ist ein Modell, das nicht nur mit, sondern oft sogar die Leistung von Modellen mit deutlich größeren Parameterzahlen übertrifft. SOLAR-10.7B ist daher ein idealer Kandidat für verschiedene Feinabstimmungsanwendungen aufgrund seiner Robustheit und Anpassungsfähigkeit.

SOLAR-10.7B-Benchmarks: Entspricht dem Hype?

Ergebnisse des Datenkontaminations-Tests

In einer Ära, in der Datenintegrität von höchster Bedeutung ist, sticht SOLAR-10.7B-Instruct-v1.0 mit seinen rigorosen Tests zur Datenkontamination hervor. Die Gewährleistung, dass das Training des Modells frei von benchmark-bezogenen Datensätzen ist, ist von entscheidender Bedeutung für seine Authentizität und Zuverlässigkeit.

| Modell | ARC | MMLU | TruthfulQA | GSM8K |

|---|---|---|---|---|

| SOLAR-10.7B-Instruct-v1.0 | Ergebnis < 0,1, %: 0,06 | Ergebnis < 0,1, %: 0,15 | Ergebnis < 0,1, %: 0,28 | Ergebnis < 0,1, %: 0,70 |

Diese Ergebnisse zeigen die hohe Authentizität des Modells, mit Kontaminationsraten, die weit unter bedenklichen Grenzwerten liegen. Dieser sorgfältige Ansatz beim Training gewährleistet, dass SOLAR-10.7B-Instruct-v1.0 echte und zuverlässige Ausgaben liefert.

Ergebnisse der Evaluierung

Zur weiteren Festigung seiner Wirksamkeit wurde SOLAR-10.7B-Instruct-v1.0 einer umfangreichen Evaluierung im Vergleich zu anderen führenden Modellen unterzogen. Die Evaluierung konzentrierte sich auf mehrere Schlüsselbereiche, darunter der Model H6-Score, der die Leistungsfähigkeit des Modells bei der Verstehens und Beantwortung komplexer Anweisungen widerspiegelt.

| Modell | H6 | Modellgröße |

|---|---|---|

| SOLAR-10.7B-Instruct-v1.0 | 74,20 | ~ 11B |

| mistralai/Mixtral-8x7B-Instruct-v0.1 | 72,62 | ~ 46,7B |

| 01-ai/Yi-34B-200K | 70,81 | ~ 34B |

| 01-ai/Yi-34B | 69,42 | ~ 34B |

| mistralai/Mixtral-8x7B-v0.1 | 68,42 | ~ 46,7B |

| meta-llama/Llama-2-70b-hf | 67,87 | ~ 70B |

| tiiuae/falcon-180B | 67,85 | ~ 180B |

| SOLAR-10.7B-v1.0 | 66,04 | ~ 11B |

| mistralai/Mistral-7B-Instruct-v0.2 | 65,71 | ~ 7B |

| Qwen/Qwen-14B | 65,86 | ~ 14B |

| 01-ai/Yi-34B-Chat | 65,32 | ~ 34B |

| meta-llama/Llama-2-70b-chat-hf | 62,40 | ~ 70B |

| mistralai/Mistral-7B-v0.1 | 60,97 | ~ 7B |

| mistralai/Mistral-7B-Instruct-v0.1 | 54,96 | ~ 7B |

Mit dieser Evaluierung wird die beeindruckende Fähigkeit von SOLAR-10.7B-Instruct-v1.0 bei komplexen Sprachaufgaben unterstrichen, insbesondere im Vergleich zu größeren Modellen. Sein hoher H6-Score zeugt von fortgeschrittenem Verständnis und Verarbeitungsfähigkeiten und setzt einen neuen Standard im Bereich des Sprachmodellings.

Fortgeschrittene Trainings- und Feinabstimmungsstrategien

Die außergewöhnliche Leistung von SOLAR-10.7B-Instruct-v1.0 lässt sich auf seine fortgeschrittenen Trainings- und Feinabstimmungsstrategien zurückführen. Diese Strategien sind darauf ausgerichtet, die Fähigkeit des Modells zu optimieren, eine Vielzahl von Anweisungen und Abfragen mit bemerkenswerter Genauigkeit zu verstehen und zu beantworten.

Wichtige Strategien bei der Modellentwicklung:

- Überwachte Feinabstimmung (SFT): Dieser Ansatz beinhaltet das Training des Modells mit sorgfältig kuratierten Datensätzen, um dessen Antwortgenauigkeit zu verbessern.

- Optimierung der direkten Präferenz (DPO): DPO konzentriert sich darauf, die Ausgaben des Modells mit den Benutzerpräferenzen abzustimmen, um sicherzustellen, dass die Antworten nicht nur genau, sondern auch relevant für die Bedürfnisse des Benutzers sind.

- Verwendung verschiedener Datensätze: Das Modell wurde mit einer Mischung aus Datensätzen trainiert, darunter intern generierte Daten und öffentlich verfügbare Datensätze, um ein umfassendes Lernerlebnis zu gewährleisten.

Gewährleistung der Datenintegrität:

- Vermeidung von Datenkontamination: Es wurde große Sorgfalt darauf verwendet, eine Kontamination der Daten zu verhindern, insbesondere von benchmark-bezogenen Datensätzen, um die Integrität und Zuverlässigkeit des Modells zu gewährleisten.

- Filterung von Aufgaben: Bestimmte Aufgaben wurden während des Trainings herausgefiltert, um Überanpassung und Verzerrung der Modellantworten zu vermeiden.

Die Kombination dieser anspruchsvollen Trainingsmethoden und die strenge Vermeidung von Datenkontamination haben in einem Modell ihren Höhepunkt gefunden, das neue Maßstäbe im Bereich der Sprachverarbeitung setzt.

Ausblick: Die Zukunft des Sprachmodellings

Die Einführung von SOLAR-10.7B-Instruct-v1.0 markiert einen bedeutenden Meilenstein in der Entwicklung von Natural Language Processing und künstlicher Intelligenz. Seine fortschrittliche Architektur und Trainingsstrategien haben neue Möglichkeiten für Forschung und Anwendung eröffnet - von der Verbesserung der AI-gesteuerten Konversation bis hin zur Bereitstellung anspruchsvoller Sprachanalysewerkzeuge.

Auswirkungen auf zukünftige Entwicklungen:

- Neue Maßstäbe setzen: SOLAR-10.7B-Instruct-v1.0 setzt neue Maßstäbe dafür, was im Bereich des Sprachmodellings möglich ist, und fordert andere Modelle und Entwickler heraus, die Grenzen noch weiter zu verschieben.

- Potenzial für vielfältige Anwendungen: Aufgrund seiner Anpassungsfähigkeit und Robustheit kann dieses Modell für eine Vielzahl von Anwendungen, von Kundenbetreuungs-Chatbots bis hin zur fortschrittlichen Forschung in Linguistik und AI, feinabgestimmt werden.

Modellkompatibilität und Leistung bei spezifischen Aufgaben

- Diskussionen über die Kompatibilität des Modells mit bestehenden Tools und Bibliotheken wie Llama cpp und GGUF waren prominent und zeigten ein großes Interesse an praktischen Anwendungen und Benutzerfreundlichkeit.

- Einige Benutzer auf Reddit haben persönliche Benchmarks durchgeführt und berichteten, dass das Modell in einzelnen Dialogen gut funktioniert, aber möglicherweise Schwierigkeiten bei mehrteiligen Interaktionen aufweist.

Bedenken hinsichtlich Datenkontamination und Benchmark-Spielereien

- Es gab Bedenken, ob die Trainingsdaten von SOLAR-10.7B-Instruct-v1.0 auch Testdaten für Ranking-Listen enthielten, was die Leistungsmetriken verfälschen könnte.

- Community-Mitglieder äußerten Skepsis gegenüber Modellen, die hohe Leistung auf der Grundlage potenziell voreingenommener Benchmarks beanspruchen.

Anakin AI

Hier sind weitere Open Source und kostenlose Modelle, die von Anakin AI unterstützt werden:

- Mistral 7B und 8x7B: die heißesten Namen für Open Source LLMs!

- Dolphin-2.5-Mixtral-8x7b: probieren Sie den wilden Westen von unzensierten Mixtral 8x7B aus!

- OpenHermes-2.5-Mistral-7B: Eines der besten Mistral-7B Fine-Tuning-Modelle, probieren Sie es aus!

- OpenChat: Jetzt können Sie Open Source Language Models erstellen, auch wenn Ihre Daten unvollkommen sind!

Weitere Modelle sind:

- GPT-4: Mit einem beeindruckenden Kontextfenster von bis zu 128 KB hebt dieses Modell das Deep Learning auf neue Höhen.

- Google Gemini Pro: Googles KI-Modell für Präzision und Tiefe bei der Informationssuche.

- DALLE 3: Erstellen Sie atemberaubende hochauflösende Bilder aus textuellen Beschreibungen.

- Stable Diffusion: Generieren Sie Bilder mit einer einzigartigen künstlerischen Note, perfekt für kreative Projekte.

Anakin AI

Fazit

Die Einbeziehung dieser Erkenntnisse von tatsächlichen Benutzern und Entwicklern bietet einen nuancierteren Blick auf SOLAR-10.7B-Instruct-v1.0. Sie hebt die Bedeutung von Feedback aus der Community bei der Bewertung und Verbesserung von Sprachmodellen hervor. Diese Perspektive unterstreicht die Stärken des Modells bei der detaillierten Anweisung und sein Potenzial zur weiteren Verbesserung in Bereichen wie Schreibstil und Multi-Turn-Gesprächsfähigkeiten. Darüber hinaus zeigt das aktive Engagement der Community in technischen Diskussionen, Benchmarking und Skepsis gegenüber Leistungsansprüchen einen reifen und differenzierten Ansatz zur Bewertung von KI-Fortschritten.