Ein bemerkenswertes Ereignis in der KI-Landschaft hat gerade stattgefunden. Mixtral 8x7B von Mistral AI sticht als bedeutender Fortschritt heraus. Dieses Open-Source-Modell (LLM) ist nicht nur eine neue Ergänzung, sondern ähnelt einem lokalen Mini-GPT-4.

Mixtral 8x7B: Eine kompakte Version von GPT-4

Mixtral 8x7B ist eine kompakte, effiziente Version von GPT-4 und bietet fortgeschrittene KI-Fähigkeiten in einer handlicheren und zugänglicheren Form.

Indem es eine ähnliche Architektur von Expertenmischungen (MoE), jedoch in einem kleineren Format, annimmt, ermöglicht Mistral AI diverse Anwendungen.

Schlüsselaspekte von Mixtral 8x7B:

- Struktur: Verwendet 8 Experten, jeweils mit 7 Milliarden Parametern, im Vergleich zur größeren Skala von GPT-4.

- Effiziente Verarbeitung: Verwendet nur 2 Experten pro Token für Inferenz, ähnlich der Effizienz von GPT-4.

Technische Parameter:

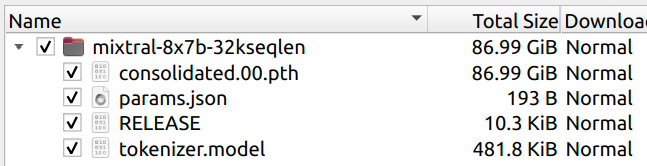

- Größe: Das Modell hat 87 GB, kleiner als ein 8x Mistral 7B, was auf die Verwendung von gemeinsamen Aufmerksamkeitsparametern zur Größenreduktion hinweist.

- Vergleich mit GPT-4: Bietet eine 2-fache Verringerung der Anzahl der Experten und eine 24-fache Verringerung der Parameter pro Experten, was zu einer geschätzten Gesamtzahl von 42 Milliarden Parametern führt.

Kontextkapazität:

- Behält eine Kontextgröße von 32K, ähnlich wie bei GPT-4, um eine robuste Leistung sicherzustellen.

Warum reden alle über Mistral AI's neues LLM?

- Entwickelt von Mistral AI: Dieses in Paris ansässige Startup erregt Aufmerksamkeit durch die Kombination von technischem Fachwissen mit Open-Source-Zugänglichkeit.

- Auswirkungen auf die KI-Branche: Die Veröffentlichung von Mixtral 8x7B signalisiert einen Paradigmenwechsel und stellt bestehende Normen in der Branche in Frage, um die Demokratisierung der KI-Technologie zu fördern.

- Über die Verbesserung von KI-Erfolgen hinaus: Mixtral 8x7B geht über die Verbesserung der Liste von KI-Innovationen hinaus. Es stellt bestehende Standards infrage und eröffnet neue Möglichkeiten für Innovation und Erkundung.

- Wegbereitung für offene, zugängliche KI: Der Ansatz von Mistral AI mit Mixtral 8x7B setzt neue Maßstäbe für Offenheit und Zusammenarbeit bei der KI-Entwicklung.

Download Mixtral 8x7B Torrents

Statt der üblichen aufwendigen Veröffentlichungen hat Mistral AI einen einzigartigen Weg für Mixtral 8x7B gewählt und es über Torrent-Links veröffentlicht.

Hier sind die Torrent-Links für den Download des neuesten Mixtral 87XB-Modells:

magnet:?xt=urn:btih:208b101a0f51514ecf285885a8b0f6fb1a1e4d7d&dn=mistral-7B-v0.1&tr=udp%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce&tr=https%3A%2F%https://t.co/HAadNvH1t0%3A443%2Fannounce

RELEASE ab979f50d7d406ab8d0b07d09806c72c

magnet:?xt=urn:btih:5546272da9065eddeb6fcd7ffddeef5b75be79a7&dn=mixtral-8x7b-32kseqlen&tr=udp%3A%2F%http://2Fopentracker.i2p.rocks%3A6969%2Fannounce&tr=http%3A%2F%http://2Ftracker.openbittorrent.com%3A80%2Fannounce

RELEASE a6bbd9affe0c2725c1b7410d66833e24

Dieser Ansatz steht im starken Kontrast zu den orchestrierten Veröffentlichungen von Unternehmen wie Google und OpenAI. Er konzentriert sich mehr darauf, eine Aussage zu machen, anstatt Spektakel zu erzeugen.

Die unkonventionelle Veröffentlichung hat nicht nur die Fähigkeiten des Modells hervorgehoben, sondern auch Gespräche über die Zukunft der KI-Technologie und die Rolle von Open-Source-Modellen angestoßen.

Mistral vs Google pic.twitter.com/mJSJ252nga

— Manoj Mahalingam (@manojlds) 8. Dezember 2023

Welche Spezifikationen benötige ich, um Mixtral 8x7B lokal auszuführen?

Hier sind die Spezifikationen, die Sie benötigen, um Mixtral-8x7B lokal auszuführen (falls gewünscht):

VRAM-Anforderungen:

- Minimale VRAM: 86GB

- Entspricht den VRAM-Anforderungen eines Modells mit 43B.

- Die gemeinsame Nutzung von Parametern unter den 8x7B-Experten reduziert den VRAM-Verbrauch.

- Eine quantisierte 4-Bit-Version passt in 24GB VRAM.

Berechnungsleistung:

- Die Berechnungsanforderungen entsprechen einem 14B-Modell.

- Jede Token-Generierung erfordert die Ausführung eines 7B "Manager"-Experten und des 7B "Selected"-Experten.

Effizienzüberlegungen:

- Modelle mit Mixture of Experts (MoE) zielen darauf ab, die Berechnungsleistung anstelle von VRAM zu optimieren.

- Die gemeinsame Nutzung von Parametern zwischen den Experten spart etwas VRAM.

Testen Sie Mixtral 8x7B online mit Anakin AI

Anakin AI ist einer der beliebtesten No-Code-KI-App-Builder online, mit dem Sie die Schönheit dieses Wunderkinds LLM online erkunden können. Nutzen Sie jetzt Anakin AI's API:

Fragen Sie sich, "Was ist Mixtral 8x7B"? Lesen Sie unseren Artikel über Mixtral 8x7B, um mehr zu erfahren.

Möchten Sie all diese großartigen LLMs online testen? Probieren Sie Anakin AI aus!

Anakin AI ist eine der bequemsten Möglichkeiten, einige der beliebtesten KI-Modelle zu testen, ohne sie herunterladen zu müssen!

Hier sind die anderen Open-Source- und kostenlosen Modelle, die von Anakin AI unterstützt werden:

- Mistral 7B und 8x7B: die begehrtesten Namen für Open-Source-LLMs!

- Dolphin-2.5-Mixtral-8x7b: Probieren Sie den Wilden Westen des unzensierten Mixtral 8x7B!

- OpenHermes-2.5-Mistral-7B: Eines der besten Mistral-7B Fine-Tuning-Modelle, probieren Sie es aus!

- OpenChat, jetzt können Sie Open Source-Sprachmodelle erstellen, auch wenn Ihre Daten nicht perfekt sind!

Weitere Modelle umfassen:

- GPT-4: Mit einem beeindruckenden Kontextfenster von bis zu 128k führt dieses Modell Deep Learning auf neue Höhen.

- Google Gemini Pro: Googles KI-Modell, das auf Präzision und Tiefe bei der Informationsabfrage ausgelegt ist.

- DALLE 3: Erzeugt atemberaubende, hochauflösende Bilder aus textuellen Beschreibungen.

- Stable Diffusion: Generiert Bilder mit einer einzigartigen künstlerischen Note, ideal für kreative Projekte.

Möchten Sie all diese großartigen LLMs online testen? Probieren Sie Anakin AI aus!

Anakin AI ist eine der bequemsten Möglichkeiten, einige der beliebtesten KI-Modelle zu testen, ohne sie herunterladen zu müssen!

Wie funktioniert Mixtral 8x7B?

Wenn man sich in das Herz von Mixtral 8x7B begibt, findet man ein Wunderwerk moderner KI-Technik, eine Demonstration der Expertise und Vision von Mistral AI. Dieses Modell ist mehr als nur ein kleinerer Nachfolger des weit bekannten GPT-4; es ist ein raffiniertes, effizientes und benutzerfreundliches Werkzeug, das für sich allein steht.

Mixtral 8x7B arbeitet nach dem Prinzip eines Mixture-of-Experts (MoE)-Modells, ein Konzept, das in den letzten Jahren aufgrund seiner Effizienz und Skalierbarkeit an Bedeutung gewonnen hat. Speziell besteht Mixtral 8x7B aus 8 Experten, von denen jeder 7 Milliarden Parameter hat. Dies ist eine signifikante Reduzierung im Vergleich zu den spekulierten 8 Experten mit jeweils 111 Milliarden Parametern des GPT-4. Diese Designentscheidung macht Mixtral nicht nur im Hinblick auf die Rechenanforderungen besser handhabbar, sondern auch vielseitig einsetzbar für verschiedene Anwendungen.

Die Architektur von Mixtral 8x7B ist besonders faszinierend. Sie ist auf Token-Inferenz mit nur 2 der 8 Experten ausgelegt, eine Strategie, die die Verarbeitungseffizienz und Geschwindigkeit optimiert. Diese Herangehensweise spiegelt sich in den Modellsbestandteilen wider, die tiefere Einblicke in dessen Konfiguration bieten:

{

"dim": 4096,

"n_layers": 32,

"head_dim": 128,

"hidden_dim": 14336,

"n_heads": 32,

"n_kv_heads": 8,

"norm_eps": 1e-05,

"vocab_size": 32000,

"moe": {

"num_experts_per_tok": 2,

"num_experts": 8

}

}

Diese Konfiguration zeigt eine fortschrittliche Einrichtung mit einem hochdimensionalen Einbettungsraum (dim: 4096), mehreren Schichten (n_layers: 32) und einer beträchtlichen Anzahl von Köpfen für Aufmerksamkeitsmechanismen (n_heads: 32). Die MoE-Architektur ("moe": {"num_experts_per_tok": 2, "num_experts": 8}) unterstreicht den Schwerpunkt des Modells auf effiziente, spezialisierte Verarbeitung für jedes Token.

Eine der bemerkenswertesten Eigenschaften von Mixtral 8x7B ist seine Fähigkeit, hochentwickelte KI-Funktionen zu bieten und dabei deutlich zugänglicher zu sein als seine größeren Pendants. Diese Zugänglichkeit bezieht sich nicht nur auf die Benutzerfreundlichkeit, sondern auch auf die für den Betrieb erforderlichen Rechenressourcen. Die reduzierte Größe des Modells im Vergleich zu einer hypothetischen Vergrößerung von Mistral 7B im Verhältnis 8x wird durch gemeinsame Aufmerksamkeitsparameter erreicht, eine clevere Designentscheidung, die die Gesamtgröße des Modells deutlich reduziert, ohne die Leistung zu beeinträchtigen.

Auch die praktische Umsetzung von Mixtral 8x7B ist bemerkenswert. Das Design des Modells ermöglicht eine flexible Anpassung an verschiedene Computerumgebungen, von High-End-Servern bis hin zu bescheideneren Einrichtungen. Hier ist ein Einblick, wie Mixtral 8x7B implementiert werden kann:

python example_text_completion.py pfad/zum/mixtral/ pfad/zum/mixtral/tokenizer.model

In diesem einfachen Befehl steht example_text_completion.py für ein Skript, das das Mixtral 8x7B-Modell verwendet, wobei die Pfade auf die Modell- und Tokenizer-Dateien verweisen. Diese einfache Implementierung spricht für das Bestreben von Mistral AI, fortgeschrittene KI-Technologie zugänglicher und benutzerfreundlicher zu machen.

Sie können die Mixtral 8x7B Hugging Face-Seite von jemandem hier besuchen:

Mixtral 8x7B ist ein leistungsstarkes und zugängliches Werkzeug in der KI-Landschaft. Seine technische Raffinesse in Kombination mit seinem pragmatischen Design machen es nicht nur zu einem beeindruckenden LLM, sondern auch zu einem Leitbild dafür, wie zukünftige KI-Modelle aussehen könnten - leistungsstark, effizient und für eine breitere Palette von Benutzern und Anwendungen zugänglich.

So führen Sie Mixtral 8x7B aus - Zwei aktuelle Methoden

Methode 1: Führen Sie Mixtral 8x7B mit diesem Hack aus

Für diejenigen, die sofort mit Mixtral 8x7B experimentieren möchten, existiert eine etwas unorthodoxe, aber funktionale Methode. Dieser Ansatz beinhaltet die Anpassung der ursprünglichen Llama-Codebasis, um mit Mixtral 8x7B zu funktionieren, obwohl zu beachten ist, dass diese Implementierung sich noch in einem frühen Stadium befindet und möglicherweise nicht das volle Potenzial des Modells ausschöpft.

Schlüsselpunkte des Hacks:

Naiv und langsam: Die Implementierung ist zugegebenermaßen grundlegend und nicht für Geschwindigkeit optimiert.

- Hardware-Anforderungen: Um diese Version auszuführen, benötigen Sie entweder zwei 80GB-GPUs oder vier 40GB-GPUs.

- Technische Details: Die Methode beinhaltet das Entfernen der Modellparallelität zur Vereinfachung und das Aufteilen der Experten auf die verfügbaren GPUs. Sie beinhaltet auch eine rückentwickelte MoE-Implementierung, basierend auf diesem Forschungspapier.

Implementierung:

Gewichte herunterladen: Die Mixtral-Modellgewichte sind entweder über Torrent oder im Hugging Face-Repository unter Mixtral 8x7B auf Hugging Face verfügbar.

Ausführen des Modells: Sobald Sie die Gewichte haben, können Sie das Modell auf 2 GPUs (jeweils ca. 45GB benötigend) mit folgendem Befehl ausführen:

python example_text_completion.py pfad/zum/mixtral/ pfad/zum/mixtral/tokenizer.model

Für eine 4-GPU-Konfiguration fügen Sie dem Befehl --num-gpus 4 hinzu.

Methode 2: Führen Sie Mixtral 8x7B mit Fireworks AI aus

Eine alternative, benutzerfreundlichere Möglichkeit, Mixtral 8x7B zu testen, ist über Fireworks.ai.

Fireworks AI bietet ein reibungsloses Erlebnis, obwohl zu beachten ist, dass dies keine offizielle Implementierung von Mistral AI ist.

Schlüsselfunktionen von Fireworks.ai:

- Schneller Zugriff: Das Modell ist nur wenige Stunden nach der erstmaligen Veröffentlichung der Gewichte einsatzbereit und zeigt die Agilität und den gemeinschaftlichen Geist der KI-Community.

- Rückentwickelte Architektur: Die Implementierung auf Fireworks.ai wurde durch Rückentwicklung der Architektur aus den Parameterbezeichnungen in Zusammenarbeit mit der Community erreicht.

Verwendung von Fireworks.ai: - Modellzugriff: Besuchen Sie einfach Fireworks.ai, um Mixtral 8x7B auszuprobieren.

- Einschränkung: Benutzer sollten beachten, dass es sich hierbei nicht um eine offizielle Veröffentlichung handelt und die Ergebnisse variieren können. Updates werden erwartet, sobald Mistral AI den offiziellen Modellcode veröffentlicht.

Methode 3: Führen Sie Mixtral 8x7B mit Ollama aus

Voraussetzungen:

- Vergewissern Sie sich, dass Ihr System über mindestens 48 GB RAM verfügt, um den Anforderungen des Modells gerecht zu werden.

- Installieren Sie Ollama Version 0.1.16. Diese spezifische Version ist erforderlich, um mit dem Mixtral-8x7B-Modell kompatibel zu sein. Sie können sie über den angegebenen Link herunterladen.

Modellübersicht:

- Das Mixtral-8x7B ist ein modernes Large Language Model (LLM) mit Sparse Mixture of Experts (MoE), das von Mistral AI entwickelt wurde.

- Es zeichnet sich durch offene Gewichte und überlegene Leistung aus und übertrifft das Llama 2 70B in verschiedenen Benchmarks.

- Mit einer freizügigen Lizenz ist es für eine Vielzahl von Anwendungen zugänglich und verbindet Kosten und Leistung effizient.

Ausführungsbefehl:

- Um das Modell auszuführen, verwenden Sie den Befehl

ollama run mixtral:8x7b. Dieser Befehl startet das Modell in der OLLAMA-Umgebung.

Verwendungstipps:

- Stellen Sie sicher, dass Ihre Umgebung ordnungsgemäß für OLLAMA konfiguriert ist. Überprüfen Sie, ob Abhängigkeiten oder Umgebungsvariablen eingestellt werden müssen.

- Nach Ausführung des Befehls sollte das Modell starten. Je nach Spezifikationen Ihres Systems kann die Initialisierungszeit variieren.

Nach der Ausführung:

- Sobald das Modell läuft, können Sie gemäß den Anforderungen Ihres Projekts damit interagieren.

- Das Modell ist für eine Vielzahl generativer Aufgaben ausgestattet, was es sowohl für die Forschung als auch für praktische Anwendungen vielseitig macht.

Unterstützung und Updates:

- Regelmäßige Updates und Support stehen zur Verfügung, wie auch durch das kürzliche Update und die Nutzungstatistiken (über 871 Abrufe) angezeigt wird.

- Für Fehlerbehebung und detailliertere Anweisungen konsultieren Sie die Mistral AI-Dokumentation oder die Community-Foren.

Mistral AI: das beste KI-Unternehmen in der Stadt

Die Veröffentlichung von Mixtral 8x7B hat die KI-Gemeinschaft in Aufregung versetzt und eine Reihe von Reaktionen hervorgerufen, die ihre Bedeutung unterstreichen. Enthusiasten, Experten und Entwickler haben alle ihr Gewicht in die Waagschale geworfen und dabei die Auswirkungen des Modells aus verschiedenen Blickwinkeln hervorgehoben.

Positive Reaktionen und konstruktive Kritik: Die Resonanz war größtenteils positiv, wobei viele Mistral AI für ihren innovativen Ansatz und die technischen Fähigkeiten des Modells lobten.

Uri Eliabayev, ein KI-Berater, lobte Mistral für ihre mutige Veröffentlichungsstrategie.

George Hotz, ein bekannter Unternehmer, drückte seine Wertschätzung für die Marke Mistral aus, die er als Favoriten im Bereich KI betrachtet.

Google hat eine Pressemitteilung und eine gefälschte Demo veröffentlicht.

— George Hotz 🌑 (@realGeorgeHotz) 8. Dezember 2023

Mistral hat einen Torrent veröffentlicht.

Diese Begeisterung wird durch konstruktive Kritik gemildert, die hauptsächlich auf die Grenzen des Modells im Vergleich zu größeren Gegenstücken wie GPT-4 abzielt, aber selbst diese Kritiker erkennen das Potenzial von Mixtral 8x7B an.

Am wichtigsten ist jedoch, dass die KI-Gemeinschaft Mistral AIs Engagement für Open-Source-Prinzipien hochschätzt. Dieser Ansatz wurde als Schritt hin zur Demokratisierung der KI-Technologie gefeiert, um sie für eine breitere Palette von Benutzern und Entwicklern zugänglicher zu machen.

Mistral AI: Setzt neue Standards für Open Source LLMs mit Mixtral 8x7B

Wenn wir in die Zukunft blicken, wird der Einfluss von Mixtral 8x7B auf die KI-Landschaft immer deutlicher. Mistral AIs Ansatz bei der Veröffentlichung und Gestaltung von Mixtral 8x7B könnte neue Standards für die Entwicklung und Verbreitung von KI-Modellen setzen.

Mixtral 8x7B ist ein bedeutender Schritt hin zu mehr Open-Source-KI-Lösungen. Sein Erfolg könnte mehr Unternehmen dazu inspirieren, ähnliche Ansätze zu übernehmen, was zu einer vielfältigeren und innovativeren KI-Forschungsumgebung führen könnte.

Wie wird Mixtral 8x7B von Mistral AI die Zukunft der KI und LLM-Entwicklung verändern?

Die begeisterte Aufnahme von Mixtral 8x7B und die daraus resultierenden Gespräche deuten auf einen wachsenden Trend zu offener, kollaborativer KI-Entwicklung hin. Dieses Modell bietet nicht nur ein wertvolles Werkzeug für verschiedene Anwendungen, sondern eröffnet auch neue Möglichkeiten für Innovation, Erkundung und Diskussion in der KI-Branche.

Wenn wir in die Zukunft blicken, wird Mixtral 8x7B eine entscheidende Rolle bei der Gestaltung der KI spielen. Seine Auswirkungen werden sich voraussichtlich auf Branchen und Gemeinschaften auswirken und weitere Fortschritte vorantreiben sowie den Zugang zur modernsten KI-Technologie demokratisieren. Zusammenfassend ist Mixtral 8x7B nicht nur ein Meilenstein für Mistral AI, sondern ein Meilenstein für die gesamte KI-Gemeinschaft, der einen Wandel zu inklusiverer, kollaborativerer und offenerer KI-Entwicklung signalisiert.

Wollen Sie all diese tollen LLMs online testen? Probieren Sie Anakin AI aus!

Anakin AI ist eine der bequemsten Möglichkeiten, einige der beliebtesten KI-Modelle zu testen, ohne sie herunterladen zu müssen!