In der sich ständig weiterentwickelnden Landschaft der künstlichen Intelligenz hat gerade eine bahnbrechende Entwicklung Einzug gehalten. Lernen Sie Mamba kennen: eine hochmoderne State-Space-Modellarchitektur, die darauf abzielt, die Maßstäbe für Sequenzmodellierung neu zu definieren. Dieses innovative Modell ist nicht nur ein technologischer Fortschritt; es ist ein Paradigmenwechsel, der eine neue Ära der Effizienz und Leistung im maschinellen Lernen signalisiert.

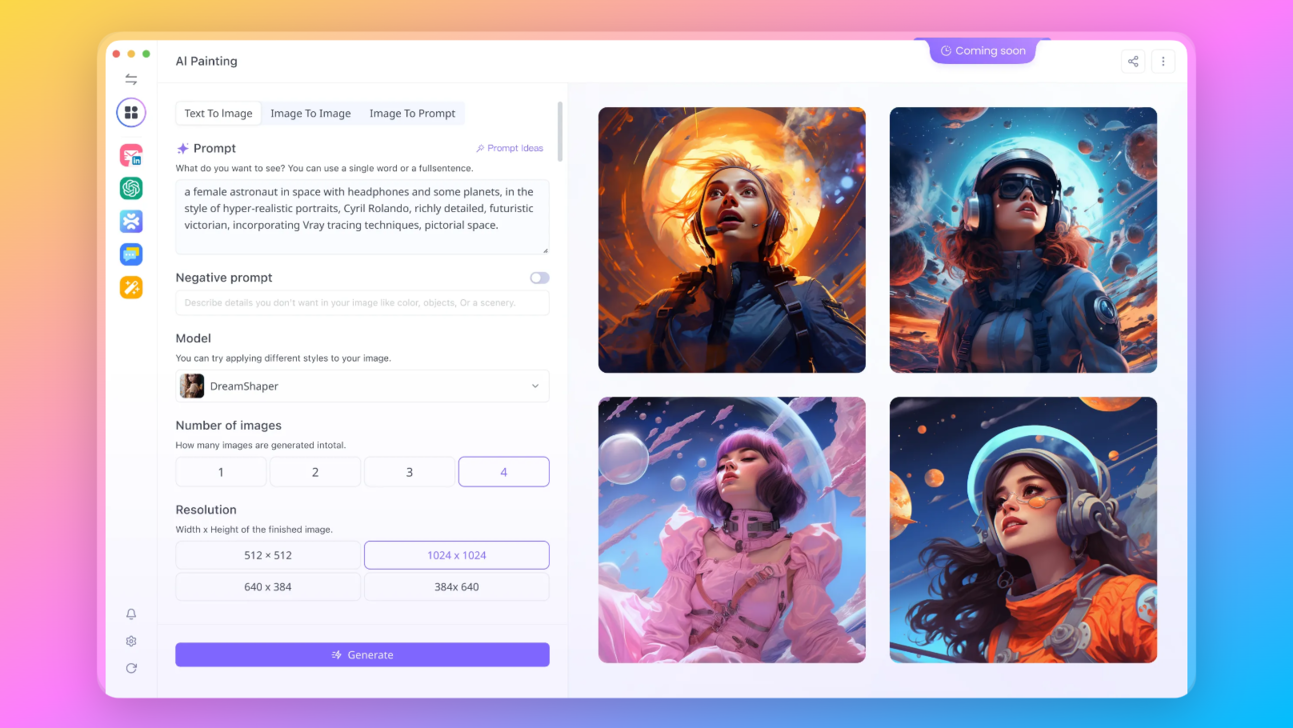

Keine Sorge. Mit Anakin AI können Sie diese großartigen Language Models mit nur einem Klick leicht testen!

Hier sind die anderen Open-Source- und kostenlosen Modelle, die von Anakin AI unterstützt werden:

- Mistral 7B und Mixtral 8x7B

- Openchat

- RWKV v5

- MythoMist

- Zephyr

- Nous Capybara

- Google Gemini Pro

- GPT-4

- Claude-2.1 und Claude Instant

Haben Sie Ihr Lieblingsmodell hier nicht gefunden? Treten Sie dem Anakin AI Discord bei und machen Sie einen Vorschlag!

Anakin AI unterstützt auch AI-Bildgenerierungs-APIs wie:

- DALLE 3: Erstellen Sie atemberaubende, hochauflösende Bilder aus textuellen Beschreibungen.

- Stable Diffusion: Generieren Sie Bilder mit einer einzigartigen künstlerischen Note, perfekt für kreative Projekte.

Interessiert an den neuesten Modellen von Mistral? Probieren Sie es jetzt bei Anakin.AI aus!

Was ist Mamba?

Mamba ist das Werk der renommierten Forscher Albert Gu und Tri Dao, ein State-Space-Modell (SSM), das feinabgestimmt wurde, um sich bei der Verarbeitung komplexer, informationsreicher Daten auszuzeichnen. Seine Gestaltung geht auf die Notwendigkeit einer effizienteren Methode der Sequenzmodellierung ein, insbesondere im Bereich der natürlichen Sprachverarbeitung, Genomik und Audiobearbeitung.

Quadratic attention has been indispensable for information-dense modalities such as language... until now.

— Albert Gu (@_albertgu) 4. Dezember 2023

Announcing Mamba: a new SSM arch. that has linear-time scaling, ultra long context, and most importantly--outperforms Transformers everywhere we've tried.

With @tri_dao 1/ pic.twitter.com/vXumZqJsdb

Die Bedeutung von Mamba verstehen

Was unterscheidet Mamba in der überfüllten Welt der maschinellen Lernmodelle? Es ist die Kombination aus schnellem linearem Skalieren und einer selektiven SSM-Schicht, die es ermöglicht, bestehende Modelle zu übertreffen, insbesondere Transformers, die bisher die erste Wahl für viele KI-Anwendungen waren. Mambas Architektur wurde mit dem Ziel entwickelt, Hardware-Aspekte zu berücksichtigen und für die heute verfügbaren leistungsstarken Berechnungsressourcen zu optimieren.

- Lineares Skalieren: Mamba kann Sequenzen linear mit der Sequenzlänge verarbeiten, anstatt quadratisch wie herkömmliche Modelle.

- Selektive SSM-Schicht: Im Kern von Mamba befindet sich eine selektive State-Space-Schicht, die das Modell ermöglicht, Informationen entlang der Sequenz selektiv zu propagieren oder zu unterdrücken, basierend auf der Eingabe bei jedem Schritt.

- Hardware-orientiertes Design: Inspiriert von FlashAttention berücksichtigt das Design von Mamba die Hardware, auf der es arbeitet, und ermöglicht so maximale Effizienz.

Indem es sich dem strukturierten Ansatz von State-Space-Modellen annimmt und ihn mit einem hardwareorientierten Blickwinkel verfeinert, positioniert sich Mamba als mächtiges Werkzeug im Arsenal der Machine-Learning-Praktiker.

Die technische Fähigkeit von Mamba

Um die Genialität hinter Mamba wirklich zu schätzen, muss man sich mit seinen technischen Spezifikationen befassen. Es ist für den Betrieb in einem Linux-System mit NVIDIA-GPU-Unterstützung entwickelt und nutzt die Leistung von PyTorch 1.12+ und CUDA 11.6+, um unübertroffene Effizienz und Leistung zu liefern. Der Installationsprozess ist mit Pip-Befehlen optimiert und damit für eine Vielzahl von Benutzern zugänglich, von akademischen Forschern bis hin zu Industrieprofis.

Lesen Sie hier mehr über das Mamba-Papier:

Installation und Anforderungen von Mamba

Bevor Sie sich mit den Fähigkeiten von Mamba befassen können, müssen Sie die Voraussetzungen und Installationsschritte verstehen, um sein volles Potential auszuschöpfen. Hier ist eine kurze Zusammenfassung für technisch versierte Benutzer:

- Betriebssystem: Mamba erfordert eine Linux-Umgebung.

- Hardware-Anforderungen: Eine NVIDIA-GPU ist unerlässlich, da Mamba darauf ausgelegt ist, die Parallelverarbeitung optimal zu nutzen.

- Software-Abhängigkeiten: Kompatibilität mit PyTorch 1.12+ und CUDA 11.6+ ist ein Muss, um Mamba effizient auszuführen.

Die innovative Architektur und das Design von Mamba

Die Architektur von Mamba ist ein Zeugnis für die innovativen Fortschritte im maschinellen Lernen. Es stellt eine selektive Zustandsraummodell (SSM) Schicht vor, die grundlegend ändert, wie Modelle Sequenzen verarbeiten. Aber was bedeutet das in der Praxis?

Der Kern von Mamba: Selektive SSM-Schicht

Die selektive SSM-Schicht ist das Herzstück von Mamba. Im Gegensatz zu traditionellen Sequenzmodellen, die alle Eingabedaten gleich behandeln, ermöglicht es die selektive SSM-Schicht Mamba:

- Sich auf relevante Informationen zu konzentrieren: Indem die Bedeutung jeder Eingabe unterschiedlich gewichtet wird, kann Mamba Informationen priorisieren, die für die jeweilige Aufgabe vorhersagender sind.

- Sich dynamisch an die Eingabe anpassen: Die Modellparameter passen sich der Eingabe an und ermöglichen es Mamba, eine Vielzahl von Aufgaben zur Sequenzmodellierung effektiv zu bewältigen.

Das Ergebnis ist ein Modell, das Sequenzen mit beispielloser Effizienz verarbeiten kann, was es zu einem idealen Kandidaten für Aufgaben macht, die lange Sequenzen von Daten beinhalten.

Hardware-Bewusstes Design: Optimiert für Leistung

Die Designphilosophie von Mamba basiert auf dem Verständnis der modernen Hardwarefähigkeiten. Es wurde entwickelt, um die Rechenressourcen von GPUs voll auszunutzen und sicherzustellen, dass:

- Die Speicherauslastung optimiert ist: Die State-Erweiterung von Mamba ist so konstruiert, dass sie in den High-Bandwidth-Speicher (HBM) von GPUs passt, was die Datenübertragungszeiten reduziert und die Berechnung beschleunigt.

- Die parallele Verarbeitung maximiert wird: Indem Mambas Berechnungen mit der parallelen Natur der GPU-Verarbeitung abgestimmt werden, erreicht Mamba eine Leistung, die einen neuen Standard für Sequenzmodelle setzt.

Installation und Systemanforderungen für Mamba

Um mit Mamba zu beginnen, müssen Benutzer ein paar technische Anforderungen erfüllen. Hier ist, was Sie wissen müssen:

Schritt-für-Schritt Installationsanleitung

- Stellen Sie sicher, dass Sie ein Linux-System mit NVIDIA-GPU-Unterstützung haben.

- Überprüfen Sie, ob PyTorch 1.12+ und CUDA 11.6+ installiert sind.

- Verwenden Sie die folgenden Befehle, um Mamba und seine erforderlichen Komponenten zu installieren:

pip install causal-conv1d

pip install mamba-ssm

Aufschlüsselung der technischen Anforderungen

- Linux-Betriebssystem: Eine stabile und kompatible Umgebung für die Ausführung von Mamba.

- NVIDIA-GPU: Zur Nutzung der parallelen Rechenfähigkeiten.

- PyTorch 1.12+: Stellt die Kompatibilität mit den neuesten Machine-Learning-Bibliotheken sicher.

- CUDA 11.6+: Eine parallele Computing-Plattform, die zum Ausführen von GPU-beschleunigten Anwendungen erforderlich ist.

Indem diese Anforderungen erfüllt werden, können Benutzer das volle Potenzial von Mamba entfesseln und sich auf eine Reise der leistungsstarken Sequenzmodellierung begeben.

Mamba nutzen: Ein Leitfaden für Verwendung und Implementierung

Die Nutzung von Mamba ist ein unkomplizierter Vorgang, dank seines gut dokumentierten Codebases und benutzerfreundlicher APIs. Egal ob Sie einen Mamba-Block implementieren oder in ein vollständiges Sprachmodell integrieren, der Prozess ist darauf ausgelegt, so nahtlos wie möglich zu sein.

Implementieren des Mamba-Blocks

Der Mamba-Block ist das Bauelement der Architektur, das um den selektiven SSM gewickelt ist. Hier ist ein Blick darauf, wie man einen Mamba-Block implementiert:

- Definieren Sie die Modellabmessungen und instanziieren Sie das Mamba-Modul.

- Leiten Sie Ihre Daten durch das Modell, um Ausgaben zu erhalten.

Jeder Schritt in der Implementierung basiert auf einem umfassenden Verständnis der Anforderungen der Sequenzmodellierung, was sicherstellt, dass Mamba sich an Ihre Anforderungen anpasst, egal ob Sie mit Sprach-, Audio- oder anderen Sequenzdaten arbeiten.

Erstellen eines Sprachmodells mit Mamba

Mamba glänzt in der Sprachmodellierung und bietet ein vollständiges Beispiel für ein Sprachmodell, das auf seiner Architektur aufbaut. Durch stapeln von Mamba-Blöcken und Kombination mit einem Sprachmodellkopf können leistungsstarke Modelle erstellt werden, die in der Lage sind, Text zu verstehen und zu generieren.

- Wiederholen von Mamba-Blöcken: Um das Verständnis des Modells zu vertiefen.

- Sprachmodellkopf: Um Vorhersagen zu generieren.

Sorgfältige Codebeispiele und umfangreiche Dokumentation führen Benutzer durch den Prozess der Modellerstellung und gewährleisten, dass auch diejenigen, die neu in diesem Bereich sind, die Fähigkeiten von Mamba nutzen können.

Vorab trainierte Modelle und Leistungsmetriken

Der Zugriff auf die Leistung von Mamba erfordert keinen Neustart, dank einer Reihe von vorab trainierten Modellen, die auf HuggingFace verfügbar sind. Diese Modelle, die von 130 Millionen bis 2,8 Milliarden Parametern reichen, wurden auf dem Pile-Datensatz rigoros trainiert und verstehen daher umfassend Sprachmuster.

Einblicke in Mambas vorab trainierte Modelle

- Vielfältige Palette: Mit Modellen unterschiedlicher Größe spricht Mamba verschiedene Rechenbedürfnisse und Leistungsbenchmarks an.

- Fortschrittliche Benchmarking : Mamba-Modelle folgen den Größenstandards von GPT-3 und versprechen vergleichbare oder überlegene Leistung.

Der wahre Beweis für die Fähigkeiten von Mamba liegt in seinen Leistungsmetriken. Das Modell zeigt nicht nur eine verbesserte Effizienz bei der Inferenzgeschwindigkeit, sondern zeigt auch signifikante Verbesserungen der Genauigkeit in einer Vielzahl von Aufgaben.

Leistungserwartungen

- Hohe Durchsatzrate: Der Inferenzprozess von Mamba ist bemerkenswert schneller und daher ideal für Anwendungen, die schnelle Antworten erfordern.

- Genauigkeit: Mamba zeigt in Zero-Shot-Evaluationen durchweg eine höhere Genauigkeit, was auf sein robustes Verständnis der Daten hinweist.

Bewertung von Mamba: Benchmarking und Zero-Shot-Evaluationen

Mambas Fähigkeiten werden durch Zero-Shot-Evaluationen weiter untermauert.

Diese Bewertungen messen die Fähigkeit eines Modells, Wissen auf neue Aufgaben anzuwenden, ohne zuvor auf diese spezifischen Aufgaben trainiert worden zu sein.

Methodik für Zero-Shot-Bewertungen

- Verwenden der Bibliothek lm-evaluation-harness: Dieses Tool erleichtert den Bewertungsprozess und ermöglicht eine standardisierte Bewertung der Leistung von Mamba.

- Ausführung einer Reihe von Aufgaben: Durch die Prüfung von Mamba in verschiedenen Herausforderungen wird seine Vielseitigkeit und Robustheit gründlich bewertet.

Trotz des inhärenten Rauschens im Bewertungsprozess sind die Ergebnisse von Mamba beeindruckend konsistent und unterstreichen seine Zuverlässigkeit.

Mamba in der Praxis: Inferenz und Anwendungen in der realen Welt

Mambas Anwendungen in der realen Welt sind so vielfältig wie wirkungsvoll. Vom Generieren von Textinhalten bis zur Analyse von genomischen Sequenzen sind die potenziellen Verwendungen umfangreich.

Hochgeschwindigkeits-Inferenz mit Mamba

- Schnelle Vervollständigung von Textanweisungen: Mamba kann schnell Vervollständigungen für Textanweisungen generieren und demonstriert damit seine schnellen Inferenzfähigkeiten.

- Batch-Verarbeitung: Das Modell zeichnet sich durch seine Fähigkeit zur Verarbeitung großer Datenmengen aus und bietet eine hohe Genauigkeit und Geschwindigkeit.

Mambas Praktikabilität ist nicht nur theoretisch, sondern wird auch in verschiedenen Bereichen durch seine Bereitstellung demonstriert und zeigt seine Anpassungsfähigkeit und Effizienz.

Die Zukunft von Mamba in der KI

Mambas Einzug in das KI-Ökosystem hat Aufregung und Spekulationen über seine zukünftige Auswirkung ausgelöst. Seine Fähigkeit, mühelos mit längeren Sequenzen umzugehen, und seine Benchmark-Ergebnisse legen nahe, dass Mamba eine entscheidende Rolle in der Entwicklung fortschrittlicher KI-Systeme spielen könnte.

Reaktionen der Community und Meinungen von Experten

- Begeisterte Aufnahme: Die KI-Community hat Mamba begeistert aufgenommen und ist von seinen Fähigkeiten fasziniert.

- Anerkennung durch Experten: Fachleute auf diesem Gebiet haben das Potenzial von Mamba anerkannt und eine Veränderung in der Herangehensweise an die Sequenzmodellierung vorhergesehen.

Wie im Artikel festgestellt wird, wird deutlich, dass Mamba nicht nur ein weiteres Modell ist, sondern ein Vorreiter für die Zukunft der Sequenzmodellierung, der einen neuen Maßstab dafür setzt, was im Bereich der KI möglich ist.

Der Weg nach vorne für Mamba und KI

Wenn die KI-Community in die Zukunft blickt, sticht Mamba als Symbol für Innovation heraus und signalisiert neue Möglichkeiten zur Bewältigung komplexer Sequenzmodellierungs-Herausforderungen. Seine Einführung ist mehr als nur ein technischer Meilenstein; es ist ein Schritt in Richtung effizienterer, skalierbarer und intelligenterer Systeme, die Sequenzen mit beispiellosem Tiefgang verstehen und verarbeiten können.

Das Potenzial von Mamba nutzen

Die potenziellen Anwendungen von Mamba sind so umfangreich wie die Datensequenzen, die es analysieren kann. Von Echtzeit-Sprachübersetzung bis zur Entschlüsselung der Geheimnisse unserer DNA können die Fähigkeiten von Mamba in verschiedenen Bereichen genutzt werden:

- Gesundheitswesen: Beschleunigung der genomischen Datenanalyse für Durchbrüche in der personalisierten Medizin.

- Finanzen: Analyse von Markttrends über lange Zeiträume, um die Vorhersage von Aktienbewegungen mit höherer Genauigkeit zu ermöglichen.

- Kundenservice: Unterstützung von Chatbots, die über lange Gespräche hinweg Kontext aufrechterhalten und so die Benutzererfahrung verbessern können.

Beteiligung der Community und gemeinsames Wachstum

Der Erfolg von Mamba hängt nicht nur von seiner technischen Leistungsfähigkeit ab, sondern auch von der Beteiligung der Community. Open-Source-Beiträge, geteilte vorab trainierte Modelle und gemeinsame Forschung sind Schlüsselfaktoren, die darüber entscheiden werden, welchen Weg Mamba auf dem Gebiet der KI einschlagen wird.

- Open-Source-Beiträge: Entwickler und Forscher werden ermutigt, zum Code von Mamba beizutragen, um robustere und vielseitigere Modelle zu entwickeln.

- Geteilte Ressourcen: Durch das Teilen von vorab trainierten Modellen kann die Community von gemeinsamem Wissen und gemeinsamen Anstrengungen profitieren und den Fortschritt beschleunigen.

- Gemeinsame Forschung: Gemeinsame Projekte zwischen Wissenschaft und Industrie können die Grenzen dessen, was Mamba erreichen kann, erweitern.

Die Rolle von Mamba in der Förderung der KI

Mamba ist dazu bestimmt, eine bedeutende Rolle bei der Weiterentwicklung von KI-Technologien zu spielen. Seine Effizienz und Leistungsfähigkeit schaffen die Grundlage für die Entwicklung anspruchsvollerer Modelle und Anwendungen und könnten somit zu einer neuen Welle von KI-Durchbrüchen führen.

- Grundlage für zukünftige Modelle: Mamba könnte die zugrunde liegende Architektur für die nächste Generation modernster KI-Modelle darstellen.

- Ermöglichung längerer Kontexte: Dank seiner Fähigkeit, lange Sequenzen zu verarbeiten, eröffnet Mamba die Möglichkeit für kontextbewusste KI, was zu nuancierteren und intelligenteren Systemen führt.

Fazit: Mamba als Grundpfeiler der modernen KI

Mamba ist nicht nur ein inkrementelles Update vorhandener Sequenzmodelle; es definiert neu, was möglich ist. Seine Ankunft markiert ein neues Kapitel in der KI, in dem Beschränkungen hinsichtlich Sequenzlänge und Rechenineffizienz zu Relikten der Vergangenheit werden.

In wenigen Jahren haben wir den Übergang von RNNs zu Transformers und nun zu Mamba miterlebt, wobei jeder Fortschritt uns näher zu KI bringt, die wie ein Mensch denken und Informationen verarbeiten kann. Mambas lineares Skalieren und sein selektiver Ansatz für Zustandsräume verkörpern den innovativen Geist, der das Feld der KI vorantreibt.

Wenn Forscher, Entwickler und Enthusiasten sich um Mamba versammeln, wird deutlich, dass dies mehr als nur ein technologischer Triumph ist: Es ist ein gemeinsamer Schritt in Richtung einer Zukunft, in der KI nahtlos in jeden Aspekt unseres digitalen Lebens integriert wird und selbst die komplexesten Sequenzmodellierungsaufgaben mühelos erscheinen lässt.

Kurz gesagt ist Mamba nicht das Ende der Reise; es ist ein vielversprechender Anfang. Es ist ein Modell, das nicht nur für die Gegenwart, sondern auch für die Zukunft entwickelt wurde - eine Zukunft, in der das Potenzial der KI grenzenlos ist und ihre Auswirkungen tiefgreifend sind.

Probieren Sie Anakin AI aus, mit dem Sie ganz einfach KI-Apps mit den neuesten GPT-4, Claude, Stable Diffusion, DALL-E 3 Modellen erstellen können!

Keine komplizierte Programmierung erforderlich. Starten Sie einfach die Anakin AI-Konsole, und los geht's!