Die digitale Ära lebt von Innovationen, und im Herzen davon liegt die Suche nach intelligenter Automatisierung. Betreten Sie die Welt der Sprachmodelle, in der Mistral-Medium und GPT-3.5 Turbo als bedeutende Akteure hervortreten. Ihre Sprachkompetenz und ihr Verständnis sind nicht nur eine programmtechnische Meisterleistung, sondern ein Ballett aus Algorithmen und Daten, bei dem jeder Schritt darauf abgestimmt ist, menschliche Kognition zu imitieren.

Ist Mistral-Medium der überlegene Konkurrent für GPT-3.5 Turbo?

- Kurz gesagt: Ja! Mistral-Medium ist die perfekte Alternative zu GPT-3.5 Turbo. Die Qualität der Ausgabe und seine robuste Leistung zu einem angemessenen Preis haben Entwickler von KI-Apps in Begeisterung versetzt.

- Allerdings hat OpenAI den Preis von GPT-3.5 Turbo gesenkt, was die Attraktivität des Mistral-Medium-Modells verringert.

Daher vergleichen wir die Vor- und Nachteile der beiden Modelle und bewerten ihre Leistung in der Praxis. Wir werden auch ihre Preise im Detail vergleichen.

Vergleich von Mistral-Medium und GPT-3.5 Turbo: die Leistung

Vergleichsmethodik

Diese Vergleichsstudie, durchgeführt von Reddit-Benutzer @Kinniken, wurde nicht nur entwickelt, um die Modelle zu bewerten, sondern auch um die Feinheiten ihrer Wissensbasis, ihrer Fähigkeiten zur Argumentation und ihrer Fähigkeit zur Unterscheidung von Fakt und Fiktion zu beleuchten, was in einer Ära, in der von KI generierte Inhalte allgegenwärtig sind, von entscheidender Bedeutung ist.

Die angewandte Methodik zur Bewertung und zum Vergleich der KI-Modelle – Mistral-Small, Mistral-Medium, GPT-3.5 Turbo und GPT-4 – umfasste eine strukturierte Vorgehensweise in drei verschiedenen Bereichen: allgemeines Wissen, Fähigkeiten zur Argumentation und Umgang mit Halluzinationen.

- Allgemeines Wissen: Beide Modelle sind hervorragend, aber GPT-3.5 Turbo sticht oft durch seine umfangreiche Datenbasis hervor.

- Argumentation: GPT-4 zeigt eine gelegentlich überlegene Kontexterkennung und deutet auf eine höhere Komplexität im Verständnis hin.

- Umgang mit Halluzinationen: Mistral-Medium schneidet besser ab und deutet auf einen nuancierten Ansatz zur Unterscheidung von Fiktion und Tatsachen hin.

Jedes Modell wurde mit identischen Anfragen über direkte API-Aufrufe für die Mistral-Varianten und über die Playground-Schnittstelle für die GPT-Versionen konfrontiert. Dies gewährleistete faire Bedingungen, wobei Unterschiede in der Leistung ausschließlich auf die Fähigkeiten der Modelle und nicht auf unterschiedliche Abfragebedingungen zurückzuführen sind.

Leistung im allgemeinen Wissen

Bei der Beurteilung der Fähigkeiten von KI-Modellen im allgemeinen Wissen ergeben sich unterschiedliche Leistungsniveaus:

| Modell | Punktzahl (/10) |

|---|---|

| Mistral-Small | 4,5 |

| Mistral-Medium | 8 |

| GPT-3.5-Turbo | 7,5 |

| GPT-4 | 9 |

- Mistral-Small zeigt grundlegende Kenntnisse, stößt jedoch bei komplexeren Anfragen oft an Grenzen.

- Mistral-Medium zeigt eine deutliche Verbesserung und legt eine solide Wissensbasis nahe.

- GPT-3.5-Turbo liefert gute Leistungen, jedoch sind Nuancen bei der Abfrage sichtbar.

- GPT-4 überzeugt durch eine überlegene Beherrschung und navigiert geschickt durch verschiedene Themen.

Die Stärken und Schwächen der Modelle sind deutlich: Mistral-Small zeigt trotz insgesamt niedrigerer Leistung eine grundlegende Kenntnisgrundlage. Der Leistungssprung von Mistral-Medium deutet auf eine erweiterte Datensatz oder verbesserte Verarbeitungsmechanismen hin. Die Ergebnisse von GPT-3.5 Turbo zeigen ein nuanciertes Verständnis von Anfragen, lassen jedoch Lücken in der Gründlichkeit erkennen. Die Spitzenposition von GPT-4 unterstreicht ein raffiniertes Verständnis- und Abrufsystem, das präzise mit komplexen Details umgeht.

Fähigkeiten zur Argumentation

Die Argumentationsfähigkeit jedes Modells wurde wie folgt quantifiziert:

| Modell | Durchschnittliche Punktzahl (/11) |

|---|---|

| Mistral-Small | 6,33 |

| Mistral-Medium | 7 |

| GPT-3.5-Turbo | 1 |

| GPT-4 | 7,67 |

Die Fähigkeit von GPT-4 zur Kontexterkennung ist offensichtlich und übertrifft seine Vorgänger bei der Anwendung logischer Strukturen auf Probleme. Die Sensibilität für die Formulierung von Fragen spielt eine entscheidende Rolle und deutet auf ein nuanciertes Verständnis von Sprache und deren Implikationen für logisches Schlussfolgern hin.

Hier ist das originale Testergebnis, das von Reddit-Benutzer @Kinniken gepostet wurde:

Umgang mit Halluzinationen

In Bezug auf Halluzinationen - Antworten auf nicht-faktische Anfragen - unterscheiden sich die Modelle:

| Modell | Punktzahl (/10) |

|---|---|

| Mistral-Small | 4,5 |

| Mistral-Medium | 3 |

| GPT-3.5-Turbo | 0 |

| GPT-4 | 6 |

- Mistral-Small zeigt eine bemerkenswerte Zurückhaltung und vermeidet oft Fiktion.

- Mistral-Medium hat Schwierigkeiten und neigt gelegentlich zur Erzeugung von Fiktion.

- GPT-3.5-Turbo scheint am anfälligsten zu sein und erkennt falsche Inhalte nicht.

- GPT-4 vereint Kreativität mit Unterscheidungsvermögen und generiert nur selten unbegründete Inhalte.

Die Leistung von Mistral-Small ist bemerkenswert und deutet auf einen potenziellen Schutzmechanismus gegen die Erzeugung irreführender Inhalte hin - ein wichtiger Aspekt für Content-Ersteller, die auf Genauigkeit abzielen. Diese Fähigkeit, Fakten von Fiktion zu unterscheiden, wirkt sich auf die Verlässlichkeit und Vertrauenswürdigkeit von von KI generierten Inhalten aus und positioniert bestimmte Modelle als besser geeignet für Aufgaben, bei denen eine genaue Faktentreue erforderlich ist.

Hier ist das originale Testergebnis, das von Reddit-Benutzer @Kinniken gepostet wurde:

Wer ist das bessere Modell? Mistral-Medium oder GPT-3.5 Turbo?

Im komplexen Zusammenspiel der KI-Fähigkeiten haben sowohl GPT-3.5 Turbo als auch Mistral-Medium bemerkenswerte Leistungen in verschiedenen Bereichen gezeigt.

- GPT-3.5 Turbo mit seiner umfangreichen Wissensbasis liefert beeindruckende Ergebnisse im Verständnis, insbesondere im allgemeinen Wissen.

- Allerdings ist Mistral-Medium wesentlich besser im Umgang mit Halluzinationen und deutet auf einen anspruchsvolleren Ansatz bei der Generierung von Inhalten hin.

Diese Erkenntnisse sind nicht nur akademischen Ursprungs, sondern dienen als Orientierungshilfe für Benutzer, die KI-Fähigkeiten an ihre spezifischen Anforderungen anpassen möchten - sei es um tieferes Wissen oder erhöhte Genauigkeit bei der Generierung von Inhalten zu erreichen. Für allgemeine Benutzer, die lediglich eine Alternative zu GPT-3.5 suchen, haben Sie sie gefunden. Mistral-Medium ist die Alternative zu GPT-3.5-Turbo.

Vergleich von Mistral-Medium vs GPT-3.5-Turbo: der Preis

Basierend auf den neuesten verfügbaren Daten gibt es hier die Tabelle für den Preisvergleich von Mistral-Medium und GPT-3.5-Turbo:

| Modell | Eingabekosten pro 1.000 Tokens (USD) | Ausgabekosten pro 1.000 Tokens (USD) |

|---|---|---|

| Mistral-Medium | $0,0027 | $0,0081 |

| GPT-3.5-Turbo (Standardkontext) | $0,0015 | $0,0020 |

| GPT-3.5-Turbo (erweiterter Kontext) | $0,0030 | $0,0040 |

Quelle: Mistral AI Docs | Techcrunch

Wichtige Erkenntnisse:

Der Preis für Mistral-Medium, wie in der Mistral AI Dokumentation aufgeführt, beträgt 2,50 € für die Eingabe und 7,50 € für die Ausgabe pro 1 Million Tokens.

- Der Preis für Mistral-Medium in USD beträgt ungefähr $0,0027 pro 1.000 Tokens für die Eingabe und $0,0081 pro 1.000 Tokens für die Ausgabe.

Auf der anderen Seite kostet GPT-3.5-Turbo jetzt $0,0015 pro 1.000 Eingabe-Tokens und $0,002 pro 1.000 Ausgabe-Tokens.

- Der Preis für das ursprüngliche GPT-3.5-Turbo-Modell, nicht die Version mit dem erweiterten Kontextfenster, wurde um 25% reduziert.

- Dies ist eine erhebliche Preissenkung im Vergleich zur vorherigen Preisgestaltung und macht GPT-3.5-Turbo zu einer günstigeren Option im Vergleich zum neueren Mistral-Medium, insbesondere für Anwendungen, die eine umfangreiche Textverarbeitung erfordern.

- Zusätzlich wird eine neue Version von GPT-3.5-Turbo mit einem Kontextfenster von 16.000 Tokens für $0,003 pro 1.000 Eingabe-Tokens und $0,004 pro 1.000 Ausgabe-Tokens angeboten.

Es gibt jedoch eine Alternative, mit der Sie die Mistral AI-API zu einem günstigeren Preis nutzen können: die Verwendung von Drittanbieter-API-Anbietern für die Mistral-API!

Wir haben einen detaillierteren Artikel zum Vergleich von Mistral-API-Anbietern:

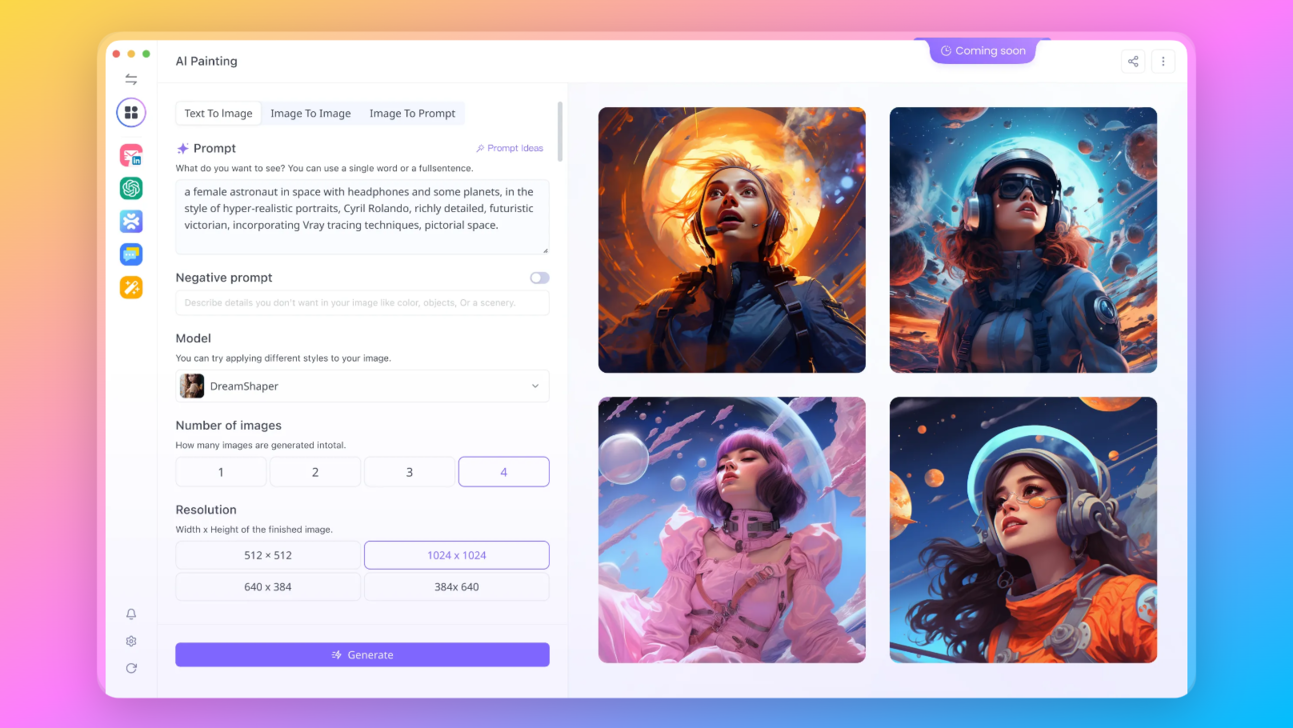

So testen Sie die Modelle von Mistral AI online: mit Anakin AI

Einer der einfachsten Wege, die neuesten Modelle von Mistral AI zu testen, besteht darin, die von Anakin AI bereitgestellte API zu verwenden:

Anakin AI ist nicht nur eine Alternative; es ist ein Einstieg in eine vielfältige Auswahl an KI-Modellen, von denen jedes einzigartige Fähigkeiten und Vorteile bietet. Stellen Sie sich vor, Sie haben die Möglichkeit, Ihre KI-Erfahrung anzupassen, indem Sie aus einer Vielzahl von Modellen auswählen, die perfekt auf die Bedürfnisse Ihres Projekts abgestimmt sind.

Hier sind die anderen Open-Source- und kostenlosen Modelle, die Anakin AI unterstützt:

- GPT-4: Mit einem beeindruckenden Kontextfenster von bis zu 128 KB bringt dieses Modell Deep Learning auf ein neues Niveau.

- Claude-2.1 und Claude Instant: Diese Varianten bieten ein nuanciertes Verständnis und Antworten, die auf unterschiedliche Interaktionsgeschwindigkeiten zugeschnitten sind.

- Google Gemini Pro: Ein Modell, das auf Präzision und Tiefe bei der Informationssuche ausgelegt ist.

- Mistral 7B und Mixtral 8x7B: Spezialisierte Modelle, die eine Kombination aus generativen Fähigkeiten und Skalierbarkeit bieten.

Ihre Vision ist nicht auf Text beschränkt, und Ihre KI sollte es auch nicht sein. Mit Anakin AI haben Sie Zugriff auf modernste Bildgenerierungsmodelle wie:

- DALLE 3: Erstellen Sie atemberaubende hochauflösende Bilder anhand textueller Beschreibungen.

- Stable Diffusion: Generieren Sie Bilder mit einer einzigartigen künstlerischen Note, perfekt für kreative Projekte.

Interessiert, die neuesten Modelle von Mistral auszuprobieren? Probieren Sie es jetzt bei Anakin.AI aus!

Fazit

Der Wettbewerb zwischen Mistral-Medium und GPT-3.5 Turbo entfaltet sich als Zeugnis für die schnellen Fortschritte in der KI, bei denen jedes Modell seine Fähigkeit zur Verarbeitung und Generierung von Sprache mit menschenähnlicher Raffinesse zeigt. Während sich diese Landschaft weiterentwickelt, liegt die endgültige Wahl in den Händen der Benutzer, die Leistung gegen Preis abwägen müssen, um eine Harmonie zu finden, die am besten mit ihrer Vision für die Zukunft der intelligenten Automatisierung übereinstimmt.