Maka, Anda tidak boleh melewatkan Anakin AI!

Anakin AI adalah platform serba ada untuk semua otomatisasi alur kerja Anda, buat aplikasi AI yang kuat dengan Pembuat Aplikasi Tanpa Kode yang mudah digunakan, dengan Deepseek, o3-mini-high dari OpenAI, Claude 3.7 Sonnet, FLUX, Minimax Video, Hunyuan...

Buat Aplikasi AI Impian Anda dalam hitungan menit, bukan minggu dengan Anakin AI!

Kecerdasan buatan telah membuat kemajuan yang luar biasa dalam memahami komunikasi manusia, tetapi mengenali emosi dengan akurat di berbagai modalitas tetap menjadi tantangan. Model R1-Omni yang baru-baru ini diperkenalkan oleh Alibaba merupakan terobosan signifikan dalam domain ini, menetapkan dirinya sebagai aplikasi pertama di industri dari Pembelajaran Penguatan dengan Hadiah Terverifikasi (RLVR) untuk model bahasa besar Omni-multimodal.

Pendekatan Baru untuk Pengenalan Emosi

Emosi manusia kompleks dan diekspresikan melalui beberapa saluran secara bersamaan – ekspresi wajah, nada suara, bahasa tubuh, dan konten verbal. Sistem pengenalan emosi tradisional telah kesulitan mengintegrasikan sinyal yang beragam ini secara efektif, sering gagal menangkap interaksi halus antara petunjuk visual dan auditori yang diproses manusia secara naluriah.

R1-Omni mengatasi tantangan ini dengan memanfaatkan pendekatan pembelajaran penguatan yang canggih yang memungkinkan model untuk mengembangkan pemahaman yang lebih halus tentang bagaimana berbagai modalitas berkontribusi pada keadaan emosional. Dibangun di atas fondasi HumanOmni-0.5B yang open-source, model inovatif ini menunjukkan kemampuan yang superior dalam penalaran, pemahaman, dan generalisasi dibandingkan dengan sistem yang dilatih secara konvensional.

"Kami fokus pada pengenalan emosi, tugas di mana baik modalitas visual maupun audio memainkan peran penting, untuk memvalidasi potensi menggabungkan RLVR dengan model Omni," catat para peneliti di balik R1-Omni dalam dokumentasi teknis mereka.

Arsitektur Teknis dan Inovasi

Di inti, R1-Omni menggabungkan pemrosesan multimodal yang maju dengan teknik pembelajaran penguatan untuk menciptakan sistem pengenalan emosi yang lebih dapat dijelaskan dan akurat. Model ini memproses input visual menggunakan menara visi SigLIP-base-patch16-224 dan menangani audio melalui Whisper-large-v3, sebuah model pemrosesan audio yang kuat yang mampu menangkap isyarat vokal halus yang menyampaikan informasi emosional.

Apa yang membedakan R1-Omni dari pendekatan sebelumnya adalah metodologi pelatihannya. Sementara fine-tuning terawasi tradisional (SFT) melatih model untuk memprediksi label emosi berdasarkan contoh yang dianotasi, R1-Omni menggunakan kerangka pembelajaran penguatan di mana model diberikan imbalan tidak hanya untuk prediksi yang benar, tetapi untuk menunjukkan jalur penalaran yang dapat diverifikasi yang mengarah ke prediksi tersebut.

Pendekatan inovatif ini mendorong hubungan yang dapat dijelaskan antara input multimodal dan output emosional. Alih-alih hanya memberi label emosi sebagai "marah," R1-Omni dapat mengartikulasikan petunjuk visual tertentu (alis yang berkerut, otot wajah yang tegang) dan fitur audio (suara yang meninggi, bicara cepat) yang berkontribusi pada penilaiannya – kemampuan penting untuk membangun kepercayaan dalam sistem AI yang diterapkan di konteks sensitif.

Kemampuan Utama dan Kinerja

R1-Omni menunjukkan tiga kemajuan utama dibandingkan sistem pengenalan emosi sebelumnya:

- Kemampuan Penalaran yang Ditingkatkan: Model memberikan penjelasan rinci untuk klasifikasinya, menghubungkan pengamatan multimodal tertentu dengan kesimpulan emosional. Transparansi ini merupakan peningkatan signifikan dibandingkan pendekatan "black box" yang menawarkan klasifikasi tanpa penjelasan.

- Kemampuan Pemahaman yang Ditingkatkan: Dibandingkan dengan model yang dilatih melalui fine-tuning terawasi, R1-Omni menunjukkan akurasi yang jauh lebih baik dalam tugas pengenalan emosi. Ini menunjukkan bahwa pendekatan pembelajaran penguatan membantu mengembangkan representasi yang lebih halus dari keadaan emosional yang lebih sesuai dengan penilaian manusia.

- Kemampuan Generalisasi yang Lebih Kuat: Mungkin yang paling mengesankan, R1-Omni menunjukkan kinerja yang luar biasa pada data di luar distribusi – skenario yang berbeda dari contoh pelatihannya. Kemampuan untuk menggeneralisasi di luar konteks pelatihan tertentu sangat penting untuk aplikasi dunia nyata.

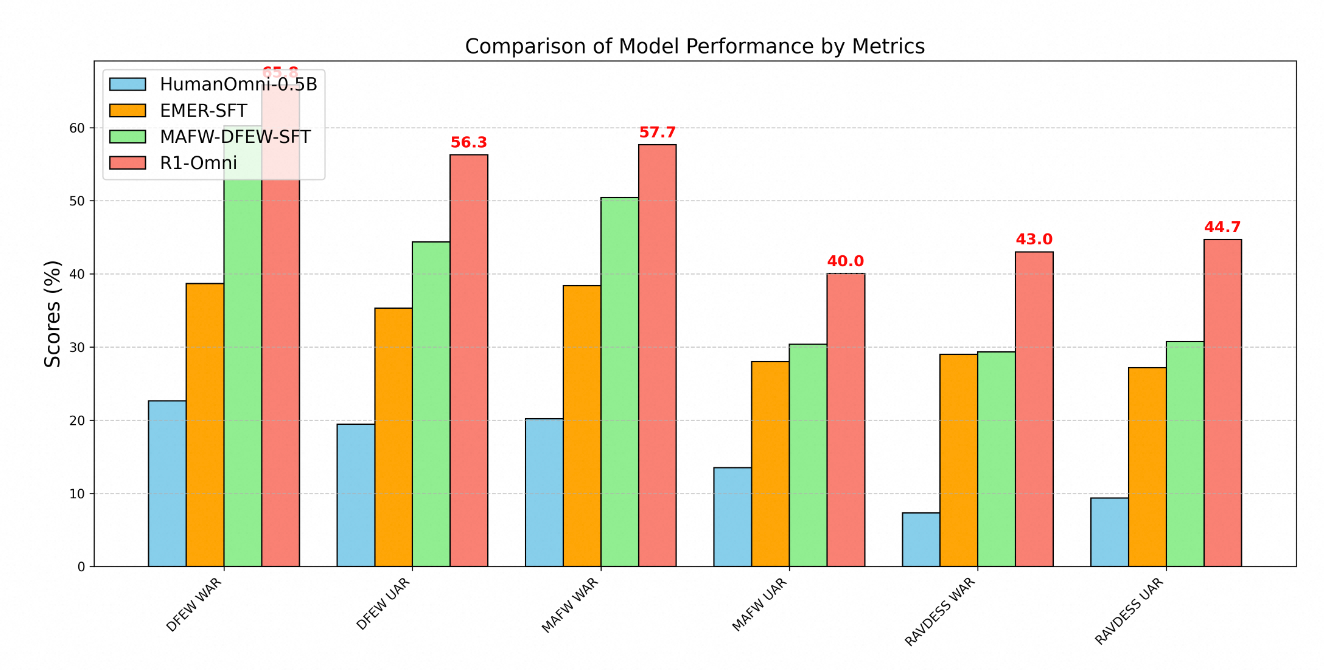

Keunggulan teknis R1-Omni jelas ditunjukkan melalui metrik kinerja di berbagai benchmark pengenalan emosi. Pengujian pada tiga dataset kunci – DFEW, MAFW, dan RAVDESS – memberikan evaluasi komprehensif tentang kemampuan model baik pada data dalam distribusi maupun di luar distribusi.

Pada dataset DFEW, R1-Omni mencapai rata-rata recall tertimbang (WAR) sebesar 65.83% dan rata-rata recall tidak tertimbang (UAR) sebesar 56.27%, secara substansial melampaui baik model HumanOmni-0.5B dasar (22.64% WAR) dan model MAFW-DFEW-SFT (60.23% WAR) yang disetel langsung pada set pelatihan.

Lebih mengesankan lagi adalah kinerja model pada data di luar distribusi. Ketika diuji pada dataset RAVDESS, yang tidak digunakan selama pelatihan, R1-Omni mencapai 43% WAR dan 44.69% UAR – jauh lebih baik daripada model dasar (7.33% WAR) dan secara substansial lebih tinggi daripada alternatif fine-tuned terawasi (29.33% WAR).

Metodologi Pelatihan

Pengembangan R1-Omni mengikuti proses pelatihan dua tahap yang canggih:

Pertama, dalam fase "cold start," para peneliti menginisialisasi model menggunakan HumanOmni-0.5B dan menyempurnakannya pada dataset yang disusun dengan cermat yang terdiri dari 232 sampel dari dataset Pengantar Alasan Emosi Multimodal yang Dapat Dijelaskan dan 348 sampel dari dataset HumanOmni. Ini memberikan kemampuan dasar sambil menekankan proses penalaran yang dapat dijelaskan.

Tahap kedua menggunakan Pembelajaran Penguatan dengan Hadiah Terverifikasi menggunakan dataset yang jauh lebih besar yang terdiri dari 15,306 sampel video dari dataset MAFW dan DFEW. Fase pembelajaran penguatan ini sangat penting dalam mengembangkan kemampuan penalaran dan generalisasi canggih model.

Sepanjang pelatihan, proses ini mengutamakan tidak hanya klasifikasi yang akurat tetapi juga pengembangan jalur penalaran yang dapat diverifikasi. Contoh pelatihan biasanya mencakup baik label emosi maupun proses pemikiran terstruktur yang menghubungkan pengamatan dengan kesimpulan. Pendekatan ini mendorong model untuk mengembangkan hubungan yang dapat dijelaskan alih-alih hanya mempelajari korelasi statistik.

Aplikasi Dunia Nyata

Kemampuan yang ditunjukkan oleh R1-Omni membuka berbagai kemungkinan di berbagai domain:

- Dukungan Kesehatan Mental: Model ini dapat membantu terapis dengan memberikan penilaian objektif terhadap keadaan emosional pasien, berpotensi mengidentifikasi isyarat emosional halus yang mungkin terlewatkan.

- Pendidikan: Sistem serupa dapat membantu guru mengukur keterlibatan siswa dan respons emosional terhadap materi pembelajaran, memungkinkan pendekatan pendidikan yang lebih responsif.

- Layanan Pelanggan: Teknologi R1-Omni dapat meningkatkan sistem layanan pelanggan otomatis dengan mengenali dan merespons emosi pelanggan dengan tepat, meningkatkan tingkat kepuasan.

- Analisis Konten: Model ini dapat menganalisis konten emosional dalam video dan rekaman audio untuk penelitian pasar, analisis media, dan moderasi konten.

Keterjelasan model ini sangat berharga dalam konteks ini, karena memungkinkan operator manusia untuk memahami dan memvalidasi penalaran di balik penilaian emosional yang dihasilkan oleh AI. Transparansi ini membangun kepercayaan dan memfasilitasi kolaborasi manusia-AI yang efektif, penting untuk adopsi luas di domain sensitif.

Pengembangan Masa Depan

Menurut peta jalan proyek, pengembangan masa depan untuk R1-Omni mencakup pengintegrasian kode sumber HumanOmni, merilis proses reproduksi yang lebih rinci, open-sourcing semua data pelatihan, mengembangkan kemampuan inferensi untuk data video tunggal dan audio tunggal, dan merilis hasil dari versi model yang lebih besar berukuran 7B.

Peningkatan yang direncanakan ini akan lebih meningkatkan aksesibilitas dan utilitas model bagi peneliti dan pengembang, berpotensi mempercepat kemajuan di bidang pengenalan emosi multimodal.

Kesimpulan

R1-Omni dari Alibaba merupakan kemajuan penting dalam pengenalan emosi berbasis AI melalui aplikasi inovatif teknik pembelajaran penguatan pada pemahaman multimodal. Dengan meningkatkan kemampuan penalaran, meningkatkan akurasi, dan menunjukkan generalisasi superior terhadap skenario baru, R1-Omni mendorong batasan dari apa yang mungkin dalam AI emosional.

Saat kita bergerak menuju interaksi manusia-komputer yang lebih alami, sistem seperti R1-Omni yang dapat mengenali dan merespons emosi manusia dengan akurat di berbagai saluran komunikasi akan memainkan peran yang semakin penting. Penekanan model pada keterjelasan dan generalisasi menjawab batasan kritis dari pendekatan sebelumnya, menetapkan standar baru untuk teknologi pengenalan emosi yang bertanggung jawab dan efektif.

Dengan menggabungkan kekuatan pembelajaran penguatan dengan kemampuan pemrosesan multimodal, Alibaba telah menciptakan bukan hanya sistem pengenalan emosi yang lebih baik, tetapi juga kemungkinan paradigma baru tentang bagaimana sistem AI dapat belajar memahami kompleksitas halus dari komunikasi manusia.