会話型AIの景色は、OpenChat-3.5-1210の登場によって大きく変革されました。このモデルは、単なる漸進的なアップデート以上のものを約束しています。

この最新のイテレーションは、言語学習モデル(LLM)の領域での卓越追求の証として立ちます。かつてChatGPTやGrokモデルが基準であった場所に、今では恐るべき新たな競合者が忍び寄っています。OpenChat-3.5-1210は単に前任者を上回るだけでなく、LLMの基準を再定義しています。

記事の要点:

OpenChatをローカルで実行できます

OpenChatとは何ですか?

OpenChatは、顕著なコーディング能力と一般ist的なアプローチで知られる言語学習モデル(LLM)です。

このモデルは、7Bのパラメータの規模であっても、複雑な言語タスクで高品質のパフォーマンスを提供する非凡な能力を示し、ChatGPTやGrokよりも優れた基準を持っています。

- 高度なコード生成:HumanEvalベンチマークでの非凡な飛躍は、モデルのコードの理解と生成の向上を示しており、職人が芸術の新たなマスタリーレベルを達成するようなものです。

- 戦略的な微調整:オフライン強化学習から引用されたC-RLFTという技術を用いることで、OpenChatは明示的な優先度ラベルの必要なしに、品質が混在するデータセットから効果的に学習することができます。

- 一般的な知識:OpenChat-3.5-1210の卓越性はコーディングに限定されていません。MMLU、TruthfulQA、AGIEvalなどの様々なベンチマークで輝き、真の一般ist AIモデルを特徴付ける柔軟性を示しています。

OpenChat 3.5-1210は、オープンソースの言語モデルの能力を前進させる世界でのAIの進歩の証です。

オンラインでOpenChat-3.4-1210を試す方法

OpenChatを実行する最も簡単な方法の一つは、Anakin AIが提供するAPIを使用することです:

Anakin AIは単なる代替品ではなく、プロジェクトのニーズに完璧に合わせるためのユニークな機能と利点を備えた多様なAIモデルへのゲートウェイです。自分のAI体験を調整する力を手に入れましょう。

以下はAnakin AIがサポートする他のオープンソースで無料のモデルです:

- GPT-4:最大128kのコンテキストウィンドウを誇るこのモデルは、ディープラーニングを新たな高みに引き上げます。

- Claude-2.1とClaude Instant:これらのバリアントは、異なるインタラクション速度に対応した微妙な理解と応答を提供します。

- Google Gemini Pro:情報検索において高い精度と深さを備えたモデルです。

- Mistral 7BとMixtral 8x7B:生成能力とスケールのブレンドを提供する専門のモデルです。

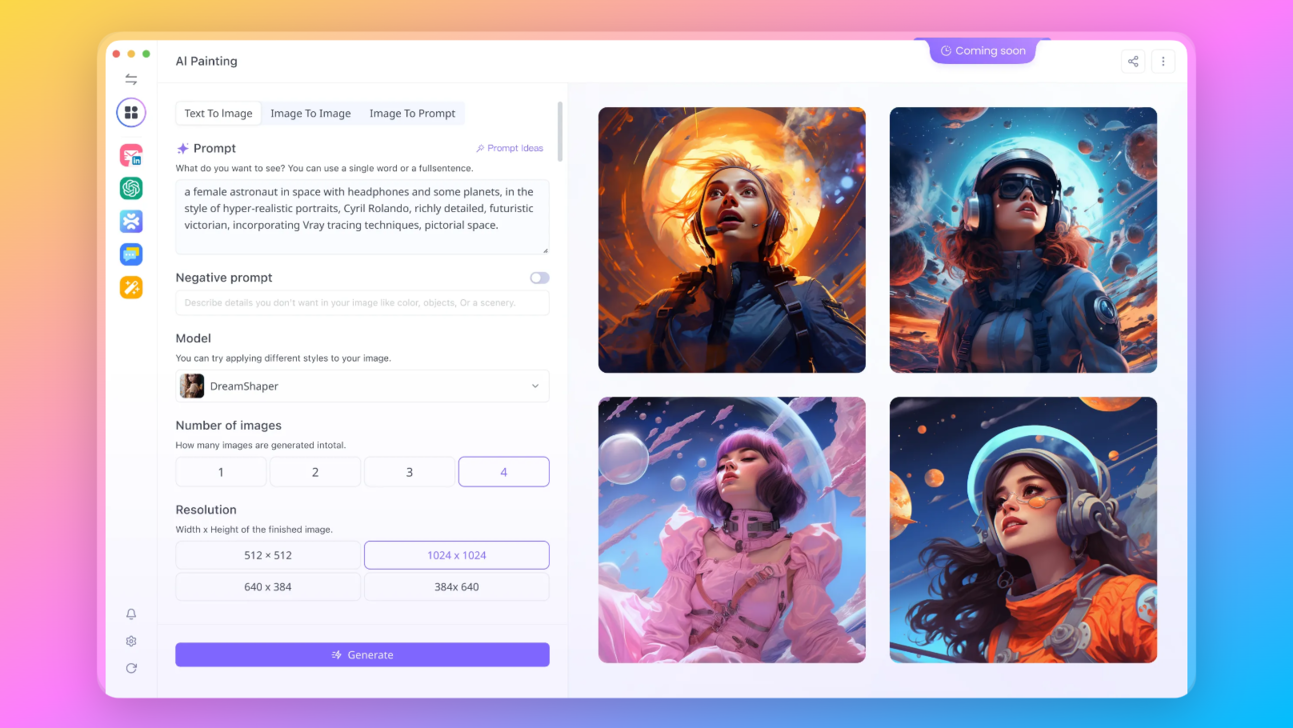

あなたのビジョンはテキストに制限されていませんし、あなたのAIもそうあってはなりません。Anakin AIを使用することで、次のような最先端の画像生成モデルにアクセスできます:

- DALLE 3:テキストの記述から見事な高解像度の画像を作成します。

- Stable Diffusion:クリエイティブなプロジェクトに最適なユニークな芸術的なスタイルで画像を生成します。

Open Chat-3.5-1210を試してみたいですか? Anakin.AIで今すぐ試してください!

OpenChat 3.5 1210は、ChatGPTとGrokと比較してどれくらい優れていますか?

OpenChat-3.5-1210のAI界隈での台頭は、HumanEvalベンチマークでの15ポイントの著しい向上によって特徴付けられています。

これは数量的な飛躍だけでなく、モデルの洗練されたコーディング能力を強調しています。

OpenChat-3.5-1210の性能ベンチマーク

以下はベンチマークグラフであり、ChatGPTおよびGrok(Elon MuskのX.AIが開発)と比較されています。

モデル比較の追加データ:

| モデル | ライセンス | パラメータ数 | 平均 | MMLU | HumanEval | MATH | GSM8K |

|---|---|---|---|---|---|---|---|

| OpenChat 3.5 1210 | Apache-2.0 | 7B | 60.1 | 65.3 | 68.9 | 28.9 | 77.3 |

| OpenChat 3.5 | Apache-2.0 | 7B | 56.4 | 64.3 | 55.5 | 28.6 | 77.3 |

| Grok-0 | プロプライエタリ | 33B | 44.5 | 65.7 | 39.7 | 15.7 | 56.8 |

| Grok-1 | プロプライエタリ | ???B | 55.8 | 73 | 63.2 | 23.9 | 62.9 |

さて、ここでは簡潔な箇条書きとフォーマットのセクションがあります:

ベンチマークの理解:スナップショット

- OpenChat 3.5 1210は、いくつかのベンチマークで競合他社を圧倒しています:

- 平均スコア:全体的な優れたパフォーマンスを示す60.1です。

- HumanEval:68.9で、コード生成タスクでのリーディングな能力が見て取れます。

- GSM8K:優れた問題解決能力を反映している77.3という高いスコアです。

- Grok-0およびGrok-1:より多くのパラメータを持っているにもかかわらず、主要な領域での遅れがあります:

- MATH:OpenChatの28.9のスコアは、Grok-0の15.7を遙かに上回ります。

- 総合的に:Grokモデルは、それぞれ44.5と55.8という低い平均スコアを示しています。

- OpenChatは、Grokのプロプライエタリなステータスとは対照的に、Apache-2.0ライセンスでオープンソースを採用しています。

これらのベンチマークは何を意味するのか?

以下は、このデータに対する私たちの評価です:

- OpenChatがHumanEvalベンチマークを支配:これは重要なことであり、HumanEvalはモデルの実世界のプログラミングタスクを理解し実行する能力を評価します。ここで高いスコアを達成することは、モデルが構文的に正確なだけでなく、論理的に堅牢なコードを生成できることを意味します。

- 開発者は、より微妙で信頼性の高いコーディングアシスタントを活用することにより、ワークフローを合理化し、デバッグに費やす時間を短縮することができます。

- ユーザーは、より一貫性があり、文脈を理解したインタラクションを体験することができます。それがカジュアルな会話であったり、複雑なトピックについて詳しい説明を求める場合でも、です。

OpenChat-3.5-1210をChatGPTとGrokシリーズと比較すると、前者には明らかな優位性があります。 レーダーチャートがOpenChat-3.5-1210の優れたパフォーマンスを説得力のあるストーリーに変えています。

HumanevalとTruthfulQAとは何ですか?

これらのベンチマークの意味について詳細な説明が気になる方へ、各ベンチマークのさらなる説明を以下に掲載します:

- GSM8K:これは、モデルの一般的な問題解決能力を評価するベンチマークです。このメトリックの高得点は、モデルの推論能力や複雑なクエリの理解力が優れていることを示しています。

- MT-Bench:通常、このベンチマークはモデルの機械翻訳タスクでのパフォーマンスをテストします。モデルが言語を理解し翻訳する能力を測定します。

- HumanEval:このベンチマークはモデルのプログラミング能力を評価し、具体的には問題のステートメントに対して正確かつ効率的なコードスニペットを生成する能力を測定します。

- BBH MC:BBH MC(Multiple Choice)ベンチマークは、モデルの読解能力と正しい選択肢を選ぶ能力を評価します。これは、人間の言語の微妙なニュアンスを理解することがしばしば要求されるため、人間言語の微妙なニュアンスを理解する能力が必要とされます。

- AGIEval:このベンチマークは、一般的な知識推論や因果関係の推論、さらに複雑な問題解決など、人工的な一般知能(AGI)を示すタスクの能力を評価するものと考えられます。

- TruthfulQA:このベンチマークは、モデルが真実かつ正確な回答を提供する能力を評価します。モデルが事実とフィクションを区別し、信頼性のある情報を提供できるかどうかを測定します。

- MMLU:MMLU(Massive Multitask Language Understanding)ベンチマークは、モデルの広範な主題と質問タイプにわたる理解能力を評価し、一般的な言語理解能力を示します。

- BBH CoT:BBH CoT(Book of the House of Black and White Completions)は、与えられたパッセージを継続したり、物語を適切な文脈で完了する能力を測定するものであり、モデルの理解力と創造的な生成能力を反映しています。

OpenChat LLMをローカルで実行するためのステップバイステップガイド

ローカルでOpenChatを実行するための要件

ローカルマシンでOpenChatトレーナーを実行するには、モデルサイズに基づいた以下のハードウェア仕様を満たす必要があります:

13Bモデルの場合:

- 8個のA/H100 GPU、各々に80GBのVRAMを搭載したセットアップが必要です。

7Bモデルの場合:

- 4個のA/H100 GPU with 80GB VRAM または 8個のA/H100 GPU with 40GB VRAM を使用できます。

また、システムにPythonがインストールされていることを確認してください。OpenChatはPython 3.6以降が必要です。Pythonパッケージをインストールするためにpip、リポジトリをクローンするためにgitが必要です。

ステップ1:OpenChatのインストール

ターミナルを開き、以下のコマンドでOpenChatをインストールします:pipは、最新バージョンのOpenChatとその依存関係をインストールします:

pip install openchat

ステップ2:インストールの確認

OpenChatが正しくインストールされたことを確認するには、次のコマンドを実行します:

python -m openchat --version

これにより、OpenChatのバージョン番号が返され、インストールが成功したことが確認されます。

ステップ3:モデルの実行

OpenChatがインストールされたので、モデルを実行できます。デフォルトでは、OpenChatはシンプルなCLIを提供しており、ターミナルで直接モデルと対話できます。次のコマンドを使用して会話を開始します:

python -m openchat

モデルを選択して、すぐにチャットを開始するように求められます。

ステップ4:高度なオプション

特定のモデルを指定したり、サーバーを実行したりするなど、より高度な使用法には、追加のコマンドライン引数を使用できます。

特定のモデルを使用してOpenChatを実行する手順は次のとおりです:

python -m openchat --model "openchat/openchat-3.5-1210"

ステップ5:APIサーバーとして実行する

他のアプリケーションとOpenChatを統合する予定がある場合は、APIサーバーとして実行することもできます:

python -m openchat.serving.openai_api_server --model "openchat/openchat-3.5-1210"

このコマンドを使用すると、デフォルトポートでリクエストを受信するローカルサーバーが開始されます。

OpenChat 3.5 1210を実行するための追加のプラットフォーム

さらに、これらのプラットフォームでOpenChat 3.5 1210を試すこともできます:

- Anakin AIの無料版OpenChat-3.5-1210を試す

- HuggingFaceでOpenChat-3.5-1210を試す

- Together AIのインファレンスAPIでモデルを試す

結論:OpenChat-3.5-1210と未来の展望

OpenChat-3.5-1210の成功は、言語モデルがさらに個別化された文脈に応じた相互作用を提供し、ニーズを予測し、ほとんど人間の入力を必要とせずに解決策を提供する未来を示唆しています。洗練されたバーチャルアシスタントの強化からリアルタイムのプログラミングサポートの提供まで、その潜在的な応用は無限です。

これはAIの進化を見守るだけでなく、参加するための招待状でもあります。OpenChat-3.5-1210はただのツールではありません。それはAIの無限の可能性を引き出す未来の先駆者です。ですので、どんどんこのモデルの限界をテストし、明日のAIの景色を形作るプロセスに参加してください。