Textgenerierungsmodelle wie GPT-4 haben die natürliche Sprachverarbeitung revolutioniert und ermöglicht es uns, mühelos eine textähnliche Ausgabe zu generieren. Allerdings können diese Modelle manchmal Ausgaben erzeugen, die entweder zu repetitiv oder zu unsinnig sind.

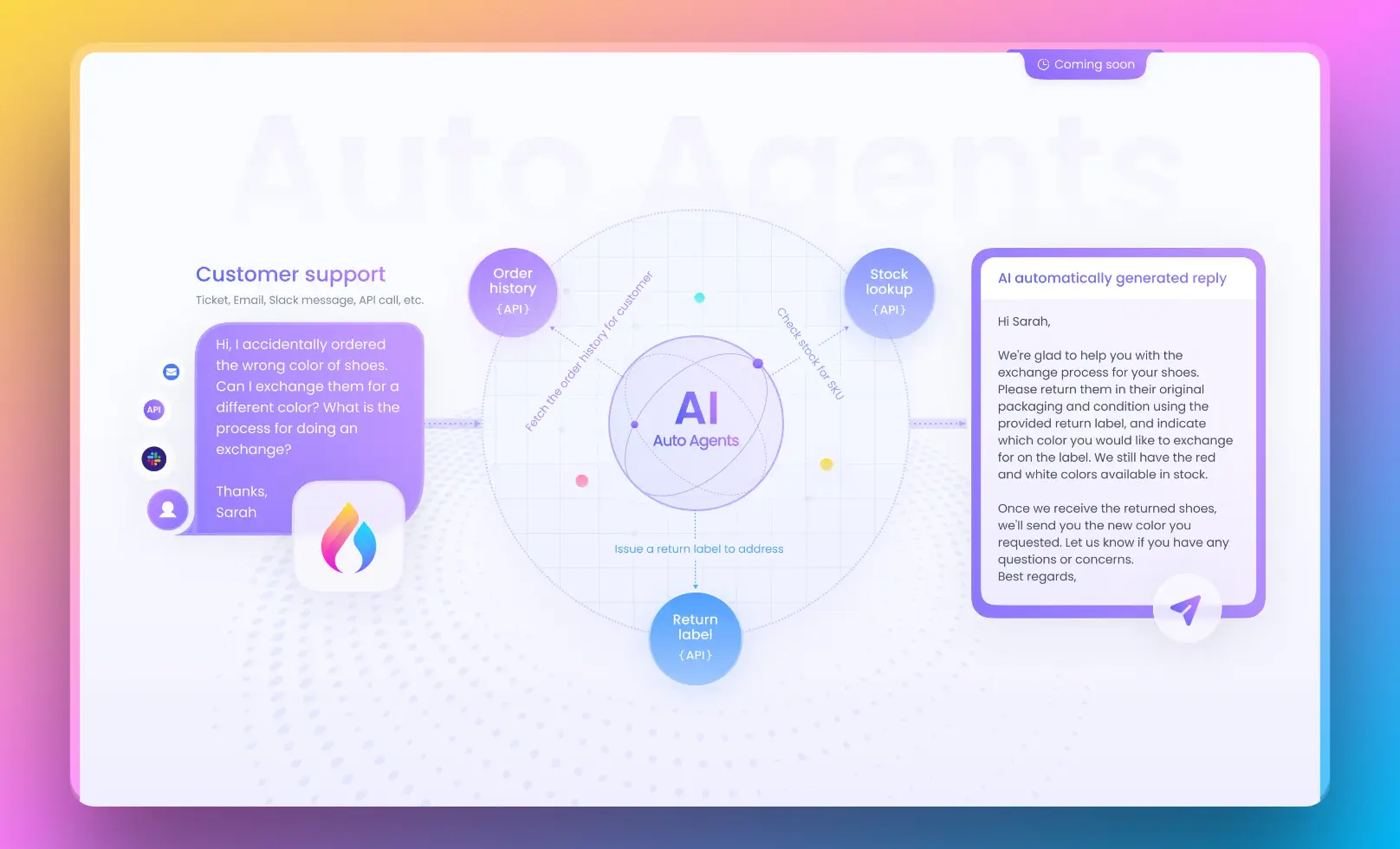

Tipp: Der "top-p"-Parameter befindet sich auf der rechten Seite des OpenAI Playground.

Hier kommt der "top-p"-Parameter ins Spiel. In diesem Artikel werden wir das Geheimnis des top-p-Parameters lüften und verstehen, wie er die Textgenerierung im OpenAI Playground beeinflusst.

Schlüsselpunkte in diesem Artikel:

- Erklärung der Rolle des top-p-Parameters bei der Textgenerierung.

- Verständnis, wie der top-p-Parameter die Vielfalt des generierten Textes beeinflusst.

- Vergleich des top-p-Parameters mit dem top-k-Parameter zur Steuerung der Textvielfalt.

Tauchen wir ein und enträtseln den top-p-Parameter.

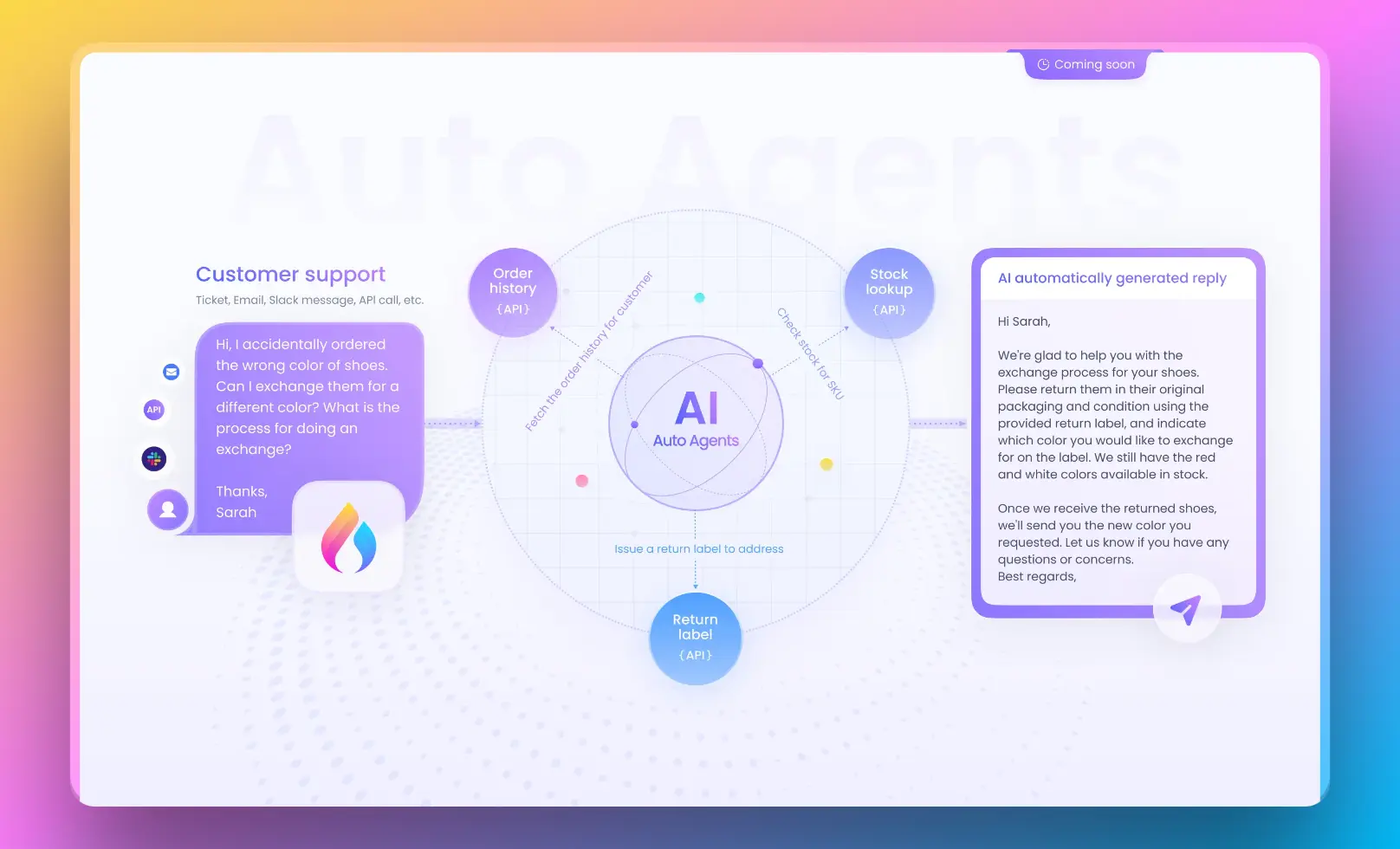

Möchten Sie den mit ChatGPT betriebenen AI-Agenten testen?

Verwenden Sie Anakin AI, um einen beliebigen AI-Agenten nach Belieben zu erstellen!

Was ist der Top-p-Parameter im OpenAI Playground?

Der Top-p-Parameter ist im Kern ein wesentlicher Bestandteil von Textgenerierungsmodellen, insbesondere im Zusammenhang mit GPT-4. Hier ist, was Sie wissen müssen:

- Funktion: Der Top-p-Parameter dient als Schwellenwert für die kumulative Wahrscheinlichkeit der wahrscheinlichsten Tokens, die in den generierten Text einbezogen werden können.

- Steuerung der Vielfalt: Eine seiner Hauptfunktionen ist die Steuerung der Vielfalt des generierten Textes. Ein niedrigerer Top-p-Wert neigt dazu, häufigere und wiederholende Wörter auszuwählen, was zu einer weniger vielfältigen Ausgabe führt. Ein höherer Top-p-Wert ermöglicht es dem Modell hingegen, eine breitere Palette von Tokens zu berücksichtigen, was zu einer vielfältigeren, aber potenziell unsinnigen Ausgabe führen kann.

- Risikomodulation: Betrachten Sie den Top-p-Parameter als Risikomodulator. Er ermöglicht es Benutzern, das "Risiko" fein abzustimmen, das das Modell bei der Textgenerierung eingeht. Niedrigere Werte bevorzugen eine vorhersehbarere und fokussiertere Ausgabe, während höhere Werte eine vielfältigere, aber potenziell weniger zusammenhängende Ausgabe erzeugen.

- Balanceakt: Der Top-p-Parameter dreht sich um Balance. Er hilft Benutzern, eine harmonische Balance zwischen Textvielfalt und Relevanz für den gegebenen Kontext zu finden. Dadurch wird sichergestellt, dass die erzeugte Ausgabe den Anforderungen und stilistischen Vorlieben des Benutzers entspricht.

- Empfehlungen: OpenAI empfiehlt in der Regel die Verwendung einer der beiden Varianten des Temperatursamplings (temperature sampling) oder des Nukleussamplings (nucleus sampling), aber nicht beides gleichzeitig, in Verbindung mit dem top-p-Parameter. Die Wahl des Top-p-Werts kann je nach spezifischen Anwendungsfällen und gewünschter Ausgabequalität angepasst werden.

Im Wesentlichen ist der Top-p-Parameter ein leistungsstolzes Tool zur Feinabstimmung der Textgenerierung. Er ermöglicht es den Benutzern, die Ausgabe an ihre spezifischen Anforderungen anzupassen, sei es hochfokussierte Inhalte oder kreative Vielfalt zu benötigen.

Wie der Top-p-Parameter die Textvielfalt formt

Nun, da wir den Wesensgehalt des Top-p-Parameters erfasst haben, wollen wir tiefer darauf eingehen, wie er die Vielfalt des Textes beeinflusst, der von KI-Modellen generiert wird. Das Verhältnis zwischen dem Top-p-Wert und der Textvielfalt lässt sich wie folgt zusammenfassen:

- Steuerung der Vielfalt: Der Top-p-Wert spielt eine entscheidende Rolle bei der Steuerung der Vielfalt des generierten Textes. Höhere Top-p-Werte führen zu vielfältigeren und kreativeren Ausgaben, da das Modell eine breitere Palette von Tokens berücksichtigen kann, einschließlich weniger wahrscheinlicher. Niedrigere Werte führen zu fokussierterem und deterministischerem Text, da das Modell nur die wahrscheinlichsten Tokens berücksichtigt.

- Risikomodulation: Betrachten Sie den Top-p-Parameter als Ihren Risikoregler. Wenn Sie den Top-p-Wert erhöhen, erhöhen Sie das Risiko, indem Sie das Modell ermutigen, weniger wahrscheinliche Tokens zu erkunden, was zu einer vielfältigeren, aber potenziell unsinnigen Ausgabe führen kann. Verringern Sie hingegen den Top-p-Wert, um das Risiko zu reduzieren und zu einer vorhersehbareren, aber weniger vielfältigen Ausgabe zu gelangen.

- Balance zwischen Vielfalt und Relevanz: Es geht darum, den richtigen Punkt zu finden. Indem sie den Top-p-Wert anpassen, können Benutzer das Maß an Vielfalt und Relevanz im generierten Text fein abstimmen. Dadurch wird gewährleistet, dass die Ausgabe nicht nur kreativ ist, sondern auch kohärent und kontextuell angemessen bleibt.

Zusammenfassend verschafft der Top-p-Parameter Benutzern die Möglichkeit, die Textvielfalt nach ihren spezifischen Anforderungen zu modulieren. Ob Sie kreative Vielfalt oder präzise Relevanz suchen, der Top-p-Parameter ist Ihr Verbündeter für die gewünschte Textausgabe.

Was ist der Unterschied zwischen den Top-p- und Top-k-Parametern

In der Welt der Textgenerierung können Sie auf einen weiteren Parameter namens "top-k" stoßen. Während sowohl der Top-p- als auch der Top-k-Parameter dazu beitragen, die Textvielfalt zu steuern, wirken sie sich auf unterschiedliche Weise aus. Hier ist der Unterschied:

Top-p-Parameter:

- Beim Top-p-Sampling werden dynamisch Wörter ausgewählt, deren kumulative Wahrscheinlichkeit die Wahrscheinlichkeit p überschreitet. Das bedeutet, dass die Größe der Wörtermenge je nach Wahrscheinlichkeitsverteilung variieren kann.

- Höhere Top-p-Werte führen zu einer größeren Vielfalt der Ausgabe, da das Modell eine breitere Palette von Tokens berücksichtigen kann, einschließlich weniger wahrscheinlicher. Niedrigere Werte führen zu fokussierterem und deterministischerem Text.

Top-k-Parameter:

- Hingegen konzentriert sich das Top-k-Sampling darauf, nur die k wahrscheinlichsten nächsten Tokens in jedem Schritt der Textgenerierung zu berücksichtigen. Es begrenzt direkt die Anzahl der betrachteten Tokens.

- Niedrigere Top-k-Werte konzentrieren die Suche auf die wahrscheinlichsten Tokens und führen zu einer weniger vielfältigen Ausgabe, während höhere Top-k-Werte dem Modell ermöglichen, eine größere Anzahl von Tokens zu berücksichtigen und dadurch vielfältigere Ausgaben zu erzeugen.

Im Wesentlichen spielen sowohl der Top-p- als auch der Top-k-Parameter eine wichtige Rolle bei der Balance zwischen Textvielfalt und Relevanz. Benutzer können zwischen beiden wählen, je nach individuellen Vorlieben und Anwendungsfällen, und die Werte anpassen, um das gewünschte Maß an Kontrolle über die Textgenerierung zu erreichen.

Und was ist mit anderen OpenAI-Parametern?

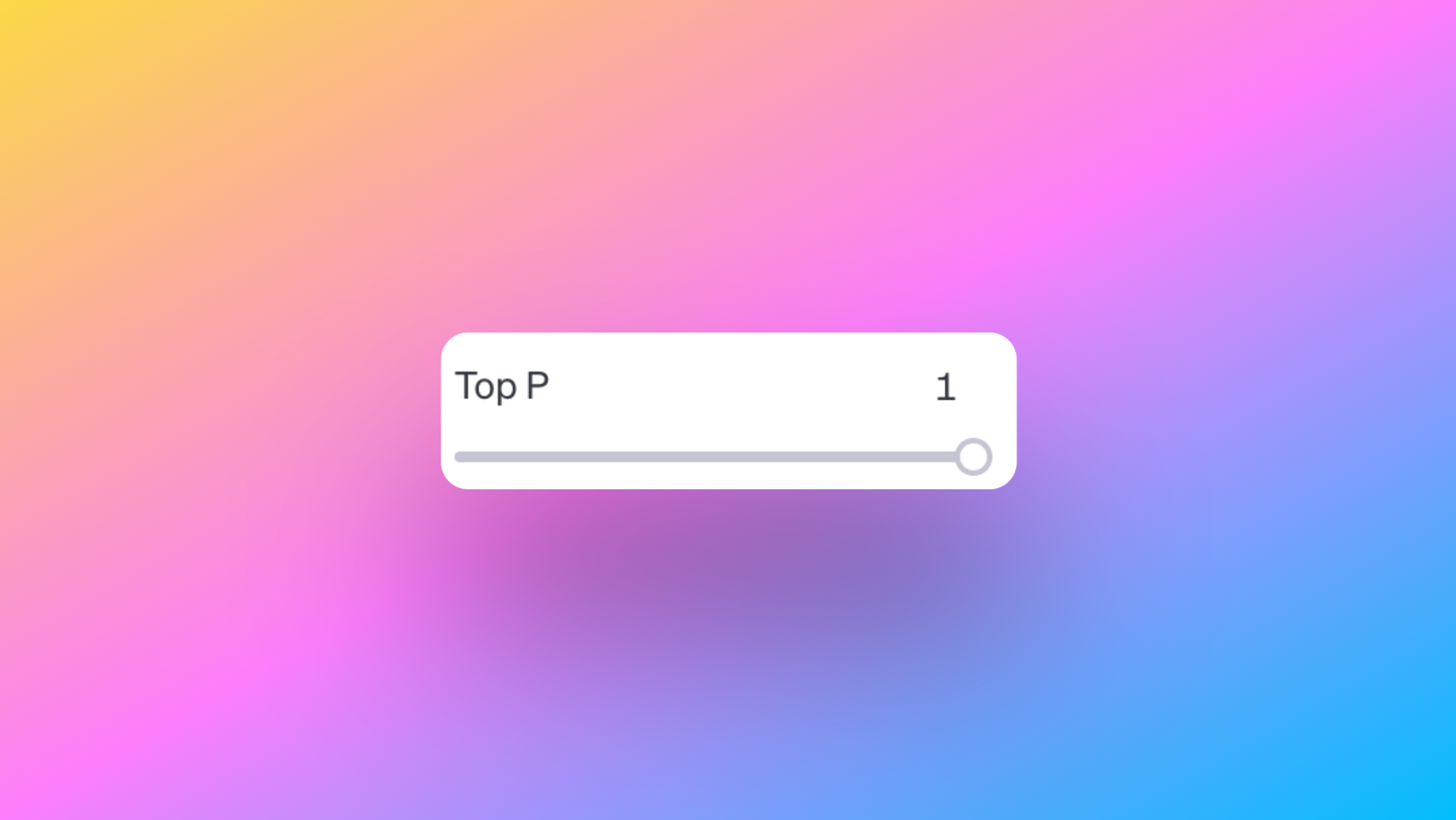

Temperatur: Kreativität formen

Die Temperatur ist ein kritischer Parameter, wenn es darum geht, die Kreativität und Zufälligkeit des generierten Textes zu kontrollieren. Sie fungiert als Kreativitätsregler, und so funktioniert sie:

- Hohe Temperatur (z. B. 1.0): Wenn Sie die Temperatur auf einen höheren Wert setzen, wird das Modell kreativer und erzeugt vielfältigere Ausgaben. Das bedeutet, dass es wahrscheinlicher ist, Wörter auszuwählen, die weniger wahrscheinlich sind, was zu einem einfallsreichen und unvorhersehbaren Text führt.

- Niedrige Temperatur (z. B. 0.2): Umgekehrt macht ein niedrigerer Temperaturwert das Modell fokussierter und deterministischer. Es neigt dazu, Wörter mit höheren Wahrscheinlichkeiten auszuwählen, was zu vorhersehbarerem und strukturierterem Text führt.

Der Temperaturparameter ermöglicht es Ihnen, das richtige Gleichgewicht zwischen kreativer Originalität und Vorhersehbarkeit zu finden, je nach Ihren spezifischen Zielen bei der Textgenerierung.

Maximale Länge: Kontrolle der Ausgabegröße

Der Maximale Länge-Parameter ermöglicht es Ihnen, die Größe des generierten Textes zu kontrollieren. Sie können die maximale Anzahl an Tokens angeben, die in der Ausgabe enthalten sein sollen. Wenn Sie zum Beispiel 256 Tokens festlegen, wird der generierte Text diese Grenze nicht überschreiten.

Dieser Parameter ist nützlich, wenn Sie Text einer bestimmten Länge generieren müssen, um in ein Zeichenlimit zu passen oder sicherzustellen, dass der generierte Inhalt prägnant und auf den Punkt gebracht ist.

Stop-Sequenzen: Festlegen von Endpunkten

Der Stop-Sequenzen-Parameter ist nützlich, wenn Sie bestimmte Sequenzen angeben möchten, die das Ende des generierten Textes anzeigen. Sie können eine Sequenz eingeben und Tab drücken, um sie als Stop-Sequenz festzulegen. Wenn das Modell diese Sequenz im generierten Text findet, behandelt es sie als Endpunkt und hört auf, weiteren Inhalt zu generieren.

Diese Funktion ist wertvoll, wenn Sie präzise Kontrolle darüber benötigen, wo der generierte Text enden soll, oder wenn Sie sicherstellen möchten, dass bestimmte Informationen immer am Ende des erzeugten Inhalts vorhanden sind.

Frequenzstrafe: Förderung von Vielfalt

Der Frequenzstrafe-Parameter ermöglicht es Ihnen, Vielfalt im generierten Text zu fördern. Durch Erhöhen des Frequenzstrafe-Werts wird das Modell angewiesen, nicht zu häufig dieselben Wörter oder Phrasen zu wiederholen.

Zum Beispiel führt das Festlegen eines höheren Frequenzstrafe-Werts wie 0,8 dazu, dass das Modell weniger wahrscheinlich Wörter häufig wiederverwendet, was zu abwechslungsreichem und ansprechendem Text führt.

Anwesenheitsstrafe: Abschreckung bestimmter Inhalte

Andererseits ist der Anwesenheitsstrafe-Parameter darauf ausgelegt, das Einschließen bestimmter Inhalte im generierten Text zu entmutigen. Sie können den Anwesenheitsstrafe-Wert erhöhen, um das Modell weniger wahrscheinlich bestimmte Wörter oder Phrasen in der Ausgabe verwenden zu lassen.

Zum Beispiel führt das Festlegen eines hohen Anwesenheitsstrafe-Wertes wie 0,8 dazu, dass das Modell versucht, bestimmte Begriffe zu vermeiden, um sicherzustellen, dass sie in den generierten Inhalten weniger präsent sind.

Fazit

Zusammenfassend ist der top-p-Parameter ein entscheidendes Element für die Feinabstimmung der Textgenerierung in der OpenAI Playground. Er ermöglicht es Benutzern, die Vielfalt und Kreativität des generierten Textes zu kontrollieren, während die Relevanz für den Kontext erhalten bleibt. Indem Sie verstehen, wie der top-p-Parameter funktioniert und wie er sich zum top-k-Parameter verhält, erhalten Sie die Einblicke, die erforderlich sind, um das volle Potenzial der KI-gesteuerten Textgenerierung für Ihre spezifischen Bedürfnisse zu nutzen.

Möchten Sie den mit ChatGPT betriebenen KI-Agenten testen?

Verwenden Sie Anakin AI, um beliebige KI-Agenten ganz nach Ihren Wünschen zu erstellen!