Open Source LLM wird jetzt immer beliebter. Wo immer Sie hingehen, hören Sie diese verwirrenden Namen der neuesten Open Source LLMs, über die die Leute leise flüstern. Aber so lustig sie auch sind, sie haben noch nicht die Spitze erreicht, GPT-4.

Bis jetzt. Starling-7B, ein neuer Mitspieler, tritt ins Rampenlicht. Als Leuchtturm der Open-Source-Innovation wird es schnell zu einem bedeutenden Rivalen des bekannten GPT-4. Diese aufstrebende Technologie ist nicht nur ein technologisches Wunder, sondern auch ein Symbol für gemeinschaftliche Bemühungen auf dem Gebiet der KI.

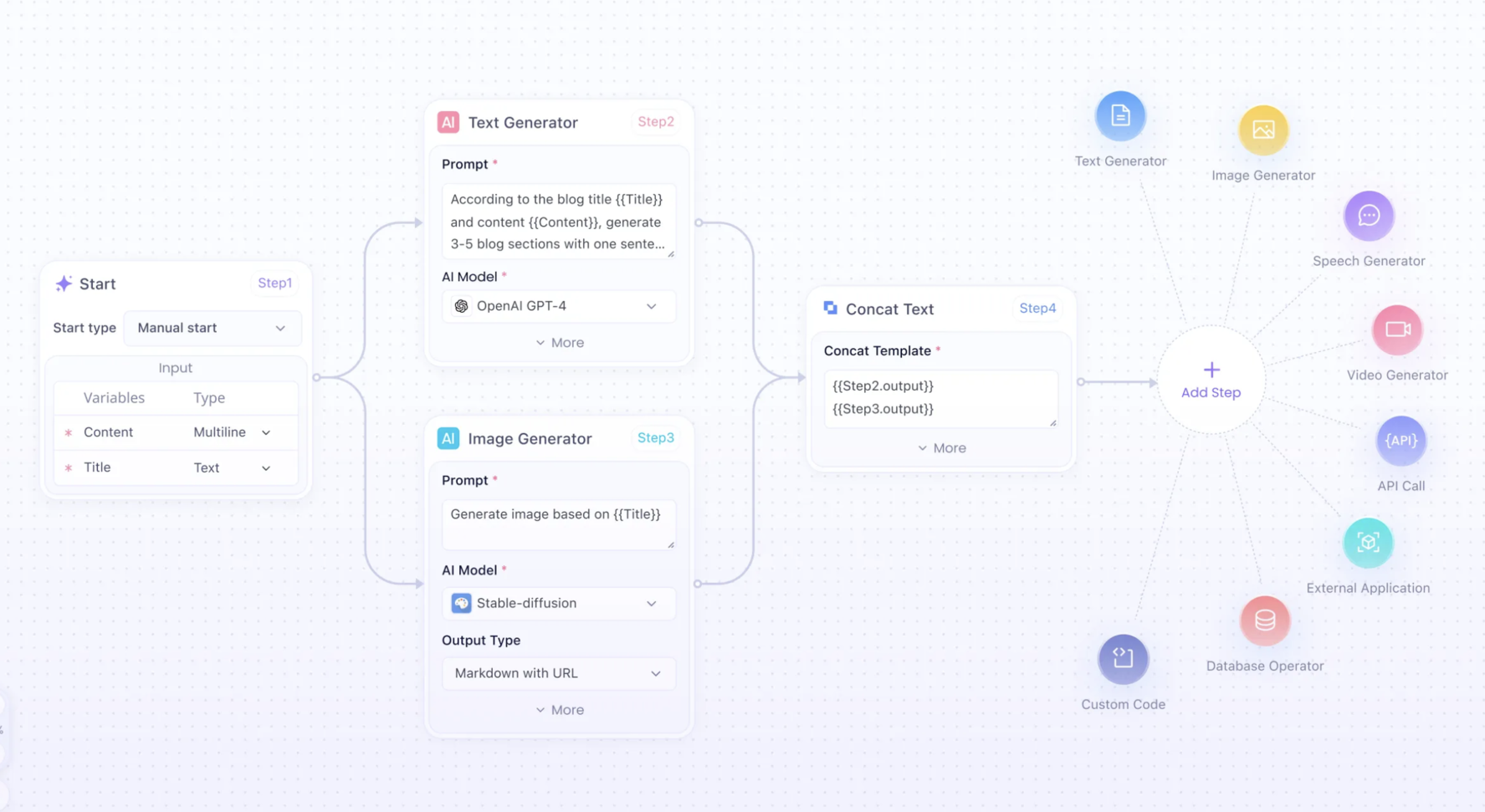

Anakin AI kann Ihnen dabei helfen, ganz einfach jede KI-App mit hochgradig anpassbarem Workflow zu erstellen. Sie erhalten Zugriff auf viele, viele KI-Modelle wie GPT-4-Turbo, Claude-2-100k, API für Midjourney & Stable Diffusion und vieles mehr!

Interessiert? Schauen Sie sich Anakin AI an und testen Sie es kostenlos aus!👇👇👇

Was ist Starling-7B?

Starling-7B ist ein Open-Source Large Language Model (LLM), das wegen seiner bemerkenswerten Leistung und der gemeinschaftlichen Grundhaltung bei seiner Entwicklung Schlagzeilen macht. Das Modell nutzt die Verstärkung des Lernens aus KI-Feedback (RLAIF) und verwendet einen speziell kuratierten Datensatz namens Nectar. Starling-7B weist einen MT Bench-Score von 8,09 auf und liegt damit knapp hinter GPT-4 in Bezug auf die Leistungsfähigkeit, was angesichts seiner Open-Source-Natur besonders bemerkenswert ist.

Starling-7B ist ein Beweis für das Potenzial der von der Community getriebenen KI-Forschung. Es sticht aus verschiedenen Gründen heraus:

- Open-Source-Modell: Im Gegensatz zu proprietären Modellen eröffnet Starling-7B Möglichkeiten für breitere Experimente und Verbesserungen durch die Forschungsgemeinschaft.

- Leistung: Mit Bewertungen, die nahe an GPT-4 liegen, zeigt es, dass Open-Source-Modelle mit Branchenführern konkurrieren können.

- Innovation: Das Training des Modells beinhaltet neue Techniken wie RLAIF, die die Grenzen der KI-Forschung erweitern.

Starling-7B Benchmark: Ist es wirklich besser als GPT-4?

Die Bewertung der Wirksamkeit von LLMs wie Starling-7B umfasst komplexe Benchmarks, die verschiedene Aspekte der Fähigkeiten des Modells bewerten. Mit zunehmendem Training und Wachstum des Datensatzes können wir Verbesserungen in den Benchmarkscores, und somit in den Fähigkeiten und Anwendungen in realen Szenarien, erwarten.

Hugging Face-Karte für das Modell Starling-LM-7B-alpha

Wie wird Starling-7B trainiert?

Die Funktionalität von Starling-7B basiert im Kern auf der Methode RLAIF, einer Trainingstechnik, die die Stärken des überwachten Lernens und des Reinforcement-Lernens vereint. Dieser hybride Ansatz zielt darauf ab, die Reaktionen des Modells zu verfeinern, um hilfreicher zu sein und weniger anfällig für die Erzeugung schädlichen Inhalts.

Der Prozess umfasst mehrere Schritte:

- Datensammlung: Starling-7B stützt sich auf den Datensatz Nectar, der über 183K Chat-Anregungen und 3,8 Millionen paarweise Vergleiche enthält, um sein Belohnungsmodell zu trainieren.

- Verfeinerung der Antworten: Mit RLAIF bewertet Starling-7B Antworten hinsichtlich ihrer Hilfreichkeit und Sicherheit und lernt, Antworten zu bevorzugen, die in diesen Metriken höher bewertet werden.

- Testen: Die Leistung des Modells wird kontinuierlich anhand von Benchmarks wie MT Bench und AlpacaEval getestet, um sicherzustellen, dass Verbesserungen mit menschlichen Präferenzen übereinstimmen.

Training mit dem Nectar-Datensatz

Der Nectar-Datensatz bildet das Rückgrat des Trainingsregimes von Starling-7B. Es handelt sich um eine Sammlung von Chat-Anregungen und Antworten, die sorgfältig gekennzeichnet sind, um dem Modell ein differenziertes Verständnis menschlicher Konversation zu vermitteln. Mit diesem umfangreichen Datensatz kann Starling-7B:

- Verschiedene Gesprächsstile und Themen analysieren.

- Von einer Vielzahl von Antworten lernen, um seine eigenen zu verbessern.

- Ein Gefühl für Kontext und Angemessenheit bei den Antworten entwickeln.

Reinforcement Learning aus KI-Feedback (RLAIF)

RLAIF ermöglicht es Starling-7B, sich von einer bloßen Nachahmung menschlicher Sprache zu einem Modell zu entwickeln, das Benutzern tatsächlich assistieren und interagieren kann. Dieser Prozess beinhaltet:

- Die Bewertung der Qualität der Antworten anhand von vordefinierten Kriterien.

- Die Anpassung der Modellparameter, um Antworten zu bevorzugen, die diesen Standards entsprechen.

- Die iterative Verbesserung durch Feedback und Anpassung.

Dieser strenge Schulungsprozess stärkt Starling-7B und befähigt es, Aufgaben in der realen Welt effektiver und sicherer zu bewältigen.

Nein, Starling-7B ist nicht immun gegen Prompt-Injektion

Obwohl Starling-7B einen bedeutenden Fortschritt in der Open-Source-KI darstellt, ist er nicht frei von Herausforderungen, insbesondere im Hinblick auf Prompt-Injektion, eine Form der KI-Manipulation.

Stärken:

- Leistung: Nahe an der von GPT-4 mit einer Punktzahl von 8,09 in MT Bench.

- Open-Source: Fördert Gemeinschaftsbeiträge und Transparenz.

- Innovation: Nutzt RLAIF für kontinuierliche Verbesserung.

Herausforderungen:

- Komplexes Denken: Schwierigkeiten bei Aufgaben, die fortgeschrittene Problemlösung erfordern.

- Anwendung im echten Leben: Anpassung an die Unvorhersehbarkeit der Nutzung im wirklichen Leben.

- Jailbreak: Anfällig für Inputs, die darauf abzielen, seine Regeln zu untergraben.

Die Zukunft von Starling-7B ist so offen wie sein Quellcode. Mit einer soliden Grundlage und einem Community-getriebenen Ansatz ist das Potenzial für Wachstum und Innovation immens. Starling-7B repräsentiert nicht nur eine technologische Alternative zu Giganten wie GPT-4, sondern auch eine Vision von kollaborativer, transparenter und ethischer KI-Entwicklung.

Wenn wir vorausschauen, wird die Modellentwicklung wahrscheinlich eine größere Vielfalt an Daten, ausgefeiltere Trainingsmethoden und eine breitere Community-Einbindung umfassen, was den Weg für eine aufregende Ära in der Welt der KI ebnet.

Häufig gestellte Fragen (FAQs)

Wie unterscheidet sich Starling-7B von GPT-4?Starling-7B ist ein Open-Source-Modell, das RLAIF verwendet und eng an der Leistung von GPT-4 arbeitet, insbesondere in Benchmarks wie dem MT Bench.

Kann jeder das Starling-7B-Modell verwenden?Ja, als Open-Source-Modell ist Starling-7B für die Forschung und den nicht-kommerziellen Gebrauch zugänglich.

Was ist der Nectar-Datensatz?Nectar ist ein mit Labels versehener Ranking-Datensatz von GPT-4, der zur Schulung von Starling-7B verwendet wird und eine Vielzahl von Chat-Anfragen und -Antworten enthält.

Ist Starling-7B besser darin, menschliche Sprache zu verstehen als andere Modelle?Starling-7B wurde entwickelt, um hoch kompetent im Verständnis und der Interaktion mit menschlicher Sprache zu sein, wie durch seine Leistungstests belegt wird.

Wie trägt Starling-7B zur KI-Sicherheit bei?Starling-7B wird mit dem Fokus auf Hilfsbereitschaft und Unschädlichkeit trainiert und nutzt Benchmarks, die Sicherheit und Interaktionsqualität bewerten.