In der Stille eines schwach beleuchteten Schlafsaals, mit dem sanften Summen meines alten Laptops, begab ich mich auf eine Reise in die Welt des Codierens. Meine Mission war einfach, aber auch herausfordernd: Leben in einen Codecluster einhauchen und ihn in einen Chatbot verwandeln, der zu grundlegenden Gesprächen in der Lage ist. Nacht für Nacht fütterte ich ihn mit Zeilen von Python, um ihn zur Komplexität zu führen. Und dann, an einem klaren Herbstabend, spuckte er seine erste zusammenhängende Antwort aus. "Hallo, Welt!" sagte er, und in diesem Moment war es, als hätte ich eine geheime Tür zur Zukunft geöffnet.

Dieser erste Ausflug in die Künstliche Intelligenz war eine Mischung aus Magie und Logik, ein Zeugnis menschlicher Einfallsreichtum. Seit dieser triumphalen Nacht sind Jahre vergangen und das Feld der Künstlichen Intelligenz hat sich nicht nur weiterentwickelt, sondern ist in Bereiche vorgestoßen, die früher nur in der Science-Fiction zu finden waren. Die Veröffentlichung von Qwen 1.5 durch Alibaba Cloud ist ein Meilenstein in dieser fortlaufenden Saga, ein glänzendes Leuchtfeuer in der KI-Odyssee.

Die Reise von jenen frühen Tagen bis heute, wo KI Gedichte verfassen, Krankheiten diagnostizieren und sogar Autos fahren kann, ist einfach nur ein Wunder. Qwen 1.5 ist das neueste Kapitel in dieser außergewöhnlichen Geschichte, eine Erzählung, die sich mit jedem algorithmischen Durchbruch und jeder geschriebenen Codezeile weiter entfaltet.

Artikelzusammenfassung

- Der Debüt von Qwen 1.5: Alibaba Cloud bringt Qwen 1.5 auf den Markt, ein KI-Modell in sechs verschiedenen Größen, das mit beeindruckenden Fähigkeiten die Dominanz von Modellen wie GPT-3.5 herausfordert.

- Grenzen der Konversations-KI neu definieren: Mit multilingualer Unterstützung und der Fähigkeit, lange 32K Token-Kontexte zu verarbeiten, definiert Qwen 1.5 die Grenzen der Konversations-KI neu.

- Revolution der Open-Access: Qwen 1.5 steht nicht nur auf Augenhöhe mit Giganten wie GPT-4, sondern ist auch Vorreiter in der Open-Access-Bewegung in der KI und macht fortschrittliche Technologie für Innovatoren weltweit frei zugänglich.

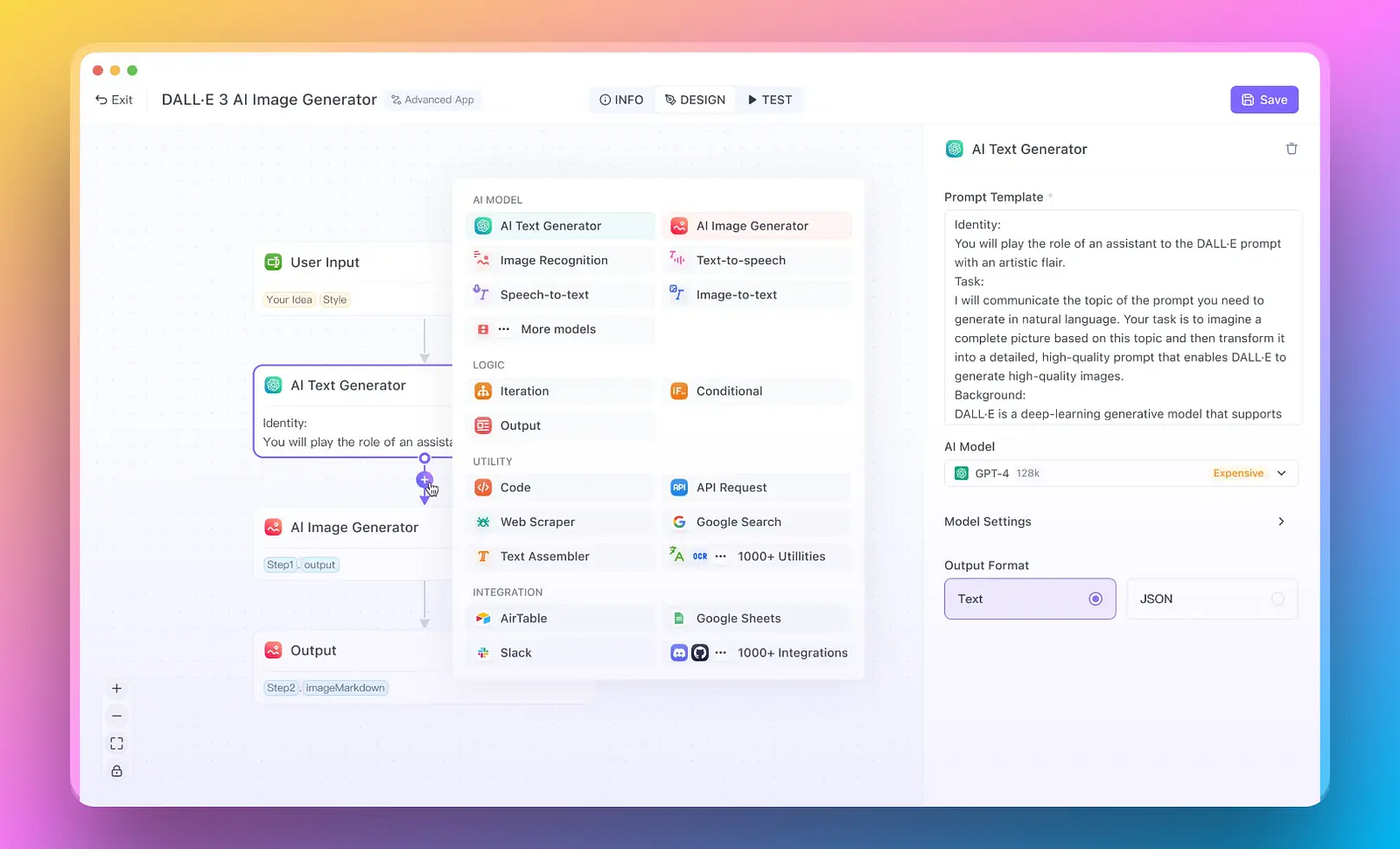

Was ist aber, wenn Sie nur schnelle KI-Apps entwickeln müssen? Und keine Zeit mit dem Stress verschwenden möchten?

Hier ist die Lösung: Anakin AI ist der beste No-Code KI-App-Builder auf dem Markt. Erstellen Sie KI-Agenten mit Multi-Modell-Unterstützung für Ihre eigenen Daten und Workflows!

Wie definiert Qwen 1.5 mehrsprachige KI-Modelle neu?

In der hektischen Bazar der KI-Innovationen fällt Qwen 1.5 nicht einfach nur als weiterer Konkurrent auf, sondern als Wegbereiter. Alibaba Cloud hat ein Wunder enthüllt, das eine Vielzahl von Parametern jonglieren kann, von einer bescheidenen Größe von 0,5 Milliarden bis hin zu beeindruckenden 72 Milliarden. Diese Vielfalt an Modellgrößen ist beispiellos und zeigt einen maßgeschneiderten Ansatz für KI, der so nuanciert oder umfangreich sein kann, wie erforderlich.

Die Suite ist in ihren verschiedenen Kapazitäten darauf ausgerichtet, eine breite Palette an Aufgaben zu bewältigen, von den einfachsten bis zu den anspruchsvollsten. Die größte Variante mit 72 Milliarden Parametern ähnelt einem digitalen Universalgelehrten mit einer tiefgreifenden Lern- und Verständnisfähigkeit.

Warum ist die Multilingual-Unterstützung von Qwen 1.5 bahnbrechend?

Multilingual-Unterstützung

Qwen 1.5 ist nicht nur ein Polyglott, sondern eine offene Tür zum globalen Gespräch. Mit seiner multilingualen Unterstützung durchbricht es die sprachlichen Grenzen, die Wissen und Fachkenntnisse lange Zeit in verschiedene Kategorien unterteilt haben.

Dieses Modell lädt eine Vielzahl von Stimmen an den Tisch ein und ermöglicht einen reichen Kulturmix, der zur KI-Weiterentwicklung beiträgt und davon profitiert. Es leitet eine Zukunft ein, in der Sprache kein Hindernis mehr im globalen Dialog der Innovation ist, sondern eine Brücke, die vielfältige Intellekte verbindet.

Effizienz des KI-Modells

Darüber hinaus zeugt die Effizienz von Qwen 1.5 von der nahtlosen Funktionalität von Alibaba Cloud. Indem es problemlos mit der Transformers-Bibliothek integriert ist, stellt Qwen 1.5 sicher, dass Entwickler seine Leistung ohne die üblichen Kompatibilitätsprobleme oder steilen Lernkurven nutzen können.

Die Gewichts-Optimierungen des Modells - Int-4, GPTQ, AWQ und GGUF - repräsentieren den Höhepunkt der Modell-Effizienz. Diese sind keine bloßen Fachbegriffe, sondern Meilensteine in der Suche nach einer schlankeren, agileren KI, die Leistung ohne den üppigen Ressourceneinsatz liefern kann, der normalerweise mit solch ausgeklügelten Modellen verbunden ist.

Wie steht Qwen 1.5 im Vergleich zu anderen Modellen da?

In der wettbewerbsintensiven Arena der Künstlichen Intelligenz, wo Modelle um die Vorherrschaft kämpfen, tritt Qwen 1.5 nicht nur an, um zu konkurrieren, sondern um einen neuen Maßstab zu setzen. Die Performance-Charts MT-Bench und Alpaca-Eval sind nicht nur Zahlen, sondern erzählen eine Geschichte des Triumphs. In dieser Geschichte steigt Qwen 1.5 in den Ranglisten auf und übertrifft Rivalen in einer breiten Palette von Metriken.

Benchmark-Leistung

| Modell | MMLU | C-Eval | GSM8K | MATH | HumanEval | MBPP | BBH | CMMLU |

|---|---|---|---|---|---|---|---|---|

| GPT-4 | 86.4 | 69.9 | 92.0 | 45.8 | 67.0 | 61.8 | 86.7 | 71.0 |

| Llama2-7B | 46.8 | 32.5 | 16.7 | 3.3 | 12.8 | 20.8 | 38.2 | 31.8 |

| Llama2-13B | 55.0 | 41.4 | 29.6 | 5.0 | 18.9 | 30.3 | 45.6 | 38.4 |

| Llama2-34B | 62.6 | - | 42.2 | 6.2 | 22.6 | 33.0 | 44.1 | - |

| Llama2-70B | 69.8 | 50.1 | 54.4 | 10.6 | 23.7 | 37.7 | 58.4 | 53.6 |

| Mistral-7B | 64.1 | 47.4 | 47.5 | 11.3 | 27.4 | 38.6 | 56.7 | 44.7 |

| Mixtral-8x7B | 70.6 | - | 74.4 | 28.4 | 40.2 | 60.7 | - | - |

| Qwen1.5-7B | 61.0 | 74.1 | 62.5 | 20.3 | 36.0 | 37.4 | 40.2 | 73.1 |

| Qwen1.5-14B | 67.6 | 78.7 | 70.1 | 29.2 | 37.8 | 44.0 | 53.7 | 77.6 |

| Qwen1.5-72B | 77.5 | 84.1 | 79.5 | 34.1 | 41.5 | 53.4 | 65.5 | 83.5 |

Hier sind unsere Einschätzungen:

- Stellen Sie sich einen Zehnkampf vor, bei dem ein einzelner Athlet die Konkurrenz fast in jeder Disziplin übertrifft. Dies ist es, was Qwen 1.5 im digitalen Bereich erreicht. Die Leistungscharts zeigen die Fähigkeiten von Qwen 1.5 auf und setzen es nicht nur neben, sondern oft über andere renommierte Modelle wie GPT-3.5.

- Es ist ein Beweis für das Design, das Robustheit mit Vielseitigkeit verbindet und dafür sorgt, dass Qwen 1.5 sowohl bei der Sprachverständnis, der Generierung als auch dem Denken hervorragende Leistungen erbringt.

Unterstützung langer Kontexte

Es erfordert eine gewisse Finesse, um eine lange Unterhaltung zu führen oder ein komplexes Dokument zu analysieren, und hier zeigt Qwen 1.5 sein Können.

| Modelle | Coursera | GSM | QuALITY | TOEFL | SFiction | Durchschn. |

|---|---|---|---|---|---|---|

| GPT3.5-turbo-16k | 63.51 | 84.00 | 61.38 | 78.43 | 64.84 | 70.43 |

| Claude1.3-100k | 60.03 | 88.00 | 73.76 | 83.64 | 72.65 | 75.62 |

| GPT4-32k | 75.58 | 96.00 | 82.17 | 84.38 | 74.99 | 82.62 |

| Qwen-72B-Chat | 58.13 | 76.00 | 77.22 | 86.24 | 69.53 | 73.42 |

| Qwen1.5-0.5B-Chat | 30.81 | 6.00 | 34.16 | 40.52 | 49.22 | 32.14 |

| Qwen1.5-1.8B-Chat | 39.24 | 37.00 | 42.08 | 55.76 | 44.53 | 43.72 |

| Qwen1.5-4B-Chat | 54.94 | 47.00 | 57.92 | 69.15 | 56.25 | 57.05 |

| Qwen1.5-7B-Chat | 59.74 | 60.00 | 64.36 | 79.18 | 62.50 | 65.16 |

| Qwen1.5-14B-Chat | 69.04 | 79.00 | 74.75 | 83.64 | 75.78 | 76.44 |

| Qwen1.5-72B-Chat | 71.95 | 82.00 | 77.72 | 85.50 | 73.44 | 78.12 |

Hier sind die Einschätzungen:

- Mit der Fähigkeit, bis zu 32.000 Token zu verarbeiten, ähnelt es einem Meisterweber, der mit den längsten Fäden umgehen kann, ohne das Muster zu verlieren.

- Diese Fähigkeit, Kohärenz über längere Dialoge oder Erzählungen aufrechtzuerhalten, eröffnet neue Möglichkeiten für Anwendungen, die ein tiefes kontextuelles Bewusstsein erfordern, angefangen bei der Erstellung rechtlicher Dokumente bis hin zur Komposition literarischer Werke.

Und... Open Source!

Der Wert eines KI-Modells besteht nicht nur in seiner Leistung, sondern auch in seiner Reichweite. Indem es eine Open-Access-Philosophie annimmt, reicht Qwen 1.5 weltweit Entwicklern und Forschern die Hand. Diese Zugänglichkeit stellt sicher, dass die Früchte der Arbeit von Alibaba Cloud nicht hinter den Toren proprietärer Beschränkungen verschlossen bleiben, sondern frei geteilt werden und Innovationen und Forschung über Grenzen hinweg vorantreiben. Es ist ein Modell, das genauso einem Studenten im Wohnheim einer Universität gehört wie einem Entwickler in einem Technologiekonzern.

Auf dem großen Schachbrett der KI ist Qwen 1.5 der Schachmatt-Zug von Alibaba Cloud. Es bietet eine beispiellose Leistung, bemerkenswertes Kontextmanagement und universelle Zugänglichkeit. Es steht nicht isoliert da, sondern als Teil eines Ökosystems, das von der Gemeinschaft geprägt wird und diese prägt.

Schritt-für-Schritt-Anleitung zur Verwendung von Qwen 1.5

Das Entwickeln mit Qwen 1.5 ist dank der Integration mit der Transformers-Bibliothek von Hugging Face deutlich benutzerfreundlicher geworden. Hier ist eine schrittweise Anleitung, um loszulegen:

Erste Schritte mit Qwen 1.5

Richten Sie Ihre Umgebung ein: Stellen Sie sicher, dass Sie die neueste Version der Hugging Face Transformers installiert haben, die Qwen 1.5 unterstützt.

Das Modell laden: Verwenden Sie AutoModelForCausalLM.from_pretrained mit dem Modelnamen und device_map auf "auto" gesetzt, um das Modell für kausales Sprachmodellieren zu laden.

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen1.5-7B-Chat", device_map="auto")

Mit Qwen 1.5 chatten: Bereiten Sie Ihre Eingabe vor und verwenden Sie den Tokenizer, um eine Chat-Vorlage anzuwenden. Generieren Sie dann eine Antwort mit dem Modell.

from transformers import AutoModelForCausalLM, AutoTokenizer

# ... (Initialisierungscode hier)

# Generieren und Dekodieren der Antwort

# ... (Generierungs- und Dekodierungscode hier)

Erweiterte Gewichtungen nutzen: Für Szenarien mit geringen Ressourcen oder Bereitstellungen können AWQ- und GPTQ-Modelle einfach geladen werden, indem Sie sie mit ihren entsprechenden Modellnamen verwenden.

Bereitstellen mit Inferenz-Frameworks: Integrieren Sie Qwen 1.5 mit beliebten Frameworks wie vLLM und SGLang für eine einfache Bereitstellung.

python -m vllm.entrypoints.openai.api_server --model Qwen/Qwen1.5-7B-Chat

Lokale Ausführung: Für die lokale Ausführung verwenden Sie die bereitgestellte Llama.cpp-Unterstützung oder die GGUF-quantisierten Modelle aus dem Hugging Face Model Hub.

Erstellen Sie eine Web-Demo: Richten Sie eine lokale Web-Demo über die Text generation web UI für interaktive Erlebnisse ein.

Fortgeschrittene Entwickler und Anwendungen:

Für fortgeschrittene Entwicklung: Wenn Sie komplexere Aufgaben wie Post-Training durchführen möchten, unterstützt Qwen 1.5 den Hugging Face Trainer und Peft. Frameworks wie LLaMA-Factory und Axolotl erleichtern auch das überwachte Feinabstimmen und die Ausrichtungstechniken.

Anwendungen im Kontext: Qwen 1.5 ist vielseitig genug, um in verschiedenen Anwendungen verwendet zu werden. OpenAI-API kompatible APIs und lokale Modelle können für die Integration mit Frameworks wie LlamaIndex, LangChain und CrewAI erstellt werden.

Beispiel: Verwendung von vLLM für Bereitstellung

# Starten Sie den API-Server unter Verwendung von vLLM

python -m vllm.entrypoints.openai.api_server --model Qwen/Qwen1.5-7B-Chat

# Verwenden Sie curl, um mit Ihrem Modell zu interagieren

curl http://localhost: 8000/v1/chat/completions \

-H "Content-Type: Anwendung/json" \

-d '{

"Modell": "Qwen/Qwen1.5-7B-Chat",

"Nachrichten": [

{"Rolle": "System", "Inhalt": "Du bist ein hilfreicher Assistent."},

{"Rolle": "Benutzer", "Inhalt": "Sag mir etwas über große Sprachmodelle."}

]

}'

Lokales Ausführen von Qwen 1.5 mit Lama.cpp

- Für eine lokale Ausführung wurde Lama.cpp aktualisiert, um Qwen 1.5 zu unterstützen und es Ihnen zu ermöglichen, quantisierte Modelle einfach zu nutzen.

./main -m qwen1.5-7b-chat-q2_k.gguf -n 512 --color -i -cml -f prompts/chat-with-qwen.txt

Qwen 1.5 mit Ollama ausführen

- Mit der Unterstützung von Ollama kann das Ausführen des Modells so einfach wie eine einzelne Befehlszeile sein:

ollama run qwen

Erstellen einer Web-Demo

- Um eine webbasierte Demonstration zu erstellen, wird die Text Generation Web UI empfohlen, da sie einfach zu bedienen und interaktiv ist.

Training mit Qwen 1.5

- Für diejenigen, die Modelle trainieren oder feinabstimmen möchten, ist Qwen 1.5 kompatibel mit dem Hugging Face Trainer und Peft, zusammen mit LLaMA-Factory und Axolotl für fortgeschrittene Trainingstechniken.

Fazit

Qwen 1.5 stellt einen bedeutenden Fortschritt in der Fähigkeit der AI-Community dar, modernste Sprachmodelle zu entwickeln, bereitzustellen und zu integrieren. Mit seiner umfassenden Unterstützung für verschiedene Plattformen und Frameworks sowie einem Schwerpunkt auf die Entwicklererfahrung ist Qwen 1.5 bereit, eine neue Welle von Innovation und Anwendung auf dem Gebiet der KI anzustoßen. Egal, ob Sie Forscher, Entwickler oder ein KI-Enthusiast sind, Qwen 1.5 bietet Ihnen die Tools und Fähigkeiten, um die Grenzen dessen zu erweitern, was mit Sprachmodellen möglich ist.

Was ist aber, wenn Sie nur schnelle KI-Apps entwickeln müssen? Und keine Zeit mit dem Stress verschwenden möchten?

Hier ist die Lösung: Anakin AI ist der beste No-Code KI-App-Builder auf dem Markt. Erstellen Sie KI-Agenten mit Multi-Modell-Unterstützung für Ihre eigenen Daten und Workflows!