Retrieval Augmented Generation (RAG) ist eine leistungsstarke Technik, die Information Retrieval mit Sprachmodellen kombiniert, um hochwertige Antworten zu generieren. LangChain, eine beliebte Python-Bibliothek zum Erstellen von Anwendungen mit großen Sprachmodellen (LLMs), bietet eine nahtlose Möglichkeit, RAG in Ihren Projekten zu implementieren. In diesem Artikel werden wir uns damit befassen, was RAG ist, wie es in LangChain funktioniert und wie Sie es verwenden können, um intelligente Chatbots und Frage-Antwort-Systeme zu erstellen.

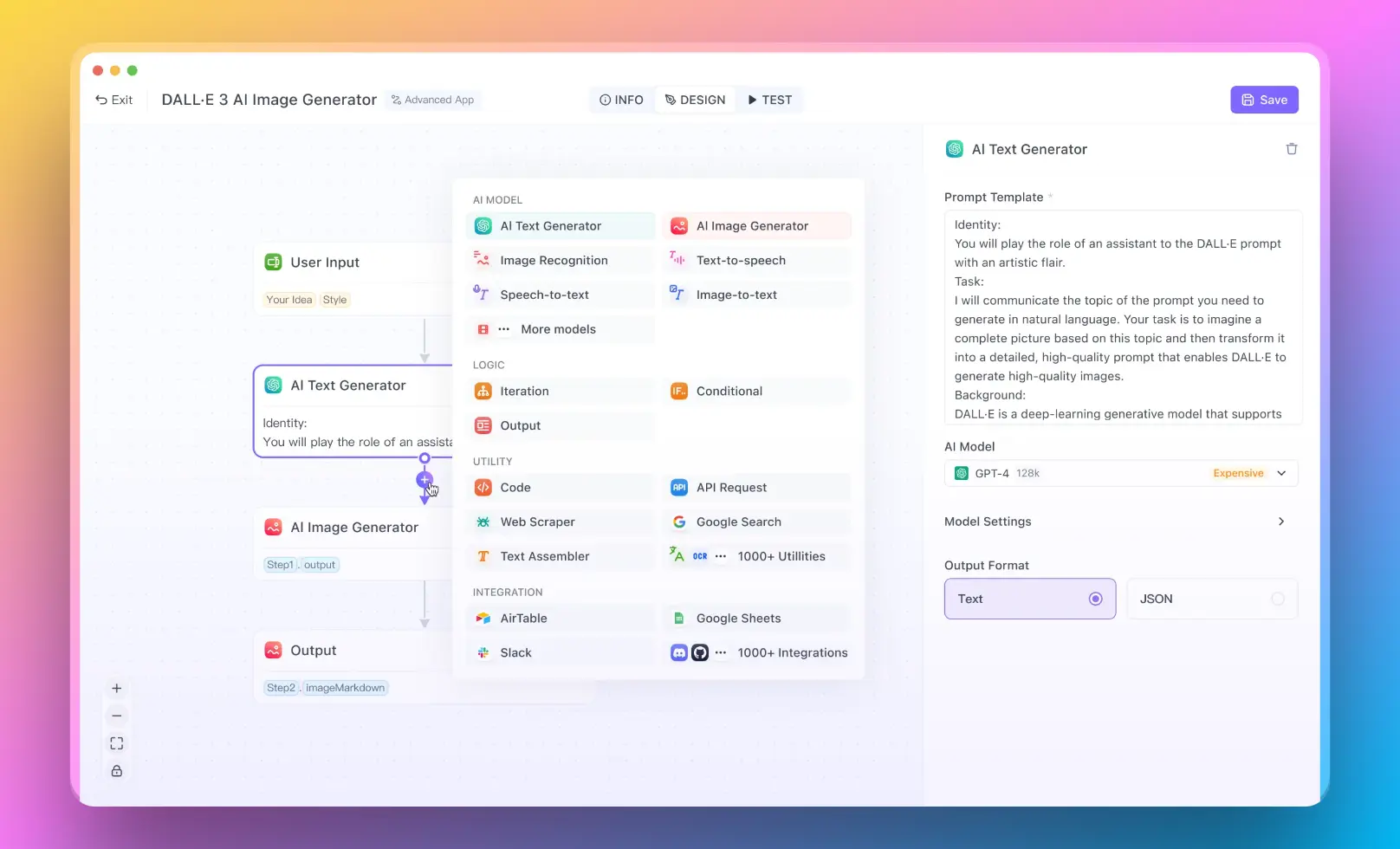

- Für Benutzer, die ein RAG-System ohne Programmierkenntnisse ausführen möchten, können Sie Anakin AI ausprobieren, mit dem Sie fantastische KI-Apps mit einem No-Code-Builder erstellen können!

Was ist RAG in LangChain?

RAG in LangChain bezieht sich auf das Retrieval Augmented Generation-Modell, das die Fähigkeiten von LLMs durch die Integration relevanter Informationen aus externen Quellen verbessert. Es ermöglicht dem Modell, Wissen aus einer gegebenen Menge von Dokumenten oder Datenquellen abzurufen und zu nutzen, um präzisere und kontextuell relevantere Antworten zu generieren.

Das RAG-Modell in Python verstehen

Das RAG-Modell in Python besteht aus drei Hauptkomponenten:

Retriever: Der Retriever ist verantwortlich für die Suche und das Abrufen relevanter Dokumente oder Passagen basierend auf der Eingabeabfrage. Er verwendet Techniken wie die Vektorsimilaritätssuche, um die relevantesten Informationen zu finden.

Generator: Der Generator ist ein LLM, der die abgerufenen Dokumente und die Eingabeabfrage als Kontext verwendet und basierend auf den kombinierten Informationen eine Antwort generiert.

Kombinierer: Der Kombinierer nimmt die abgerufenen Dokumente und die generierte Antwort und kombiniert sie, um die endgültige Ausgabe zu erzeugen. Er kann verschiedene Strategien wie Konkatenation oder gewichtete Durchschnittsbildung verwenden, um die Informationen zu fusionieren.

Wie man RAG in Python mit LangChain verwendet

Um RAG in Python mit LangChain zu verwenden, befolgen Sie diese Schritte:

- Installieren Sie die erforderlichen Abhängigkeiten:

pip install langchain openai chromadb

Bereiten Sie Ihre Daten vor, indem Sie sie in ein geeignetes Format konvertieren, wie z. B. Textdateien oder eine CSV-Datei.

Erstellen Sie eine Vektordatenbank mit einer Bibliothek wie Chroma:

from langchain.vectorstores import Chroma

documents = [...] # Laden Sie Ihre Dokumente

vectordb = Chroma.from_documents(documents, embedding=OpenAIEmbeddings())

- Definieren Sie Ihren Retriever mithilfe der Vektordatenbank:

retriever = vectordb.as_retriever(search_kwargs={"k": 3})

- Erstellen Sie eine LLM-Instanz:

from langchain.llms import OpenAI

llm = OpenAI(temperature=0)

- Kombinieren Sie den Retriever und den LLM, um ein RAG-Modell zu erstellen:

from langchain.chains import RetrievalQA

qa = RetrievalQA.from_chain_type(llm=llm, chain_type="stuff", retriever=retriever)

- Verwenden Sie das RAG-Modell, um Antworten zu generieren:

query = "Was ist die Hauptstadt von Frankreich?"

response = qa.run(query)

print(response)

Anwendungen von LangChain RAG

LangChain RAG (Retrieval Augmented Generation) ist eine leistungsstarke Technik, die für verschiedene KI-Anwendungen eingesetzt werden kann. Erforschen wir einige dieser Anwendungen im Detail und geben Ihnen schrittweise Anleitungen und Beispielschnipsel, um Ihnen den Einstieg zu erleichtern.

Aufbau von intelligenten Chatbots mit LangChain RAG

Eine der Hauptanwendungen von LangChain RAG besteht darin, intelligente Chatbots zu erstellen, die Fragen auf der Grundlage einer Wissensbasis beantworten können. So können Sie einen Chatbot mit LangChain RAG erstellen:

Bereiten Sie Ihre Wissensbasis vor, indem Sie relevante Dokumente oder Datenquellen sammeln.

Konvertieren Sie die Dokumente in ein geeignetes Format, wie z. B. Textdateien oder eine CSV-Datei.

Erstellen Sie eine Vektordatenbank mit einer Bibliothek wie Chroma:

from langchain.vectorstores import Chroma

from langchain.embeddings import OpenAIEmbeddings

documents = [...] # Laden Sie Ihre Dokumente

vectordb = Chroma.from_documents(documents, embedding=OpenAIEmbeddings())

- Definieren Sie Ihren Retriever mithilfe der Vektordatenbank:

retriever = vectordb.as_retriever(search_kwargs={"k": 3})

- Erstellen Sie eine LLM-Instanz:

from langchain.llms import OpenAI

llm = OpenAI(temperature=0)

- Kombinieren Sie den Retriever und den LLM, um ein RAG-Modell zu erstellen:

from langchain.chains import ConversationalRetrievalChain

qa = ConversationalRetrievalChain.from_llm(llm=llm, retriever=retriever)

- Implementieren Sie eine Schleife für die Konversation, um mit dem Chatbot zu interagieren:

chat_history = []

while True:

query = input("Benutzer: ")

if query.lower() == 'exit':

break

result = qa({"question": query, "chat_history": chat_history})

chat_history.append((query, result['answer']))

print(f"Assistent: {result['answer']}")

Erstellen von Frage-Antwort-Systemen mit LangChain RAG

LangChain RAG kann zur Erstellung von Frage-Antwort-Systemen für bestimmte Bereiche wie Kundensupport oder technische Dokumentation verwendet werden. So können Sie ein Frage-Antwort-System erstellen:

Sammeln und verarbeiten Sie die relevanten Dokumente oder Datenquellen für Ihren spezifischen Bereich.

Erstellen Sie eine Vektordatenbank und einen Retriever wie im vorherigen Beispiel gezeigt.

Definieren Sie eine Frage-Antwort-Kette mithilfe des RAG-Modells:

from langchain.chains import RetrievalQA

qa_chain = RetrievalQA.from_chain_type(llm=llm, chain_type="stuff", retriever=retriever)

- Verwenden Sie die Frage-Antwort-Kette, um Antworten zu generieren:

query = "Welche sind die Systemanforderungen für die Installation der Software?"

response = qa_chain.run(query)

print(response)

Generieren von Zusammenfassungen oder Erklärungen mit LangChain RAG

LangChain RAG kann verwendet werden, um Zusammenfassungen oder Erklärungen aus einer Sammlung von Dokumenten zu generieren. So können Sie dies erreichen:

Bereiten Sie Ihre Dokumentsammlung vor und erstellen Sie eine Vektordatenbank und einen Retriever wie in den vorherigen Beispielen gezeigt.

Definieren Sie eine Zusammenfassungskette mit Hilfe des RAG-Modells:

from langchain.chains import LoadQA

summarization_chain = LoadQA(llm=llm, retriever=retriever)

- Verwenden Sie die Zusammenfassungskette, um Zusammenfassungen oder Erklärungen zu generieren:

query = "Geben Sie eine Zusammenfassung der wichtigsten besprochenen Punkte im Sitzungsprotokoll."

summary = summarization_chain.run(query)

print(summary)

Verbesserung der Suchfunktionalität mit LangChain RAG

LangChain RAG kann verwendet werden, um die Suchfunktionalität durch Bereitstellung relevanterer und kontextbezogener Ergebnisse zu verbessern. So können Sie RAG in ein Suchsystem integrieren:

Bereiten Sie Ihre Dokumentsammlung vor und erstellen Sie eine Vektordatenbank und einen Retriever wie in den vorherigen Beispielen gezeigt.

Definieren Sie eine Suchfunktion, die das RAG-Modell nutzt:

def search(query):

docs = retriever.get_relevant_documents(query)

context = " ".join([doc.page_content for doc in docs])

response = llm.generate(f"{context}\nFrage: {query}\nAntwort:", stop=None, max_tokens=100).generations[0].text

return response.strip()

- Verwenden Sie die Suchfunktion, um relevante Ergebnisse abzurufen:

query = "Welche Vorteile bietet die Verwendung unseres Produkts?"

result = search(query)

print(result)

Indem Sie die Leistung von Retrieval und Generation nutzen, ermöglicht Ihnen LangChain RAG die Erstellung von KI-Anwendungen, die Benutzerabfragen mit hoher Genauigkeit und Relevanz verstehen und darauf reagieren können. Egal, ob Sie Chatbots, Frage-Antwort-Systeme, Zusammenfassungswerkzeuge erstellen oder Suchfunktionalität verbessern möchten, LangChain RAG bietet eine flexible und effiziente Möglichkeit, externes Wissen zu integrieren und kontextuell relevante Ausgaben zu generieren.

Fazit

RAG in LangChain ist eine leistungsstarke Technik, die Information Retrieval mit Sprachmodellen kombiniert, um hochwertige Antworten zu generieren. Durch die Verwendung der intuitiven API von LangChain und die Integration mit Vektordatenbanken wie Chroma können Sie RAG einfach in Ihre Python-Projekte implementieren. Egal, ob Sie Chatbots, Frage-Antwort-Systeme oder andere KI-Anwendungen erstellen, LangChain RAG bietet eine flexible und effiziente Möglichkeit, externes Wissen zu integrieren und kontextuell relevante Ausgaben zu generieren.

Entdecken Sie die Kraft von LangChain RAG und revolutionieren Sie Ihre KI-Anwendungen mit retrieval augmented generation!