Anakin AI ist die Lösung!

Anakin AI ist die All-in-One-Plattform, auf der Sie Zugriff auf Llama-Modelle von Meta, Claude 3.5 Sonnet, GPT-4, Google Gemini Flash, Unzensierte LLM, DALLE 3, Stable Diffusion an einem Ort mit API-Unterstützung für eine einfache Integration haben!

Legen Sie los und probieren Sie es jetzt aus!👇👇👇

Die Llama 3.1-Modelle von Meta stellen den neuesten Fortschritt bei Open-Source-Großsprachmodellen (LLMs) dar und bieten beeindruckende Fähigkeiten für verschiedene Aufgaben. In diesem umfassenden Leitfaden werden wir erkunden, wie man diese Modelle lokal ausführt, ihre Leistung vergleicht und alternative Plattformen zur Nutzung diskutiert.

Understanding Llama 3.1 Modelle

Llama 3.1 ist in drei Größen erhältlich: 8B, 70B und 405B Parameter. Jede Modellgröße bietet unterschiedliche Fähigkeiten und Ressourcenanforderungen:

- Llama 3.1 8B: Ideal für begrenzte Rechenressourcen, ausgezeichnet in Textzusammenfassung, Klassifizierung, Sentimentanalyse und latenzarmer Sprachübersetzung.

- Llama 3.1 70B: Geeignet für Content-Erstellung, Conversational AI, Sprachverständnis und Unternehmensanwendungen.

- Llama 3.1 405B: Das größte öffentlich verfügbare LLM, perfekt für Unternehmensanwendungen, Forschung und Generierung synthetischer Daten.

Benchmarks und Leistungsvergleich

Llama 3.1-Modelle haben gegenüber ihren Vorgängern erhebliche Verbesserungen in verschiedenen Benchmarks gezeigt. Hier ist eine Vergleichstabelle, die einige wichtige Leistungskennzahlen hervorhebt:

| Benchmark | Llama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B | GPT-4 | Claude 3.5 Sonnet |

|---|---|---|---|---|---|

| MATH | 35.2 | 68.3 | 73.8 | 76.6 | 71.1 |

| MMLU | 45.3 | 69.7 | 75.1 | 86.4 | 79.3 |

| HumanEval | 18.3 | 42.2 | 48.9 | 67.0 | 65.2 |

| GSM8K | 22.1 | 63.5 | 69.7 | 92.0 | 88.4 |

Es ist erwähnenswert, dass Llama 3.1 405B zwar eine beeindruckende Leistung in allen Bereichen zeigt, jedoch nicht immer das 70B-Modell in jeder Aufgabe übertreffen kann. Diese Variabilität unterstreicht die Bedeutung der Wahl der richtigen Modellgröße für bestimmte Anwendungsfälle.

Lokale Ausführung von Llama 3.1-Modellen

1. Verwendung von Ollama für die lokale Bereitstellung von Llama 3.1-Modellen (8B, 70B, 405B)

Ollama ist ein leichtgewichtiges, erweiterbares Framework für die lokale Ausführung von Llama-Modellen. Es bietet eine benutzerfreundliche Befehlszeilenschnittstelle und unterstützt verschiedene Modellgrößen.

Um mit Ollama zu beginnen:

- Installieren Sie Ollama von der offiziellen Website (https://ollama.ai).

- Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um Llama 3.1 herunterzuladen und auszuführen:

ollama run llama3

- Sobald das Modell geladen ist, können Sie mit ihm interagieren:

ollama run llama3 "Erklären Sie das Konzept der Quantenverschränkung"

Für fortgeschrittene Anwendungen können Sie eine benutzerdefinierte Modelldatei (Modelfile) erstellen, um Parameter feinabzustimmen:

FROM llama3:8b

PARAMETER temperature 0.7

PARAMETER top_k 50

PARAMETER top_p 0.95

PARAMETER repeat_penalty 1.1

Speichern Sie dies als Modelfile und erstellen Sie Ihr benutzerdefiniertes Modell:

ollama create mymodel -f Modelfile

ollama run mymodel

Ollama bietet auch eine REST-API zur Integration von Llama 3.1 in Ihre Anwendungen:

curl http://localhost:11434/api/generate -d '{

"model": "llama3",

"prompt": "Was ist die Hauptstadt von Frankreich?"

}'

2. Verwendung von LM Studio für lokale Bereitstellungen von Llama-Modellen (8B, 70B, 405B)

LM Studio bietet eine benutzerfreundliche grafische Benutzeroberfläche zum Ausführen und Interagieren mit Llama 3.1-Modellen lokal. Hier erfahren Sie, wie Sie loslegen:

- Laden Sie LM Studio von https://lmstudio.ai herunter und installieren Sie es.

- Starten Sie LM Studio und navigieren Sie zur Modellsuchseite.

- Suchen Sie nach "lmstudio-community/llama-3", um verfügbare Llama 3.1-Modelle zu finden.

- Wählen Sie die gewünschte Modellgröße (8B oder 70B) und Variante (Base oder Instruct) aus.

- Laden Sie das ausgewählte Modell herunter.

- Sobald es heruntergeladen ist, laden Sie das Modell in LM Studio.

- Verwenden Sie die Chat-Schnittstelle, um mit dem Modell zu interagieren, oder richten Sie einen lokalen API-Server für den programmatischen Zugriff ein.

LM Studio bietet zwei Hauptvarianten von Llama 3.1:

- Base: Erfordert Prompt-Engineering-Techniken wie Few-Shot Prompting und In-Context Learning.

- Instruct: Feinabgestimmt, um Anweisungen zu befolgen und Gespräche zu führen.

Verwenden Sie für die beste Erfahrung mit der Instruct-Variante in den Einstellungen von LM Studio die "Llama 3"-Voreinstellung.

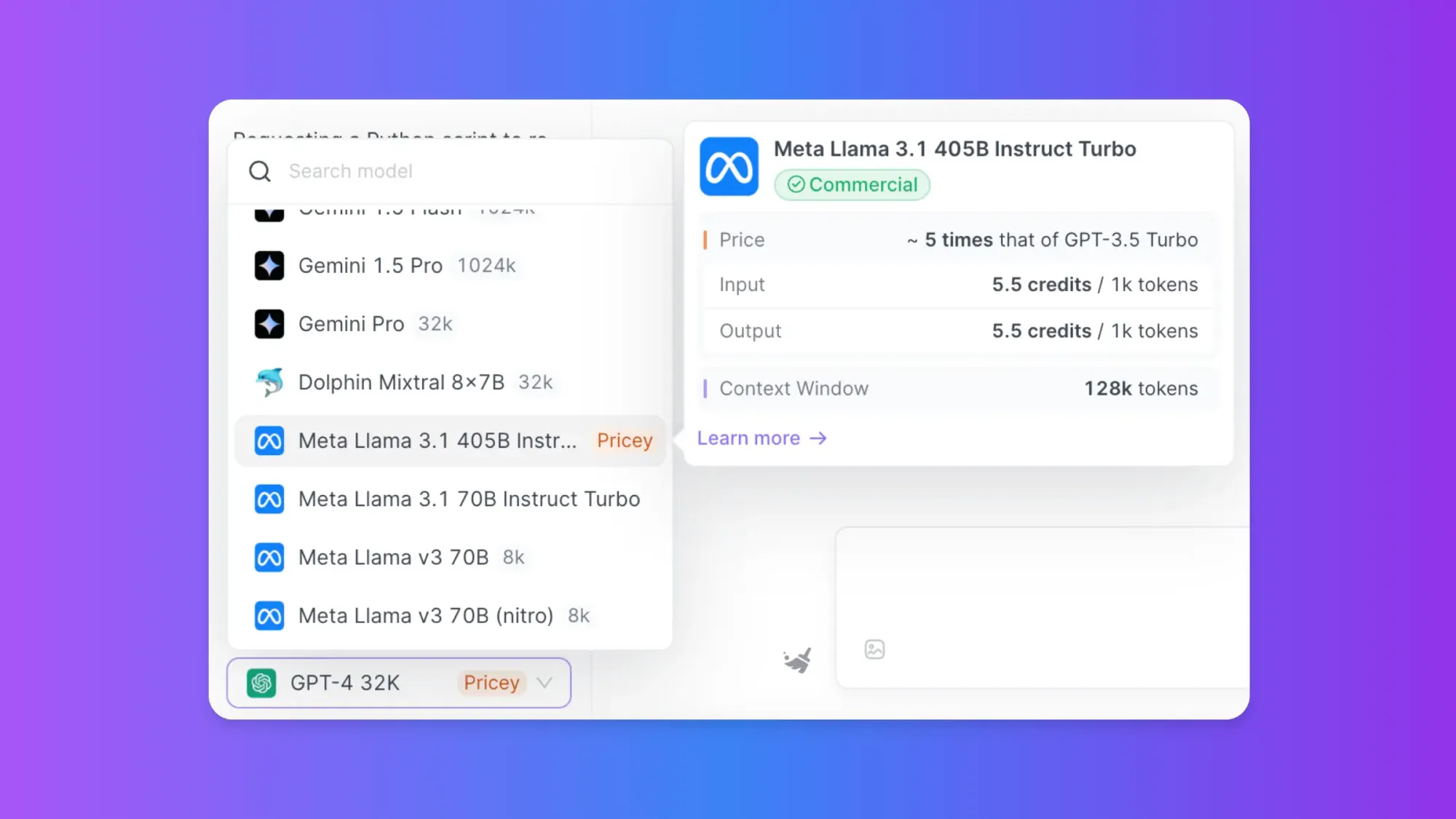

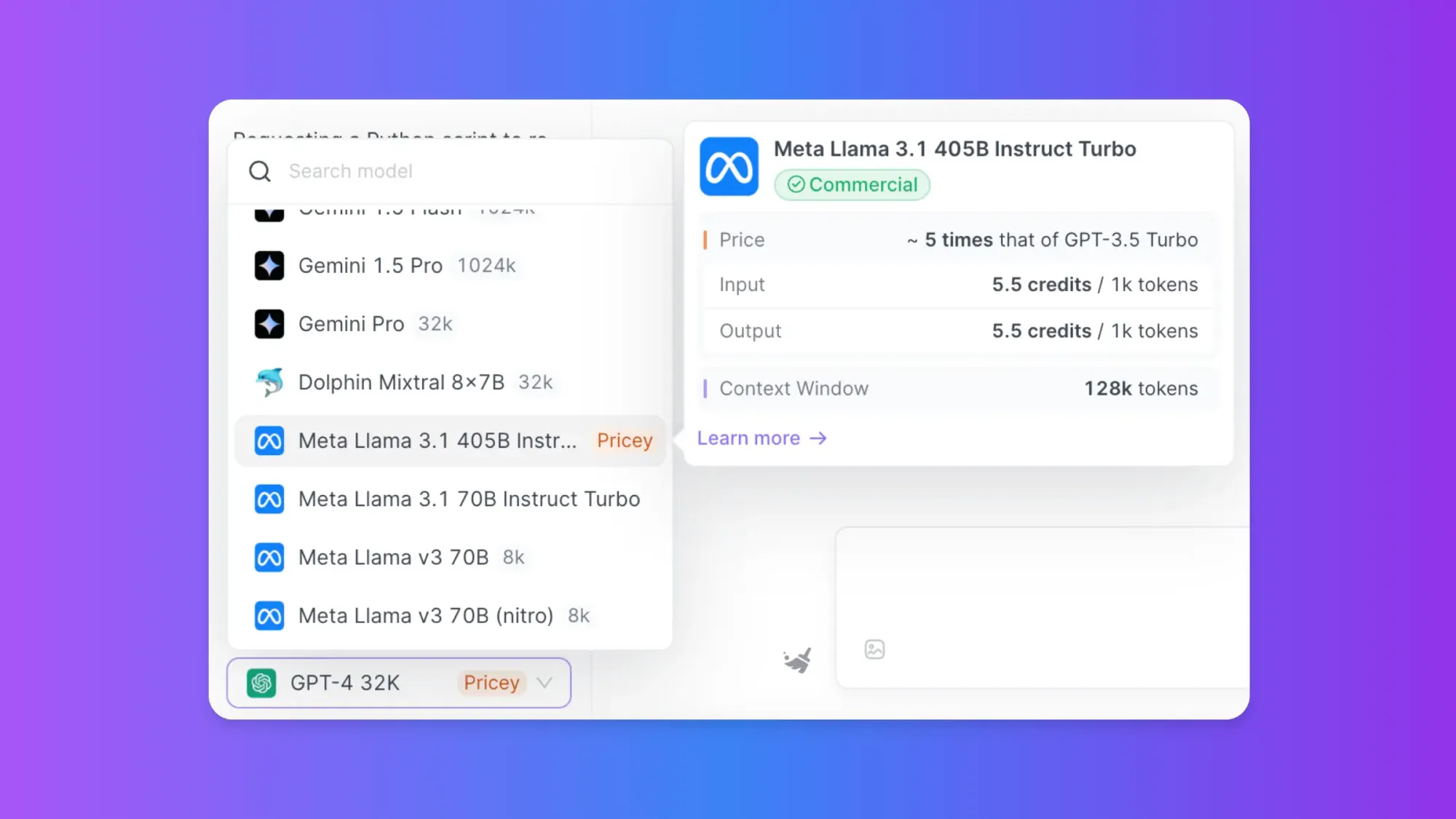

Verwendung von Anakin AI für den Online-Zugriff

Obwohl die lokale Ausführung von Llama 3.1-Modellen flexible Möglichkeiten bietet, erfordert sie erhebliche Rechenressourcen, insbesondere für größere Modelle. Anakin AI bietet eine alternative Lösung für diejenigen, die diese Modelle nutzen möchten, ohne den Aufwand der lokalen Einrichtung.

Anakin AI ist eine vielseitige Plattform, die verschiedene KI-Modelle integriert, einschließlich der Llama-Serie, und es Benutzern ermöglicht, KI-Anwendungen zu erstellen und anzupassen, ohne zu programmieren. Hier erfahren Sie, wie Sie Llama 3.1-Modelle über Anakin AI verwenden können:

- Besuchen Sie die Anakin AI-Website und erstellen Sie ein Konto.

- Erkunden Sie den App Store mit über 1.000 vorgefertigten KI-Apps.

- Wählen Sie eine auf Llama 3.1 basierende App aus oder erstellen Sie eine benutzerdefinierte App mit den Tools der Plattform.

- Passen Sie die App an Ihre spezifischen Anforderungen an.

- Bereitstellen und verwenden Sie die App direkt über die Benutzeroberfläche von Anakin AI.

Sie können ganz einfach KI-Workflows mit Anakin AI erstellen, ohne über Programmierkenntnisse zu verfügen. Verbinden Sie LLM-APIs wie GPT-4, Claude 3.5 Sonnet, Unzensierter Dolphin-Mixtral, Stable Diffusion, DALLE, Web Scraping.... zu einem Workflow!

Vergessen Sie komplizierte Codierung, automatisieren Sie Ihre alltäglichen Arbeiten mit Anakin AI!

Für begrenzte Zeit können Sie auch Google Gemini 1.5 und Stable Diffusion kostenlos nutzen!

Anakin AI bietet mehrere Vorteile für die Verwendung von Llama 3.1-Modellen:

- Keine lokale Einrichtung erforderlich: Zugriff auf leistungsstarke KI-Modelle, ohne sich um Hardwareanforderungen oder komplexe Installationen kümmern zu müssen.

- Integration mit anderen KI-Modellen: Kombinieren Sie Llama 3.1 mit anderen Modellen wie GPT-3.5, DALL-E oder Stable Diffusion für umfassendere Lösungen.

- Benutzerfreundliche Benutzeroberfläche: Erstellen und bereitstellen von KI-Anwendungen ohne Programmierkenntnisse.

- Skalierbarkeit: Skalieren Sie Ihre KI-Lösungen einfach, wenn sich Ihre Anforderungen ändern.

- Vielfältige Anwendungsfälle: Geeignet für Content-Erstellung, Kundensupport, Datenanalyse und mehr.

Die richtige Vorgehensweise wählen

Bei der Entscheidung, wie Llama 3.1-Modelle ausgeführt werden sollen, sollten Sie folgende Faktoren berücksichtigen:

- Rechenressourcen: Lokale Ausführung erfordert erhebliche CPU-/GPU-Leistung, insbesondere für größere Modelle.

- Datenschutz und Datensicherheit: Die lokale Ausführung bietet mehr Kontrolle über Ihre Daten.

- Anpassungsbedarf: Lokale Einrichtungen bieten mehr Flexibilität für die Feinabstimmung und Anpassung.

- Benutzerfreundlichkeit: Plattformen wie Anakin AI bieten eine benutzerfreundlichere Erfahrung für nicht-technische Benutzer.

- Integrationsanforderungen: Berücksichtigen Sie, wie das Modell in Ihre bestehenden Systeme integriert werden muss.

Best Practices für die Verwendung von Llama 3.1-Modellen

Unabhängig davon, wie Sie sich entscheiden, Llama 3.1-Modelle auszuführen, beachten Sie diese bewährten Methoden:

- Beginnen Sie mit dem kleinsten geeigneten Modell: Beginnen Sie mit dem 8B-Modell und skalieren Sie es bei Bedarf hoch.

- Feinabstimmung für bestimmte Aufgaben: Passen Sie das Modell an Ihren spezifischen Anwendungsfall an, um eine bessere Leistung zu erzielen.

- Überwachen Sie die Ressourcennutzung: Achten Sie besonders bei lokaler Ausführung auf die Auslastung von CPU, GPU und Speicher.

- Implementieren Sie angemessene Prompting-Techniken: Verwenden Sie klare und spezifische Eingabeaufforderungen, um die besten Ergebnisse aus dem Modell zu erzielen.

- Bleiben Sie auf dem neuesten Stand: Halten Sie Ihre lokalen Installationen oder Plattformabonnements auf dem neuesten Stand, um von den neuesten Verbesserungen zu profitieren.

Fazit

Llama 3.1-Modelle bieten beeindruckende Fähigkeiten für verschiedene natürliche Sprachverarbeitungsaufgaben. Ob Sie sie lokal mit Tools wie Ollama und LM Studio ausführen oder cloudbasierte Plattformen wie Anakin AI nutzen, diese Modelle bieten eine leistungsstarke Grundlage für den Aufbau fortschrittlicher KI-Anwendungen.

Lokale Einrichtungen bieten mehr Kontrolle und Anpassungsmöglichkeiten, erfordern jedoch mehr technisches Fachwissen und Rechenressourcen. Auf der anderen Seite bieten Plattformen wie Anakin AI eine zugängliche und skalierbare Lösung für diejenigen, die die Leistung von Llama 3.1 nutzen möchten, ohne die Komplexität der lokalen Bereitstellung.

Da sich das Gebiet der KI weiterhin rapide entwickelt, ist es wichtig, über die neuesten Entwicklungen und bewährten Methoden informiert zu bleiben, um das Beste aus diesen leistungsstarken Sprachmodellen zu machen. Experimentieren Sie mit verschiedenen Ansätzen, Modellgrößen und Anwendungsfällen, um die optimale Lösung für Ihre spezifischen Anforderungen zu finden.

Anakin AI ist die Lösung!

Anakin AI ist die All-in-One-Plattform, auf der Sie Zugriff auf Llama-Modelle von Meta, Claude 3.5 Sonnet, GPT-4, Google Gemini Flash, Unzensierte LLM, DALLE 3, Stable Diffusion an einem Ort mit API-Unterstützung für eine einfache Integration haben!

Legen Sie los und probieren Sie es jetzt aus!👇👇👇