Mitten im geschäftigen Herzen von Tokio, zwischen der von Neonlicht erleuchteten Skyline und dem unerbittlichen Rhythmus des täglichen Lebens, sah ich mich einer scheinbar unüberwindbaren Herausforderung gegenüber. Als aufstrebender digitaler Künstler war ich auf der Suche nach einer Serie von Kunstwerken, die das lebhafte Chaos des städtischen Lebens mit den nuancierten Ausdrücken menschlicher Emotionen verbinden konnten. Aber die Komplexität, solche Details und Tiefen in meinen Bildern festzuhalten, war entmutigend. In dieser Zeit der kreativen Turbulenzen stieß ich auf Ollama Vision und seine LLaVA-Modelle. Plötzlich schienen die Möglichkeiten endlos.

Ollama steht als Leuchtturm für diejenigen, die die Kraft großer Sprachmodelle lokal nutzen möchten. Es bietet eine Suite spezialisierter Vision-Modelle, die die Art und Weise, wie wir mit digitalen Bildern interagieren, verändern. Das kürzliche Update der LLaVA-Modelle auf Version 1.6 war bahnbrechend und bot höhere Bildauflösungsfähigkeiten, verbesserte Texterkennung und großzügigere Lizenzen. Dies bedeutete, dass ich nicht nur meine Kunst mit beispiellosem Detail verfeinern konnte, sondern auch mühelos Narrative und Bedeutungsschichten in jedes Stück einbetten konnte.

Voraussetzungen und Installation

Bevor Sie in die Welt von Ollama Vision eintauchen, müssen Sie einige Schritte unternehmen, um sicherzustellen, dass Sie bereit für diese Reise sind:

- Systemanforderungen: Ollama ist darauf ausgelegt, auf macOS- und Linux-Systemen reibungslos zu funktionieren. Die Vorfreude auf Windows-Kompatibilität steigert die Aufregung und verspricht eine noch breitere Zugänglichkeit in naher Zukunft.

- Installationsprozess: Das Einrichten von Ollama ist einfach. Besuchen Sie zunächst die offizielle Ollama-Website, wo Sie detaillierte Anweisungen für Ihr Betriebssystem finden. Laden Sie das für Ihre Plattform geeignete Paket herunter und befolgen Sie die schrittweisen Anleitungen, um alles einzurichten. Es ist wichtig sicherzustellen, dass Ihre Umgebung die erforderlichen Voraussetzungen erfüllt, um etwaige Probleme während der Installation zu vermeiden.

Der Prozess ist benutzerfreundlich gestaltet, aber für diejenigen, die sich in einem Durcheinander befinden, sind die Ollama-Community und die Dokumentation von unschätzbarem Wert. Egal, ob Sie ein erfahrener Entwickler oder ein digitaler Künstler wie ich sind, der in die Welt der fortschrittlichen Bildanalyse und -erstellung eintaucht: Ollama Vision eröffnet eine Welt, in der nur Ihre Vorstellungskraft die Grenzen setzt.

offiziellen Ollama-Dokumentation

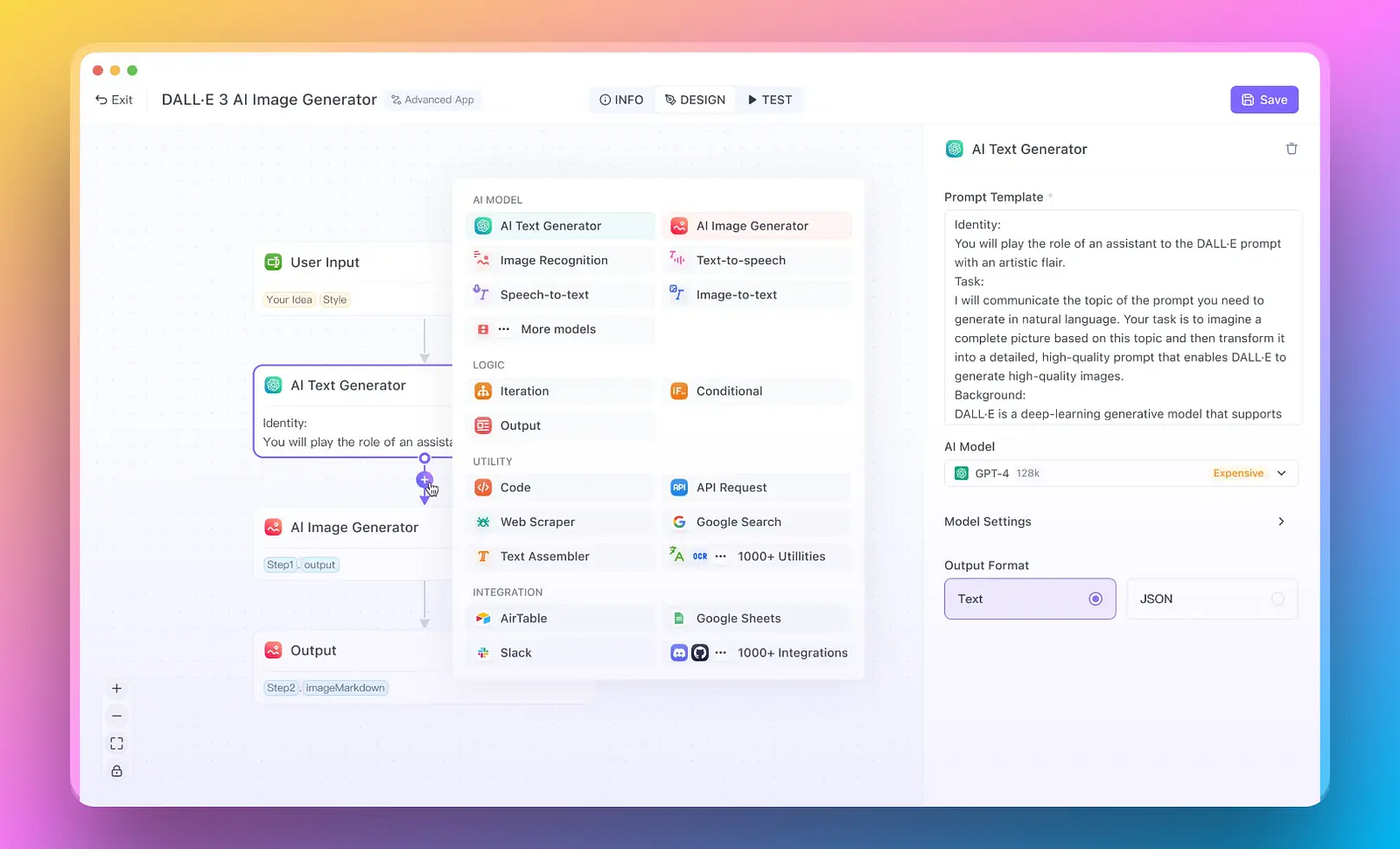

Aber was ist, wenn Sie nur schnell KI-Apps erstellen müssen? Und keine Zeit mit dem Aufwand verschwenden möchten?

Hier ist es: Anakin AI ist der beste No-Code-KI-App-Builder auf dem Markt. Erstellen Sie beliebige KI-Agenten mit Multi-Modell-Unterstützung für Ihre eigenen Daten und Workflows!

Erste Schritte mit LLaVA-Modellen in Ollama Vision

Die Reise mit LLaVA-Modellen beginnt mit dem Verständnis der Bandbreite ihrer Fähigkeiten und wie man ihre Leistungsfähigkeit nutzt. Ollama Visions LLaVA (Large Language-and-Vision Assistant) -Modelle stehen an vorderster Front dieses Abenteuers und bieten eine Reihe von Parametern, die verschiedene Anforderungen und Rechenfähigkeiten erfüllen.

Parametergrößen und Initialisierung

Die Nutzung der LLaVA-Modelle ist vergleichbar mit der Wahl des richtigen Objektivs für Ihre Kamera. Die Parametergröße beeinflusst maßgeblich die Leistung und die Qualität der Ausgabe des Modells. Die Modelle gibt es in drei verschiedenen Größen:

- 7B-Parameter: Diese Version ist die zugänglichste und wurde für diejenigen entwickelt, die Effizienz und Geschwindigkeit benötigen, ohne die tiefsten Analysen zu erfordern. Sie ist ein ausgezeichneter Ausgangspunkt für allgemeine Zwecke.

- 13B-Parameter: Der 13B-Modell bietet eine ausgewogene Mischung aus Leistung und Detailtiefe. Es ist für eine detailliertere Bildanalyse und komplexe Texterkennungsaufgaben geeignet.

- 34B-Parameter: Das 34B-Modell ist das Höchste der Gefühle in Bezug auf Präzision und Detailtreue. Es wurde für diejenigen entwickelt, die den höchsten Detailgrad und die größte analytische Kapazität benötigen.

Die Aktivierung dieser Modelle erfolgt über den einfachen Befehl ollama run. Um beispielsweise das 13B-Modell zu aktivieren, geben Sie einfach Folgendes ein:

ollama run llava:13b

Dieser Befehl ermöglicht Ihnen den Zugang zur Welt der fortgeschrittenen Bildanalyse und bereitet den Boden für die Vielzahl von Aufgaben, die Sie mit LLaVA-Modellen bewältigen können.

Fähigkeiten des Modells

Die LLaVA-Modelle sind nicht nur aufgrund ihrer Größe bedeutsam, sondern auch aufgrund der Möglichkeiten, die sie eröffnen. Mit diesen Modellen können Sie komplexe visuelle und textuelle Landschaften erkunden und Details und Erkenntnisse enthüllen, die zuvor unerreichbar waren.

Objekterkennung: Stellen Sie sich vor, Sie könnten ein Bild betrachten und sofort verschiedene darin enthaltene Objekte identifizieren und klassifizieren. LLaVA-Modelle sind hervorragend darin, Objekte in Bildern zu erkennen, von banalen bis hin zu obskuren. Sie sind unverzichtbare Werkzeuge für Aufgaben wie Inhaltsmoderation oder Datenannotation in maschinellem Lernen.

Texterkennung: Die Fähigkeit, Text in Bildern zu erkennen und zu interpretieren, eröffnet eine neue Dimension der Interaktion mit digitalem Inhalt. Egal, ob es darum geht, Text von Straßenschildern in einer belebten Stadtlandschaft zu extrahieren oder handgeschriebene Notizen in einem Künstlerjournal zu entziffern, LLaVA-Modelle stehen bereit, die Lücke zwischen dem Visuellen und dem Textlichen zu überbrücken.

Jede dieser Fähigkeiten verbessert nicht nur unsere Interaktion mit digitalem Inhalt, sondern ebnet auch den Weg für innovative Anwendungen in verschiedenen Bereichen. Von der Unterstützung von Forschern bei der Datenanalyse bis hin zur Hilfe von Künstlern bei der Integration von narrativen Schichten in ihre Werke - das Potenzial ist grenzenlos.

Wenn Sie sich auf diese Reise mit LLaVA-Modellen begeben, denken Sie daran, dass jeder von Ihnen ausgeführte Befehl und jedes von Ihnen analysierte Bild zu einer größeren Erzählung der Erforschung und Entdeckung beiträgt, angetrieben von den fortschrittlichen Fähigkeiten von Ollama Vision.

Verwendung von Ollama Vision

Die Nutzung von Ollama Vision und die Nutzung der Fähigkeiten von LLaVA-Modellen können die Art und Weise, wie Sie mit Bildern interagieren und sie analysieren, verändern. Egal, ob Sie Entwickler, Datenwissenschaftler oder Künstler sind: Die Integration dieser Modelle in Ihren Workflow kann Ihre Projekte erheblich verbessern. Im Folgenden finden Sie eine schrittweise Anleitung zur Verwendung von LLaVA-Modellen über die Befehlszeilenschnittstelle (CLI), ein vielseitiges und leistungsstarkes Werkzeug in Ihrem Arsenal.

Verwendung der Befehlszeilenschnittstelle

Die Befehlszeile bietet eine direkte und effiziente Möglichkeit, mit LLaVA-Modellen zu interagieren. Sie ist ideal für Skripting- und Automatisierungsaufgaben. Hier erfahren Sie, wie Sie damit Bilder analysieren und Beschreibungen generieren können:

Öffnen Sie Ihr Terminal oder Ihre Befehlszeilenschnittstelle: Stellen Sie sicher, dass Sie Ollama auf Ihrem System installiert haben. Wenn Sie es noch nicht installiert haben, gehen Sie zurück zum Installationsabschnitt.

Navigieren Sie zu Ihrem Projektverzeichnis: Verwenden Sie den Befehl cd, um Ihr aktuelles Verzeichnis zu ändern, um zum Speicherort Ihres Zielbilds zu gelangen oder um den Speicherort der Ausgabe zu speichern.

Führen Sie den Ollama-Befehl aus: Verwenden Sie die folgende Syntax, um ein Bild zu analysieren und eine Beschreibung zu erstellen:

ollama run llava:<Modellgröße> "beschreibe dieses Bild: ./Pfad/zu/ihrem/Bild.jpg"

- Ersetzen Sie

<Modellgröße>durch die gewünschte LLaVA-Modellparametergröße (z. B.7b,13boder34b). - Passen Sie

./Pfad/zu/ihrem/Bild.jpgan den relativen oder absoluten Pfad Ihrer Bilddatei an.

Beispielsweise würde Ihr Befehl so aussehen, um ein Bild namens Kunst.jpg mit dem 13B-Modell zu beschreiben:

ollama run llava:13b "Beschreiben Sie dieses Bild: ./Kunst.jpg"

- Betrachten Sie die Ergebnisse: Nach Ausführung des Befehls verarbeitet das Modell das Bild und gibt eine Beschreibung aus. Diese Beschreibung wird direkt in Ihrem Terminal angezeigt und bietet Einblicke in den Inhalt und Kontext des Bildes.

- Experimentieren Sie mit verschiedenen Befehlen: Über einfache Beschreibungen hinaus können Sie mit verschiedenen Anfragen experimentieren, um andere Aspekte des Bildes zu erkunden, wie z. B. nach der Stimmung zu fragen, bestimmte Elemente zu identifizieren oder sogar kreative Interpretationen zu generieren.

Tipps für eine effektive CLI-Nutzung

- Batch-Verarbeitung: Wenn Sie mehrere Bilder analysieren müssen, sollten Sie erwägen, die Befehle in einer Batch-Datei oder einem Shell-Skript zu skripten. Dieser Ansatz ermöglicht es Ihnen, die Analyse einer großen Anzahl von Bildern effizient zu automatisieren.

- Individuelle Anfragen: Passen Sie Ihre Anfragen an, um die spezifischen Informationen zu erhalten, die Sie aus dem Bild suchen. Die LLaVA-Modelle sind vielseitig einsetzbar und können eine Vielzahl von Abfragen bearbeiten.

- Ausgabe verarbeiten: Für fortgeschrittene Anwendungsfälle möchten Sie möglicherweise die Ausgabe in eine Datei oder ein anderes Programm zur weiteren Verarbeitung umleiten. Sie können dies mit Standard-CLI-Ausgabeumleitungs-Techniken tun.

Indem Sie diesen Schritten und Tipps folgen, können Sie die Leistung von Ollama Vision und LLaVA-Modellen direkt von Ihrer Befehlszeile aus nutzen und eine Vielzahl von Möglichkeiten für die Bildanalyse und -interpretation eröffnen. Egal, ob Sie Forschung betreiben, Anwendungen entwickeln oder Kunstwerke erstellen, diese Werkzeuge bieten eine neue Dimension der Interaktion mit digitalen Bildern.

b. Python-BeispielcodeDie Verwendung von Python zur Interaktion mit Ollama Visions LLaVA-Modellen beinhaltet die Nutzung der ollama.chat-Funktion. Diese leistungsstarke Funktion ermöglicht es Ihnen, ein Bild zur Analyse zu senden und aussagekräftige Beschreibungen abzurufen. Hier ist ein Beispielskript in Python, das zeigt, wie Sie dies erreichen können:

import ollama

# Initialisieren des Ollama-Clients

ollama_client = ollama.OllamaClient()

# Definieren Sie den Pfad zu Ihrem Bild

bildpfad = './Pfad/zu/Ihrem/Bild.jpg'

# Bereiten Sie die Nachricht vor, die an das LLaVA-Modell gesendet werden soll

nachricht = {

'rolle': 'benutzer',

'inhalt': 'Beschreibe dieses Bild:',

'bilder': [bildpfad]

}

# Verwenden Sie die ollama.chat-Funktion, um das Bild zu senden und die Beschreibung abzurufen

antwort = ollama_client.chat(

modell="llava:13b", # Geben Sie die gewünschte Größe des LLaVA-Modells an

nachrichten=[nachricht]

)

# Drucken Sie die Beschreibung des Modells des Bildes

print(antwort['nachrichten'][-1]['inhalt'])

In diesem Skript:

- Ersetzen Sie

./Pfad/zu/Ihrem/Bild.jpgdurch den tatsächlichen Pfad zu Ihrer Bilddatei. - Passen Sie

llava:13ban die spezifische Größe des LLaVA-Modells an, das Sie verwenden möchten (7b, 13b oder 34b).

c. JavaScript-BeispielcodeÄhnliche Funktionalitäten in JavaScript zu erreichen, erfordert die Handhabung von asynchronen Operationen mit await. Das folgende Snippet zeigt, wie Sie die ollama.chat-Methode in einer JavaScript-Umgebung verwenden, um ein Bild zu analysieren und eine Beschreibung zu erhalten:

import ollama from 'ollama';

async function bildBeschreiben(bildPfad) {

// Initialisieren des Ollama-Clients

const ollamaClient = new ollama.OllamaClient();

// Bereiten Sie die Nachricht vor, die an das LLaVA-Modell gesendet werden soll

const nachricht = {

rolle: 'benutzer',

inhalt: 'Beschreibe dieses Bild:',

bilder: [bildPfad]

};

// Verwenden Sie die ollama.chat-Funktion, um das Bild zu senden und die Beschreibung abzurufen

const antwort = await ollamaClient.chat({

modell: "llava:13b", // Geben Sie die gewünschte Größe des LLaVA-Modells an

nachrichten: [nachricht]

});

// Protokollieren Sie die Beschreibung des Modells des Bildes

console.log(antwort.nachrichten[antwort.nachrichten.length - 1].inhalt);

}

// Ersetzen Sie './Pfad/zu/Ihrem/Bild.jpg' durch den Pfad zu Ihrer Bilddatei

bildBeschreiben('./Pfad/zu/Ihrem/Bild.jpg');

In diesem JavaScript-Beispiel:

- Ersetzen Sie

./Pfad/zu/Ihrem/Bild.jpgdurch den tatsächlichen Pfad zu Ihrer Bilddatei. - Ändern Sie

llava:13b, um die gewünschte Größe des LLaVA-Modells auszuwählen, das Sie verwenden möchten (7b, 13b oder 34b).

Diese Beispiele in Python und JavaScript zeigen, wie einfach es ist, LLaVA-Modelle in Ihre Projekte zu integrieren und fortgeschrittene Bildanalysefunktionen mit minimalem Code zu ermöglichen. Ob Sie eine Webanwendung entwickeln, Forschung betreiben oder digitale Kunst erstellen, diese Beispiele dienen als Grundlage für die Erkundung des großen Potenzials von Ollama Vision.

Fortgeschrittene Nutzung und Beispiele für LLaVA-Modelle in Ollama Vision

Wenn Sie über grundlegende Bildbeschreibungen mit den LLaVA-Modellen von Ollama Vision hinausgehen, öffnen Sie eine Welt fortgeschrittener Funktionen wie Objekterkennung und Texterkennung in Bildern. Diese Funktionalitäten sind für eine Vielzahl von Anwendungen unverzichtbar, von der Entwicklung interaktiver KI-gesteuerter Tools bis hin zur Durchführung detaillierter visueller Forschung.

ObjekterkennungDie Objekterkennung beinhaltet die Identifizierung und Klassifizierung einzelner Elemente innerhalb eines Bildes. Dies kann von der Erkennung alltäglicher Objekte wie Möbeln und Fahrzeugen bis hin zu spezialisierten Elementen wie Tierarten oder technischen Komponenten reichen.

Beispielbefehl:

ollama run llava:13b "identifiziere und klassifiziere Objekte in diesem Bild: ./Stadtbild.jpg"

Erwartete Ausgabe:

Das Modell könnte eine detaillierte Liste identifizierter Objekte zurückgeben, wie "Verkehrslichter, Fußgängerüberwegsschilder, Autos, Fahrräder und Bäume", zusammen mit möglichen Klassifizierungen oder Merkmalen wie "Limousine, SUV, Laubbaum".

TexterkennungDie Texterkennung, oder optische Zeichenerkennung (OCR), ermöglicht es dem Modell, Text in Bildern zu erkennen und zu interpretieren. Dies kann besonders nützlich sein, um schriftliche Dokumente zu digitalisieren, Informationen aus Beschilderungen in Bildern zu extrahieren oder grafische Inhalte mit Text zu analysieren.

Beispielbefehl:

ollama run llava:34b "extrahiere und interpretiere Text aus diesem Bild: ./handgeschriebene_notizen.jpg"

Erwartete Ausgabe:

Das Modell könnte den transkribierten Text ausgeben, möglicherweise mit Angabe seines Vertrauensniveaus oder Hervorhebung unsicherer Bereiche. Bei handgeschriebenen Notizen könnte es auch Kontext oder Interpretation basierend auf dem umgebenden Inhalt bereitstellen.

Bereitstellung von Bildern für ModelleDie LLaVA-Modelle können Bilder in verschiedenen Formaten verarbeiten, um die Flexibilität in verschiedenen Entwicklungsumgebungen zu gewährleisten.

CLI: In der Befehlszeilenschnittstelle werden Bilder normalerweise über Dateipfade direkt im Befehl bereitgestellt, wie in den obigen Beispielen gezeigt. Diese Methode ist einfach und effektiv für Skripte und Batch-Verarbeitung.

Python und JavaScript: In Programmierumgebungen wie Python und JavaScript können Bilder als base64-kodierte Zeichenfolgen bereitgestellt werden. Dieser Ansatz ist besonders nützlich, wenn es um Bilder aus dem Web oder aus der Anwendung generierte Bilder geht.

Python-Beispiel:

import base64

# Funktion zum Codieren der Bilddatei in base64

def bild_in_base64_kodieren(bildpfad):

with open(bildpfad, "rb") as bilddatei:

return base64.b64encode(bilddatei.read()).decode("utf-8")

# Pfad zum Bild

bildpfad = "./meinBild.jpg"

# Codieren des Bildes in base64

bild_base64 = bild_in_base64_kodieren(bildpfad)

# Verwenden Sie die base64-kodierte Zeichenfolge in Ihrer Anfrage an das Modell

JavaScript-Beispiel:

import fs from 'fs';

// Funktion zum Lesen und Codieren der Bilddatei in base64

function bildInBase64Kodieren(bildPfad) {

const bild = fs.readFileSync(bildPfad);

return bild.toString('base64');

}

// Pfad zum Bild

const bildPfad = './meinBild.jpg';

// Codieren des Bildes in base64

const bildBase64 = bildInBase64Kodieren(bildPfad);

// Verwenden Sie die base64-kodierte Zeichenfolge in Ihrer Anfrage an das Modell

Diese Beispiele zeigen, wie Bilder in base64-kodierte Zeichenfolgen umgewandelt und in Python- und JavaScript-Umgebungen verwendet werden können. Durch die Bereitstellung von Bildern in diesem Format können Sie die Integration von Ollama Vision in Ihre Anwendungen und Workflows nahtlos gestalten.

Fazit

Die Möglichkeiten von Ollama Vision und seinen LLaVA-Modellen sind faszinierend und vielfältig. Von der grundlegenden Bildbeschreibung bis hin zur fortgeschrittenen Objekterkennung und Textextraktion bieten diese Modelle einen reichen Satz von Funktionen, die eine breite Palette von Anwendungen bedienen. Egal, ob Sie ein Entwickler sind, der innovative KI-Anwendungen erstellt, oder ein Künstler, der neue Wege sucht, um mit digitalen Medien zu experimentieren, Ollama Vision ist eine Plattform, die Ihre kreativen und technologischen Ambitionen unterstützt.

Durch die nahtlose Integration von LLaVA-Modellen in Ihre Projekte können Sie die Leistungsfähigkeit der modernsten KI-Technologien nutzen und Ihre Visionen in die Realität umsetzen. Seien Sie bereit, die Grenzen dessen zu überschreiten, was möglich ist, und tauchen Sie ein in die Welt von Ollama Vision.