In der Welt der Datenwissenschaft sind Sprachmodelle die neue Grenze. Diese informationsverarbeitenden Giganten können Aufgaben ausführen, die früher als einzigartig menschlich angesehen wurden. Vom Zusammenfassen langer Artikel, dem Generieren von texten, die menschenähnlich sind, dem Übersetzen von Sprachen bis hin zum Beantworten komplexer Fragen stoßen große Sprachmodelle (LLMs) an die Grenzen dessen, was Maschinen tun können. Der Umgang mit diesen gigantischen Modellen erfordert jedoch oft umfangreiche Rechenressourcen, die für viele Einzelpersonen und kleine Teams unerreichbar sind.

Das ist, wo Google Colab ins Spiel kommt.

Stellen Sie sich vor, Sie sind ein Datenwissenschaftler, der an seinem nächsten großen Projekt arbeitet. Sie haben ein leistungsstarkes LLM zur Hand, das Ihre Arbeit revolutionieren könnte. Aber es gibt nur ein Problem - Ihre lokale Maschine hat nicht die Leistung, um das Modell zu verarbeiten. Sie stehen vor zwei Optionen: entweder in teure Hardware-Upgrades investieren oder leistungsstarke Cloud-Computing-Dienste mieten, was beide teuer sein kann.

Oder Sie nutzen Google Colab.

Google Colab ist eine cloud-basierte Plattform, mit der Sie über Ihren Browser Python-Code schreiben und ausführen können, ohne dass eine Konfiguration erforderlich ist. Und das Beste daran? Es ist völlig kostenlos. Google Colab ermöglicht den Zugang zu leistungsstarken Rechenressourcen für alle, ohne hohe Kosten zu verursachen.

Aber es wird noch besser. Google Colab bietet auch Folgendes:

- Kostenlose GPU: Google Colab bietet kostenlose GPU-Unterstützung, wodurch Berechnungen drastisch beschleunigt werden und das Ausführen großer Modelle möglich wird.

- Einfacher Zugriff: Es ist in Google Drive integriert, sodass Sie Ihre Arbeit einfach speichern und teilen können.

- Benutzerfreundliche Oberfläche: All das wird in einer einfachen und intuitiven Oberfläche präsentiert, die die Verwendung zum Kinderspiel macht.

Hört sich verlockend an, oder? Aber Sie fragen sich vielleicht, "Kann ich wirklich große Sprachmodelle auf Google Colab ausführen?" Finden wir es heraus.

Kann ich LLMs auf Google Colab ausführen?

Auf jeden Fall! Die kostenlose Version von Google Colab bietet Zugriff auf eine Tesla K80-GPU mit 12 GB RAM. Obwohl dies möglicherweise nicht ausreicht, um die größten Sprachmodelle zu trainieren, ist es mehr als ausreichend, um sie zu feinabstimmen oder Vorhersagen auszuführen.

Tatsächlich gibt es zahlreiche Anbieter großer Sprachmodelle, die vortrainierte Modelle anbieten, die Sie nutzen können:

- OpenAI: OpenAI's GPT-3 ist ein modernes Sprachmodell, das beeindruckend menschenähnlichen Text generieren kann.

- Azure OpenAI: Die Azure-Plattform von Microsoft bietet GPT-3 als Cloud-Dienst an.

- Hugging Face: Hugging Face bietet eine Reihe von vortrainierten Modellen, die für verschiedene NLP-Aufgaben verwendet werden können.

- Fireworks AI: Fireworks AI ist auf große Sprachmodelle für Unternehmensanwendungen spezialisiert.

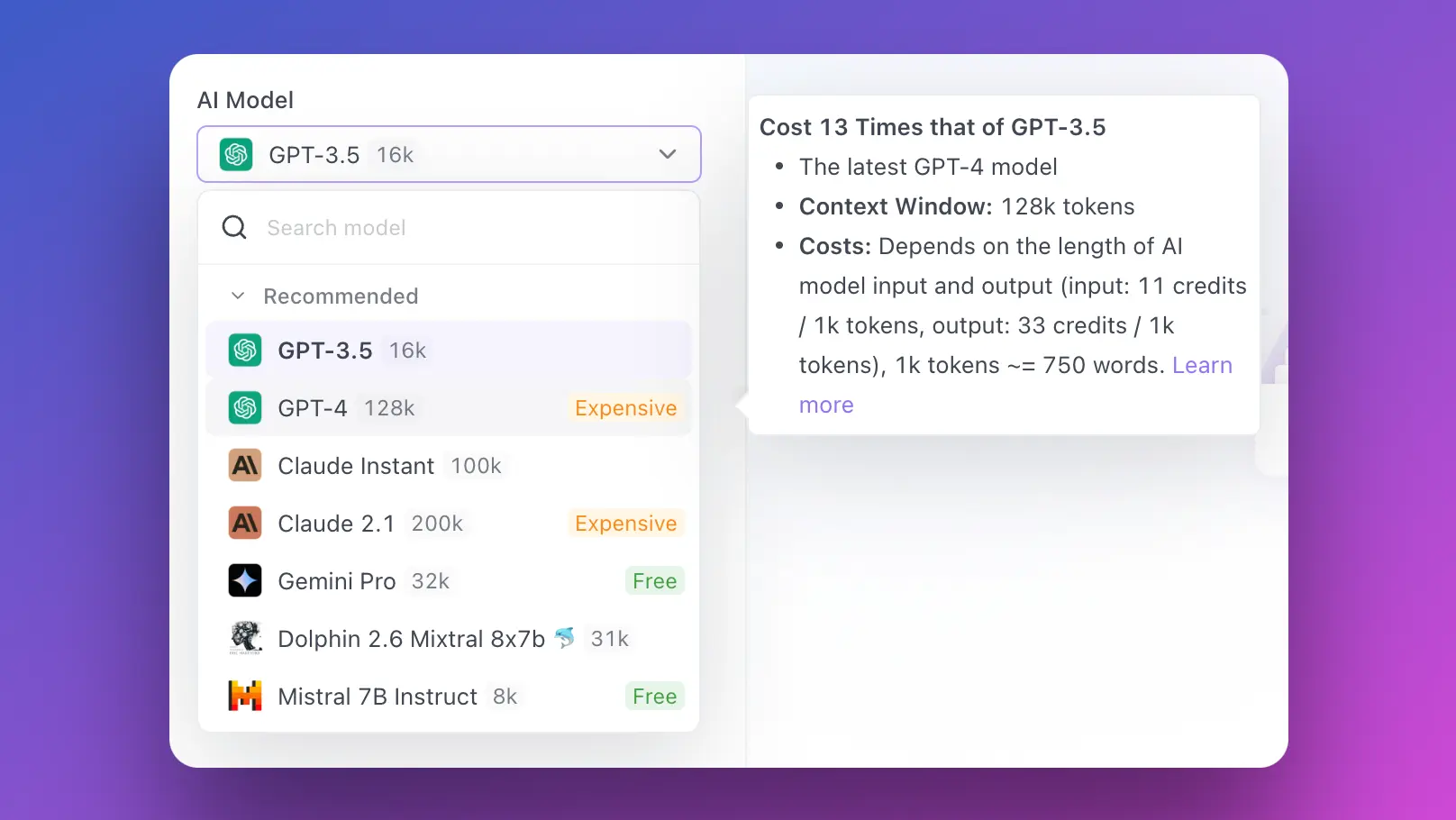

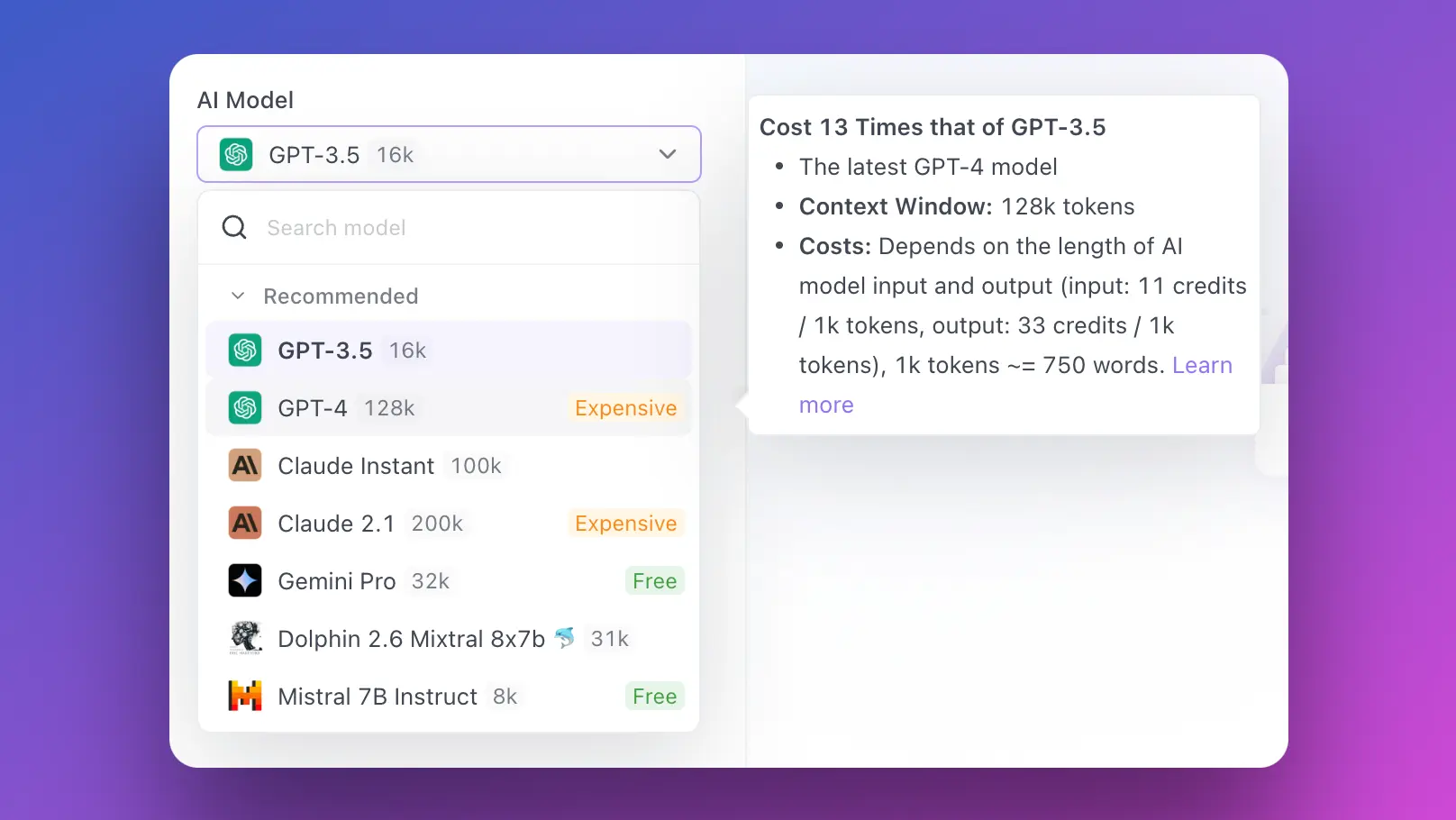

- Anakin AI: Hier können Sie KI-Apps mit JEDEM KI-Modell erstellen, und zwar mit einem App-Builder ohne Code!

Aber wie richten Sie Ihre Umgebung in Google Colab ein, um diese Modelle auszuführen? Tauchen wir ein.

Einrichten Ihrer Umgebung in Google Colab

Die Einrichtung von Google Colab für die Ausführung von LLMs ist ein einfaches Unterfangen. Hier ist eine Schritt-für-Schritt-Anleitung, um Sie zu starten:

Erstellen Sie ein neues Notebook: Gehen Sie zur Website von Google Colab und starten Sie ein neues Python 3-Notebook.

Erforderliche Bibliotheken installieren: Installieren Sie die erforderlichen Python-Bibliotheken. Wenn Sie beispielsweise ein Hugging Face-Modell verwenden, müssen Sie die transformers-Bibliothek installieren. Führen Sie den folgenden Code in einer neuen Zelle aus:

!pip install transformers

Wählen Sie die richtige Laufzeitumgebung: Klicken Sie auf Laufzeit > Laufzeittyp ändern und wählen Sie GPU für die Hardwarebeschleunigung.

Voila! Ihr grundlegendes Setup ist abgeschlossen. Aber es gibt noch mehr, wenn Sie Ihren Workflow optimieren möchten.

Google Drive in Google Colab einbinden

Die Integration von Google Drive ist eine der Hauptfunktionen, die Google Colab zu einem leistungsstarken Werkzeug für Datenwissenschaftler machen. Sie ermöglicht Ihnen den direkten Zugriff auf Ihre Daten von Ihrem Google Drive aus und das Speichern Ihrer Arbeit zurück in Ihrem Laufwerk.

So binden Sie Ihr Google Drive in Google Colab ein:

Führen Sie den folgenden Code in einer neuen Zelle aus:

from google.colab import drive

drive.mount('/content/drive')

Folgen Sie dem angezeigten Link, wählen Sie Ihr Google-Konto aus und kopieren Sie den Autorisierungscode.

Fügen Sie den Code in Colab ein und Sie sind fertig! Sie können nun direkt von Ihrem Colab-Notebook aus durch Ihre Google Drive-Dateien navigieren.

Als Nächstes sehen wir uns an, wie Sie die GPU-Beschleunigung in Google Colab aktivieren können.

Aktivieren der GPU-Beschleunigung in Google Colab

Wenn Sie ernsthaft mit LLMs arbeiten möchten, ist die Aktivierung der GPU-Beschleunigung ein absolutes Muss. Glücklicherweise macht Ihnen Google Colab das einfach und kostenlos:

Wechseln Sie zu Laufzeit > Laufzeittyp ändern.

Klicken Sie neben Hardwarebeschleuniger auf die Dropdown-Liste und wählen Sie GPU aus.

Und das ist es! Sie haben gerade Ihr Colab-Notebook mit GPU-Beschleunigung aufgerüstet.

Ausführen großer Sprachmodelle in Google Colab

Ihre Google Colab-Umgebung sollte jetzt eingerichtet und einsatzbereit sein. Es ist Zeit, die Schwergewichte ins Spiel zu bringen.

Werfen wir einen Blick auf einen Beispielcode, der die Transformers-Bibliothek von Hugging Face verwendet:

from transformers import pipeline

# Initialisieren des Modells

nlp_model = pipeline('sentiment-analysis')

# Verwendung des Modells für die Vorhersage

result = nlp_model('We are learning to use Google Colab for running large language models.')

print(result)

Mit diesem grundlegenden Code-Snippet können Sie einen Satz an das Modell übergeben und im Gegenzug eine Sentiment-Analyse-Vorhersage erhalten. Je nach Bedarf können Sie 'sentiment-analysis' durch andere Aufgaben wie 'text-generation', 'translation_en_to_fr' usw. ersetzen.

Fazit

In einer Ära von Big Data und immer größer werdenden Sprachmodellen sind die verfügbaren Rechenressourcen für Datenwissenschaftler entscheidend. Google Colab gleicht die Chancen aus, indem es erhebliche Rechenleistung einschließlich kostenloser GPU-Beschleunigung in einer cloud-basierten, benutzerfreundlichen Umgebung bietet.

Ob Sie nun eine Einzelperson sind, die an einem persönlichen Projekt arbeitet, ein Datenwissenschaftler in einem kleinen Team oder sogar ein Student, der sich zum ersten Mal mit LLMs beschäftigt - das Ausführen von LLMs in Google Colab bietet eine zugängliche, kostengünstige und zuverlässige Lösung.

Also, worauf warten Sie noch? Richten Sie Ihre Google Colab-Umgebung noch heute ein und machen Sie sich auf den Weg, die Leistung großer Sprachmodelle kostenlos zu nutzen!

Und vergessen Sie nicht, Anakin AI auszuprobieren, wo es Ihnen Stunden an Codierungsarbeit erspart, indem es alle Ihre Lieblings-KI-Modelle an einem Ort zusammenführt und mit einem No-Code-KI-App-Builder ausgestattet ist!