Vậy thì, bạn không thể bỏ lỡ Anakin AI!

Anakin AI là một nền tảng tất cả trong một cho mọi quy trình tự động hóa của bạn, tạo ứng dụng AI mạnh mẽ với một Trình tạo Ứng dụng Không mã dễ sử dụng, với Deepseek, o3-mini-high của OpenAI, Claude 3.7 Sonnet, FLUX, Minimax Video, Hunyuan...

Xây dựng Ứng dụng AI mơ ước của bạn trong vòng vài phút, không phải vài tuần với Anakin AI!

Giới thiệu

Trí tuệ nhân tạo đã có những bước tiến đáng kể trong những năm gần đây, với các mô hình ngôn ngữ mạnh mẽ trở nên ngày càng dễ tiếp cận với người dùng hàng ngày. DeepSeek R1, được phát triển bởi DeepSeek, đại diện cho một trong những mô hình AI mã nguồn mở tiên tiến nhất hiện có. Điều khiến DeepSeek R1 đặc biệt ấn tượng là khả năng của nó trong việc bắt kịp các mô hình thương mại như o1 của OpenAI và Claude 3.5 Sonnet trong các nhiệm vụ toán học, lập trình và suy luận trong khi có sẵn để sử dụng cục bộ.

Trong hướng dẫn toàn diện này, chúng tôi sẽ hướng dẫn bạn qua quá trình tải xuống và chạy DeepSeek R1 cục bộ trên PC của bạn. Chúng tôi cũng sẽ giới thiệu bạn với Anakin AI, một nền tảng mạnh mẽ cung cấp một cách thay thế để tận dụng khả năng của DeepSeek mà không cần chi phí kỹ thuật của việc cài đặt cục bộ.

Hiểu về DeepSeek R1

DeepSeek R1 là dòng mô hình suy luận thế hệ đầu tiên của DeepSeek, có sẵn trong nhiều kích thước khác nhau để phù hợp với các cấu hình phần cứng khác nhau. Từ các phiên bản nhỏ hơn đến mô hình đầy đủ 671B tham số, DeepSeek R1 cung cấp tính linh hoạt cho người dùng với các nguồn lực tính toán khác nhau. Mô hình này được cấp phép theo MIT, cho phép cả ứng dụng cá nhân và thương mại.

DeepSeek R1 xuất sắc ở:

- Tạo văn bản: Tạo bài viết, tóm tắt và nội dung sáng tạo

- Hỗ trợ mã: Tạo và gỡ lỗi mã qua nhiều ngôn ngữ lập trình

- Hiểu ngôn ngữ tự nhiên: Giải thích đầu vào của con người với sự hiểu biết tinh tế

- Trả lời câu hỏi: Cung cấp phản hồi dựa trên ngữ cảnh, thông tin

Yêu cầu hệ thống

Trước khi cố gắng chạy DeepSeek R1 cục bộ, hãy đảm bảo hệ thống của bạn đáp ứng được các yêu cầu cần thiết. Điều này thay đổi tùy thuộc vào phiên bản của mô hình mà bạn dự định sử dụng:

- Đối với các mô hình nhỏ hơn (1.5B, 7B, hoặc 8B): CPU hiện đại với ít nhất 16GB RAM và tốt nhất là GPU với 8GB+ VRAM

- Đối với các mô hình trung bình (14B, 32B): GPU mạnh mẽ với 16-24GB VRAM

- Đối với các mô hình lớn hơn (70B): GPU cao cấp với 40GB+ VRAM hoặc nhiều GPU

- Đối với mô hình đầy đủ 671B: Phần cứng doanh nghiệp với nhiều GPU mạnh mẽ

DeepSeek R1 hỗ trợ các hệ điều hành macOS, Linux và Windows.

Sử dụng Ollama để chạy DeepSeek R1 cục bộ

Ollama đã nổi lên như một trong những giải pháp phổ biến nhất để chạy các mô hình ngôn ngữ lớn cục bộ. Nó đơn giản hóa quy trình bằng cách xử lý việc tải xuống mô hình, khởi tạo và tối ưu hóa cho phần cứng cụ thể của bạn.

Bước 1: Cài đặt Ollama

Đầu tiên, hãy cài đặt Ollama trên hệ thống của bạn:

Đối với macOS:

brew install ollama

Nếu Homebrew chưa được cài đặt, hãy truy cập brew.sh và làm theo hướng dẫn cài đặt.

Đối với Windows: Tải xuống Ollama từ trang web chính thức và làm theo hướng dẫn cài đặt.

Đối với Linux:

curl -fsSL <https://ollama.com/install.sh> | sh

Sau khi cài đặt, hãy xác minh rằng Ollama đang chạy đúng:

ollama --version

Bước 2: Tải xuống DeepSeek R1

Ngay khi Ollama được cài đặt, bạn có thể tải xuống DeepSeek R1 bằng một câu lệnh đơn giản. Chọn kích thước mô hình phù hợp dựa trên khả năng phần cứng của bạn:

ollama pull deepseek-r1

Đối với một phiên bản nhỏ hơn, hãy chỉ định kích thước mô hình:

ollama pull deepseek-r1:1.5b

Các kích thước khác có sẵn bao gồm:

deepseek-r1:7b(tải xuống 4.7GB)deepseek-r1:8b(tải xuống 4.9GB)deepseek-r1:14b(tải xuống 9.0GB)deepseek-r1:32b(tải xuống 20GB)deepseek-r1:70b(tải xuống 43GB)deepseek-r1:671b(tải xuống 404GB - yêu cầu phần cứng doanh nghiệp)

Bước 3: Bắt đầu mô hình

Sau khi tải xuống mô hình, hãy khởi động máy chủ Ollama:

ollama serve

Rồi, chạy DeepSeek R1:

ollama run deepseek-r1

Hoặc, để sử dụng một phiên bản cụ thể:

ollama run deepseek-r1:1.5b

Bước 4: Tương tác với DeepSeek R1

Với mô hình đang chạy, bạn có thể tương tác với nó trong terminal. Chỉ cần gõ các truy vấn của bạn và nhấn Enter:

>>> Lớp trong C++ là gì?

DeepSeek R1 sẽ xử lý truy vấn của bạn và cung cấp một phản hồi chi tiết dựa trên đào tạo của nó.

Sử dụng Nâng cao với Ollama

Ollama cung cấp một số tính năng nâng cao để nâng cao trải nghiệm của bạn với DeepSeek R1:

Tham số Tùy chỉnh

Bạn có thể tùy chỉnh hành vi của mô hình với các tham số như nhiệt độ và top-p:

ollama run deepseek-r1:8b --temperature 0.7 --top-p 0.9

Sử dụng API

Ollama cung cấp một API HTTP cho phép bạn tích hợp mô hình vào các ứng dụng của mình:

curl -X POST <http://localhost:11434/api/generate> -d '{

"model": "deepseek-r1:8b",

"prompt": "Giải thích về tính toán lượng tử bằng ngôn ngữ đơn giản",

"stream": false

}'

Mẹo Tối ưu hóa Hiệu suất

Để có hiệu suất tốt nhất khi chạy DeepSeek R1 cục bộ:

- Tăng tốc GPU: Đảm bảo trình điều khiển GPU của bạn được cập nhật và cấu hình đúng.

- Quản lý bộ nhớ: Đóng các ứng dụng không cần thiết khi chạy các mô hình lớn hơn.

- Định lượng: Thử nghiệm với các cài đặt định lượng khác nhau cho nhu cầu cụ thể của bạn.

- Quản lý Cửa sổ Ngữ cảnh: Hãy lưu ý đến độ dài của các yêu cầu và phản hồi để tối ưu hóa việc sử dụng bộ nhớ.

- Làm mát: Đảm bảo hệ thống của bạn có hệ thống làm mát thích hợp để ngăn chặn quá nhiệt.

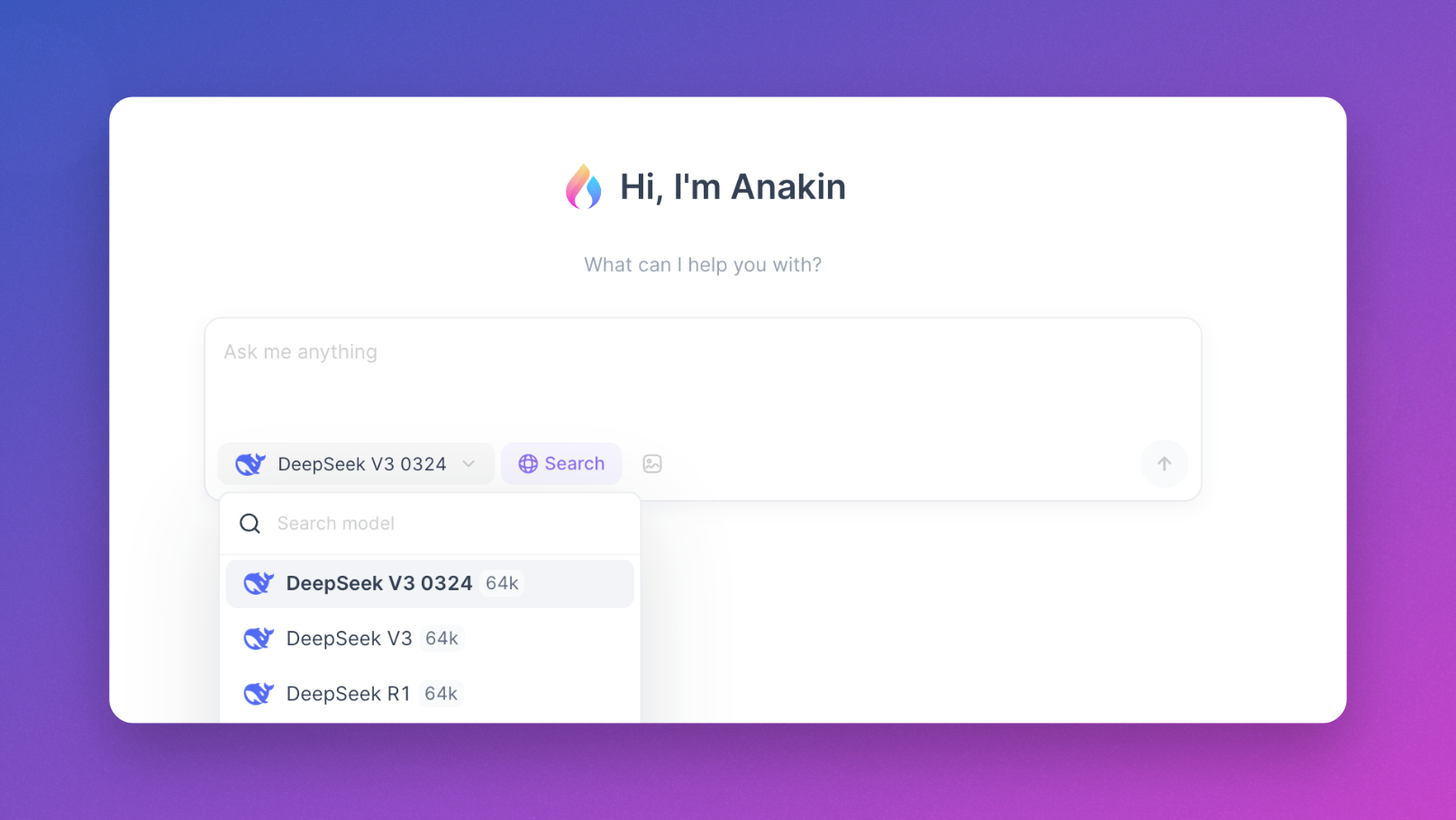

Sử dụng Anakin AI: Một Lựa Chọn Mạnh Mẽ

Khi chạy các mô hình cục bộ với Ollama cung cấp kiểm soát và riêng tư tuyệt vời, nhưng nó yêu cầu tài nguyên tính toán đáng kể và thiết lập kỹ thuật. Đối với nhiều người dùng, đặc biệt là những người không tiếp cận được phần cứng mạnh mẽ, Anakin AI cung cấp một lựa chọn tuyệt vời cho phép bạn trải nghiệm DeepSeek và các mô hình mạnh mẽ khác mà không cần sự phức tạp của các cài đặt cục bộ.

Anakin AI là gì?

Anakin AI là một nền tảng tất cả trong một cung cấp:

- Truy cập Ngay lập tức: Sử dụng DeepSeek và các mô hình mạnh mẽ khác trực tiếp trong trình duyệt của bạn mà không cần tải xuống hoặc cài đặt bất cứ thứ gì.

- Giao diện Thân thiện với Người dùng: Một giao diện trò chuyện sạch sẽ, trực quan giúp việc tương tác với các mô hình AI trở nên đơn giản.

- Hỗ trợ Nhiều Mô hình: Truy cập không chỉ vào DeepSeek mà còn Llama, Mistral, Dolphin, và nhiều LLM mã nguồn mở khác.

- Không hạn chế phần cứng: Thực hiện các cuộc trò chuyện với các mô hình lớn ngay cả trên phần cứng khiêm tốn như laptop hoặc máy tính bảng.

- Cuộc trò chuyện Liên tục: Tất cả các cuộc trò chuyện của bạn được lưu và tổ chức để dễ dàng tham khảo.

- Tính năng Nâng cao: Tạo ứng dụng AI, tích hợp với dữ liệu của bạn và xây dựng quy trình làm việc tùy chỉnh.

Bắt đầu với Anakin AI

Để bắt đầu sử dụng DeepSeek R1 qua Anakin AI:

- Truy cập https://anakin.ai

- Tạo một tài khoản hoặc đăng nhập

- Chọn DeepSeek từ các mô hình có sẵn

- Ngồi nói chuyện ngay lập tức mà không cần thiết lập nào cả

Lợi ích của việc Sử dụng Anakin AI

Anakin AI đặc biệt có lợi cho:

- Các người dùng có tài nguyên phần cứng hạn chế

- Những người cần truy cập nhanh mà không cần thiết lập kỹ thuật

- Các nhóm muốn hợp tác sử dụng cùng một cơ sở hạ tầng AI

- Các nhà phát triển thử nghiệm các mô hình khác nhau trước khi triển khai cục bộ

Anakin AI cũng cung cấp khả năng tạo quy trình làm việc AI mà không cần kiến thức lập trình, điều này làm cho nó trở thành một lựa chọn dễ tiếp cận cho người dùng ở mọi nền tảng kỹ thuật.

Xây dựng Ứng dụng với DeepSeek R1

Vượt ra ngoài các tương tác trò chuyện đơn giản, DeepSeek R1 có thể tích hợp vào nhiều ứng dụng khác nhau:

Tạo và Phân tích Mã

DeepSeek R1 xuất sắc trong các nhiệm vụ liên quan đến mã, làm cho nó có giá trị cho các nhà phát triển muốn:

- Tạo các đoạn mã dựa trên yêu cầu

- Gỡ lỗi mã hiện có

- Tối ưu hóa các thuật toán

- Dịch giữa các ngôn ngữ lập trình

Nghiên cứu và Phân tích

Khả năng suy luận của mô hình làm cho nó phù hợp với:

- Tóm tắt các tài liệu học thuật

- Phân tích xu hướng dữ liệu

- Tạo giả thuyết

- Tạo các báo cáo có cấu trúc

Tạo nội dung

Sử dụng DeepSeek R1 cho:

- Viết và chỉnh sửa bài báo

- Tạo nội dung tiếp thị

- Tạo nội dung sáng tạo

- Dịch giữa các ngôn ngữ

Kết luận

Chạy DeepSeek R1 cục bộ với Ollama đại diện cho một bước tiến lớn trong việc dân chủ hóa quyền truy cập vào các mô hình AI mạnh mẽ. Cách tiếp cận này mang đến cho bạn toàn quyền kiểm soát dữ liệu và tương tác của bạn trong khi tận dụng các khả năng xử lý ngôn ngữ tiên tiến nhất.

Tùy thuộc vào các nguồn lực phần cứng và mức độ thoải mái về kỹ thuật của bạn, bạn có thể chọn giữa việc chạy mô hình cục bộ thông qua Ollama hoặc truy cập nó thông qua các nền tảng thân thiện với người dùng như Anakin AI. Cả hai cách tiếp cận đều có những ưu điểm riêng:

- Cài đặt cục bộ với Ollama: Tối đa hóa quyền riêng tư, kiểm soát, và tùy chỉnh, nhưng yêu cầu phần cứng phù hợp

- Anakin AI: Truy cập ngay lập tức, không hạn chế phần cứng, giao diện thân thiện với người dùng và khả năng quy trình làm việc bổ sung

Dù bạn là một nhà phát triển xây dựng thế hệ tiếp theo của các ứng dụng AI, một nhà nghiên cứu khám phá khả năng của các mô hình ngôn ngữ lớn, hay đơn giản là một người đam mê muốn trải nghiệm AI tiên tiến, DeepSeek R1 cung cấp các khả năng ấn tượng mà trước đây chỉ có thể có được qua các dịch vụ riêng tư.

Bằng cách làm theo hướng dẫn này, bạn giờ đây đã có kiến thức để chạy DeepSeek R1 cục bộ bằng Ollama hoặc truy cập nó thông qua Anakin AI, tùy thuộc vào nhu cầu và nguồn lực cụ thể của bạn. Sức mạnh của AI tiên tiến giờ đây đã ở trong tầm tay của bạn!