Então, você não pode perder Anakin AI!

Anakin AI é uma plataforma tudo-em-um para toda a sua automação de fluxo de trabalho, crie aplicativos de IA poderosos com um construtor de aplicativos sem código fácil de usar, com Deepseek, o o3-mini-high da OpenAI, Claude 3.7 Sonnet, FLUX, Minimax Video, Hunyuan...

Construa seu aplicativo dos sonhos de IA em minutos, não em semanas, com Anakin AI!

Introdução

A inteligência artificial fez avanços notáveis nos últimos anos, com poderosos modelos de linguagem se tornando cada vez mais acessíveis para usuários comuns. O DeepSeek R1, desenvolvido pela DeepSeek, representa um dos modelos de IA de código aberto mais avançados disponíveis hoje. O que torna o DeepSeek R1 particularmente impressionante é sua capacidade de igualar modelos comerciais como o o1 da OpenAI e o Claude 3.5 Sonnet em tarefas de matemática, codificação e raciocínio, enquanto está disponível para uso local.

Neste tutorial abrangente, vamos guiá-lo pelo processo de download e execução do DeepSeek R1 localmente em seu PC. Também vamos apresentar o Anakin AI, uma plataforma poderosa que oferece uma alternativa para aproveitar as capacidades do DeepSeek sem a sobrecarga técnica da instalação local.

Entendendo o DeepSeek R1

O DeepSeek R1 é a série de modelos de raciocínio de primeira geração da DeepSeek, disponível em vários tamanhos para atender a diferentes configurações de hardware. Desde versões menores destiladas até o modelo completo de 671B parâmetros, o DeepSeek R1 oferece flexibilidade para usuários com diferentes recursos computacionais. O modelo é licenciado sob MIT, permitindo aplicações pessoais e comerciais.

O DeepSeek R1 se destaca em:

- Geração de texto: Criar artigos, resumos e conteúdo criativo

- Assistência de código: Gerar e depurar código em várias linguagens de programação

- Compreensão de linguagem natural: Interpretar entradas humanas com compreensão sutil

- Pergunta-resposta: Fornecer respostas informativas com base em contexto

Requisitos do Sistema

Antes de tentar executar o DeepSeek R1 localmente, certifique-se de que seu sistema atenda aos requisitos necessários. Estes variam dependendo da versão do modelo que você planeja usar:

- Para modelos menores (1.5B, 7B ou 8B): CPU moderna com pelo menos 16GB de RAM e, preferably um GPU com 8GB+ VRAM

- Para modelos médios (14B, 32B): GPU potente com 16-24GB de VRAM

- Para modelos maiores (70B): GPUs de alto nível com 40GB+ de VRAM ou várias GPUs

- Para o modelo completo de 671B: Hardware de nível empresarial com várias GPUs potentes

O DeepSeek R1 suporta sistemas operacionais macOS, Linux e Windows.

Usando Ollama para Executar o DeepSeek R1 Localmente

Ollama emergiu como uma das soluções mais populares para executar grandes modelos de linguagem localmente. Ele simplifica o processo lidando com downloads de modelo, inicialização e otimização para seu hardware específico.

Etapa 1: Instalar Ollama

Primeiro, vamos instalar o Ollama em seu sistema:

Para macOS:

brew install ollama

Se o Homebrew não estiver instalado, visite brew.sh e siga as instruções de configuração.

Para Windows: Baixe o Ollama do site oficial e siga o assistente de instalação.

Para Linux:

curl -fsSL <https://ollama.com/install.sh> | sh

Após a instalação, verifique se o Ollama está funcionando corretamente:

ollama --version

Etapa 2: Baixar DeepSeek R1

Depois que o Ollama estiver instalado, você pode baixar o DeepSeek R1 com um simples comando. Escolha o tamanho do modelo adequado com base nas capacidades do seu hardware:

ollama pull deepseek-r1

Para uma versão menor, especifique o tamanho do modelo:

ollama pull deepseek-r1:1.5b

Outros tamanhos disponíveis incluem:

deepseek-r1:7b(download de 4.7GB)deepseek-r1:8b(download de 4.9GB)deepseek-r1:14b(download de 9.0GB)deepseek-r1:32b(download de 20GB)deepseek-r1:70b(download de 43GB)deepseek-r1:671b(download de 404GB - requer hardware empresarial)

Etapa 3: Iniciar o Modelo

Depois de baixar o modelo, inicie o servidor Ollama:

ollama serve

Então, execute o DeepSeek R1:

ollama run deepseek-r1

Ou, para usar uma versão específica:

ollama run deepseek-r1:1.5b

Etapa 4: Interagindo com o DeepSeek R1

Com o modelo em execução, você pode agora interagir com ele no terminal. Basta digitar suas consultas e pressionar Enter:

>>> O que é uma classe em C++?

O DeepSeek R1 processará sua consulta e fornecerá uma resposta detalhada com base em seu treinamento.

Uso Avançado com Ollama

Ollama oferece vários recursos avançados para aprimorar sua experiência com o DeepSeek R1:

Parâmetros Personalizados

Você pode personalizar o comportamento do modelo com parâmetros como temperatura e top-p:

ollama run deepseek-r1:8b --temperature 0.7 --top-p 0.9

Usando a API

Ollama fornece uma API HTTP que permite integrar o modelo em suas aplicações:

curl -X POST <http://localhost:11434/api/generate> -d '{

"model": "deepseek-r1:8b",

"prompt": "Explique computação quântica em termos simples",

"stream": false

}'

Dicas de Otimização de Desempenho

Para obter o melhor desempenho ao executar o DeepSeek R1 localmente:

- Aceleração por GPU: Certifique-se de que os drivers da sua GPU estão atualizados e configurados corretamente.

- Gerenciamento de Memória: Feche aplicações desnecessárias ao executar modelos maiores.

- Quantização: Experimente diferentes configurações de quantização para suas necessidades específicas.

- Gerenciamento da Janela de Contexto: Esteja atento aos seus prompts e aos comprimentos das respostas para otimizar o uso da memória.

- Refrigeração: Garantir que seu sistema tenha refrigeração adequada para evitar limitações térmicas.

Usando o Anakin AI: Uma Alternativa Poderosa

Embora executar modelos localmente com Ollama ofereça grande controle e privacidade, requer recursos computacionais significativos e configuração técnica. Para muitos usuários, especialmente aqueles sem acesso a hardware potente, o Anakin AI fornece uma excelente alternativa que permite experimentar o DeepSeek e outros modelos poderosos sem a complexidade das instalações locais.

O que é o Anakin AI?

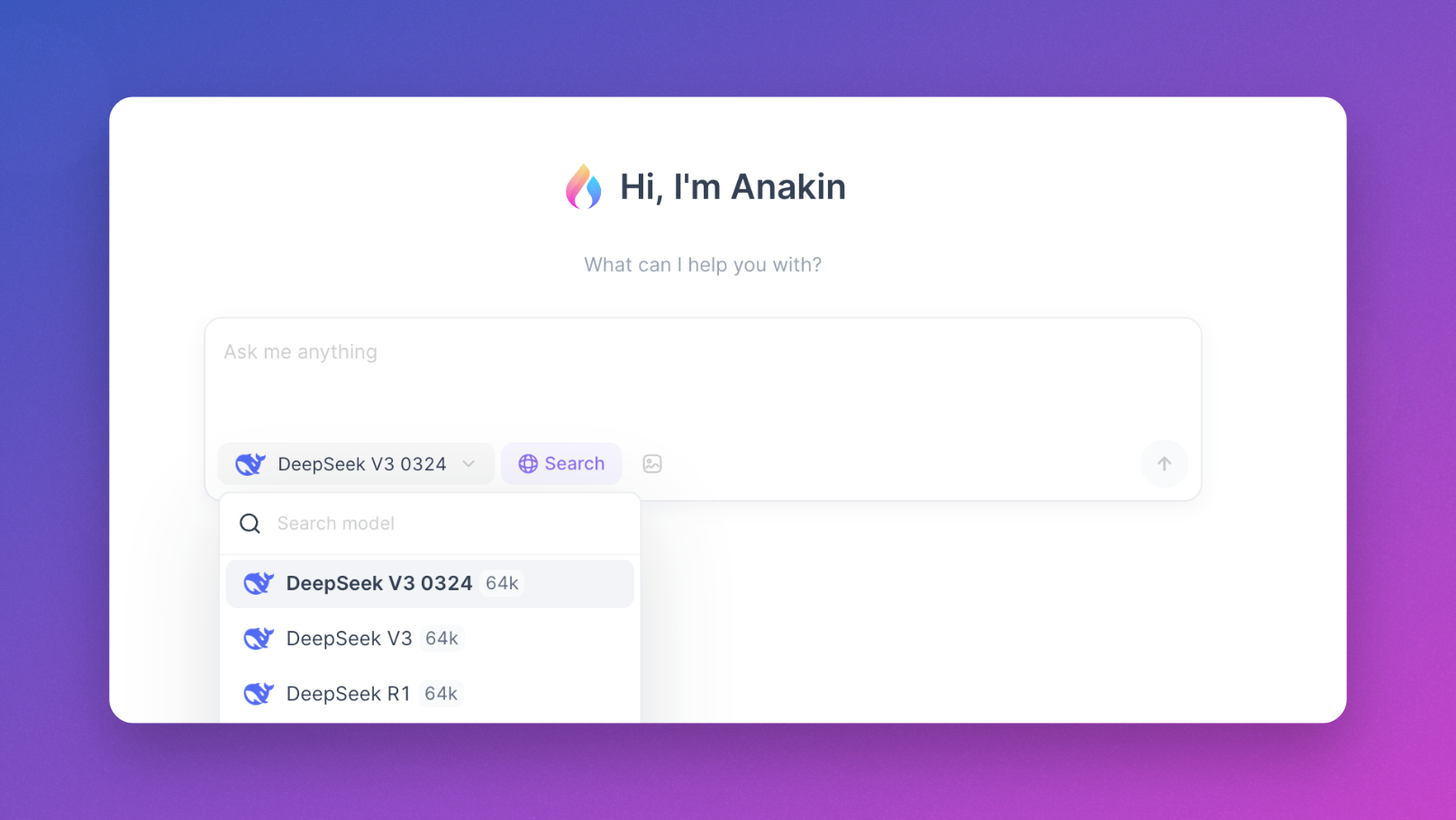

O Anakin AI é uma plataforma tudo-em-um que oferece:

- Acesso Imediato: Use DeepSeek e outros modelos poderosos diretamente em seu navegador, sem baixar ou instalar nada.

- Interface Amigável: Uma interface de chat limpa e intuitiva que torna a interação com modelos de IA simples.

- Suporte a Múltiplos Modelos: Acesso não apenas ao DeepSeek, mas também ao Llama, Mistral, Dolphin e muitos outros LLMs de código aberto.

- Sem Restrições de Hardware: Conduza conversas com grandes modelos mesmo em hardware modesto como laptops ou tablets.

- Conversas Persistentes: Todos os seus chats são salvos e organizados para fácil referência.

- Recursos Avançados: Crie aplicações de IA, integre-se aos seus dados e construa fluxos de trabalho personalizados.

Começando com o Anakin AI

Para começar a usar o DeepSeek R1 através do Anakin AI:

- Visite https://anakin.ai

- Crie uma conta ou faça o login

- Selecione DeepSeek entre os modelos disponíveis

- Comece a conversar imediatamente, sem nenhuma configuração

Benefícios de Usar o Anakin AI

O Anakin AI é particularmente benéfico para:

- Usuários com recursos limitados de hardware

- Aqueles que precisam de acesso rápido sem configuração técnica

- Equipes que desejam colaborar usando a mesma infraestrutura de IA

- Desenvolvedores testando diferentes modelos antes de implantar localmente

O Anakin AI também oferece a capacidade de criar fluxos de trabalho de IA sem conhecimento de codificação, tornando-o uma opção acessível para usuários de todos os níveis técnicos.

Construindo Aplicações com DeepSeek R1

Além de simples interações de chat, o DeepSeek R1 pode ser integrado em várias aplicações:

Geração e Análise de Código

O DeepSeek R1 se destaca em tarefas relacionadas a código, tornando-o valioso para desenvolvedores que desejam:

- Gerar trechos de código com base em requisitos

- Depurar código existente

- Otimizar algoritmos

- Traduzir entre linguagens de programação

Pesquisa e Análise

As capacidades de raciocínio do modelo o tornam bem adequado para:

- Resumir artigos acadêmicos

- Analisar tendências de dados

- Gerar hipóteses

- Criar relatórios estruturados

Criação de Conteúdo

Use o DeepSeek R1 para:

- Escrever e editar artigos

- Criar textos de marketing

- Gerar conteúdo criativo

- Traduzir entre idiomas

Conclusão

Executar o DeepSeek R1 localmente com o Ollama representa um passo significativo em democratizar o acesso a poderosos modelos de IA. Esta abordagem oferece controle total sobre seus dados e interações ao mesmo tempo em que aproveita as capacidades de processamento de linguagem de última geração.

Dependendo dos seus recursos de hardware e nível de conforto técnico, você pode escolher entre executar o modelo localmente através do Ollama ou acessá-lo através de plataformas amigáveis ao usuário como o Anakin AI. Ambas as abordagens têm seus méritos:

- Instalação local com Ollama: Máxima privacidade, controle e personalização, mas requer hardware adequado

- Anakin AI: Acesso imediato, sem restrições de hardware, interface amigável e capacidades adicionais de fluxo de trabalho

Seja você um desenvolvedor construindo a próxima geração de aplicações impulsionadas por IA, um pesquisador explorando as capacidades de grandes modelos de linguagem ou simplesmente um entusiasta interessado em experimentar IA de ponta, o DeepSeek R1 oferece capacidades impressionantes que anteriormente estavam disponíveis apenas através de serviços proprietários.

Seguindo este guia, agora você tem o conhecimento para executar o DeepSeek R1 localmente usando o Ollama ou acessá-lo através do Anakin AI, dependendo de suas necessidades e recursos específicos. O poder da IA avançada agora está na ponta dos seus dedos!