Allora, non puoi perderti Anakin AI!

Anakin AI è una piattaforma tutto-in-uno per tutta l'automazione del tuo workflow, crea potenti app AI con un builder di app No Code facile da usare, con Deepseek, o3-mini-high di OpenAI, Claude 3.7 Sonnet, FLUX, Minimax Video, Hunyuan...

Crea la tua app AI dei sogni in pochi minuti, non settimane con Anakin AI!

Introduzione

L'intelligenza artificiale ha fatto passi da gigante negli ultimi anni, con modelli di linguaggio potenti che diventano sempre più accessibili agli utenti comuni. DeepSeek R1, sviluppato da DeepSeek, rappresenta uno dei modelli AI open-source più avanzati disponibili oggi. Ciò che rende DeepSeek R1 particolarmente impressionante è la sua capacità di eguagliare modelli commerciali come o1 di OpenAI e Claude 3.5 Sonnet in compiti di matematica, codifica e ragionamento pur essendo disponibile per uso locale.

In questo tutorial completo, ti guideremo attraverso il processo di download e esecuzione di DeepSeek R1 localmente sul tuo PC. Ti presenteremo anche Anakin AI, una potente piattaforma che offre un modo alternativo per sfruttare le capacità di DeepSeek senza l'onere tecnico dell'installazione locale.

Comprendere DeepSeek R1

DeepSeek R1 è la serie di modelli di ragionamento di prima generazione di DeepSeek, disponibile in più dimensioni per adattarsi a diverse configurazioni hardware. Dalle versioni distillate più piccole al modello completo da 671B parametri, DeepSeek R1 offre flessibilità per utenti con diverse risorse computazionali. Il modello è concesso in licenza sotto MIT, consentendo applicazioni sia personali che commerciali.

DeepSeek R1 eccelle in:

- Generazione di testi: Creazione di articoli, riassunti e contenuti creativi

- Assistente di codice: Generazione e debug di codice in diversi linguaggi di programmazione

- Comprensione del linguaggio naturale: Interpretazione dell'input umano con comprensione sfumata

- Risposte a domande: Fornitura di risposte informative basate sul contesto

Requisiti di sistema

Prima di tentare di eseguire DeepSeek R1 localmente, assicurati che il tuo sistema soddisfi i requisiti necessari. Questi variano a seconda della versione del modello che intendi utilizzare:

- Per modelli più piccoli (1.5B, 7B o 8B): CPU moderna con almeno 16GB di RAM e preferibilmente una GPU con 8GB+ di VRAM

- Per modelli medi (14B, 32B): GPU potente con 16-24GB di VRAM

- Per modelli più grandi (70B): GPU di alta gamma con 40GB+ di VRAM o più GPU

- Per il modello completo da 671B: Hardware di livello enterprise con più GPU potenti

DeepSeek R1 supporta sistemi operativi macOS, Linux e Windows.

Utilizzare Ollama per eseguire DeepSeek R1 localmente

Ollama è emerso come una delle soluzioni più popolari per eseguire modelli di linguaggio grandi localmente. Semplifica il processo occupandosi dei download dei modelli, dell'inizializzazione e dell'ottimizzazione per il tuo hardware specifico.

Passo 1: Installa Ollama

Per prima cosa, installiamo Ollama sul tuo sistema:

Per macOS:

brew install ollama

Se Homebrew non è installato, visita brew.sh e segui le istruzioni di configurazione.

Per Windows: Scarica Ollama dal sito ufficiale e segui la procedura guidata di installazione.

Per Linux:

curl -fsSL <https://ollama.com/install.sh> | sh

Dopo l'installazione, verifica che Ollama stia funzionando correttamente:

ollama --version

Passo 2: Scarica DeepSeek R1

Una volta installato Ollama, puoi scaricare DeepSeek R1 con un semplice comando. Scegli la dimensione del modello appropriata in base alle capacità del tuo hardware:

ollama pull deepseek-r1

Per una versione più piccola, specifica la dimensione del modello:

ollama pull deepseek-r1:1.5b

Altre dimensioni disponibili includono:

deepseek-r1:7b(download 4.7GB)deepseek-r1:8b(download 4.9GB)deepseek-r1:14b(download 9.0GB)deepseek-r1:32b(download 20GB)deepseek-r1:70b(download 43GB)deepseek-r1:671b(download 404GB - richiede hardware enterprise)

Passo 3: Avvia il modello

Dopo aver scaricato il modello, avvia il server Ollama:

ollama serve

Poi, esegui DeepSeek R1:

ollama run deepseek-r1

Oppure, per utilizzare una versione specifica:

ollama run deepseek-r1:1.5b

Passo 4: Interagire con DeepSeek R1

Con il modello in esecuzione, puoi ora interagire con esso nel terminale. Basta digitare le tue domande e premere Invio:

>>> Cos'è una classe in C++?

DeepSeek R1 elaborerà la tua domanda e fornirà una risposta dettagliata basata sul suo addestramento.

Utilizzo avanzato con Ollama

Ollama offre diverse funzionalità avanzate per migliorare la tua esperienza con DeepSeek R1:

Parametri personalizzati

Puoi personalizzare il comportamento del modello con parametri come temperatura e top-p:

ollama run deepseek-r1:8b --temperature 0.7 --top-p 0.9

Utilizzo dell'API

Ollama fornisce un'API HTTP che ti consente di integrare il modello nelle tue applicazioni:

curl -X POST <http://localhost:11434/api/generate> -d '{

"model": "deepseek-r1:8b",

"prompt": "Spiega il calcolo quantistico in termini semplici",

"stream": false

}'

Suggerimenti per l'ottimizzazione delle prestazioni

Per ottenere le migliori prestazioni quando esegui DeepSeek R1 localmente:

- Accelerazione GPU: Assicurati che i driver della tua GPU siano aggiornati e configurati correttamente.

- Gestione della memoria: Chiudi applicazioni non necessarie quando esegui modelli più grandi.

- Quantizzazione: Sperimenta con diverse impostazioni di quantizzazione per le tue esigenze specifiche.

- Gestione della finestra di contesto: Fai attenzione alle tue domande e lunghezze delle risposte per ottimizzare l'uso della memoria.

- Raffreddamento: Assicurati che il tuo sistema abbia un raffreddamento adeguato per prevenire il throttling termico.

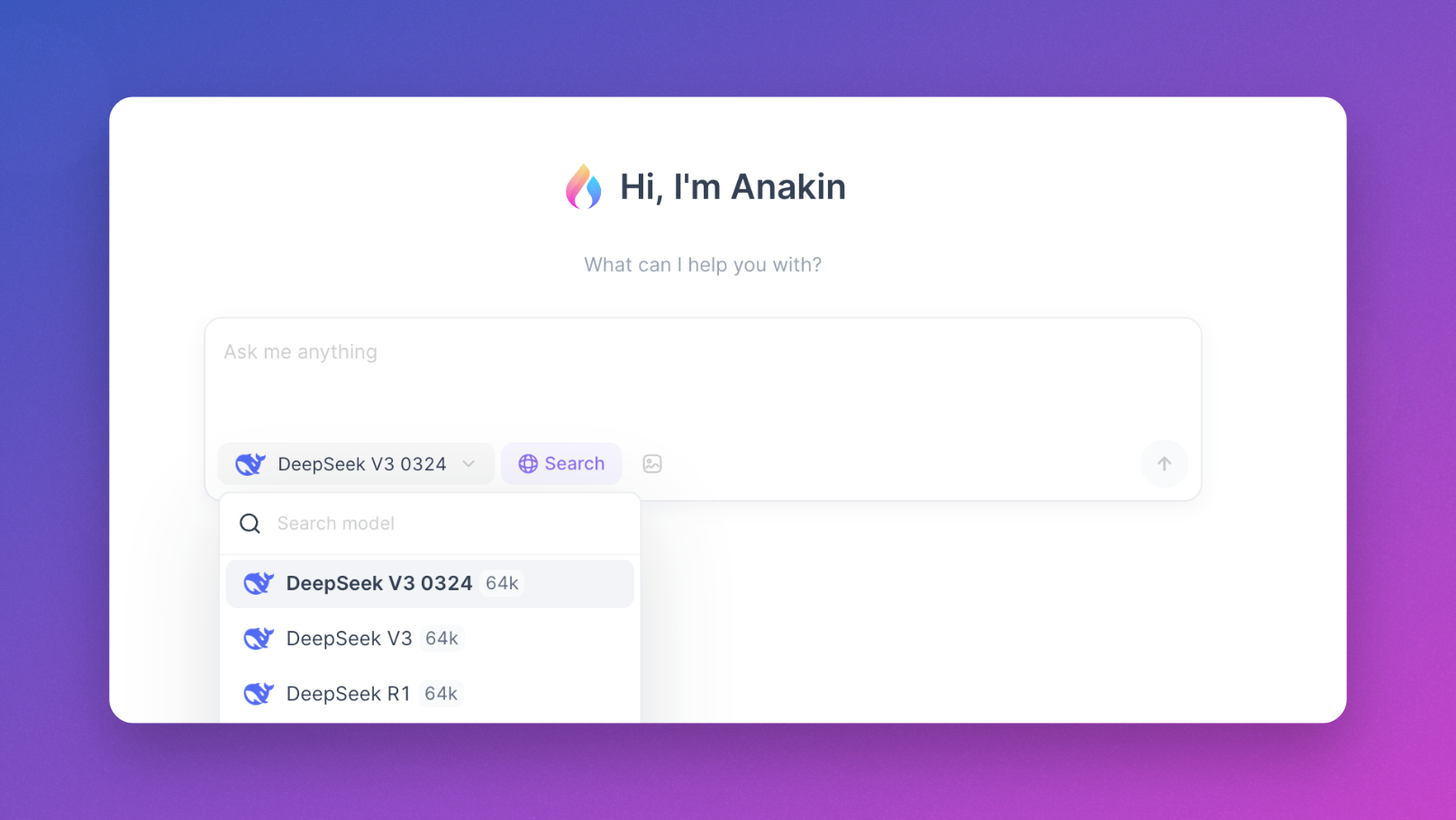

Utilizzare Anakin AI: un'ottima alternativa

Se eseguire modelli localmente con Ollama offre un grande controllo e privacy, richiede risorse computazionali significative e una configurazione tecnica. Per molti utenti, specialmente quelli senza accesso a hardware potente, Anakin AI offre un'eccellente alternativa che consente di sperimentare DeepSeek e altri modelli potenti senza la complessità delle installazioni locali.

Cos'è Anakin AI?

Anakin AI è una piattaforma tutto-in-uno che offre:

- Accesso immediato: Usa DeepSeek e altri potenti modelli direttamente nel tuo browser senza scaricare o installare nulla.

- Interfaccia user-friendly: Un'interfaccia di chat pulita e intuitiva che rende semplice interagire con i modelli AI.

- Supporto per più modelli: Accesso non solo a DeepSeek ma anche a Llama, Mistral, Dolphin e molti altri LLM open-source.

- Nessuna limitazione hardware: Esegui conversazioni con modelli grandi anche su hardware modesto come laptop o tablet.

- Conversazioni persistenti: Tutte le tue chat sono salvate e organizzate per un facile riferimento.

- Funzionalità avanzate: Crea applicazioni AI, integra i tuoi dati e costruisci flussi di lavoro personalizzati.

Iniziare con Anakin AI

Per iniziare a utilizzare DeepSeek R1 tramite Anakin AI:

- Visita https://anakin.ai

- Crea un account o accedi

- Seleziona DeepSeek dai modelli disponibili

- Inizia a chattare immediatamente senza alcuna configurazione

Vantaggi di utilizzare Anakin AI

Anakin AI è particolarmente utile per:

- Utenti con risorse hardware limitate

- Coloro che hanno bisogno di un accesso rapido senza configurazioni tecniche

- Team che vogliono collaborare utilizzando la stessa infrastruttura AI

- Sviluppatori che testano diversi modelli prima di distribuirli localmente

Anakin AI offre anche la possibilità di creare flussi di lavoro AI senza conoscenze di programmazione, rendendolo un'opzione accessibile per utenti di tutti i livelli tecnici.

Costruire applicazioni con DeepSeek R1

Oltre a semplici interazioni in chat, DeepSeek R1 può essere integrato in varie applicazioni:

Generazione e analisi del codice

DeepSeek R1 eccelle in compiti legati al codice, risultando prezioso per gli sviluppatori che vogliono:

- Generare frammenti di codice in base ai requisiti

- Debuggare codice esistente

- Ottimizzare algoritmi

- Tradurre tra linguaggi di programmazione

Ricerca e analisi

Le capacità di ragionamento del modello lo rendono adatto per:

- Riassumere articoli accademici

- Analizzare tendenze nei dati

- Generare ipotesi

- Creare rapporti strutturati

Creazione di contenuti

Utilizza DeepSeek R1 per:

- Scrivere e modificare articoli

- Creare testi di marketing

- Generare contenuti creativi

- Tradurre tra lingue

Conclusione

Eseguire DeepSeek R1 localmente con Ollama rappresenta un passo significativo nel democratizzare l'accesso a modelli AI potenti. Questo approccio ti dà il completo controllo sui tuoi dati e interazioni, sfruttando al contempo le capacità di elaborazione del linguaggio all'avanguardia.

A seconda delle tue risorse hardware e del tuo livello di confort tecnico, puoi scegliere tra eseguire il modello localmente tramite Ollama o accedervi tramite piattaforme user-friendly come Anakin AI. Entrambi gli approcci hanno i loro meriti:

- Installazione locale con Ollama: Massima privacy, controllo e personalizzazione, ma richiede hardware adeguato

- Anakin AI: Accesso immediato, nessuna limitazione hardware, interfaccia user-friendly e ulteriori capacità di flusso di lavoro

Che tu sia uno sviluppatore che costruisce la prossima generazione di applicazioni alimentate da AI, un ricercatore che esplora le capacità di modelli di linguaggio grandi, o semplicemente un appassionato interessato a vivere l'AI all'avanguardia, DeepSeek R1 offre capacità impressionanti che erano precedentemente disponibili solo attraverso servizi proprietari.

Seguendo questa guida, ora hai le conoscenze per eseguire DeepSeek R1 localmente usando Ollama o accedervi tramite Anakin AI, a seconda delle tue esigenze e risorse specifiche. Il potere dell'AI avanzata è ora a portata di mano!