In der sich rasch entwickelnden Welt der Technologie ist die Integration von Sprachmodellen in Anwendungen zu einem Eckpfeiler für Innovationen im Bereich der natürlichen Sprachverarbeitung (NLP) geworden. LangChain, eine leistungsstarke Bibliothek für Python, vereinfacht diese Integration, indem sie Tools wie CTransformers bereitstellt. CTransformers nutzen die Geschwindigkeit von C/C++-Implementierungen und behalten gleichzeitig die Flexibilität von Python bei, was es Entwicklern erleichtert, komplexe Sprachmodelle effizient bereitzustellen. Dieser Artikel geht auf die Funktionen von CTransformers im Rahmen des LangChain-Frameworks ein und bietet praktische Beispiele, Installationsanleitungen und Einblicke in die lebhafte LangChain-Community.

TL;DR: Kurzübersicht

- LangChain und CTransformers installieren: Fügen Sie diese Tools einfach Ihrer Python-Umgebung hinzu.

- Text mit CTransformers generieren: Verwenden Sie vortrainierte Modelle, um Text zu erstellen.

- Erweiterte Funktionen erkunden: Implementieren Sie Streaming für die dynamische Textgenerierung.

- Seien Sie Teil der LangChain-Community: Engagieren Sie sich mit einem Netzwerk von NLP-Enthusiasten und Experten.

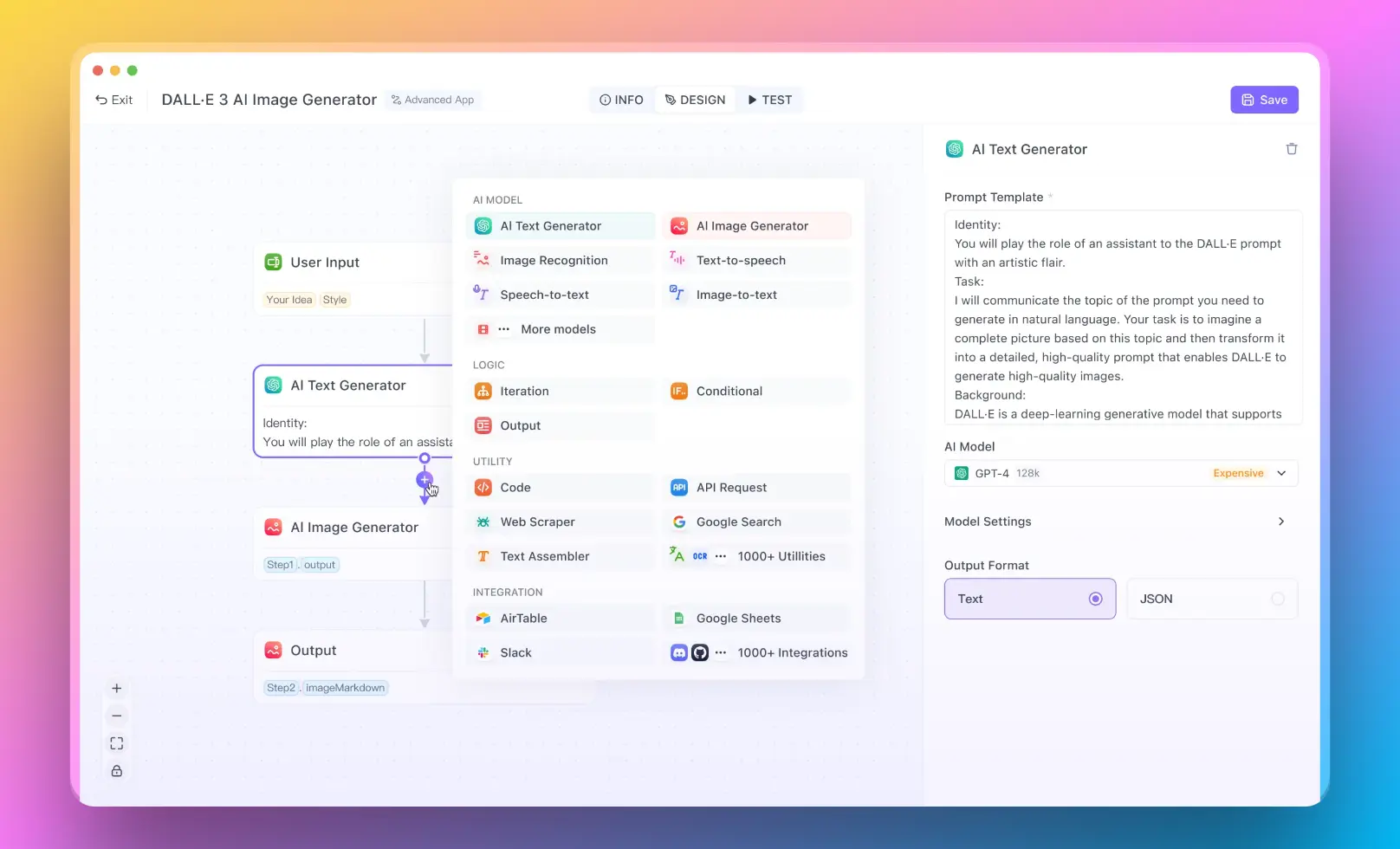

- Für Benutzer, die ein RAG-System ohne Programmierkenntnisse ausführen möchten, können Sie Anakin AI ausprobieren, wo Sie großartige KI-Apps mit einem No-Code-Builder erstellen können!

Was ist CTransformers in LangChain?

CTransformers in LangChain repräsentiert eine leistungsstarke Abstraktionsebene, die die Verwendung von Transformer-Modellen erleichtert, insbesondere solcher, die mit der GGML-Bibliothek optimiert sind, in Python. Es bietet Python-Bindungen, die eine unkomplizierte Ausführung dieser Modelle ermöglichen und eine vereinheitlichte Schnittstelle für verschiedene Modelltypen bieten. Diese Kompatibilität erstreckt sich auch auf Modelle, die im Hugging Face Hub gehostet werden, und erweitert damit den Umfang der zugänglichen Ressourcen.

Wie installiert man LangChain in Python?

Die Installation von LangChain in Python ist ein unkomplizierter Vorgang, der mit einem einzigen Befehl durchgeführt werden kann:

pip install langchain

Dieser Befehl installiert LangChain zusammen mit seinen Abhängigkeiten und bereitet die Integration von CTransformers vor und ermöglicht die Nutzung seiner umfangreichen Funktionen.

Was ist die LangChain-Community?

Die LangChain-Community ist ein lebendiges Ökosystem von Entwicklern, Forschern und Enthusiasten, die sich auf die Erforschung und Weiterentwicklung von Sprachmodellen und deren Anwendungen konzentrieren. In dieser Community teilen Mitglieder Einsichten, Tools und Ressourcen wie CTransformers, um Innovation und Zusammenarbeit zu fördern. Die Beiträge der Community zur LangChain-Bibliothek, einschließlich der Dokumentation, Beispiele und Unterstützung, spielen eine wichtige Rolle bei der Demokratisierung des Zugangs zu modernsten NLP-Technologien.

Schritte zur Verwendung von CTransformers mit LangChain

LangChain und CTransformers installieren

Bevor wir zu Beispielen übergehen, ist es wichtig, Ihre Umgebung einzurichten. So installieren Sie LangChain und CTransformers in Python:

pip install langchain

pip install ctransformers

Dieser einfache Installationsprozess stattet Sie mit den Tools aus, die Sie benötigen, um mit CTransformers innerhalb des LangChain-Frameworks zu experimentieren.

Grundlegende Verwendung von CTransformers in LangChain

Zum Einstieg schauen wir uns an, wie man ein Modell mit CTransformers in LangChain lädt und verwendet:

from langchain_community.llms import CTransformers

# Das CTransformers-Modell initialisieren

llm = CTransformers(model='marella/gpt-2-ggml')

# Text generieren

response = llm.invoke("KI wird")

print(response)

Dieser Code-Schnipsel zeigt, wie einfach es ist, ein Modell zu laden und Text zu generieren, und zeigt die nahtlose Integration zwischen CTransformers und LangChain.

Erweiterte Textgenerierung mit Streaming

Für komplexere Szenarien wie das Streaming der Textgenerierung bietet CTransformers elegante Funktionen:

from langchain.callbacks.streaming_stdout import StreamingStdOutCallbackHandler

# CTransformers mit Streaming-Funktionen konfigurieren

llm = CTransformers(

model="marella/gpt-2-ggml",

callbacks=[StreamingStdOutCallbackHandler()]

)

# Das Modell mit Streaming aufrufen

response = llm.invoke("KI wird")

Dieses Beispiel zeigt, wie man den Textgenerierungsprozess mit Streaming verbessern kann, um eine Echtzeitausgabe für dynamische Anwendungen zu ermöglichen.

Sentiment-Analyse mit CTransformers in LangChain durchführen

In diesem Szenario nehmen wir an, dass ein vortrainiertes Sentiment-Analyse-Modell im Hugging Face Hub verfügbar ist, auf das über CTransformers zugegriffen werden kann. Das Modell wird die Stimmung des Eingabetextes klassifizieren. Beachten Sie, dass wir für dieses Beispiel einen fiktiven Modellnamen "sentiment-analysis-ggml" verwenden. Sie müssen dies durch den tatsächlichen Modellnamen ersetzen, den Sie verwenden möchten.

Schritt 1: LangChain und CTransformers installieren

Stellen Sie zunächst sicher, dass LangChain und CTransformers in Ihrer Python-Umgebung installiert sind. Wenn Sie sie noch nicht installiert haben, können Sie dies durchführen, indem Sie folgenden Befehl ausführen:

pip install langchain

pip install ctransformers

Schritt 2: Erforderliche Bibliotheken importieren

Importieren Sie nun die erforderlichen Komponenten von LangChain und anderen erforderlichen Bibliotheken:

from langchain_community.llms import CTransformers

Schritt 3: Das Sentiment-Analyse-Modell initialisieren

Initialisieren Sie nun das Sentiment-Analyse-Modell mit CTransformers. Ersetzen Sie "sentiment-analysis-ggml" durch den tatsächlichen Modellnamen, den Sie verwenden:

# Sentiment-Analyse-Modell initialisieren

sentiment_model = CTransformers(model='sentiment-analysis-ggml')

Schritt 4: Sentiment-Analyse durchführen

Mit dem initialisierten Modell können Sie jetzt Sentiment-Analyse an jedem Text durchführen. Lassen Sie uns die Stimmung eines Beispielsatzes analysieren:

# Beispieltext

text = "LangChain und CTransformers machen NLP-Aufgaben unglaublich einfach und effizient."

# Sentiment-Analyse durchführen

sentiment_result = sentiment_model.invoke(text)

print(sentiment_result)

Dieser Code-Schnipsel gibt das Ergebnis der Sentiment-Analyse aus, das in der Regel die Klassifizierung (z. B. "positiv" oder "negativ") und möglicherweise eine Vertrauensscore je nach Ausgabeformat des Modells enthält.

Fazit

CTransformers in LangChain erweist sich als ein bahnbrechendes Werkzeug, das die Effizienz von C/C++ mit der Vielseitigkeit von Python im Bereich von Sprachmodellen verbindet. Durch praktische Beispiele und eine umfassende Installationsanleitung wurde in diesem Artikel der Weg für Entwickler beleuchtet, um die Leistungsfähigkeit von CTransformers in ihren Projekten zu nutzen. Die LangChain-Community bleibt ein Leuchtturm für Zusammenarbeit und Innovation und treibt die NLP-Forschung voran.

Machen Sie sich mit CTransformers in LangChain auf eine Reise und entfesseln Sie das volle Potenzial von Sprachmodellen in Ihren Anwendungen.