Einführung

Die Welt der KI entwickelt sich rasant weiter, und mit dem Aufkommen leistungsstarker Modelle wie Codestral 22B erweitern sich die Möglichkeiten für die Codegenerierung und die natürliche Sprachverarbeitung. Um diese Modelle jedoch effizient ausführen zu können, ist eine sorgfältige Berücksichtigung der Hardware-Ressourcen erforderlich, insbesondere wenn es um den GPU-Speicher (VRAM) geht.

Dann sollten Sie Anakin AI nicht verpassen!

Anakin AI ist eine All-in-One-Plattform für die Workflow-Automatisierung. Erstellen Sie leistungsstarke KI-Anwendungen mit einem benutzerfreundlichen App Builder ohne Code und nutzen Sie Llama 3, Claude, GPT-4, Uncensored LLMs, Stable Diffusion...

Erstellen Sie Ihre Traum-KI-Anwendung in Minuten, nicht Wochen, mit Anakin AI!

Kann ich Codestral 22B lokal ausführen?

In einem kürzlich durchgeführten umfassenden Laborversuch wurde die Leistung von Codestral 22B unter Verwendung einer kostengünstigen Konfiguration mit zwei Nvidia RTX 4060 Ti GPUs getestet, von denen jede mit 16 GB GDDR6-Speicher ausgestattet war. Diese Konfiguration bietet insgesamt 32 GB VRAM, was früher als ungewöhnliche Menge für Systeme der Verbraucherklasse galt. Der Test sollte wichtige Fragen über den Einfluss der Kontextgröße auf die VRAM-Nutzung, die Auswirkungen verschiedener Quantisierungsstufen (Q4, Q6 und Q8) auf die Durchsatzrate (t/s), den Stromverbrauch und mehr beantworten.

Um die Eignung von erschwinglichen High-VRAM-Builds weiter zu erforschen, ist es sinnvoll, die Speicherbandbreite verschiedener Budget-GPUs zu untersuchen. Die folgende Tabelle stellt einen Vergleich mehrerer Modelle dar:

| GPU-Modell | Architektur | Speichergröße | Speichertyp | Speicherbandbreite | Leistungsaufnahme (TDP) |

|---|---|---|---|---|---|

| Nvidia A4000 | Ampere | 16 GB GDDR6 | GDDR6 | 448 GB/s | 140 W |

| Nvidia RTX 4060 Ti 16GB | Ada Lovelace | 16 GB GDDR6 | GDDR6 | 288 GB/s | 160 W |

| Nvidia RTX 3060 | Ampere | 12 GB GDDR6 | GDDR6 | 360 GB/s | 170 W |

| Nvidia Quadro P5000 | Pascal | 16 GB GDDR5X | GDDR5X | 288 GB/s | 180 W |

| Nvidia Quadro RTX 5000 | Turing | 16 GB GDDR6 | GDDR6 | 448 GB/s | 230 W |

| Nvidia Quadro P6000 | Pascal | 24 GB GDDR5X | GDDR5X | 432 GB/s | 250 W |

| Nvidia Titan X | Pascal | 12 GB GDDR5X | GDDR5X | 480 GB/s | 250 W |

| Nvidia Tesla P40 | Pascal | 24 GB GDDR5X | GDDR5X | 346 GB/s | 250 W |

Obwohl der RTX 3090 mit seinem beeindruckenden 24GB VRAM und der doppelten Speicherbandbreite der schnellsten aufgeführten Karte zu den Spitzenreitern gehört, könnte der hohe Preis für viele Benutzer abschreckend sein. Die Daten legen nahe, dass preisgünstigere Optionen wie der RTX 4060 Ti mit 16GB VRAM eine überzeugende Balance zwischen Leistung und Kosteneffizienz bieten könnten.

In den folgenden Abschnitten werden wir die wichtigsten Ergebnisse des Labortests untersuchen, die Auswirkungen auf realweltliche Anwendungen diskutieren und das Potenzial erschwinglicher High-VRAM-GPU-Builds untersuchen.

Codestral 22B lokal mit Ollama ausführen

Ollama ist eine Open-Source-Plattform, die es Ihnen ermöglicht, verschiedene KI-Modelle auszuführen und mit ihnen zu interagieren. Dazu gehört auch Codestral 22B, ein modernes KI-Modell für Codieraufgaben, das von Mistral AI entwickelt wurde. Dieses leistungsstarke Modell wurde auf einem massiven Datensatz von Code und natürlicher Sprache trainiert.

Schritt 1: Installieren Sie Ollama

Bevor Sie Codestral 22B ausführen können, müssen Sie Ollama auf Ihrem System installieren. Ollama ist für verschiedene Betriebssysteme wie Windows, macOS und Linux verfügbar. Die Installationsanweisungen und Download-Links finden Sie auf der offiziellen Ollama-Website (https://ollama.com).

Zum Beispiel können Sie Ollama unter Linux mit einem einzigen Befehl installieren:

curl -fsSL https://ollama.com/install.sh | sh

Nachdem Sie das für Ihr System passende Paket heruntergeladen haben, folgen Sie den bereitgestellten Installationsanweisungen. Dieser Vorgang beinhaltet in der Regel das Entpacken des Pakets und das Ausführen des Installationsskripts.

Schritt 2: Laden Sie das Codestral 22B-Modell herunter

Nach der Installation von Ollama müssen Sie das Codestral 22B-Modell herunterladen. Dieses Modell ist auf der Hugging Face-Plattform, einem beliebten Repository für KI-Modelle und Datensätze, verfügbar. Sie können das Codestral 22B-Modell über den folgenden Link finden: https://huggingface.co/mistralai/Codestral-22B-v0.1

Um das Modell herunterzuladen, können Sie die Befehlszeilenschnittstelle (CLI) von Ollama verwenden. Öffnen Sie Ihr Terminal oder die Eingabeaufforderung und wechseln Sie zum Verzeichnis, in dem Sie das Modell speichern möchten. Führen Sie dann den folgenden Befehl aus:

ollama pull codestral

Dieser Befehl lädt die erforderlichen Dateien aus dem Hugging Face-Repository herunter und erstellt eine lokale Kopie des Codestral 22B-Modells.

Schritt 3: Führen Sie das Codestral 22B-Modell aus

Nachdem das Modell heruntergeladen wurde, können Sie es mit Hilfe der Ollama CLI ausführen. Wechseln Sie in Ihrem Terminal oder in der Eingabeaufforderung zum Verzeichnis, in dem Sie Ollama installiert haben, und führen Sie den folgenden Befehl aus:

ollama run codestral

Dieser Befehl startet das Codestral 22B-Modell und öffnet eine interaktive Sitzung, in der Sie Eingaben bereitstellen und Antworten erhalten können.

Beispielhafte Verwendung:

Mensch: Schreiben Sie eine Python-Funktion zur Berechnung der Fakultät einer gegebenen Zahl.

Assistent: Hier ist eine Python-Funktion zur Berechnung der Fakultät einer gegebenen Zahl:

def factorial(n):

"""

Berechnet die Fakultät einer gegebenen Zahl.

Args:

n (int): Die Zahl, für die die Fakultät berechnet werden soll.

Returns:

int: Die Fakultät der gegebenen Zahl.

"""

if n == 0:

return 1

else:

return n * factorial(n-1)

# Beispielhafte Verwendung

print(factorial(5)) # Ausgabe: 120

In diesem Beispiel generiert das Codestral 22B-Modell eine Python-Funktion, die die Fakultät einer gegebenen Zahl unter Verwendung von Rekursion berechnet. Die Funktion enthält einen Docstring, der ihren Zweck, ihre Argumente und ihren Rückgabewert erklärt.

Erstellen einer KI-App mit Anakin AI

Anakin AI ist eine No-Code-Plattform, mit der Sie KI-Anwendungen erstellen können, ohne eine einzige Zeile Code zu schreiben. Sie bietet eine benutzerfreundliche Oberfläche und eine Vielzahl von vorab erstellten KI-Modellen, was sie für Benutzer mit unterschiedlichem technischen Fachwissen zugänglich macht.

Schritt 1: Melden Sie sich bei Anakin AI an

Um mit Anakin AI zu beginnen, müssen Sie ein Konto auf ihrer Website erstellen (https://www.anakin.ai). Der Anmeldevorgang ist unkompliziert und erfordert die Angabe grundlegender Informationen wie Ihren Namen, Ihre E-Mail-Adresse und ein Passwort.

Schritt 2: Erkunden Sie vorgefertigte KI-Apps

Nachdem Sie sich angemeldet und eingeloggt haben, gelangen Sie zu Ihrer persönlichen Arbeitsumgebung. Anakin AI bietet eine Vielzahl von vorab erstellten KI-Apps, die Sie erkunden und sofort nutzen können. Diese Apps decken verschiedene Bereiche ab, darunter Content-Erstellung, Bildverarbeitung, Datenanalyse und mehr.

Um vorgefertigte Apps zu finden, klicken Sie auf die Schaltfläche "Entdecken" in der oberen Navigationsleiste. Dadurch gelangen Sie zu einer Bibliothek mit verfügbaren Apps, die Sie basierend auf Kategorien filtern oder nach bestimmten Funktionen suchen können.

Schritt 3: Erstellen Sie eine neue KI-App

Wenn Sie keine vorgefertigte App finden, die Ihren Anforderungen entspricht, können Sie eine neue KI-App von Grund auf erstellen. In Ihrer persönlichen Arbeitsumgebung klicken Sie auf die Schaltfläche "App erstellen" und wählen den Typ der App aus, die Sie erstellen möchten.

Anakin AI bietet drei Haupttypen von Apps:

- Schnell-App: Dieser App-Typ ist für die Generierung von Textinhalten wie Blog-Beiträgen, Übersetzungen oder kreativem Schreiben konzipiert.

- Chatbot-App: Wie der Name schon sagt, ermöglicht diese App die Erstellung von Chatbots, die in natürlichen Konversationen mit Benutzern interagieren können.

- Workflow-App: Workflow-Apps sind komplexer und ermöglichen es Ihnen, mehrere KI-Modelle und Funktionen in einer einzigen Anwendung zu kombinieren.

Für dieses Beispiel erstellen wir eine Schnell-App.

Schritt 4: Passen Sie Ihre KI-App an

Nachdem Sie den App-Typ ausgewählt haben, gelangen Sie zur App Builder-Oberfläche. Hier können Sie verschiedene Aspekte Ihrer App anpassen, wie z. B. die Eingabefelder, das zu verwendende KI-Modell und das Ausgabeformat.

Bei einer Schnell-App definieren Sie in der Regel Folgendes:

- Eingabefelder: Hier geben Benutzer die erforderlichen Informationen ein, damit die App Inhalte generieren kann. Wenn Sie z. B. eine App zum Generieren von Blog-Beitrag-Ideen erstellen, könnten Sie Eingabefelder für das Thema, die Zielgruppe und den gewünschten Ton haben.

- KI-Modell: Anakin AI bietet eine Reihe von KI-Modellen von verschiedenen Anbietern wie OpenAI, Anthropic und Google. Sie können das Modell auswählen, das am besten zu den Anforderungen Ihrer App passt.

- Prompt-Vorlage: Dies ist die Vorlage, die das KI-Modell verwendet, um Inhalte auf Grundlage der Eingabe des Benutzers zu generieren. Sie können die Prompt-Vorlage anpassen, um sicherzustellen, dass die generierten Inhalte Ihren spezifischen Anforderungen entsprechen.

- Ausgabeformat: Schließlich können Sie das Format angeben, in dem die generierten Inhalte präsentiert werden sollen, z. B. als einfacher Text, Markdown oder HTML.

Nachdem Sie Ihre App angepasst haben, können Sie sie testen, indem Sie Beispiel-Eingaben bereitstellen und Inhalte generieren. Wenn Sie mit den Ergebnissen zufrieden sind, können Sie Ihre App speichern und für andere Benutzer zugänglich machen.

Schritt 5: Integrieren Sie Anakin AI's API (Optional)

Anakin AI bietet umfassende API-Dienste für alle Anwendungen und ermöglicht Entwicklern und Organisationen, ihre Projekte nahtlos mit Anakin AI's APIs zu integrieren und zu verbessern.

Durch die Nutzung dieser APIs erhalten Benutzer die Flexibilität, die leistungsstarken Funktionen von Anakin AI in ihren eigenen Anwendungen zu nutzen. Diese Funktion ermöglicht es Entwicklern und Organisationen, ihre spezifischen Anpassungsanforderungen ohne komplexen Aufwand bei der Verwaltung von Backend-Architektur und Bereitstellungsprozessen zu erfüllen. Dadurch werden Entwicklungskosten und Arbeitsbelastung erheblich reduziert und bieten Entwicklern einen beispiellosen Komfort.

Vorteile der API-Integration

- Entwickeln Sie schnell KI-Anwendungen, die auf Ihre geschäftlichen Anforderungen zugeschnitten sind, mit Anakin AI's intuitiver visueller Oberfläche und ihrer Echtzeit-Implementierung auf allen Clients.

- Unterstützung für mehrere KI-Modellanbieter, die Ihnen die Flexibilität bieten, bei Bedarf Anbieter zu wechseln.

- Vorgefertigter Zugriff auf die essentiellen Funktionen des KI-Modells.

- Bleiben Sie mit zukünftigen erweiterten Funktionen auf dem neuesten Stand, die über die API verfügbar sind.

Verwendung von Anakin AI mit Codestral 22B

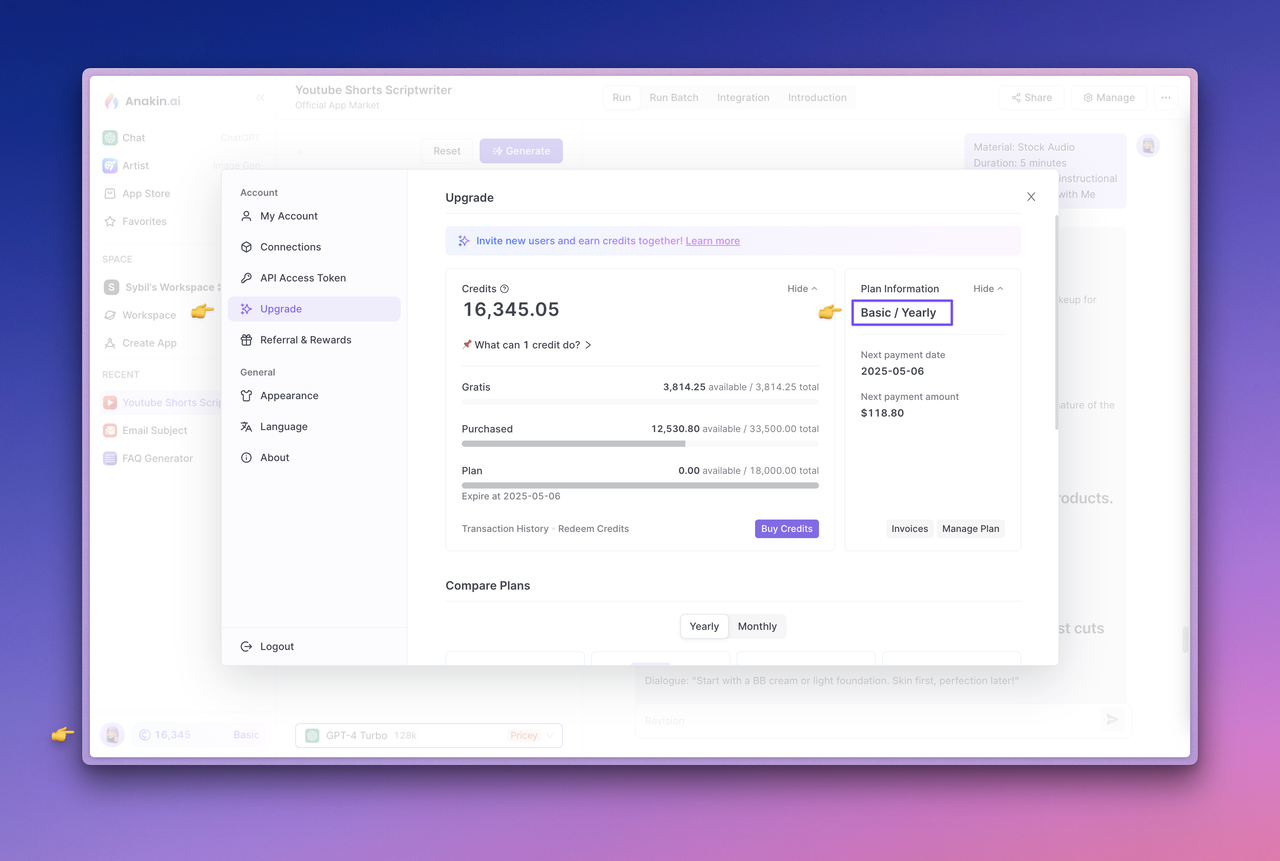

Upgraden Sie Ihren Plan und überprüfen Sie Ihre Kontogutschriften: Anakin AI's API-Service ist derzeit exklusiv für Abonnenten verfügbar. Während Sie das KI-Modell über API-Aufrufe verwenden, werden Gutschriften von Ihrem Kontoguthaben abgezogen. Überprüfen Sie Ihren Abonnementstatus oder aktualisieren Sie Ihren Plan, indem Sie zur Anakin AI Web App navigieren, auf den Avatar in der unteren linken Ecke klicken und auf die Upgrade-Seite zugreifen. Stellen Sie sicher, dass Ihr aktuelles Konto über ausreichende Gutschriften verfügt.

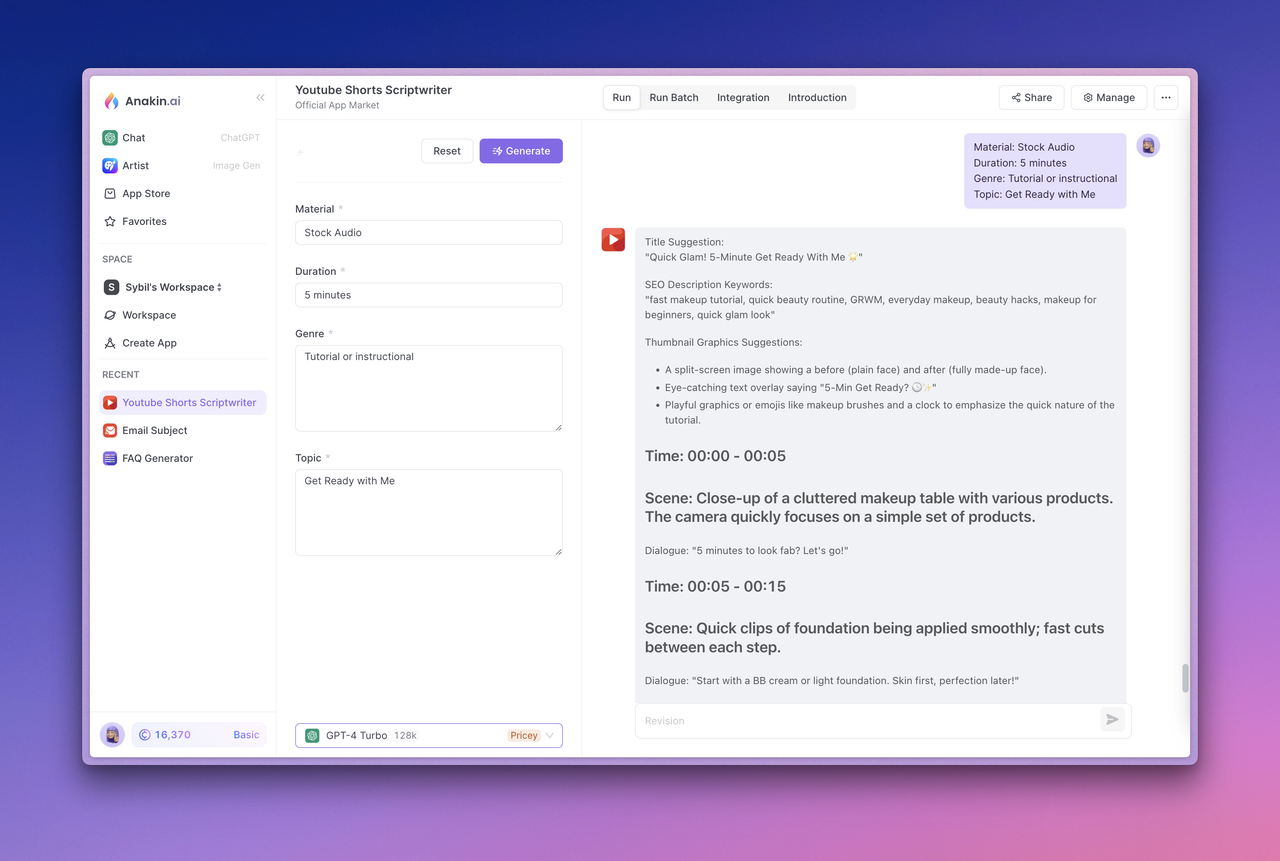

Testen Sie Ihre App: Um die App zu testen, wählen Sie die App aus und klicken Sie auf die Schaltfläche "Generieren". Bestätigen Sie, dass sie ordnungsgemäß ausgeführt wird und die erwartete Ausgabe erzeugt, bevor Sie fortfahren.

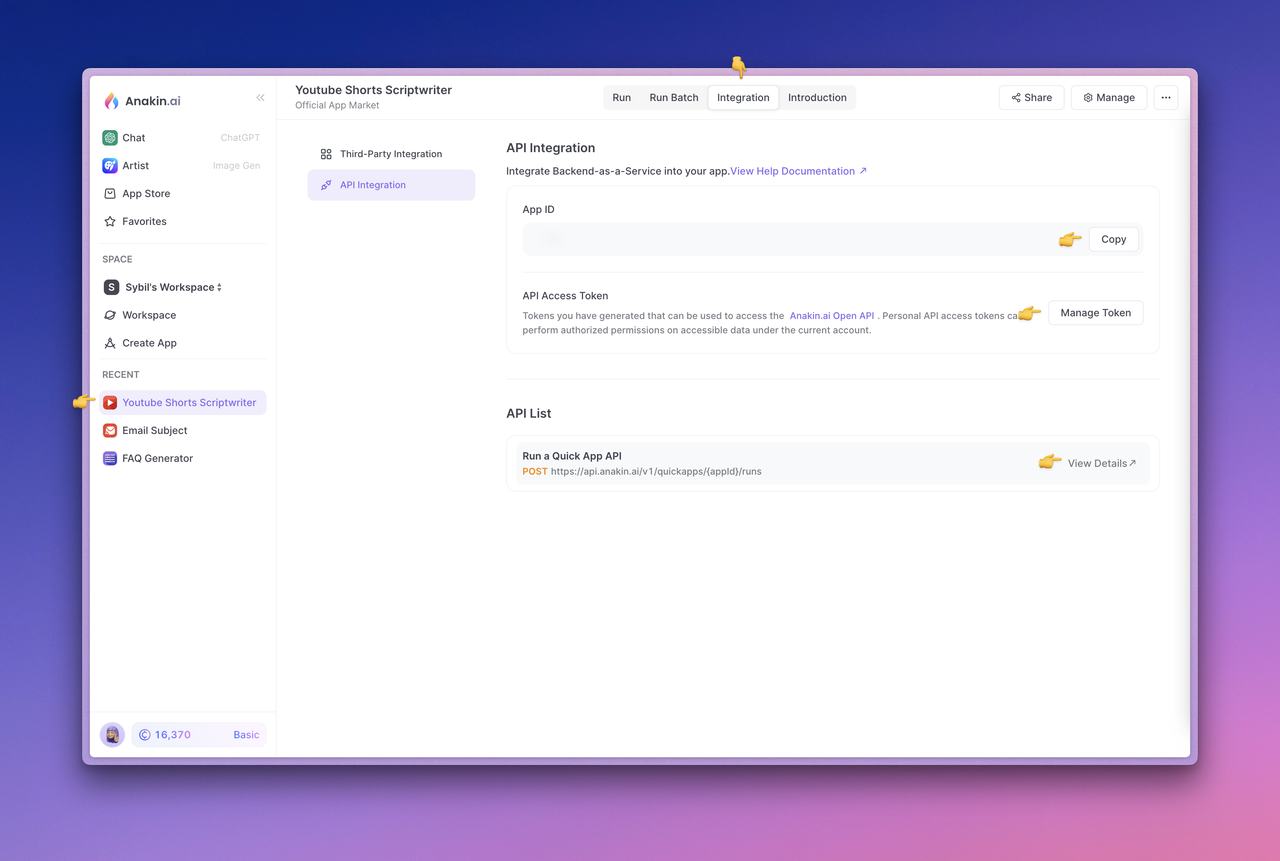

API-Dokumentation anzeigen und API-Zugriffstoken verwalten: Besuchen Sie als Nächstes den Bereich "Integration" der App oben. Hier können Sie auf "Details anzeigen" klicken, um die von Anakin AI bereitgestellte API-Dokumentation einzusehen, den Zugriff auf Tokens verwalten und die App-ID anzeigen.

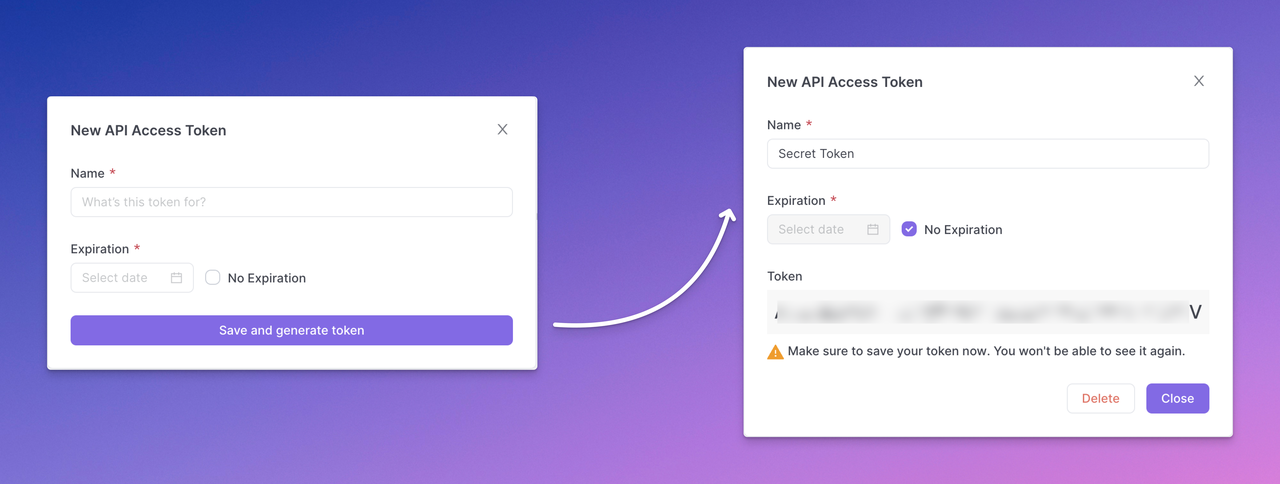

Ihr API-Zugriffstoken generieren: Klicken Sie auf die Schaltfläche "Token verwalten", um Ihr API-Zugriffstoken zu verwalten, und wählen Sie "Neues Token", um Ihr API-Zugriffstoken zu generieren. Konfigurieren Sie das Token vollständig, klicken Sie dann auf "Speichern und Token generieren" und kopieren und speichern Sie das API-Zugriffstoken sicher.

Beachten Sie, dass das generierte API-Zugriffstoken nur einmal angezeigt wird. Stellen Sie also sicher, dass Sie es sofort sicher kopieren und speichern. Es ist bewährt, API-Schlüssel im Klartext über Backend-Aufrufe anstelle von direktem Frontend-Code oder Anfragen auszusetzen, um Missbrauch oder Angriffe auf Ihre App zu verhindern. Sie können mehrere API-Zugriffstoken für eine App erstellen, um es unter verschiedenen Benutzern oder Entwicklern zu verteilen. Dadurch können die Benutzer der API auf die von der App bereitgestellten KI-Fähigkeiten zugreifen, während die zugrunde liegende Prompt-Engineering und andere Werkzeugfunktionen intakt bleiben.

Beispiel für eine Quick App-API-Anfrage

Mit einer Quick App können Sie qualitativ hochwertige Textinhalte wie Blog-Beiträge, Übersetzungen und andere kreative Inhalte generieren. Durch Aufruf der API "Run a Quick App" wird der vom Benutzer eingegebene Inhalt gesendet und das generierte Textergebnis erhalten.

Die Modellparameter und Prompt-Vorlage zur Generierung von Text hängen von den Eingabeeinstellungen auf der Anakin AI App -> Verwalten -> Design-Seite ab.

In der App -> Integration -> API-Liste -> Details finden Sie die API-Dokumentation und Beispielanfragen für die App.

Hier ist ein Beispiel für einen API-Aufruf zur Generierung von Textinformationen:

curl --location --request POST 'https://api.anakin.ai/v1/quickapps/{{appId}}/runs' \

--header 'Authorization: Bearer ANAKINAI_API_ACCESS_TOKEN' \

--header 'X-Anakin-Api-Version: 2024-05-06' \

--header 'Content-Type: application/json' \

--data-raw '{

"inputs": {

"Product/Service": "Cloud Service",

"Features": "Zuverlässigkeit und Leistung.",

"Advantages": "Effizienz",

"Framework": "Attention-Interest-Desire-Action"

},

"stream": true

}'

Beispiel für eine Chatbot App-API-Anfrage

Eine Chatbot-App ermöglicht Ihnen das Erstellen von Chatbots, die in natürlicher Frage-Antwort-Form mit Benutzern interagieren können. Um ein Gespräch zu starten, rufen Sie die "Conversation with Chatbot" API auf und geben Sie den zurückgegebenen Parameternamen fortlaufend ein, um das Gespräch aufrechtzuerhalten.

In der App -> Integration -> API-Liste -> Details finden Sie die API-Dokumentation und Beispieldaten für die App.

Hier ist ein Beispiel für einen API-Aufruf, um Konversationsnachrichten zu senden:

curl --location --request POST 'https://api.anakin.ai/v1/chatbots/{{appId}}/messages' \

--header 'Authorization: Bearer ANAKINAI_API_ACCESS_TOKEN' \

--header 'X-Anakin-Api-Version: 2024-05-06' \

--header 'Content-Type: application/json' \

--data-raw '{

"content": "Wie lautet dein Name? Bist du der Clevere?",

"stream": true

}'

Indem Sie Anakin AI's APIs in Ihre Anwendungen integrieren, können Sie die Leistungsfähigkeit von KI-Modellen und -Funktionen nutzen und gleichzeitig die Kontrolle über die Benutzererfahrung und Anpassungsoptionen beibehalten.

Fazit

In diesem umfassenden Leitfaden haben Sie gelernt, wie Sie das Codestral 22B-Modell mithilfe von Ollama, einem leistungsstarken Tool zur Interaktion mit KI-Modellen, ausführen und KI-Anwendungen mithilfe von Anakin AI, einer No-Code-Plattform, die den Prozess der Erstellung und Bereitstellung von KI-Lösungen vereinfacht, entwickeln können.

Indem Sie den in diesem Artikel beschriebenen Schritten folgen, können Sie die Möglichkeiten des Codestral 22B-Modells für Codieraufgaben nutzen und mit Anakin AI individuell anpassbare KI-Apps erstellen, die Ihren spezifischen Anforderungen entsprechen. Egal, ob Sie Entwickler, Unternehmer oder einfach nur ein KI-Enthusiast sind, diese Tools bieten einen nahtlosen und zugänglichen Weg, um das große Potenzial der künstlichen Intelligenz zu erkunden.

Quellen:

[1] https://ppl-ai-file-upload.s3.amazonaws.com/web/direct-files/6987700/746022a6-8311-46fa-9fbc-1b22763a6ef6/paste.txt

[2] https://ppl-ai-file-upload.s3.amazonaws.com/web/direct-files/6987700/c1da2cf5-5a8c-4b2e-bfa7-8aa539ee8062/paste.txt

[3] https://github.com/ollama/ollama

[4] https://ollama.com/download

[5] https://www.ollama.com

[6] https://huggingface.co/mistralai/Codestral-22B-v0.1

[7] https://huggingface.co/bartowski/Codestral-22B-v0.1-GGUF

[8] https://mistral.ai/news/codestral/

[9] https://www.youtube.com/watch?v=XGc0Q3tJ7s0

[10] https://ollama.com/blog/continue-code-assistant

[11] https://github.com/ollama/ollama/issues/4706

[12] https://www.jammable.com/anakinskywalker

[13] https://www.eventbrite.com/e/anakinai-promo-code-anakinai-sign-up-now-tickets-892090535807

[14] https://www.aitoolsclub.com/anakin-ai/

[15] https://scrapbox.io/anakin-ai/How_to_Create_AI_Apps_with_No_Code_Effortlessly

[16] https://www.futurepedia.io/tool/anakinai

[17] https://digitaltools.io/ai/anakin-ai/

[18] https://www.youtube.com/watch?v=o_iO-uCuD_I

[19] https://www.youtube.com/watch?v=lK8xsrLhL_E

[20] https://www.youtube.com/watch?v=UkfnC2kT_so