In der schnelllebigen Welt der künstlichen Intelligenz ist die nahtlose Integration leistungsstarker KI-Modelle in Anwendungen ein Gamechanger für Entwickler. Dieser Artikel dient als umfassender Leitfaden für die Nutzung von ChatOpenAI innerhalb der LangChain-Bibliothek und des Azure OpenAI-Dienstes. Egal, ob Sie Ihr Projekt mit anspruchsvollen Konversationsfähigkeiten erweitern möchten oder einfach das Potenzial von KI erkunden, es ist entscheidend zu verstehen, wie man ChatOpenAI effektiv einsetzt. Wir werden den Prozess in einfache und umsetzbare Schritte aufteilen, ergänzt durch Beispiellcode, um Sie zu starten.

TL;DR: Schnellstart-Anleitung

- Installieren Sie LangChain und importieren Sie ChatOpenAI, um Ihre Entwicklungsumgebung einzurichten.

- Konfigurieren Sie ChatOpenAI mit Ihrem OpenAI- oder Azure-API-Schlüssel für die Authentifizierung.

- Erstellen und führen Sie eine Chat-Funktion aus, um mit dem KI-Modell zu interagieren.

- Verstehen Sie den Unterschied zwischen OpenAI und ChatOpenAI für eine bessere Integration.

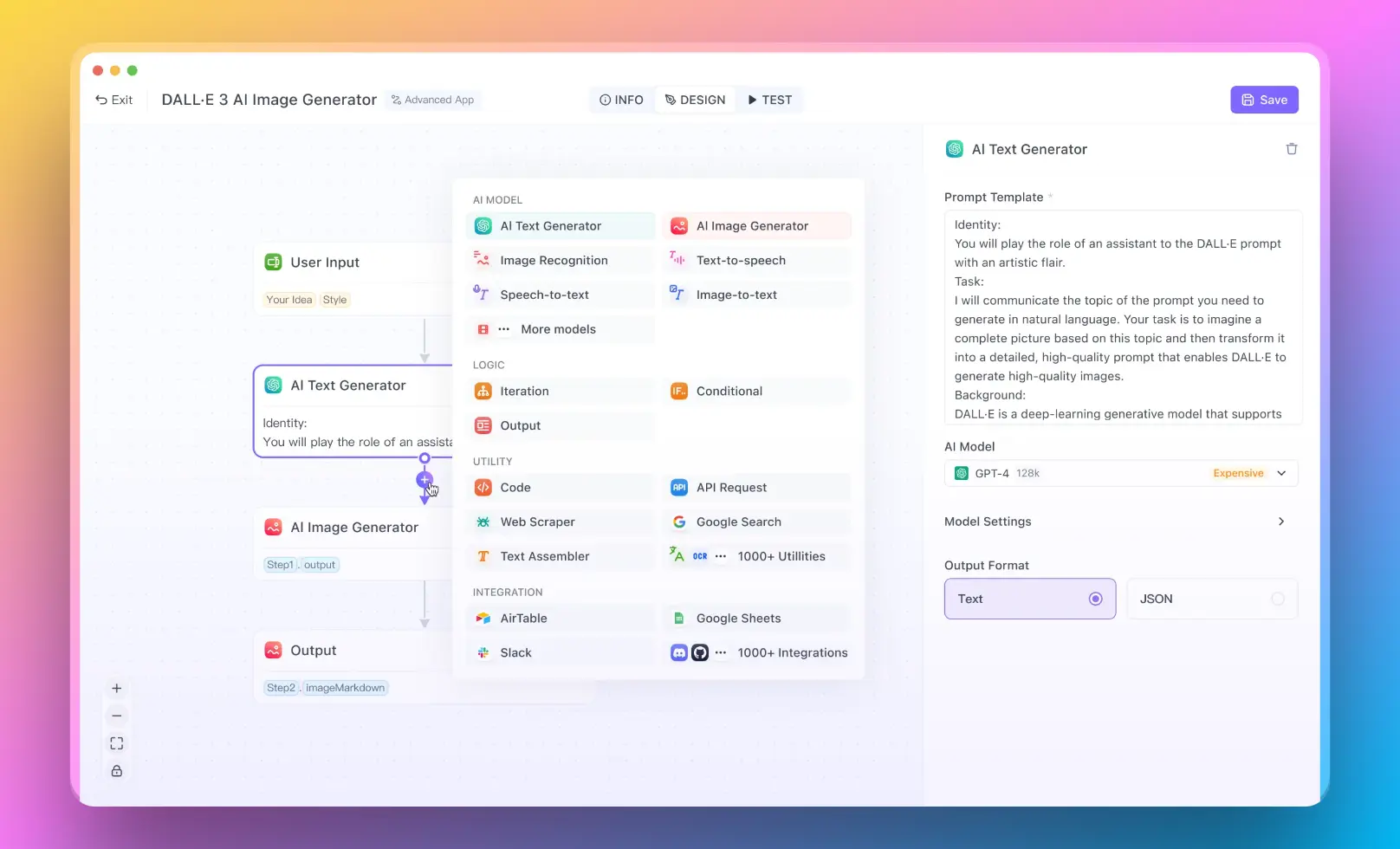

- Für Benutzer, die ein RAG-System ohne Programmierkenntnisse ausführen möchten, können Sie Anakin AI ausprobieren, mit dem Sie großartige KI-Apps mit einem No-Code-Builder erstellen können!

Mit all den oben genannten Informationen kann es losgehen!

Erste Schritte mit ChatOpenAI und LangChain

Stellen Sie sich vor, Sie bauen einen Roboter, der wie ein Mensch chatten kann. Dafür müssen Sie ihm ein Gehirn geben - und hier kommt ChatOpenAI ins Spiel. LangChain ist sozusagen der Körper des Roboters, der die Verwendung des Gehirns erleichtert. Hier ist, wie alles zusammenpasst:

- Einrichten: Es ist wie das Vorbereiten Ihres Arbeitsbereichs. Stellen Sie sicher, dass Ihr Computer Python versteht, und stellen Sie ihn dann über die Installation von LangChain ein.

- Das Gehirn (ChatOpenAI) einführen: Jetzt stellen Sie das Gehirn (ChatOpenAI) dem Körper Ihres Roboters (LangChain) vor. Es ist so einfach wie Python mitzuteilen: "Hey, wir werden ChatOpenAI verwenden."

- Das Gehirn aktivieren: Bevor Ihr Roboter chatten kann, müssen Sie das Gehirn mit dem Internet verbinden (unter Verwendung Ihres OpenAI-API-Schlüssels). Dies entspricht der WLAN-Verbindung des Gehirns.

- Chatten: Jetzt sind Sie bereit zu chatten! Schreiben Sie eine kleine Notiz an die KI (wie "Hallo"), und sie wird antworten.

Chatten über Azure OpenAI

Möglicherweise möchten Sie, dass Ihr Roboter einen anderen Internetanbieter verwendet, und hier kommt Azure ins Spiel. Die Schritte sind ähnlich, aber Sie verwenden einfach Azures WLAN:

- Registrierung bei Azure: Erstellen Sie ein Azure-Konto und finden Sie Ihre speziellen Azure WLAN-Daten (API-Schlüssel und Endpunkt).

- Das Gehirn mit Azure verbinden: Sagen Sie dem Gehirn Ihres Roboters, Azure WLAN zu verwenden, indem Sie ihm die Azure-Daten geben.

- Mit dem Chatten beginnen: Wie zuvor senden Sie eine Notiz an die KI, und Sie erhalten eine Antwort.

OpenAI vs. ChatOpenAI: Was ist der Unterschied?

- OpenAI: Dies ist das große Unternehmen, das KI-Gehirne herstellt. Sie stellen Gehirne für verschiedene Aufgaben her.

- ChatOpenAI: Dies ist ein bestimmter Typ Gehirn, der für das Chatten entwickelt wurde. Es ist darauf ausgelegt, einfach zu bedienen zu sein, damit Ihr Roboter schnell mit dem Chatten beginnen kann.

Integrieren von ChatOpenAI mit LangChain und Azure OpenAI

Entdecken Sie, wie ChatOpenAI Ihre Projekte mit LangChain und Azure OpenAI verbessert. Klicken Sie, um die Möglichkeiten zu erkunden!

Einführung in ChatOpenAI

ChatOpenAI ist ein leistungsstarkes Tool, das entwickelt wurde, um die Integration von OpenAIs Sprachmodellen in verschiedene Anwendungen zu optimieren. Dieser Artikel geht darauf ein, wie Entwickler die ChatOpenAI-Klasse innerhalb der LangChain-Bibliothek und des Azure OpenAI-Dienstes nutzen können. Er hebt die Unterschiede zwischen OpenAI und ChatOpenAI hervor und bietet praktische Anleitungen durch Schritte und Beispiellcodes.

Wie man ChatOpenAI in LangChain verwendet

LangChain ist eine Bibliothek, die den Aufbau von Sprachanwendungen erleichtert, indem sie gemeinsame Muster in Sprach-KI abstrahiert. Die Integration von ChatOpenAI in LangChain kann den Prozess der Bereitstellung von Konversations-KI-Modellen erheblich vereinfachen.

Schritt 1: Einrichten der Entwicklungsumgebung

Bevor Sie ChatOpenAI integrieren, stellen Sie sicher, dass Python installiert ist und eine virtuelle Umgebung eingerichtet ist:

python -m venv langchain-env

source langchain-env/bin/activate

Schritt 2: Installation von LangChain

Installieren Sie LangChain mit pip:

pip install langchain

Schritt 3: Importieren von ChatOpenAI

Importieren Sie die Klasse ChatOpenAI aus LangChain:

from langchain.chains import ChatOpenAI

Schritt 4: Konfigurieren von ChatOpenAI

Initialisieren Sie die Klasse ChatOpenAI mit Ihrem OpenAI-API-Schlüssel:

chat_model = ChatOpenAI(api_key='your_openai_api_key')

Schritt 5: Erstellen einer Konversation

Erstellen Sie eine Funktion, um die Logik der Konversation zu handhaben:

def chat_with_openai(prompt):

response = chat_model.chat(prompt)

print("KI sagt:", response)

Schritt 6: Ausführen des Chats

Testen Sie die Einrichtung, indem Sie eine Notiz an das Modell senden:

chat_with_openai("Hallo, wie kann ich Ihnen heute helfen?")

Verwendung der ChatOpenAI-Klasse mit Azure OpenAI

Azure OpenAI unterstützt auch die Integration von OpenAI-Modellen, einschließlich der Verwendung von ChatOpenAI für erweiterte Konversationsfähigkeiten.

Schritt 1: Erstellen eines Azure OpenAI-Ressourcen

Erstellen Sie zunächst eine Azure OpenAI-Ressource über das Azure-Portal und erhalten Sie Ihren API-Schlüssel und Endpunkt.

Schritt 2: Installieren des Azure SDK

Installieren Sie das Azure AI SDK:

pip install azure-ai-textanalytics

Schritt 3: Konfigurieren von ChatOpenAI mit Azure-Anmeldeinformationen

Ändern Sie die Initialisierung von ChatOpenAI, um Azure-Anmeldeinformationen zu verwenden:

chat_model = ChatOpenAI(api_key='your_azure_api_key', api_endpoint='your_azure_endpoint')

Schritt 4: Implementierung der Chat-Funktion

Verwenden Sie die gleiche Chat-Funktion wie zuvor, stellen Sie jedoch sicher, dass der Endpunkt korrekt konfiguriert ist, um auf Azure OpenAI zu verweisen:

def chat_with_azure(prompt):

response = chat_model.chat(prompt)

print("Azure KI sagt:", response)

Schritt 5: Testen Sie Ihre Azure-Integration

Führen Sie die Chat-Funktion aus, um zu sehen, wie sie mit Azure OpenAI funktioniert:

chat_with_azure("Hallo, wie kann ich Ihnen behilflich sein?")

Fazit

Durch die Integration von ChatOpenAI in LangChain und Azure OpenAI erhalten Entwickler ein robustes Framework, um fortschrittliche Konversations-KI in ihre Anwendungen zu integrieren. Durch Befolgung der oben beschriebenen Schritte können Sie ein reaktionsschnelles KI-Chat-System einrichten, das die Leistungsfähigkeit der OpenAI-Modelle nutzt und Ihren Anforderungen entsprechend anpasst - sowohl durch direkte OpenAI-Integration als auch über die Cloud-Plattform von Azure.