In dem sich schnell entwickelnden Bereich der künstlichen Intelligenz hat Meta kürzlich Llama 3 vorgestellt, ein bahnbrechendes großes Sprachmodell, das verspricht, die Art und Weise, wie wir mit KI-Technologie interagieren und nutzen, zu revolutionieren. Dieses leistungsstarke Werkzeug, das auf beeindruckenden 15 Billionen Tokens an Daten trainiert wurde, verfügt über bemerkenswerte Fähigkeiten zur Verständnis und Generierung von menschenähnlichem Text und ist somit ein Game-Changer für eine Vielzahl von Anwendungen.

Zusammenfassung

- Laden Sie Llama 3 von Meta's GitHub-Repository herunter und installieren Sie es.

- Feinabstimmung des Modells auf einen Code-Datensatz, um seine Codierungsfähigkeiten zu verbessern.

- Entwicklung einer Webanwendungs-Schnittstelle mit Flask.

- Erstellung einer benutzerfreundlichen Benutzeroberfläche für Ihren KI-Codierassistenten.

Was ist Llama 3?

- Llama 3 ist das neueste und fortschrittlichste große Sprachmodell von Meta, das aufgrund seiner außergewöhnlichen Leistung bei natürlichsprachlichen Verarbeitungsaufgaben bekannt ist.

- Mit seiner Fähigkeit, menschenähnlichen Text mit bemerkenswerter Genauigkeit zu verstehen und zu generieren, hat Llama 3 neue Maßstäbe in Bereichen wie logischem Denken, Codegenerierung und kreativem Schreiben gesetzt.

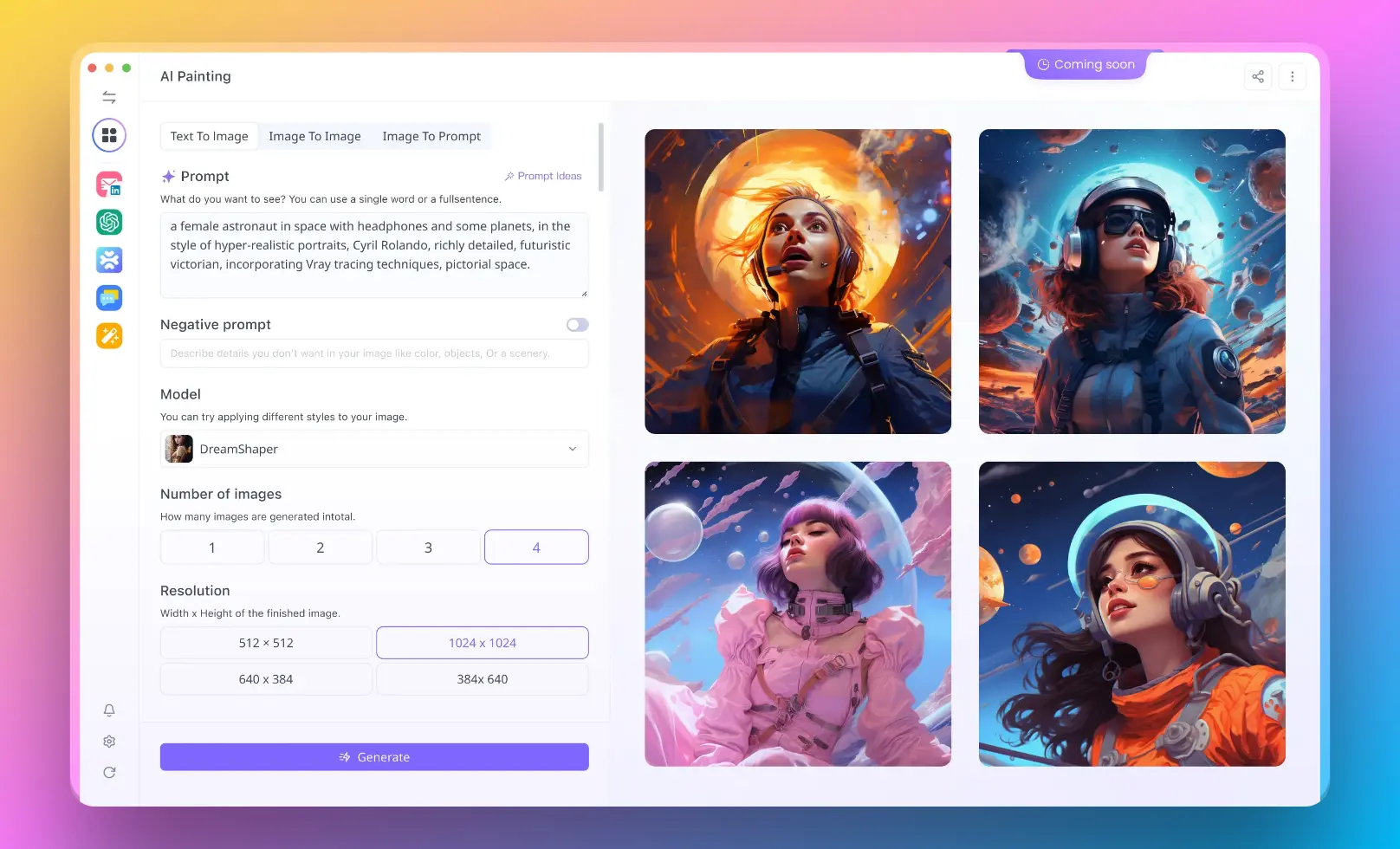

- Möchten Sie die Leistung von Llama 3 testen? Sprechen Sie jetzt mit Anakin AI! (Unterstützt praktisch jedes verfügbare KI-Modell!)

Was ist RAG (Retrieval-Augmented Generation)?

- RAG (Retrieval-Augmented Generation) ist eine von Llama 3 verwendete Technik, bei der die Sprachgenerierungsfähigkeiten mit externem Wissensabruf kombiniert werden.

- Durch die Nutzung eines umfangreichen Informationsspeichers ermöglicht RAG Llama 3 eine qualifiziertere und kontextuell relevantere Antwort, was seine Gesamtleistung und Vielseitigkeit verbessert.

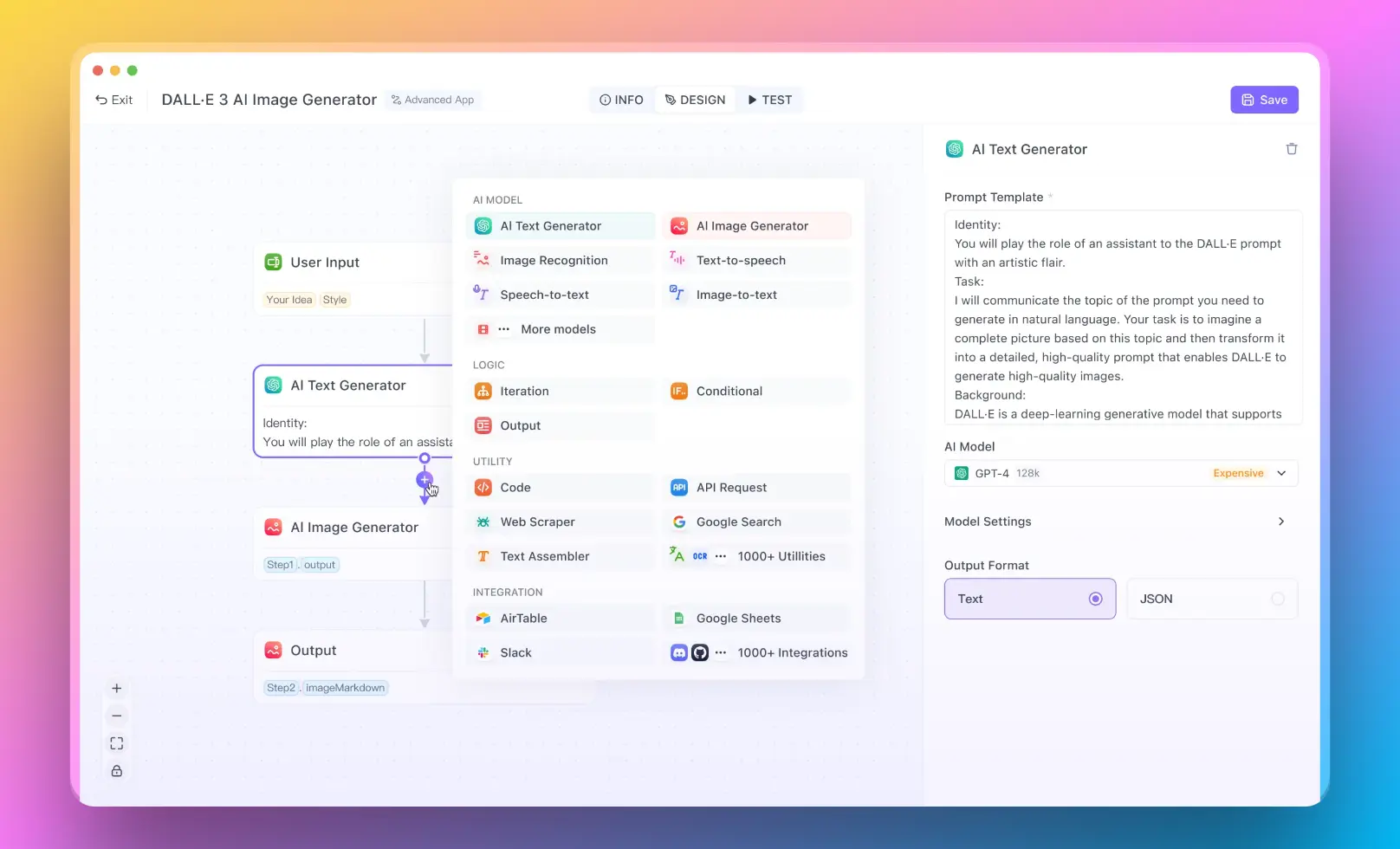

- Für Benutzer, die ein RAG-System ohne Programmierkenntnisse ausführen möchten, können Sie Anakin AI ausprobieren, wo Sie großartige KI-Apps mit einem No-Code-Builder erstellen können!

Verwenden Sie Anakin AI zum Erstellen von RAG-Anwendungen ohne Code

- Anakin AI bietet eine No-Code-Plattform zur Erstellung von KI-gesteuerten Anwendungen, einschließlich Retrieval-Augmented Generation (RAG)-Systemen.

- Mit seiner visuellen Benutzeroberfläche können Sie benutzerdefinierte RAG-Lösungen erstellen, indem Sie Datenquellen verbinden, Abruf- und Generierungskomponenten konfigurieren und Sprachmodelle feinabstimmen - alles ohne Code zu schreiben.

- Anakin AI bietet vorgefertigte Vorlagen und Zusammenarbeitstools, die es auch Nicht-Technikern ermöglichen, effiziente RAG-Lösungen zu entwickeln, selbst wenn sie über kein AI-Expertenwissen verfügen.

Mit allen oben genannten Informationen kann es losgehen!

Voraussetzungen

Stellen Sie vor dem Beginn sicher, dass Sie über folgendes verfügen:

- Einen Computer mit einer NVIDIA-GPU (empfohlen wird 8 GB VRAM oder mehr)

- Ein Betriebssystem Linux oder Windows 10/11

- Installiertes Python 3.7+

- Grundkenntnisse in Python und maschinellem Lernen

Schritt 1: Installieren Sie Llama 3

Der erste Schritt besteht darin, das Llama 3-Sprachmodell auf Ihrem lokalen Rechner zu installieren. Llama 3 ist Open Source und auf GitHub zu finden.

- Klonen Sie das Llama 3-Repository:

git clone https://github.com/facebookresearch/llama.git

cd llama

- Installieren Sie die erforderlichen Python-Pakete:

pip install -r requirements.txt

- Laden Sie die vortrainierten Llama 3-Gewichte herunter. Sie müssen das Formular auf der Llama 3-Website ausfüllen, um Zugriff zu erhalten. Platzieren Sie die heruntergeladene .pth-Datei im Verzeichnis llama/models.

Schritt 2: Feinabstimmung von Llama 3 auf Code

Als Nächstes müssen wir Llama 3 anhand eines Code-Datensatzes feinabstimmen, damit es Quellcode verstehen und generieren kann.

- Bereiten Sie einen Datensatz mit Code-Snippets und Dokumentzeichenketten vor. Eine gute Option ist der CodeSearchNet-Datensatz. Laden Sie das Python-Unterseiten-Set herunter und extrahieren Sie es:

wget https://s3.amazonaws.com/code-search-net/CodeSearchNet/v2/python.zip

unzip python.zip

- Verwenden Sie das Skript finetune.py, um Llama 3 auf dem Code-Datensatz zu trainieren:

python finetune.py \

--base_model decapoda-research/llama-7b-hf \

--data_path python/train \

--output_dir python_model \

--num_train_epochs 3 \

--batch_size 128

Dadurch wird Llama 3 für 3 Epochen auf dem Python-Code-Datensatz feinabgestimmt und das feinabgestimmte Modell im Verzeichnis python_model gespeichert.

Schritt 3: Entwicklung der Benutzeroberfläche für den Codierungsassistenten

Jetzt, da wir ein sprachmodellspezifisches Modell haben, wollen wir eine Benutzeroberfläche für unseren KI-Codierassistenten entwickeln. Hierfür werden wir eine einfache Webanwendung mit dem Flask-Framework erstellen.

- Installieren Sie Flask:

pip install flask

- Erstellen Sie eine neue Datei mit dem Namen app.py und fügen Sie den folgenden Code ein:

from flask import Flask, request, jsonify

from transformers import AutoModelForCausalLM, AutoTokenizer

app = Flask(__name__)

model_path = "python_model"

tokenizer = AutoTokenizer.from_pretrained(model_path)

model = AutoModelForCausalLM.from_pretrained(model_path)

@app.route('/complete', methods=['POST'])

def complete():

data = request.get_json()

code = data['code']

input_ids = tokenizer.encode(code, return_tensors='pt')

output = model.generate(input_ids, max_length=100, num_return_sequences=1)

generated_code = tokenizer.decode(output[0])

return jsonify({'generated_code': generated_code})

if __name__ == '__main__':

app.run()

Dadurch wird ein Flask-Webserver mit einem /complete-Endpunkt erstellt. Es lädt das feinabgestimmte Llama 3-Modell und den Tokenizer und verwendet sie, um Codevervollständigungen zu generieren, wenn eine POST-Anfrage mit dem aktuellen Code als JSON-Daten an /complete gesendet wird.

- Führen Sie die Flask-Anwendung aus:

flask run

Schritt 4: Erstellen einer Frontend-Benutzeroberfläche

Erstellen Sie schließlich eine grundlegende Benutzeroberfläche für unseren Codierungsassistenten.

- Erstellen Sie eine Datei mit dem Namen index.html und fügen Sie Folgendes ein:

<!DOCTYPE html>

<html>

<head>

<title>KI-Codierungsassistent</title>

</head>

<body>

<h1>KI-Codierungsassistent</h1>

<textarea id="code" rows="10" cols="50"></textarea>

<br>

<button onclick="complete()">Code vervollständigen</button>

<p>Generierter Code:</p>

<pre id="generated-code"></pre>

<script>

function complete() {

var code = document.getElementById("code").value;

fetch('/complete', {

method: 'POST',

headers: {

'Content-Type': 'application/json'

},

body: JSON.stringify({code: code})

})

.then(response => response.json())

.then(data => {

document.getElementById("generated-code").textContent = data.generated_code;

});

}

</script>

</body>

</html>

Dadurch wird eine einfache HTML-Seite erstellt, auf der der Benutzer seinen Code eingeben und einen Button drücken kann, um den Code an den /complete-API-Endpunkt zu senden. Die generierte Codevervollständigung wird dann unten angezeigt.

- Öffnen Sie index.html in einem Webbrowser und starten Sie die Codierung mit Hilfe Ihres KI-Assistenten!

Bereitstellung und nächste Schritte

Herzlichen Glückwunsch, Sie haben jetzt einen funktionierenden KI-Codierassistenten, der von Llama 3 unterstützt wird! Hier sind noch einige zusätzliche Dinge, die Sie versuchen können:

- Bereiten Sie Ihre Anwendung für eine Cloud-Plattform wie AWS oder Heroku vor, damit andere sie verwenden können.

- Erweitern Sie die Benutzeroberfläche um Syntaxhervorhebung, Mehrdateiunterstützung usw.

- Feinabstimmung von Llama 3 für zusätzliche Programmiersprachen.

- Experimentieren Sie mit alternativen Modellarchitekturen und Hyperparametern.

Mit den unglaublichen Möglichkeiten großer Sprachmodelle wie Llama 3 sind die Möglichkeiten endlos. Ich hoffe, diese Anleitung hat Ihnen geholfen, mit dem Aufbau Ihrer eigenen KI-Codierungstools zu beginnen. Viel Spaß beim Codieren!