人工知能(AI)の急速に進化する世界では、リアルタイムで言語を処理する能力はますます重要となっています。ストリーミングLangChainは、高度な言語理解と生成機能をアプリケーションにシームレスに統合することができる堅牢なソリューションを提供します。このガイドでは、ストリーミングLangChainの基本的な概念から実装までについて解説し、呼び出しとストリーミング出力の違いを強調し、大規模な言語モデル(LLM)におけるストリーミングの広範な影響を探ります。動的なチャットボット、リアルタイム翻訳ツール、または他の対話型のAI駆動アプリケーションを構築している場合、LangChainを使ってストリーミングを活用する方法を理解することで、プロジェクトの効果とユーザーの参加度を大幅に向上させることができます。

まとめ: クイックな概要

- 環境の初期化: LangChainのセットアップと言語モデルの設定を行います。

- ストリーミングの設定: ストリーミングのパラメータとセッションの設定を定義します。

- ロジックの実装: データの連続的な処理と応答を行うための関数を開発します。

- テストと最適化: テストを通じてシステムの応答性と安定性を確保します。

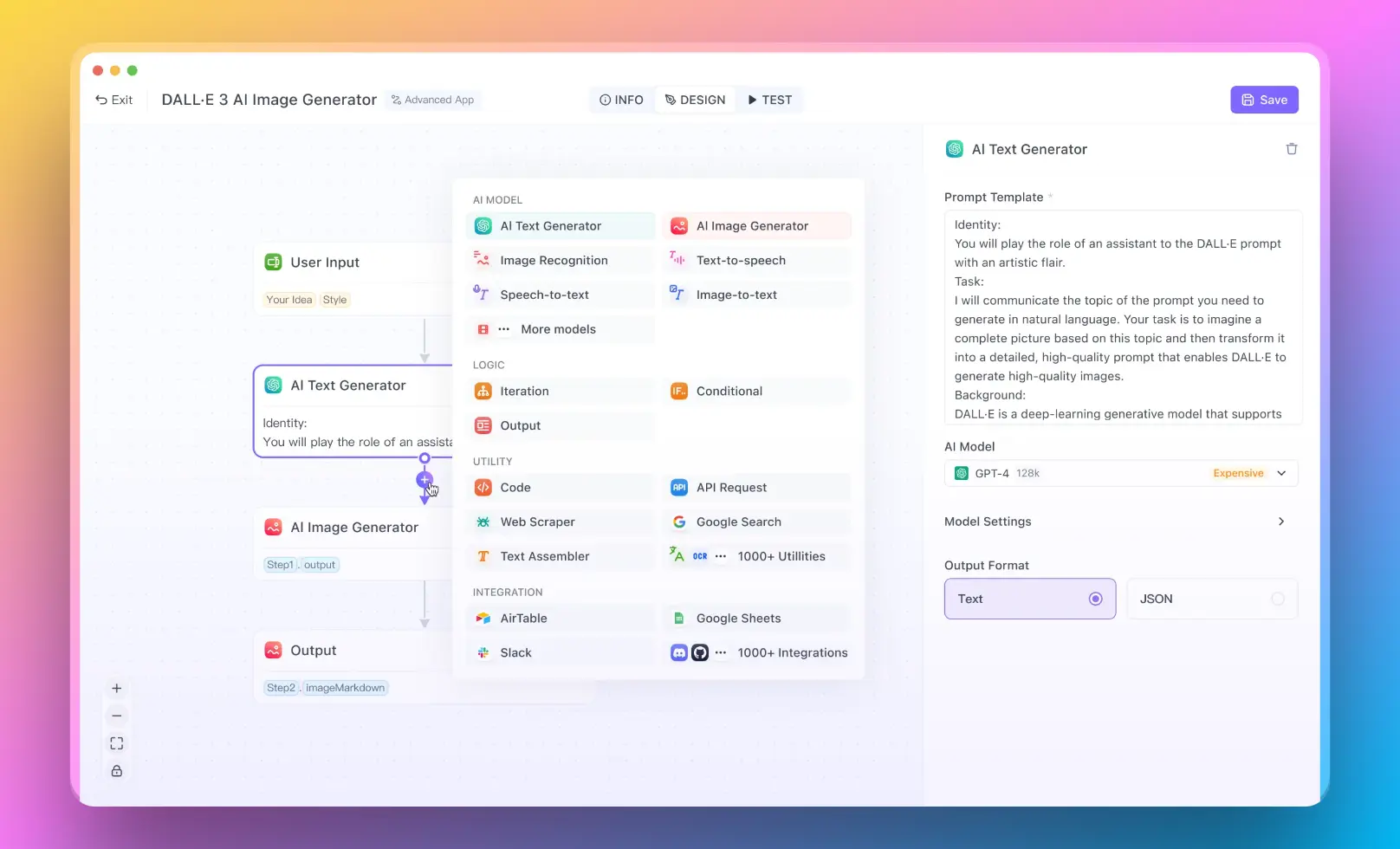

- コーディングの経験がないユーザー向けには、No Code Builderを使用して素晴らしいAIアプリを作成できるAnakin AIを試してみることができます!

ストリーミングLangChainとは何ですか?

LangChainは、言語モデルをアプリケーションに統合し、人間らしいテキストの理解と生成能力を向上させるための強力なツールです。LangChainにおけるストリーミングは、リアルタイムのデータフローの処理を指し、言語モデルが入力を連続的に処理・応答することを可能にします。この機能は、入力データが静的ではなく時間とともに進化するチャットボット、リアルタイム翻訳サービス、対話型教育プラットフォームなどのシナリオで特に有用です。

LangChainにおけるストリーミング出力のステップバイステップガイド

LangChainで効果的にストリーミング出力を行うためには、開発者は構造化されたアプローチに従う必要があります。以下はLangChainでストリーミング出力を開始する方法です:

LangChainの環境の初期化:

必要なライブラリのインストールと言語モデルの設定により、LangChainの環境を設定します。

from langchain.llms import OpenAI

# 言語モデルの初期化

llm = OpenAI(api_key='your-api-key')

ストリーミング設定の構成:

ストリーミングのパラメータを定義します。これにはセッションの設定やデータのストリーミング方法の指定が含まれます。

from langchain.chains import StreamingChain

# ストリーミングチェーンの作成

streaming_chain = StreamingChain(llm=llm, stream=True)

ストリーミングのロジックの実装:

データストリームの処理ロジックを開発します。これには、データを処理し、応答を生成する関数の作成が含まれます。

def handle_input(input_text):

response = streaming_chain.run(input_text)

print("Response:", response)

return response

# 使用例

handle_input("こんにちは、今日はどのようにお手伝いできますか?")

テストと最適化:

安定性と応答性を確保するために、さまざまな種類の入力でストリーミングのセットアップを継続的にテストします。フィードバックとパフォーマンスメトリクスに基づいて最適化します。

LangChainにおけるInvokeとStreamの違いは何ですか?

LangChainでは、"invoke"と"stream"という用語は、言語モデルとの相互作用の異なる方法を指します:

Invoke: このメソッドは、言語モデルから単一のレスポンスを取得する必要がある場合に使用されます。入力全体が一度に利用可能な静的な入力に適しています。モデルは入力を処理し、単一のレスポンスを返します。

Stream: Invokeとは異なり、連続的な入力および出力に使用されます。これにより、言語モデルは対話の流れに基づいてコンテキストを維持し、対話が時間の経過とともに自然に進行するチャットボットなどのアプリケーションに適しています。

以下はコードを使用したシンプルな比較です:

# Invokeの使用

response = llm.invoke("今日の天気はどうですか?")

print(response)

# Streamの使用

streaming_chain.run("今日の天気はどうですか?")

streaming_chain.run("明日は?")

LLM(Large Language Models)におけるストリーミングとは何ですか?

大規模言語モデル(LLM)におけるストリーミングは、これらのモデルが連続的でリアルタイムな方法で入力データを処理する能力を指します。これは、仮想アシスタント、リアルタイムのカスタマーサポートシステム、対話型学習ツールなどの動的な対話を必要とするアプリケーションにとって重要です。ストリーミングにより、LLMは会話のコンテキストを保持し、対話の流れに基づいて応答を調整し、長時間実行されるセッションを効果的に処理できるようになります。

LLMにおけるストリーミングの利点

- コンテキストの意識: 会話のコンテキストを保持し、一貫性があり文脈に即した応答を行います。

- リアルタイムの対話: 即座に入力を処理することができ、即時のフィードバックが必要なアプリケーションに適しています。

- スケーラビリティ: 同時に複数のインタラクションを処理することができ、企業向けソリューションに有益です。

LLMにおけるストリーミングの実装

LLMにおけるストリーミングの基本的な実装例は次のとおりです:

from langchain.llms import OpenAI

# LLMの初期化

llm = OpenAI(api_key='your-api-key')

# ストリーミングを処理する関数

def stream_conversation(input_text):

response = llm.stream(input_text)

print("Streaming Response:", response)

return response

# 会話の例

stream_conversation("こんにちは、あなたの名前は何ですか?")

stream_conversation("今日はどのように助けてくれますか?")

これで動作させるために必要な全てです!

まとめ

ストリーミングLangChainは、LLMの連続データ処理能力を活用する革新的な手法であり、開発者がより対話的でレスポンシブなアプリケーションを構築することを可能にします。ストリーミングを理解し実装することで、開発者はユーザーエクスペリエンスを大幅に向上させ、AIとのインタラクションをよりスムーズで自然なものにすることができます。