暗い宿舎の静かな一室で、古いラップトップの優しいハムと共に、私はコーディングの世界への旅に出ました。私の使命は単純でありながらも困難でした:コードの集合体に生命を吹き込み、基本的な会話ができるチャットボットに変えることです。夜ごとに、私はPythonの行を与え、それを複雑さに誘導しました。そして、ある澄んだ秋の夜、それは最初の理解できる返答を吐き出しました。「こんにちは、世界!」と言いました。その瞬間に、私は未来への秘密の扉を開けたようでした。

初めてのAIへの挑戦は、魔法と論理の混合物であり、人間の創造力の証でした。その勝利の夜から数年が経ちましたが、人工知能の領域は進化するだけでなく、かつてSFのページに限られていた領域に爆発的に広がりました。Alibaba CloudによるQwen 1.5のリリースは、この継続的なサーガの中での画期的な出来事であり、AIの冒険に輝く信号であります。

AIが詩を作り、病気を診断し、さらには車を運転することができる現在までの道のりは、奇跡的と言えるでしょう。Qwen 1.5は、この非凡な物語の最新の章であり、各アルゴリズムの突破口と書かれる各行によって展開し続けています。

記事の要約

- Qwen 1.5のデビュー:Alibaba CloudがQwen 1.5を発表しました。これは6つの異なるサイズのAIモデルで、印象的な機能によりGPT-3.5のようなモデルの優位性に挑戦します。

- 会話AIの再定義:多言語サポートと32Kトークンの長い文脈の取り扱い能力を備えたQwen 1.5は、会話AIの限界を再定義します。

- オープンアクセスの革命:Qwen 1.5は、GPT-4などの巨人たちと肩を並べるだけでなく、AIのオープンアクセス運動の先駆者でもあり、高度なテクノロジーを革新者たちに無償で提供します。

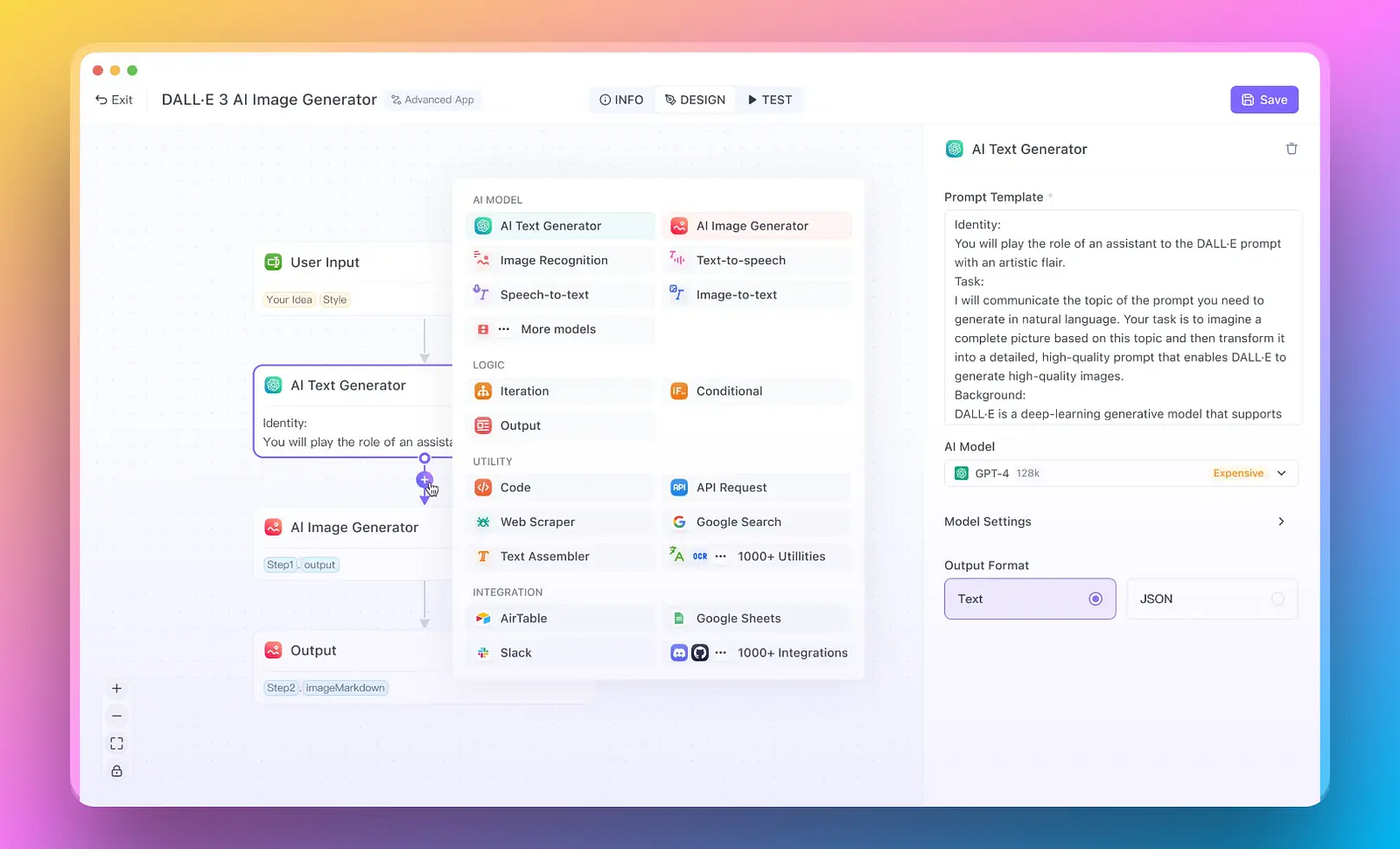

ただし、クイックなAIアプリを構築したい場合にはどうでしょうか?また、手間をかけずに済ませたい場合は?

どうぞこちらから: Anakin AI は市場で最も優れたノーコードAIアプリビルダーです。マルチモデルのサポートを備え、あなた自身のデータとワークフローのためのAIエージェントを構築します!

Qwen 1.5はどのように多言語AIモデルを再定義するのか?

AI革新の活気ある市場で、Qwen 1.5はただ他の競合としてだけでなく、道を切り開く存在として際立っています。Alibaba Cloudは、0.5から720億という幅広いパラメータの取り回しを可能にする驚異を公開しました。このモデルのサイズの多様性は前例のないものであり、必要に応じて微妙であるか、拡大的であるかが選択できるAIへの取り組みを示しています。

このスイートは、最も単純なタスクから最も要求の厳しいタスクまで、幅広いスペクトラムに対応できるよう設計されています。720億のパラメータを持つ最大のバリアントは、学習と理解の深い能力を備えたデジタルな多芸多才な存在のようです。

Qwen 1.5の多言語サポートはなぜ画期的なのか?

多言語サポート

Qwen 1.5は単なる多言語話者ではありません。それはグローバルな対話の扉を開く存在です。多言語サポートにより、知識と専門知識が長い間分断された言語の壁を打ち破ります。

このモデルは、多様な文化がAIの進歩に貢献し、それを享受できるようにするために、多くの声をテーブルに招待します。これにより、言語が革新のグローバルな対話における障壁ではなく、多様な知性を結びつける橋となる未来が待っています。

AIモデルの効率性

さらに、Qwen 1.5の効率は、Alibaba Cloudのシームレスな機能に対する取り組みの証です。Transformersライブラリとのスムーズな統合により、開発者は通常の互換性の問題や急な学習曲線なしに、その力を利用することができます。

モデルの重み最適化 - Int-4、GPTQ、AWQ、およびGGUF - は、効率的なモデルの最高峰を表しています。これらは単なる専門用語ではなく、このような洗練されたモデルに通常関連付けられる膨大なリソースの消費を伴わずにパフォーマンスを提供するための候補です。

Qwen 1.5は他のモデルと比較してどうなのか?

モデルが優位を争う競争の舞台で、Qwen 1.5は競争するだけでなく、新たな基準を設定します。MT-BenchとAlpaca-Evalのパフォーマンスチャートは単なる数字ではありません。これらは、様々なメトリックで競争相手を凌駕する中で、Qwen 1.5が順位を上げる物語を語っています。

Stable Diffusion

ベンチマークパフォーマンス

| モデル | MMLU | C-Eval | GSM8K | MATH | HumanEval | MBPP | BBH | CMMLU |

|---|---|---|---|---|---|---|---|---|

| GPT-4 | 86.4 | 69.9 | 92.0 | 45.8 | 67.0 | 61.8 | 86.7 | 71.0 |

| Llama2-7B | 46.8 | 32.5 | 16.7 | 3.3 | 12.8 | 20.8 | 38.2 | 31.8 |

| Llama2-13B | 55.0 | 41.4 | 29.6 | 5.0 | 18.9 | 30.3 | 45.6 | 38.4 |

| Llama2-34B | 62.6 | - | 42.2 | 6.2 | 22.6 | 33.0 | 44.1 | - |

| Llama2-70B | 69.8 | 50.1 | 54.4 | 10.6 | 23.7 | 37.7 | 58.4 | 53.6 |

| Mistral-7B | 64.1 | 47.4 | 47.5 | 11.3 | 27.4 | 38.6 | 56.7 | 44.7 |

| Mixtral-8x7B | 70.6 | - | 74.4 | 28.4 | 40.2 | 60.7 | - | - |

| Qwen1.5-7B | 61.0 | 74.1 | 62.5 | 20.3 | 36.0 | 37.4 | 40.2 | 73.1 |

| Qwen1.5-14B | 67.6 | 78.7 | 70.1 | 29.2 | 37.8 | 44.0 | 53.7 | 77.6 |

| Qwen1.5-72B | 77.5 | 84.1 | 79.5 | 34.1 | 41.5 | 53.4 | 65.5 | 83.5 |

以下は私たちのテイクです:

- デカスロンを想像してください。ほとんどすべての競技で他の競技者を追い越し、パフォーマンスのバーを再定義することです。これこそが、Qwen 1.5がデジタル領域で達成することです。パフォーマンスチャートは、Qwen 1.5の能力を示しており、GPT-3.5などの他の優れたモデルと並べるだけでなく、しばしば上回っています。

- 堅牢さと汎用性を組み合わせた設計のおかげで、言語理解、生成、推論においてQwen 1.5は優れたパフォーマンスを発揮することができます。

長い文脈のサポート

長い会話の管理や複雑なドキュメントの分析には独特の技巧があり、それがQwen 1.5の真価を示しています。

| モデル | Coursera | GSM | QuALITY | TOEFL | SFiction | Avg. |

|---|---|---|---|---|---|---|

| GPT3.5-turbo-16k | 63.51 | 84.00 | 61.38 | 78.43 | 64.84 | 70.43 |

| Claude1.3-100k | 60.03 | 88.00 | 73.76 | 83.64 | 72.65 | 75.62 |

| GPT4-32k | 75.58 | 96.00 | 82.17 | 84.38 | 74.99 | 82.62 |

| Qwen-72B-Chat | 58.13 | 76.00 | 77.22 | 86.24 | 69.53 | 73.42 |

| Qwen1.5-0.5B-Chat | 30.81 | 6.00 | 34.16 | 40.52 | 49.22 | 32.14 |

| Qwen1.5-1.8B-Chat | 39.24 | 37.00 | 42.08 | 55.76 | 44.53 | 43.72 |

| Qwen1.5-4B-Chat | 54.94 | 47.00 | 57.92 | 69.15 | 56.25 | 57.05 |

| Qwen1.5-7B-Chat | 59.74 | 60.00 | 64.36 | 79.18 | 62.50 | 65.16 |

| Qwen1.5-14B-Chat | 69.04 | 79.00 | 74.75 | 83.64 | 75.78 | 76.44 |

| Qwen1.5-72B-Chat | 71.95 | 82.00 | 77.72 | 85.50 | 73.44 | 78.12 |

以下は私たちのテイクです:

- 最大32,000トークンを処理できる能力は、最長のスレッドをパターンを失うことなく扱うマスターワーバーに似ています。

- 拡張された対話や物語の一貫性を維持するこの能力は、法的文書の作成から文学作品の作成まで、深い文脈の認識を必要とするアプリケーションに新たな可能性を開くものです。

そして… オープンソース!

AIモデルの価値はパフォーマンスだけでなく、そのアクセスにもあります。オープンアクセスの哲学を受け入れることで、Qwen 1.5はグローバルな開発者や研究者コミュニティに手を差し伸べています。このアクセシビリティにより、Alibaba Cloudの成果物が専用の制約の門の後ろにロックされずに自由に共有され、イノベーションと研究が国境を越えて促進されます。これは、大学の寮にいる学生だけでなく、テックコングロマリットの開発者にも属しているモデルです。

AIの大いなるチェスボードにおいて、Qwen 1.5はAlibaba Cloudのチェックメイトの一手であり、類まれなパフォーマンス、優れた文脈管理、普遍的なアクセス性を提供します。それは孤立して存在するのではなく、エコシステムの一部として、それを形作り、形作られるコミュニティに影響を与えています。

Qwen 1.5の実行手順

Qwen 1.5で開発する際には、Hugging FaceのTransformersライブラリとの統合により、ユーザーフレンドリーさが大幅に向上しました。以下に始めるためのステップバイステップのガイドを示します:

Qwen 1.5でのスタート

環境のセットアップ: Qwen 1.5をサポートする最新バージョンのHugging Face transformersがインストールされていることを確認します。

モデルの読み込み: モデル名とdevice_mapを "auto"に設定して、AutoModelForCausalLM.from_pretrainedを使用してモデルを読み込みます。

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen1.5-7B-Chat", device_map="auto")

Qwen 1.5とのチャット: プロンプトを準備し、トークナイザーを使用してチャットテンプレートを適用し、モデルを使用して応答を生成します。

from transformers import AutoModelForCausalLM, AutoTokenizer

# ... (初期設定コードがここにある場合)

# 応答を生成し、デコードする

# ... (生成とデコードのコードがここにある場合)

Advanced Weightsの使用: 低リソースまたはデプロイメントシナリオでは、AWQおよびGPTQモデルを、それぞれのモデル名で読み込むだけで利用できます。

Inference Frameworksでのデプロイ: Qwen 1.5をvLLMやSGLangなどの人気のあるフレームワークと統合して、簡単にデプロイすることができます。

python -m vllm.entrypoints.openai.api_server --model Qwen/Qwen1.5-7B-Chat

ローカルで実行: ローカルで実行する場合は、提供されるllama.cppサポートまたはHugging FaceモデルハブからGGUF量子化モデルを使用してください。

Webデモの作成: インタラクティブな体験に適したテキスト生成ウェブUIを使用して、ローカルのWebデモを設定します。

上級開発者と下流アプリケーション:

高度な開発のために: ポストトレーニングなどのより複雑なタスクを実行したい場合、Qwen 1.5はHugging Face TrainerとPeftをサポートしています。LLaMA-FactoryやAxolotlなどのフレームワークも、教師ありファインチューニングやアライメント技術を容易にします。

下流アプリケーション: Qwen 1.5は、さまざまなアプリケーションで使用できるほど汎用性があります。

OpenAI-APIと互換性のあるAPIおよびローカルモデルは、LlamaIndex、LangChain、CrewAIなどのフレームワークと統合するために構築することができます。

例: vLLMを使用した展開

# vLLMを使用してAPIサーバーを起動

python -m vllm.entrypoints.openai.api_server --model Qwen/Qwen1.5-7B-Chat

# curlを使用してモデルとのやり取りを行う

curl http://localhost:8000/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "Qwen/Qwen1.5-7B-Chat",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Tell me something about large language models."}

]

}'

llama.cppを使用してローカルでQwen 1.5を実行する

- ローカル実行のために、llama.cppはQwen 1.5をサポートするように更新され、簡単に量子化モデルを利用することができます。

./main -m qwen1.5-7b-chat-q2_k.gguf -n 512 --color -i -cml -f prompts/chat-with-qwen.txt

Ollamaを使用してQwen 1.5を実行する

- Ollamaのサポートにより、モデルの実行は単一のコマンドラインで簡単に行うことができます:

ollama run qwen

Webデモの構築

- Webベースのデモを作成する場合、テキスト生成ウェブUIが推奨されます。使いやすさと対話性に優れています。

Qwen 1.5でのトレーニング

- モデルのトレーニングや微調整を行いたい場合は、Qwen 1.5はHugging Face TrainerとPeft、LLaMA-Factory、Axolotlといった高度なトレーニング技術とも互換性があります。

結論

Qwen 1.5は、AIコミュニティが先端的な言語モデルの開発、展開、統合を行う能力を大きく前進させるものです。さまざまなプラットフォームとフレームワークへの包括的なサポートと開発者エクスペリエンスへの注力により、Qwen 1.5はAIの領域で新たなイノベーションと応用の波を引き起こすことになるでしょう。研究者、開発者、AI愛好家のいずれであっても、Qwen 1.5は言語モデルの可能性を広げるためのツールと機能を提供しています。

Anakin AI