OpenLLMへの導入

人工知能の急速な進展の中で、言語モデルは数多くのアプリケーションにおいて理解と相互作用を促進する重要なツールとして注目されています。オープンソースのフレームワークであるOpenLLMを使用することで、開発者は大規模な言語モデルの力を効率的に活用することができます。さらに、LangChainと組み合わせることで、言語に基づくアプリケーションの作成を容易にするライブラリを使用することで、OpenLLMの潜在能力を大幅に向上させることができます。この記事では、OpenLLMをLangChain環境内で使用するための基本事項についてご紹介します。インストールから最初の言語アプリケーションの構築までをカバーします。

要約

- 必要なパッケージのインストール: pipを使用してLangChainとOpenLLMをインストールします。

- OpenLLMの初期設定: PythonスクリプトでOpenLLMをAPIキーと共にセットアップします。

- LangChainの設定: LangChainで言語モデルとしてOpenLLMを統合します。

- アプリケーションの構築と実行: チャットボットなどのシンプルな言語アプリケーションを作成して実行します。

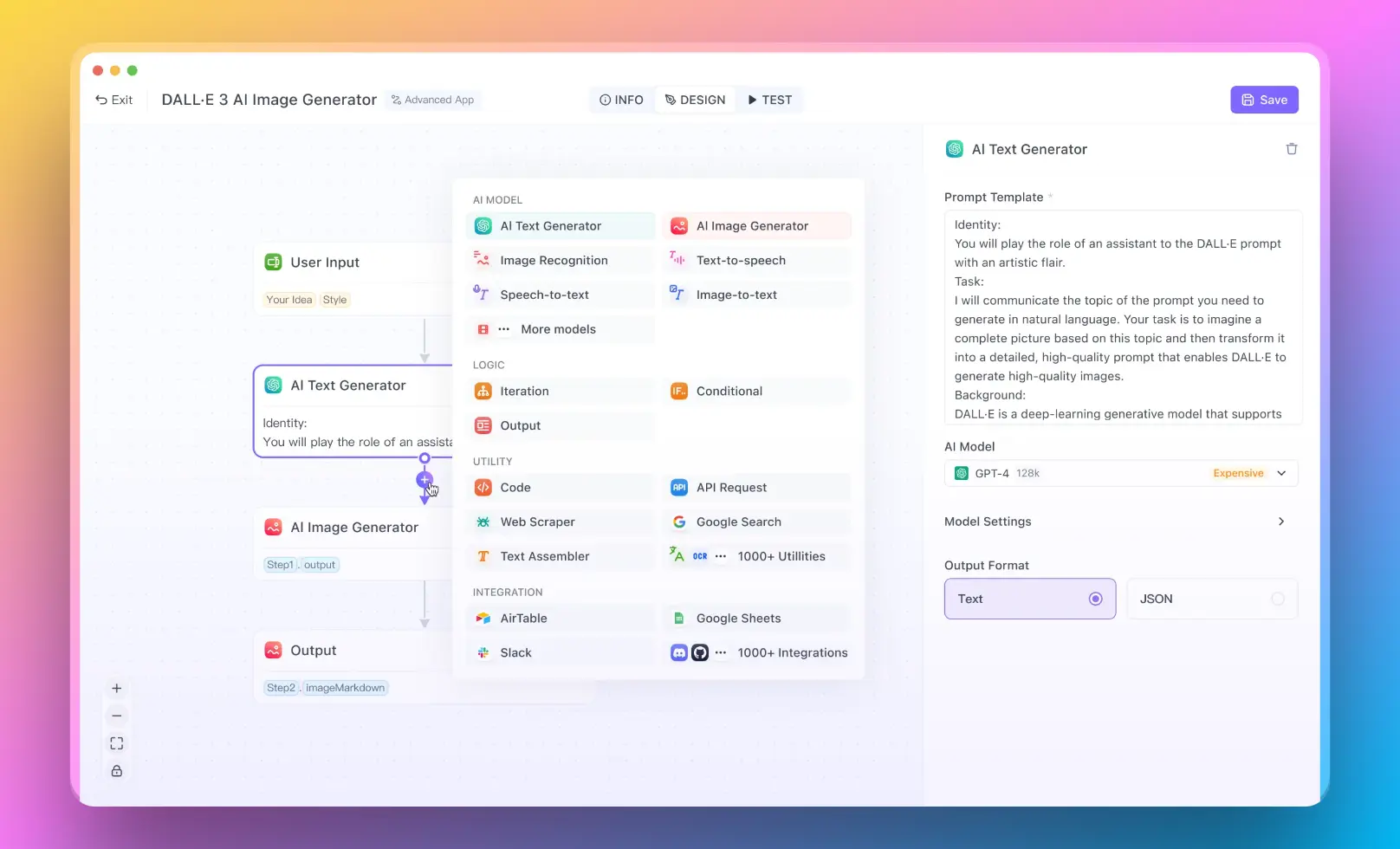

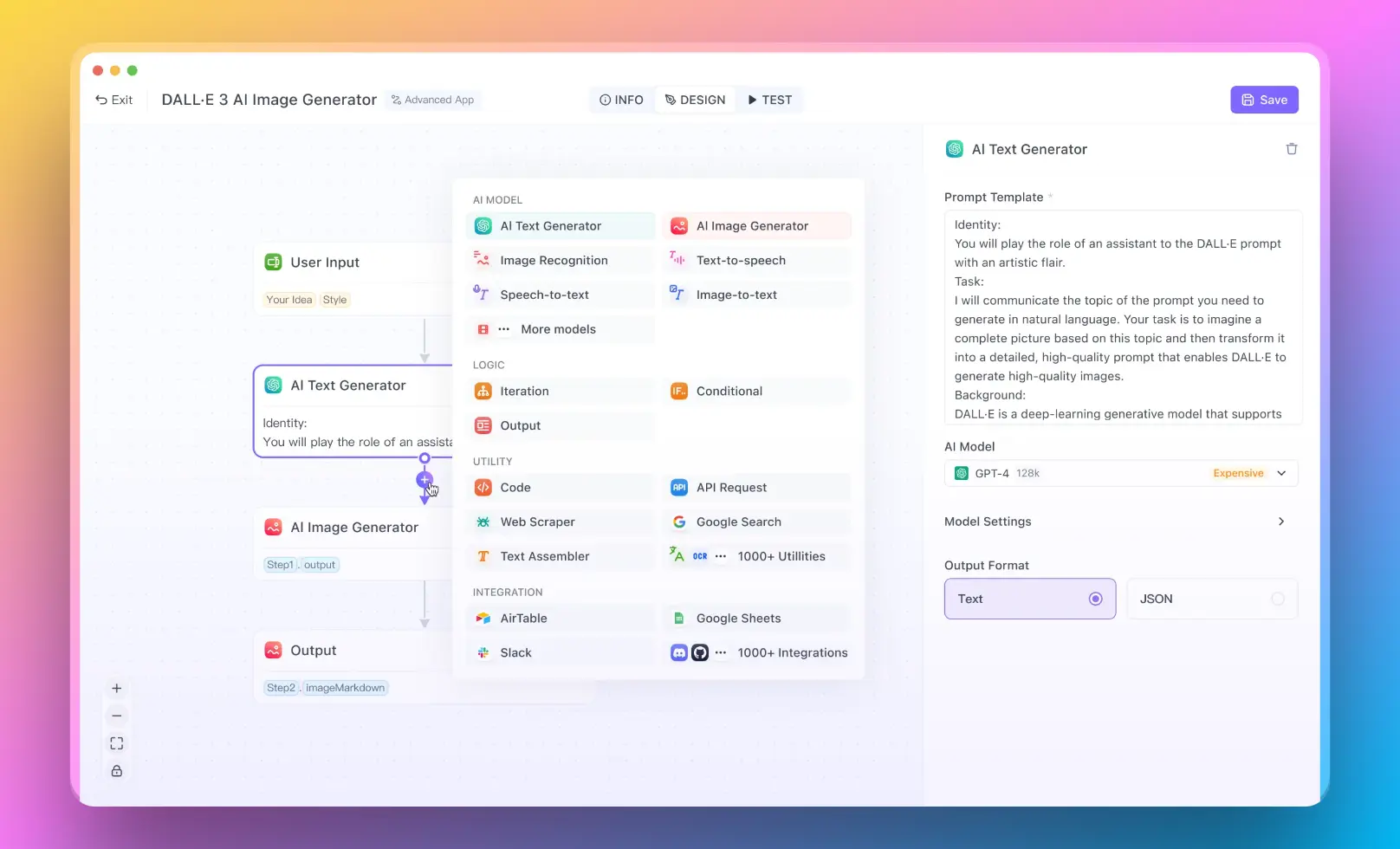

- コーディングの経験がないユーザー向けに、コードを書かずにRAGシステムを実行する場合は、Anakin AIで試してみることができます。No Code Builderを使用して素晴らしいAIアプリを作成できます!

OpenLLMの使用目的

OpenLLMは、AIや機械学習の領域で複数の目的で使用されます。主な使用目的は以下のとおりです:

- テキストベースのアプリケーションにテキストの要約、質問応答、言語翻訳などの機能を組み込むこと。

- 特定のニーズや業界に合わせてカスタマイズされた言語モデルを開発するための基盤を提供すること。

- 研究者や開発者が大規模な言語モデルをより効率的に試験し、展開することを可能にすること。

LangChainでChatOpenAIを使用する方法

LangChainは、特に対話目的のAIを活用する言語ベースのアプリケーションの開発をスムーズにするためのパワフルなライブラリです。ChatOpenAIを統合することで、OpenAIの対話モデルと連携して対話型AIシステムの展開と管理を大幅に簡素化することができます。このガイドでは、LangChain内でChatOpenAIを統合するための手順を詳しく説明します。環境のセットアップからチャットセッションの実行までをカバーします。

ステップ1:環境のセットアップ

ChatOpenAIの統合に入る前に、開発環境の準備が重要です。これにはPythonがシステムにインストールされていることが含まれます。Python 3.7以上のバージョンを推奨します。また、依存関係の管理や他のPythonプロジェクトとの競合を避けるために、仮想環境のセットアップが良い習慣です。

# 仮想環境の作成

python -m venv langchain-env

# 仮想環境を有効化

# Windowsの場合

langchain-env\Scripts\activate

# UnixまたはMacOSの場合

source langchain-env/bin/activate

ステップ2:LangChainのインストール

環境が整ったら、次のステップはLangChainのインストールです。LangChainは、Pythonのパッケージインストーラであるpipを使用して簡単にインストールすることができます。以下のコマンドを実行する前に、仮想環境が有効化されていることを確認してください。

pip install langchain

このコマンドは、LangChainとその依存関係をダウンロードしてインストールします。

ステップ3:ChatOpenAIのインポート

LangChainがインストールされたら、ChatOpenAIをプロジェクトにインポートすることができます。ChatOpenAIは、LangChain内部でOpenAIの対話モデルと連携するためのクラスです。以下のようにインポートします:

from langchain.chat_openai import ChatOpenAI

このコード行により、ChatOpenAIクラスがスクリプトで利用可能になり、その機能を利用することができます。

ステップ4:ChatOpenAIの設定

ChatOpenAIを使用するには、OpenAIのAPIキーを使用して初期化する必要があります。このキーにより、アプリケーションはOpenAIのAPIと通信し、言語モデルを使用することができます。次の方法でChatOpenAIを初期化できます:

# OpenAIのAPIキーを使用してChatOpenAIを初期化

chat_openai = ChatOpenAI(api_key="ここにOpenAIのAPIキーを入力してください")

"ここにOpenAIのAPIキーを入力してください"を実際のOpenAIのAPIキーに置き換えてください。このステップは、OpenAIのサービスへのリクエスト認証に重要です。

ステップ5:会話の作成

ChatOpenAIを設定したら、会話のロジックを処理する関数を作成する準備が整いました。この関数は、ユーザーの入力を受け取り、モデルに送信し、モデルの応答を表示します。以下は簡単な例です:

def start_conversation():

while True:

user_input = input("You: ")

if user_input.lower() == "quit":

break

response = chat_openai.generate_response(user_input)

print("AI:", response)

この関数は、ユーザーがメッセージを入力し、AIが応答するインタラクティブなループを作成します。"quit"と入力することで会話を終了できます。

ステップ6:チャットの実行

セットアップをテストし、ChatOpenAIを実際に使用して確認するには、単純にstart_conversation関数を呼び出すだけです:

# 会話の開始

start_conversation()

このスクリプトをターミナルまたはコマンドプロンプトで実行すると、AIモデルとの対話セッションが開始され、対話することができます。

例:フィードバック収集ボットの構築

この例では、LangChainとChatOpenAIを使用してフィードバック収集ボットを作成します。このボットは、ユーザーと対話し、サービスに対するフィードバックを収集し、フィードバックの感情に基づいて適切な応答を返します。この例では、基本的な感情分析の形式が使用されていますが、洗練された感情分析を行うための基本的なステップが示されています。

- コーディングの経験がないユーザー向けに、コードを書かずにRAGシステムを実行する場合は、Anakin AIで試してみることができます。No Code Builderを使用して素晴らしいAIアプリを作成できます!

フィードバック収集ボットは、ビジネスが顧客と関わり、サービスについての貴重な洞察を収集するためのシンプルで効果的なツールです。フィードバックの感情を分析することで、ボットは応答を分類し、問題をエスカレートしたり、ポジティブなコメントを強調したりすることができます。この即時の対話は、顧客満足度を向上させ、サービスの改善に向けたリアルタイムのデータを提供することができます。

ステップごとの実装

ステップ1:ボットのセットアップ

まず、前のセクションで説明したように、LangChainとChatOpenAIが適切にインストールされ、設定されていることを確認してください。次に、ボットのコーディングを開始できます:

from langchain.chat_openai import ChatOpenAI

# OpenAIのAPIキーを使用してChatOpenAIを初期化

chat_openai = ChatOpenAI(api_key="ここにOpenAIのAPIキーを入力してください")

ステップ2:対話ロジックの作成

フィードバックボットのコアは、ユーザーと対話し、その入力を分析する能力です。以下に、対話ロジックを実装する方法を示します:

def feedback_bot():

print("こんにちは!本日のサービス体験はいかがでしたか?")

while True:

feedback = input("フィードバック: ")

if feedback.lower() == "quit":

break

analyze_feedback(feedback)

この関数は、会話を開始し、ユーザーが"quit"と入力するまで、ユーザーからのフィードバックを継続的に収集します。

ステップ3:フィードバックの分析

この例では、基本的なキーワード検索を使用して感情を判断していますが、LangChainやOpenAIを介して利用可能なより高度な自然言語処理技術を統合することで、これを拡張することができます。

def analyze_feedback(feedback):

# キーワードに基づいた感情分析

positive_keywords = ["great", "excellent", "good", "fantastic", "happy"]

negative_keywords = ["bad", "poor", "terrible", "unhappy", "worst"]

if any(word in feedback.lower() for word in positive_keywords):

print("AI: それは素晴らしいです!フィードバックありがとうございます。")

elif any(word in feedback.lower() for word in negative_keywords):

print("AI: それは残念です。改善に取り組みます。")

else:

print("AI: フィードバックありがとうございます。常に改善に努めています。")

この関数は、特定のキーワードの存在をチェックしてフィードバックの感情を評価します。肯定的なキーワードと否定的なキーワードで、それぞれ対応する応答がトリガされます。

高度な感情分析でボットを強化する

フィードバックボットをより強力で洞察力のあるものにするために、高度な感情分析モデルを統合することができます。LangChainを使用すると、テキストをより深く解析することができるさまざまな言語モデルを簡単に組み込むことができます。これにより、単純なキーワード検索よりもニュアンスやコンテキストをより正確に理解できます。たとえば、OpenAIのGPTモデルを使用して感情をより正確に解釈し、フィードバックのコンテキストに基づいてより個別化された応答を生成することができます。

OpenLLMを実行できない場合は、Pythonのバージョンを確認してください

OpenLLMは、Python 3.7以降と互換性があるように設計されています。OpenLLMとLangChainを使用する際に互換性の問題が発生しないようにするために、Python環境がこの要件を満たしていることを確認することが重要です。

Pythonのバージョンを確認する

ターミナルで以下のコマンドを実行することで、現在のPythonのバージョンを確認できます:

python --version

バージョンが3.7未満の場合、OpenLLMを効果的に使用するためにはPythonを新しいバージョンに更新する必要があります。

結論

LangChainのOpenLLMは、アプリケーションに大規模な言語モデルを活用するための強力なツールキットです。上記の手順に従ってOpenLLMをプロジェクトに統合することで、高度な言語処理機能を備えたアプリケーションを開発することができます。チャットボット、テキスト要約ツール、その他の言語に基づくアプリケーションを構築する場合に必要なツールをOpenLLMとLangChainが提供します。