最新かつ最もパワフルな言語モデルであるLlama 3は、Metaから発表され、AIの世界に大きな影響を与えています。その印象的な能力とオープンソースの性質から、開発者、研究者、AI愛好家の間で非常に求められるツールとなりました。ただし、このような大規模で複雑なモデルを実行することは、特にこの分野が初めての人にとっては困難な作業です。そこでOllamaが登場します。Ollamaは、Llama 3の実行とやり取りのプロセスを簡素化するために設計された使いやすいプラットフォームです。

この包括的なガイドでは、Ollamaを使用してLlama 3を実行する手順をステップバイステップで説明し、インストールから高度な機能までをカバーします。また、Anakin AIのAPIを統合する方法も探求します。これにより、Llama 3とのエクスペリエンスがさらに向上し、AIプロジェクトに新たな可能性が広がります。

Llama 3の理解

Ollamaを使用してLlama 3を実行する前に、Llama 3が何であり、なぜそれがAIの世界に革新をもたらすのかを理解しましょう。

Llama 3は、FacebookやInstagramなどのソーシャルメディアプラットフォームを手がけるMetaによって開発された大規模な言語モデルです。Llama 2という非常に成功したモデルの後継機であり、以下の改良点を備えています。

より大規模なトレーニングデータセット: Llama 3は、先代よりも7倍大きなデータセットでトレーニングされており、より広範な知識と言語パターンを捉えることができます。

増加したコンテキストの長さ: 8Kトークンのコンテキスト長により、Llama 3はより長いテキストシーケンスを処理・理解することができるため、文書の要約や質問応答など、包括的なコンテキストが必要なタスクに適しています。

効率的な言語エンコーディング: Llama 3は128Kのトークン語彙を使用し、言語をより効率的かつ正確にエンコードします。

リファサルの低減: Llama 2と比較して、Llama 3はプロンプトを提示された際の虚偽の「拒否」が3分の1未満であり、より信頼性と応答性が高くなっています。

これらの驚くべき改良により、Llama 3はテキスト生成、翻訳、要約、質問応答など、さまざまな自然言語処理タスクにおいて強力なツールとなりました。

Ollamaの紹介

Ollamaは、Llama 3などの大規模な言語モデルを実行しやすくするために設計されたオープンソースのプラットフォームです。ユーザーフレンドリーなインターフェースと一連のツールを提供し、これらのモデルのダウンロード、設定、実行のプロセスを簡素化します。

Ollamaの最も重要な機能の一つは、クラウドコンピューティングリソースの高額な使用料金を回避するために、モデルをローカルマシンで実行できることです。これにより、費用を節約するだけでなく、データのプライバシーとセキュリティを保護することができます。

OllamaはLlama 3を含むさまざまなモデルをサポートし、テキスト生成や質問応答など、さまざまなユースケースに最適化された異なるバージョンを提供しています。また、コマンドラインインターフェース(CLI)とAPIも提供されており、Llama 3を独自のアプリケーションやワークフローに統合することができます。

Ollamaのインストール

Ollamaを使用してLlama 3を実行するための最初のステップは、マシンにプラットフォームをインストールすることです。OllamaはWindows、macOS、Linuxなど、すべての主要なオペレーティングシステムをサポートしています。

Windowsのインストール

Windowsユーザー向けに、Ollamaはインストールプロセスを案内するシンプルなインストーラを提供しています。以下はWindowsにOllamaをインストールする方法です:

- Ollamaウェブサイト(https://ollama.com)にアクセスし、[ダウンロード]セクションに移動します。

- [Windows]ボタンをクリックしてインストーラをダウンロードします。

- ダウンロードが完了したら、インストーラを実行し、画面の指示に従います。

- インストールプロセス中に、追加の依存関係やコンポーネントのインストールを求められる場合があります。指示に従ってインストールを完了します。

macOSのインストール

macOS上でOllamaをインストールするのも同様に簡単です。以下はその手順です:

- Ollamaウェブサイト(https://ollama.com)にアクセスし、[ダウンロード]セクションに移動します。

- [macOS]ボタンをクリックしてインストーラをダウンロードします。

- ダウンロードが完了したら、インストーラパッケージをダブルクリックしてインストールプロセスを開始します。

- 画面の指示に従ってインストールを完了します。

Linuxのインストール

Linuxユーザー向けには、パッケージマネージャやソースコードからの手動インストールといったさまざまなインストール方法を提供しています。以下にUbuntu上でOllamaをインストールする例を示します(aptパッケージマネージャを使用):

ターミナルウィンドウを開きます。

以下のコマンドを実行してパッケージリストを更新します:

sudo apt update

以下のコマンドを実行して必要な依存関係をインストールします:

sudo apt install -y software-properties-common

以下のコマンドを実行して、Ollamaリポジトリをシステムのソースリストに追加します:

sudo add-apt-repository ppa:ollama/stable

リポジトリが有効になったら、次のコマンドでOllamaをインストールします:

sudo apt install ollama

インストールが完了したら、次のコマンドを実行してインストールを確認できます:

ollama --version

これにより、システムにインストールされたOllamaのバージョンが表示されます。

Ollamaがマシンにインストールされたので、Llama 3の実行の準備が整いました。

Ollamaを使用してLlama 3を実行する

Ollamaを使用してLlama 3を実行するのは簡単なプロセスです。それは、Ollamaの使いやすいインターフェースとコマンドラインツールのおかげです。

Llama 3のダウンロード

Llama 3を実行する前に、モデルファイルをダウンロードする必要があります。Ollamaは、モデルのダウンロードと管理のための便利なコマンドラインツールを提供しています。

マシン上でターミナルまたはコマンドプロンプトを開きます。

次のコマンドを実行してLlama 3をダウンロードします:

ollama pull llama3

このコマンドにより、Llama 3のモデルファイルがマシンにダウンロードされます。インターネット接続の速度やモデルのサイズによっては、このプロセスには時間がかかる場合があります。

ターミナルでのLlama 3の実行

モデルファイルがダウンロードされたら、Llama 3をターミナルまたはコマンドプロンプトから直接実行できます。以下はその方法です:

マシン上でターミナルまたはコマンドプロンプトを開きます。

次のコマンドを実行してLlama 3を起動します:

ollama run llama3

このコマンドにより、Llama 3モデルがメモリに読み込まれ、インタラクティブなセッションが開始されます。

これでターミナルに入力することでLlama 3とやり取りすることができます。たとえば、特定のトピックに関するテキストの生成、文書の要約、または質問に答えるようLlama 3に依頼することができます。

Human: フランスの首都は何ですか?

Llama 3: フランスの首都はパリです。

インタラクティブなセッションを終了するには、/exitを入力するか、Ctrl+Cを押します。

Ollama WebインターフェースでのLlama 3の実行

コマンドラインインターフェースに加えて、Ollamaはより使いやすいWebベースのインターフェースも提供しており、Llama 3とやり取りすることができます。

- Webブラウザを開き、

http://localhost:8080に移動します。 - OllamaのWebインターフェースが表示されます。提示された場合、新しいアカウントを作成するか、既存の資格情報でログインします。

- ログインすると、利用可能なモデルのリストが表示されます。リストから「Llama 3」を選択します。

- テキストボックスにプロンプトやクエリを入力し、「送信」ボタンをクリックすることで、Llama 3とやり取りを開始できます。

- Llama 3の応答はチャットウィンドウに表示されるため、モデルと自然な対話をすることができます。

Ollama Webインターフェースは、会話の保存とロード、モデル設定の調整、ドキュメンテーションや実例へのアクセスなど、追加の機能も提供しています。

Anakin AIのAPIを使用してAIアプリを構築する

Ollamaは、Llama 3を実行するためのパワフルで使いやすいプラットフォームを提供しますが、Anakin AIのAPIを統合することで、エクスペリエンスをさらに向上させ、AIプロジェクトに新たな可能性を開くことができます。

それならAnakin AIを見逃してはいけません!

Anakin AIは、ノーコードのアプリビルダーを使ったワークフロー自動化のオールインワンプラットフォームで、Llama 3、Claude、GPT-4、Uncensored LLMs、Stable Diffusionなどを使って簡単にパワフルなAIアプリを作成することができます!

Anakin AIで夢のAIアプリを数分で、数週間ではなく構築しましょう!

Anakin AIは、開発者や組織がAnakin AIのAPIを使用してプロジェクトをシームレスに統合し、プロジェクトにAnakin AIの強力な機能を取り込むことができる包括的なAPIサービスを提供しています。これらのAPIを利用することで、ユーザーは自分自身のアプリケーション内でAnakin AIの堅牢な製品機能に簡単にアクセスする柔軟性を得ることができます。

Anakin AIとのAPI統合の利点

Llama 3とOllamaにAnakin AIのAPIを統合することは、次のような利点があります:

迅速な開発:Anakin AIの直感的なビジュアルインターフェースを使用して、ビジネスニーズに合わせたAIアプリケーションを迅速に開発できます。リアルタイムの実装は、すべてのクライアントに対して行われます。

モデルの柔軟性:Anakin AIは、複数のAIモデルプロバイダーをサポートしており、必要に応じてプロバイダーを切り替えられます。

事前パッケージ化された機能:AIモデルの基本機能に事前にアクセスできるため、開発プロセスがスムーズに行われます。

将来対応:APIを介して利用可能な次世代の高度な機能により、新機能について先行して利用することができます。

Anakin AIのAPIの使用方法

Llama 3とOllamaでAnakin AIのAPIを使用するには、以下の手順に従ってください:

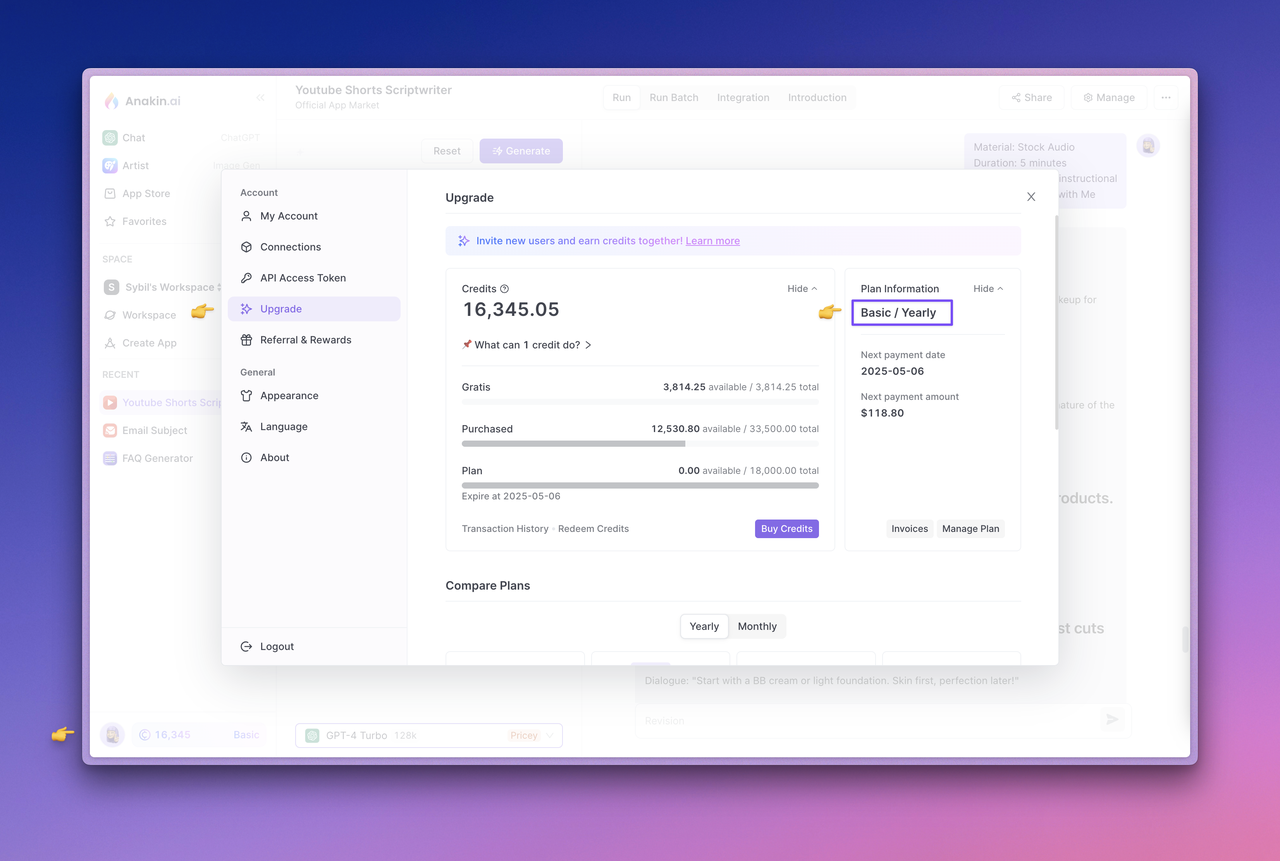

プランをアップグレードし、アカウントのクレジットを確認する:Anakin AIのAPIサービスは現在、購読者専用です。API呼び出しを介してAIモデルを使用する間は、アカウントの残高からクレジットが消費されます。サブスクリプションのステータスを確認したり、プランをアップグレードするには、Anakin AI Webアプリに移動し、左下隅にあるアバターをクリックしてアップグレードページにアクセスします。現在のアカウントに十分なクレジットがあることを確認してください。

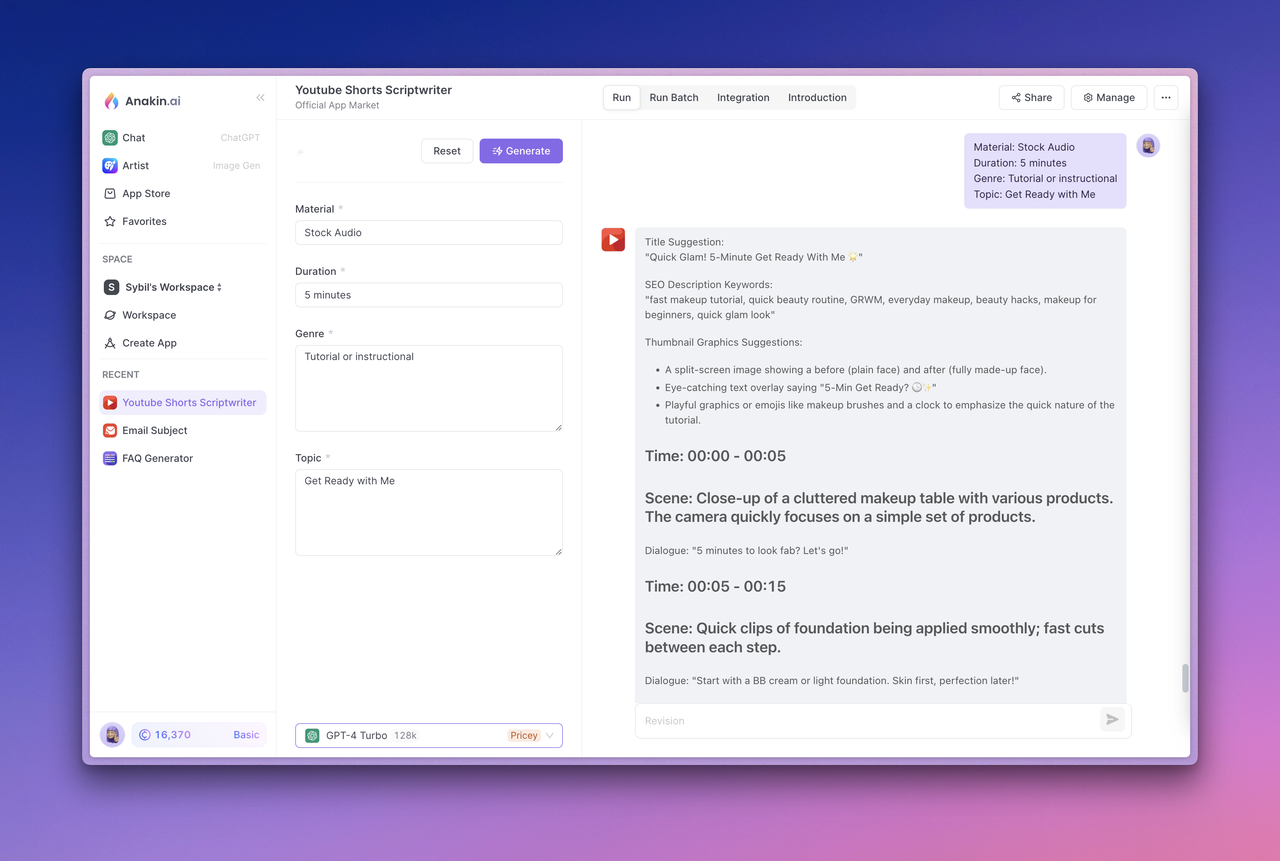

アプリをテストする:使用するアプリを選択し、「生成」ボタンをクリックします。正常に実行され、期待される出力を生成することを確認してください。

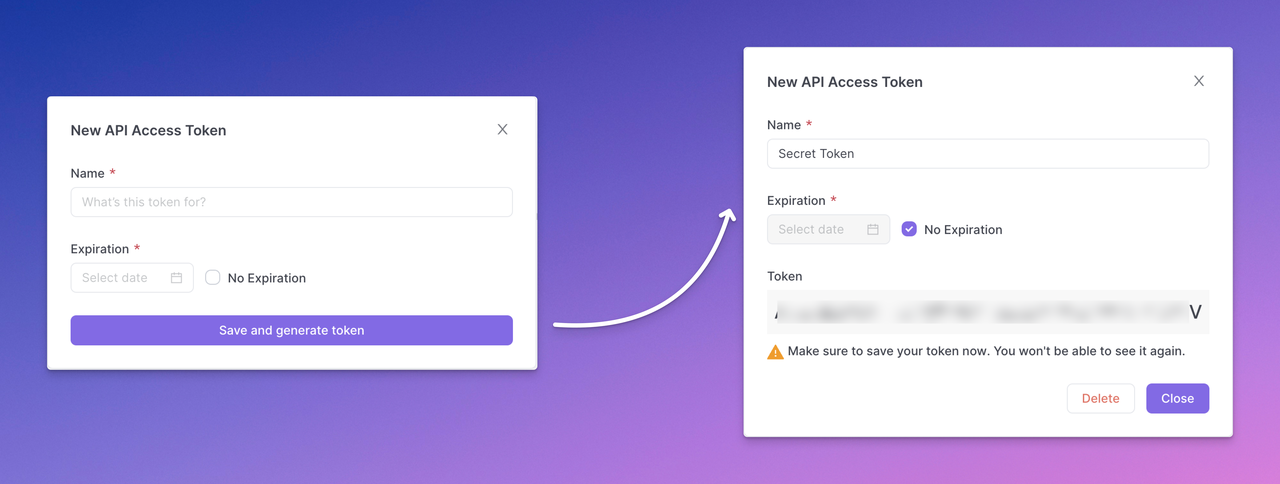

APIドキュメンテーションの表示とAPIアクセストークンの管理:次に、上部にあるアプリケーションの統合セクションに移動します。このセクションでは、Anakin AIが提供するAPIドキュメンテーションを表示したり、アクセストークンを管理したり、アプリIDを表示したりすることができます。

APIアクセストークンの生成:「Manage Token」ボタンをクリックしてAPIアクセストークンを管理し、「New Token」を選択してAPIアクセストークンを生成します。トークンの設定を完了し、「Save and generate token」をクリックし、生成されたAPIアクセストークンをコピーして安全に保存します。

注意:生成されたAPIアクセストークンは一度だけ表示されます。直ちにコピーして安全に保存するようにしてください。APIキーを直接フロントエンドのコードやリクエストに明示的に公開する代わりに、バックエンド呼び出しを通じて平文でAPIキーを公開することは、悪用や攻撃を防ぐためのベストプラクティスです。

APIの使用:APIアクセストークンを手に入れたので、OllamaのワークフローやアプリケーションにAnakin AIのAPIを統合することができます。Anakin AIは、テキスト生成(Quick App)やチャットボットのやり取り(Chatbot App)など、さまざまな使用例に対する詳細なAPIドキュメンテーションとサンプルリクエストを提供しています。

たとえば、Quick App APIを使用してテキストを生成するには、次のようなPOSTリクエストを行います:

curl --location --request POST 'https://api.anakin.ai/v1/quickapps/{{appId}}/runs' \

--header 'Authorization: Bearer ANAKINAI_API_ACCESS_TOKEN' \

--header 'X-Anakin-Api-Version: 2024-05-06' \

--header 'Content-Type: application/json' \

--data-raw '{

"inputs": {

"Product/Service": "Cloud Service",

"Features": "Reliability and performance.",

"Advantages": "Efficiency",

"Framework": "Attention-Interest-Desire-Action"

},

"stream": true

}'

{{appId}}を適切なApp IDで、ANAKINAI_API_ACCESS_TOKENを生成したAPIアクセストークンで置き換えてください。

Llama 3とOllamaにAnakin AIのAPIを統合することで、カスタムアプリケーションの構築から高度なAI機能を備えた既存のワークフローの強化まで、さまざまなAIプロジェクトの可能性が広がります。

高度な機能とユースケース

Llama 3とOllamaで実行し、Anakin AIのAPIを統合することで、AIプロジェクトの強力な基盤が提供されますが、その他にもいくつかの高度な機能とユースケースがあります。これらを探求することで、エクスペリエンスをさらに向上させることができます。

Llama 3の微調整

Llama 3の最も強力な機能の一つは、特定のデータセットやタスクに適用するための微調整能力です。微調整とは、事前にトレーニングされたLlama 3モデルを取り出し、より小さなタスク固有のデータセットでさらにトレーニングするプロセスのことです。このプロセスにより、モデルの特定のタスクに対するパフォーマンスが大幅に向上し、より正確で信頼性の高いモデルになります。

Ollamaでは、独自のデータセットを使用してLlama 3を微調整するためのツールとドキュメントが提供されています。これは、以下のようなタスクに特に役立ちます:

ドメイン固有の言語生成:業界やドメイン固有のデータセット(法的文書、医療報告書、技術マニュアルなど)を使用して、Llama 3を微調整し、より正確かつ関連性のあるテキストを生成します。

感情分析:ラベル付きのレビューやソーシャルメディアの投稿などのデータセットでLlama 3をトレーニングし、感情を正確に検出・分類する能力を向上させます。

固有表現の識別:テキスト内の人物、組織、場所などの固有表現をより正確に特定および分類するために、Llama 3を微調整します。

質問応答:ドメインやユースケースに特化した質問と回答のデータセットを使用して、Llama 3の質問応答タスクに対するパフォーマンスを向上させます。

Llama 3をアプリケーションに統合する

Ollamaは、Llama 3とのやり取りを容易にする便利なインターフェースを提供しますが、モデルを直接独自のアプリケーションやワークフローに統合したい場合もあるかもしれません。Ollamaはそれを可能にします。OllamaのAPIを使用することで、プロンプトやクエリを送信し、モデルの応答を受け取ることができます。これにより、次のようなアプリケーションの構築に役立ちます:

チャットボットや仮想アシスタント:チャットボットや仮想アシスタントアプリケーションにLlama 3を統合し、自然言語理解や生成の機能を提供します。

コンテンツ生成ツール:Llama 3のテキスト生成機能を活用して、執筆、発想、コンテンツ作成などのタスクを支援するツールを作成します。

質問応答システム:Llama 3の知識と理解を活用して、正確に質問に答え、関連する情報を提供するシステムを開発します。

要約や分析ツール:Llama 3の言語理解機能を活用して、長文を要約したり、キーポイントや情報を分析したりするツールを作成します。

他のLlamaモデルの探索

Llama 3はLlamaファミリーの最新かつ最もパワフルなモデルですが、Ollamaでは他のLlamaモデル(Llama 2やLlama 1など)もサポートしています。それぞれのモデルは、特定のタスクやユースケースに応じてより適していることがあります。

たとえば、計算リソースが限られている場合や、メモリのフットプリントが小さいモデルが必要な場合は、Llama 2がより適しているかもしれません。一方、シンプルなテキスト生成や分類タスクなど、Llama 3のフルパワーを必要としないタスクには、Llama 1が役立つ場合があります。

Ollamaは、さまざまなLlamaモデル間を簡単に切り替えることができるため、実験を行い、自分のニーズに最適なモデルを見つけることができます。

まとめ

OllamaでLlama 3を実行し、Anakin AIのAPIを統合することで、AIプロジェクトの可能性が広がります。自然言語処理のタスクからコンテンツ生成まで、このパワフルな組み合わせは、大規模な言語モデルの能力を探求するための堅牢かつ柔軟なプラットフォームを提供します。

この包括的なガイドに従って、Ollamaをインストールし、Llama 3をダウンロードして実行し、Anakin AIのAPIを統合する手順について学びます。さらに、微調整、アプリケーション統合、他のLlamaモデルの探索など、高度な機能についても学びます。

AIのフィールドは急速に進化しており、最新のツールとテクノロジーについて常に最新情報を把握しておくことが重要です。OllamaとAnakin AIは、Llama 3および他の大規模な言語モデルのパワーを活用するためのパワフルかつ使いやすいソリューションを提供し、AIで可能なことの可能性を広げることを可能にします。

さあ、何を待っているのでしょうか?Llama 3とOllamaでの旅を今日始めて、AIプロジェクトの可能性を広げましょう!

それならAnakin AIを見逃してはいけません!

Anakin AIは、ノーコードのアプリビルダーを使ったワークフロー自動化のオールインワンプラットフォームで、Llama 3、Claude、GPT-4、Uncensored LLMs、Stable Diffusionなどを使って簡単にパワフルなAIアプリを作成することができます!

Anakin AIで夢のAIアプリを数分で、数週間ではなく構築しましょう!