急速に進化するAIの登場に伴い、すべての規模のビジネスにとって強力でスケーラブルなモデルの必要性が不可欠となっています。MetaのLlama 3.2 APIは、市場で最も効率的かつ適応性のある言語モデルの一つを提供しており、テキスト専用とマルチモーダル(テキストおよびビジョン)機能の両方があります。会話エージェントやデータ処理システム、マルチモーダルアプリケーションを構築している場合でも、Llama 3.2 APIは最高のパフォーマンスを提供します。ただし、特定のユースケースにおける価値を最大化するためには、価格構造を理解することが重要です。

この資料では、Llama 3.2 APIの価格モデルを分解し、地域別の例を示し、特定の入力および出力に対するトークン消費に関する洞察を提供します。

特別な注意: Anakin.ai上のLlama 3.2: 柔軟なアクセスでAIの潜在能力を解放する

Anakin.aiLlama 3.2Anakin.aiLlama 3.2

Anakin.ai

Llama 3.2

シームレスな統合:テキスト要約画像キャプショニング視覚推論

スケーラブルな使用:

Anakin.aiLlama 3.2今日、Anakin.aiでLlama 3.2を試してみてください

Llama 3.2 API 価格概要

Llama 3.2 APIの価格は、トークン使用量に基づいて設計されています。トークンは単語の一部を表し、通常は英語で1から4文字です。価格は入力トークンと出力トークンに分かれ、モデルサイズや運用地域によって異なるレートが適用されます。

- 入力トークンは、リクエストでモデルに送信するトークンです。

- 出力トークンは、リクエストに対してモデルが生成するトークンです。

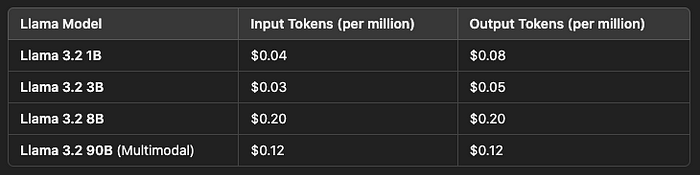

Metaおよびそのパートナーは、百万トークンあたりのUSDの観点から価格設定を提供しています。価格構造は、Llamaモデルによって異なり、そのサイズや能力に基づいています。

以下は、いくつかのモデルの価格詳細です:

Llama 3.2をアプリケーションに統合したい企業にとって、この柔軟な価格モデルは、小規模および大規模企業アプリケーションの両方にとってスケーラブルです。

地域別価格の変動

API価格は地域によって異なる場合があり、主にインフラコスト、データセンター、および運用コストによるものです。Together AIやAmazon Bedrockなどのプロバイダーは、地域に特化した価格設定でLlama 3.2 APIを提供しています。

以下は地域の価格設定の例です:

Together AIの価格設定:

Llama 3.2 Turbo (3B):

- 入力および出力トークン: 100万トークンあたり$0.06

Llama 3.2 Reference (8B):

- 入力および出力トークン: 100万トークンあたり$0.20

- 地域: 北米、欧州、アジア太平洋

Amazon Bedrockの価格設定:

- Llama 3.2 APIモデルは、複数のAWSリージョンで利用可能です。地域によって価格が変動する場合があり、リージョンをまたぐ推論が遅延とコストに影響を与える可能性があります。

- AWS 米国東部: 標準料金が適用されます。

- AWS EU西部: 高いインフラコストにより追加料金が発生する可能性があります。

Llamaモデルのトークン価格は一般的に似た範囲内に収まりますが、地域的なコストはインフラ投資やデータの居住要件などの要因によって変動することがあります。

プロバイダー固有の機能

さまざまなクラウドプロバイダーやAPIプラットフォームは、基本的なトークン価格を超えるユニークな機能を提供するLlama 3.2を提供しています。これらの追加サービスはコストに影響を与える可能性がありますが、スケーラビリティや低遅延といった価値あるメリットも提供します。

Together AI:

- スケーラビリティ: Together AIは、最大9,000リクエスト/分及び500万トークン/分の大規模言語モデルをサポートしています。

- 柔軟な使用: 日次での制限がないため、チャットボットやAI駆動のカスタマーサービスのような高スループットアプリケーションに最適です。

Amazon Bedrock:

- クロスリージョン推論: Bedrockは、開発者が異なるAWSリージョンでLlamaモデルを実行できるようにし、グローバルなスケーラビリティを実現します。

- エンタープライズ統合: AWSのLlamaモデルは、既存のクラウドベースのアプリケーションに簡単に統合できるよう、ファインチューニングやカスタマイズされたデプロイメントツールを提供します。

プロバイダーは、強化されたセキュリティ、カスタムSLA(サービスレベル合意)、およびエンタープライズクライアント向けの専用エンドポイントなどの追加サービスを提供する場合もあります。

トークン消費の具体例

Llama 3.2 APIの価格体系をよりよく理解するために、いくつかのトークン消費の具体例を探ってみましょう。これにより、さまざまなアプリケーションにおける入力/出力トークン使用量に基づいて、どれくらいの支出が期待できるかを示すことができます。

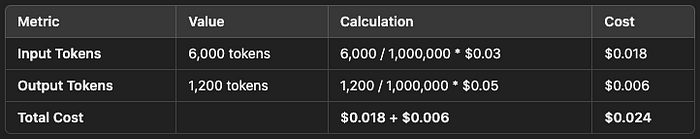

例 1: テキスト要約

- 入力テキストの長さ: 1,500単語(約6,000トークン)

- 出力要約の長さ: 250単語(約1,000トークン)

このタスクの場合:

- 入力トークンコスト: 6,000トークン / 1,000,000トークン * $0.03 = $0.018

- 出力トークンコスト: 1,000トークン / 1,000,000トークン * $0.05 = $0.005

- 合計コスト: $0.018(入力) + $0.005(出力) = $0.023

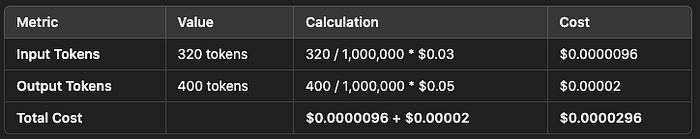

例 2: リアルタイムチャットボット

- ユーザー入力(チャット): 100単語(約400トークン)

- AIの応答: 120単語(約480トークン)

各インタラクションについて:

- 入力トークンコスト: 400トークン / 1,000,000トークン * $0.03 = $0.000012

- 出力トークンコスト: 480トークン / 1,000,000トークン * $0.05 = $0.000024

- インタラクションあたりの合計コスト: $0.000012 + $0.000024 = $0.000036

100,000回のチャットボットインタラクションの場合、コストは:

- 入力コスト: $0.000012 * 100,000 = $1.2

- 出力コスト: $0.000024 * 100,000 = $2.4

- 合計コスト: $1.2 + $2.4 = $3.6

例 3: マルチモーダル画像キャプショニング

- 画像分析の入力: 5画像(約20,000トークン)

- テキスト出力(キャプション): 5つのキャプション(約1,000トークンずつ)

このマルチモーダルタスクの場合:

- 入力トークンコスト: 20,000トークン / 1,000,000トークン * $0.06 = $0.012

- 出力トークンコスト: 5,000トークン / 1,000,000トークン * $0.08 = $0.04

- 合計コスト: $0.012(入力) + $0.04(出力) = $0.052

月に10,000画像を処理するアプリケーションの場合:

- 合計コスト: $0.052 * 10,000 = $520

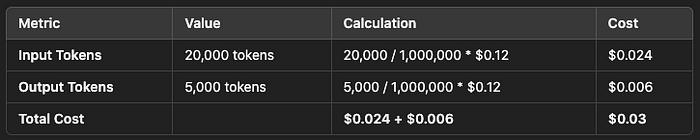

例 4: Llama 3.2 90Bとのマルチモーダル統合

画像およびテキスト処理の入力: 5画像 + 関連テキスト(約20,000トークン)

テキスト出力(キャプション): 5つのキャプション(約1,000トークンずつ)

このマルチモーダルタスクの場合:

- 入力トークンコスト: 20,000トークン / 1,000,000トークン * $0.12 = $0.024

- 出力トークンコスト: 5,000トークン / 1,000,000トークン * $0.12 = $0.006

- 合計コスト: $0.024(入力) + $0.006(出力) = $0.03

月に10,000バッチを処理するアプリケーションの場合:

- 合計コスト: $0.03 * 10,000 = $300

エンタープライズおよびバルク価格オプション

大企業や長期間にわたって高ボリュームの使用を考えている企業は、Metaまたは第三者プロバイダーとカスタム価格モデルを交渉できます。これらの契約では、割引率、専用インフラ、または強化サポートパッケージが提供されることがよくあります。

例えば、毎日1000万トークンを処理する会社は、特にLlama 3.2 Reference (8B)モデルやLlama 3.2 90Bのマルチモーダルモデルを使用している場合、コストを削減するためにカスタム料金を交渉することができます。 ここでLlamaモデルのエンタープライズ価格について詳しく学ぶ.

無料プランとクレジット

多くのプロバイダーは、開発者がLlama 3.2 APIを試してみることを奨励するために無料プランや初期クレジットを提供しています。例えば:

- Together AIは、限られたトークン数でモデルをテストできる無料使用プランを提供しています。

- AWSは、新しいユーザーにクレジットを提供し、これを使用してAmazon BedrockでLlama 3.2モデルを実行できます。

これらの無料プランは、小規模なビジネスや開発者がLlama 3.2のパフォーマンスを大きな予算をかける前にテストするのに最適な方法です。 利用可能な無料プランについて詳しく学ぶ.

マルチモーダル機能とトークン価格

マルチモーダルモデル(テキストとビジョンの両方をサポートするモデル)は、テキスト専用モデルに比べてやや高い価格設定になることに注意が必要です。これは、画像認識や視覚推論タスクに関連する計算の複雑さが増すためです。

例えば、Llama 3.2 90Bのマルチモーダルモデルは次のような価格が設定される可能性があります:

- 入力および出力トークン: 100万トークンあたり$0.12(地域特有)

この価格は、クローズドアクセスAPIや限定ファインチューニングオプションにより、通常料金が高くなる他のマルチモーダルモデルに比べても競争力のあるものです。 価格差について詳しく学ぶ.

結論

Llama 3.2 APIの価格を理解することで、開発者はトークン使用量に基づいてAIプロジェクトを効果的に予算立てできます。小規模アプリケーションを運用している場合でも、大規模なマルチモーダルシステムを実行している場合でも、Llama 3.2は柔軟で競争力のある価格設定を提供します。重要な考慮点には、APIがホストされている地域、特定のユースケースにおけるトークンの要件、およびテキスト専用またはマルチモーダル処理の必要性が含まれます。

小規模アプリケーションの場合、Llama 3.2の1Bおよび3Bモデルは手頃なエントリーポイントを提供します。一方、エンタープライズは8Bまたは90Bのような大規模モデルに対するカスタム価格契約の恩恵を受けることができます。

これらの要因を考慮することで、企業はコストを最適化しながら、さまざまなAI駆動アプリケーションのためにLlama 3.2の完全な力を活用できます。 LlamaのAPI価格についてさらに探索する.

Anakin AIでLlama 3.2を使用する方法: ステップバイステップガイド

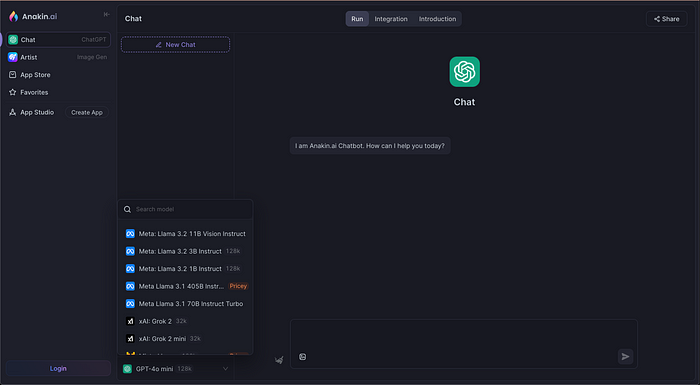

Llama 3.2が何を実現できるかを理解したので、次はどのようにおよびどこで使用できるかを深掘りしましょう。以下の手順に従って、Anakin AIでLlama 3.2を使用開始してください:

ステップ 1: Anakin AIにアクセスする

まず、Anakin AIのチャットプラットフォームにアクセスしてください。ここで、MetaのLlama 3.2や他の先進的なAIモデルにアクセスできます。

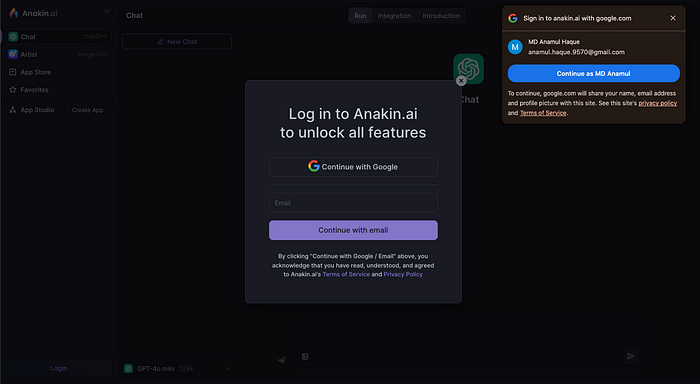

ステップ 2: アカウントを作成する

まだ登録していない場合は、アカウントを作成する必要があります。登録プロセスは迅速で、メールアドレスとパスワードを入力するだけです。登録が完了すれば、プラットフォーム上のすべてのAIモデルにアクセスできるようになります。

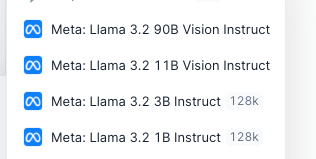

ステップ 3: AIモデルを選択する

モデルセレクションパネルから、ChatGPT、Gemini、Claude、そしてもちろんLlama 3.2などの利用可能なモデルリストを見ることができます。モデルはプロジェクトの複雑さに応じて、Llama 3.2 Vision InstructやLlama 3.2 Turbo Instructなどの異なるバリエーションで提供されています。