所得強化生成(RAG)は、情報検索と言語モデルを組み合わせて高品質な応答を生成するための強力な手法です。LangChainは、大規模な言語モデル(LLM)を使用してアプリケーションを構築するための人気のあるPythonライブラリであり、RAGをプロジェクトにシームレスに実装する方法を提供します。本記事では、RAGとは何か、LangChainでの動作方法、およびその使用によるインテリジェントなチャットボットや質問応答システムの作成方法について説明します。

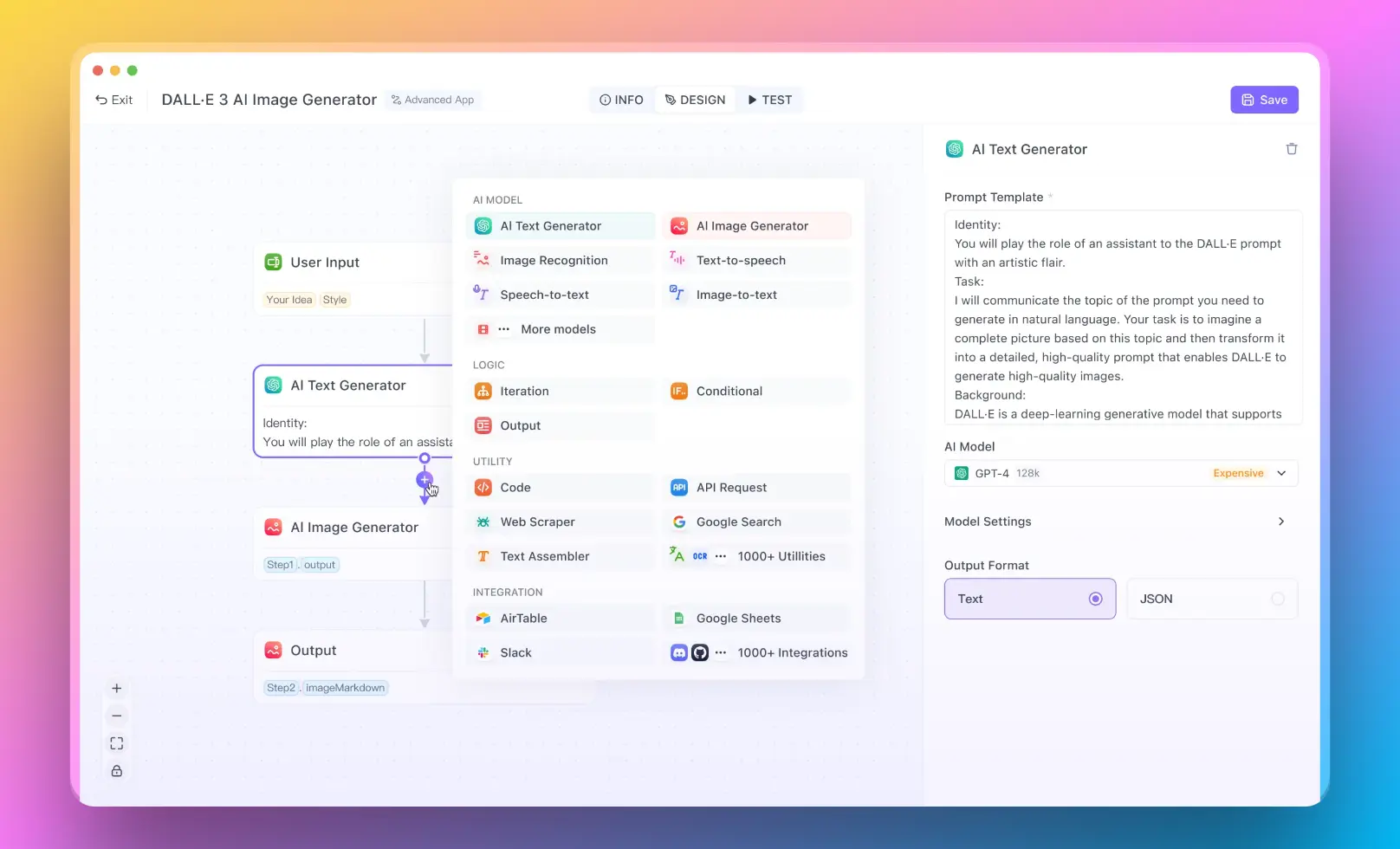

- コーディングの経験がないユーザーのために、Anakin AIを試してみることをお勧めします。ここでは、No Code Builderを使用して素晴らしいAIアプリを作成することができます!

LangChainのRAGとは何ですか?

LangChainのRAGは、外部のソースから関連情報を取り込むことで、LLMの機能を強化するRetrieval Augmented Generationモデルを指します。このモデルにより、モデルは与えられた一連のドキュメントやデータソースから知識を取得して活用し、より正確で文脈に即した応答を生成することができます。

PythonでのRAGモデルの理解

PythonでのRAGモデルは、次の3つの主要なコンポーネントから構成されます:

リトリーバー:リトリーバーは、入力クエリに基づいて関連するドキュメントやパッセージを検索して取得する責任を持ちます。ベクトルの類似検索などの技術を使用して、より関連性の高い情報を見つけます。

ジェネレーター:ジェネレーターは、取得したドキュメントと入力クエリをコンテキストとして受け取り、組み合わせた情報に基づいて応答を生成するLLMです。

コンバイナー:コンバイナーは、取得したドキュメントと生成された応答を組み合わせ、最終的な出力を生成します。結合の方法として、連結や重み付き平均など、さまざまな戦略を使用することができます。

PythonでLangChainのRAGを使用する方法

LangChainでPythonでRAGを使用するには、次の手順に従ってください:

- 必要な依存関係をインストールします:

pip install langchain openai chromadb

テキストファイルやCSVファイルなどの適切な形式に変換することで、データを準備します。

Chromaなどのライブラリを使用して、ベクトルデータベースを作成します:

from langchain.vectorstores import Chroma

documents = [...] # ドキュメントをロードします

vectordb = Chroma.from_documents(documents, embedding=OpenAIEmbeddings())

- ベクトルデータベースを使用してリトリーバーを定義します:

retriever = vectordb.as_retriever(search_kwargs={"k": 3})

- LLMインスタンスを作成します:

from langchain.llms import OpenAI

llm = OpenAI(temperature=0)

- リトリーバーとLLMを組み合わせてRAGモデルを作成します:

from langchain.chains import RetrievalQA

qa = RetrievalQA.from_chain_type(llm=llm, chain_type="stuff", retriever=retriever)

- RAGモデルを使用して応答を生成します:

query = "フランスの首都は何ですか?"

response = qa.run(query)

print(response)

LangChain RAGの応用

LangChain RAG(Retrieval Augmented Generation)は、さまざまなAIアプリケーションに適用することができる強力な技術です。詳細な説明と、始めるためのステップバイステップの手順とサンプルコードスニペットを提供しながら、以下でこれらの応用について詳しく説明します。

LangChain RAGを使用したインテリジェントチャットボットの構築

LangChain RAGの主な応用の1つは、ナレッジベースに基づいて質問に答えることができるインテリジェントなチャットボットの構築です。LangChain RAGを使用してチャットボットを作成する方法は以下の通りです:

関連ドキュメントやデータソースを収集してナレッジベースを準備します。

テキストファイルやCSVファイルなどの適切な形式にドキュメントを変換します。

Chromaなどのライブラリを使用してベクトルデータベースを作成します:

from langchain.vectorstores import Chroma

from langchain.embeddings import OpenAIEmbeddings

documents = [...] # ドキュメントをロードします

vectordb = Chroma.from_documents(documents, embedding=OpenAIEmbeddings())

- ベクトルデータベースを使用してリトリーバーを定義します:

retriever = vectordb.as_retriever(search_kwargs={"k": 3})

- LLMインスタンスを作成します:

from langchain.llms import OpenAI

llm = OpenAI(temperature=0)

- リトリーバーとLLMを組み合わせてRAGモデルを作成します:

from langchain.chains import ConversationalRetrievalChain

qa = ConversationalRetrievalChain.from_llm(llm=llm, retriever=retriever)

- チャットボットとの対話のループを実装して、チャットボットと対話します:

chat_history = []

while True:

query = input("ユーザー: ")

if query.lower() == 'exit':

break

result = qa({"question": query, "chat_history": chat_history})

chat_history.append((query, result['answer']))

print(f"アシスタント: {result['answer']}")

LangChain RAGを使用した質問応答システムの作成

LangChain RAGは、カスタマーサポートや技術文書などの特定のドメインにおける質問応答システムの作成に使用することができます。質問応答システムを構築する方法は以下の通りです:

特定のドメインの関連ドキュメントやデータソースを収集して前処理します。

以前の例と同様に、ベクトルデータベースとリトリーバーを作成します。

RAGモデルを使用して質問応答チェーンを定義します:

from langchain.chains import RetrievalQA

qa_chain = RetrievalQA.from_chain_type(llm=llm, chain_type="stuff", retriever=retriever)

- 質問応答チェーンを使用して応答を生成します:

query = "ソフトウェアのシステム要件は何ですか?"

response = qa_chain.run(query)

print(response)

LangChain RAGを使用して要約または説明を生成する

LangChain RAGは、複数のドキュメントから要約や説明を生成するために使用することができます。これを実現する方法は以下の通りです:

ドキュメントコレクションを準備し、前の例と同様にベクトルデータベースとリトリーバーを作成します。

RAGモデルを使用して要約チェーンを定義します:

from langchain.chains import LoadQA

summarization_chain = LoadQA(llm=llm, retriever=retriever)

- 要約チェーンを使用して要約や説明を生成します:

query = "ミーティング議事録で議論された要点について要約してください。"

summary = summarization_chain.run(query)

print(summary)

LangChain RAGを使用して検索機能を強化する

LangChain RAGを使用することで、検索機能をより関連性の高い文脈を持つ結果で強化することができます。検索システムにRAGを統合する方法は以下の通りです:

ドキュメントコレクションを準備し、前の例と同様にベクトルデータベースとリトリーバーを作成します。

RAGモデルを利用する検索機能を定義します:

def search(query):

docs = retriever.get_relevant_documents(query)

context = " ".join([doc.page_content for doc in docs])

response = llm.generate(f"{context}\nQuestion: {query}\nAnswer:", stop=None, max_tokens=100).generations[0].text

return response.strip()

- 検索機能を使用して関連する結果を取得します:

query = "当社の製品の利点は何ですか?"

result = search(query)

print(result)

リトリーバルとジェネレーションの力を活用することで、LangChain RAGは高い精度と関連性を持つユーザークエリに理解して応答するAIアプリケーションを作成することができます。チャットボット、質問応答システム、要約ツール、検索機能の強化など、LangChain RAGは外部の知識を組み込んで文脈に即した出力を生成する柔軟かつ効率的な方法を提供します。

結論

LangChainのRAGは、情報検索と言語モデルを組み合わせて高品質な応答を生成する強力な手法です。LangChainの直感的なAPIとChromaなどのベクトルデータベースとの統合を活用することで、PythonプロジェクトでRAGを簡単に実装することができます。チャットボット、質問応答システム、その他のAIアプリケーションを構築する場合、LangChain RAGは外部の知識を組み込んで文脈に即した出力を生成する柔軟かつ効率的な方法を提供します。

LangChain RAGの力を発揮して、検索強化生成を通じてAIアプリケーションを革新しましょう!