Gemini 1.5 Pro APIは、開発者がGoogleの最先端の言語モデルをアプリケーションに統合することができる強力なツールです。このAPIは、Googleの最新の生成モデルへのアクセスを提供し、テキスト生成、質問応答、画像キャプションなどのさまざまなタスクを実行することができます。この包括的なガイドでは、Gemini 1.5 Pro APIの使用方法について説明します。開発環境の設定から最初のアプリケーションの構築までを手順に沿って説明します。

それなら、Anakin AIを見逃すことはできません!

Anakin AIは、ワークフローの自動化のためのオールインワンプラットフォームであり、使いやすいノーコードアプリビルダーで強力なAIアプリを作成することができます。Llama 3、Claude、GPT-4、Uncensored LLMs、Stable Diffusionなどを使用して、夢のAIアプリを数分で構築しましょう!

ステップ1:APIキーの生成

Gemini 1.5 Pro APIを使用するには、まずGoogle AI for DevelopersページからAPIキーを取得する必要があります。このキーはリクエストの認証を行い、APIへのアクセスを許可します。

- Google AI for Developersのページにアクセスし、Googleアカウントでログインします。

- "APIキーを取得"ボタンをクリックします。

- 新しいプロジェクトを作成するか、既存のプロジェクトを選択するようにプロンプトに従って操作します。

- プロジェクトのセットアップが完了すると、APIキーが提供されます。このキーは、すべてのAPIリクエストで必要となるため、安全に保管してください。

ステップ2:APIライブラリのインストール

Gemini 1.5 Pro APIとの対話を簡素化するために、Googleはさまざまなプログラミング言語用の公式クライアントライブラリを提供しています。このガイドではPythonライブラリを使用しますが、他の言語でも同様の手順があります。

- ターミナルまたはコマンドプロンプトを開きます。

- pipを使用してGemini Python APIパッケージをインストールします:

pip install google-generativeai

- インストールが完了したら、必要なライブラリをPythonスクリプトにインポートします:

import google.generativeai as genai

from google.generativeai.types import ContentType

from PIL import Image

ステップ3:APIキーの設定

APIの呼び出しを行う前に、PythonスクリプトでAPIキーを設定する必要があります:

GOOGLE_API_KEY = 'your-api-key-goes-here'

genai.configure(api_key=GOOGLE_API_KEY)

'your-api-key-goes-here'をStep 1で取得したAPIキーで置き換えてください。

ステップ4:Gemini 1.5 Proモデルへのアクセス

Gemini 1.5 Pro APIは、さまざまなモデルへのアクセスを提供します。各モデルにはそれぞれの機能と特性があります。この例では、Gemini 1.5 Proモデルの最新バージョンであるgemini-1.5-pro-latestモデルを使用します。

model = genai.GenerativeModel('gemini-1.5-pro-latest')

ステップ5:コンテンツの生成

モデルが初期化されたら、Gemini 1.5 Pro APIを使用してコンテンツを生成することができます。APIはテキストのみのプロンプトと、テキストと画像を組み合わせたマルチモーダルプロンプトの両方をサポートしており、リクエストに画像や動画などのメディアを組み込むことができます。

テキストのみのプロンプト

テキストのみのプロンプトからテキストを生成するには、generate_contentメソッドを使用します:

prompt = "魔法のリュックサックについての物語を書いてください。"

response = model.generate_content(prompt)

print(response.text)

これにより、指定したプロンプトに基づいてストーリーが生成され、結果がコンソールに表示されます。

マルチモーダルプロンプト

Gemini 1.5 Pro APIは、テキストと画像を組み合わせたマルチモーダルプロンプトもサポートしています。以下は画像のキャプションを生成する例です:

text_prompt = "画像を詳しく説明してください。"

image = Image.open('example_image.jpg')

prompt = [text_prompt, image]

response = model.generate_content(prompt)

print(response.text)

この例では、まずテキストのプロンプトを定義し、PILライブラリを使って画像ファイルを開きます。次に、テキストのプロンプトと画像をリストに組み合わせて、generate_contentメソッドのプロンプトとして使用します。APIは、指定したプロンプトに基づいて画像の詳細な説明を生成します。

ステップ6:高度な機能の探索

Gemini 1.5 Pro APIには、マルチターンの会話(チャット)、ストリーム形式のレスポンス、埋め込みなど、さまざまな高度な機能が用意されています。これらの機能の詳細をさらに探索しましょう。

マルチターンの会話(チャット)

Gemini APIを使用すると、ユーザーとの対話型チャット体験を作成することができます。チャット機能を使用することで、複数の質問と回答のラウンドを収集し、ユーザーが回答に向けて段階的に作業したり、複数のパートで問題の解決に役立ったりすることができます。

model = genai.GenerativeModel('gemini-1.5-flash')

chat = model.start_chat(history=[])

response = chat.send_message("スノーマンになりきってキャラクターに応じて返答してください。")

print(response.text)

response = chat.send_message("年の中でお気に入りの季節は何ですか?")

print(response.text)

この例では、空の履歴で新しいチャットセッションを開始します。次に、モデルに対して2つのメッセージを送信し、モデルがスノーマンとしてキャラクターに応じて返信します。send_messageメソッドを使用することで、さらにメッセージを送信して会話を続けることができます。

ストリーム形式のレスポンス

Gemini APIでは、生成モデルからのレスポンスをデータストリームとして受け取ることができます。この機能により、モデルが生成したデータの一部をアプリケーションに送り返して、ユーザーのよりインタラクティブな体験を作成することができます。

response = model.generate_content(prompt, stream=True)

for chunk in response.iter_text():

print(chunk, end='')

この例では、generate_contentメソッドを呼び出す際にstreamパラメータをTrueに設定します。その結果、レスポンスはストリームとして返され、iter_textメソッドを使用してレスポンスのチャンクごとに反復処理し、利用可能になるたびに出力します。

埋め込み

Gemini APIは、単語、フレーズ、文のための最新の埋め込みを生成する埋め込みサービスを提供します。これらの埋め込みは、意味検索、テキスト分類、クラスタリングなど、さまざまな自然言語処理のタスクに使用することができます。

from google.generativeai import EmbeddingModel

embedding_model = EmbeddingModel()

text = "これは例の文です。"

embeddings = embedding_model.get_embeddings(text)

print(embeddings)

この例では、EmbeddingModelクラスのインスタンスを作成し、指定したテキストの埋め込みを生成するためにget_embeddingsメソッドを使用しています。生成された埋め込みは、さまざまな後処理のタスクやアプリケーションで使用することができます。

Anakin.aiとのAPI統合

Anakin.aiは、すべてのアプリケーションに対して包括的なAPIサービスを提供し、開発者や組織がAnakin.aiのAPIを活用してプロジェクトをシームレスに統合および強化することができます。これらのAPIを活用することで、ユーザーは独自のアプリケーション内でAnakin.aiの強力な製品機能に簡単にアクセスする柔軟性を得ることができます。

この機能により、開発者や組織は複雑なバックエンドアーキテクチャや展開プロセスの管理の手間をかけることなく、特定のカスタマイズ要件を満たすことができます。その結果、開発コストとワークロードが大幅に削減され、開発者にとって利便性が向上します。

API統合の利点

- Anakin.aiの直感的なビジュアルインターフェースを使用して、ビジネスニーズに合わせたAIアプリケーションを迅速に開発し、リアルタイムですべてのクライアントに実装できます。

- 複数のAIモデルプロバイダーのサポートにより、必要に応じてプロバイダーを切り替える柔軟性があります。

- AIモデルの基本的な機能への事前パッケージ化されたアクセス。

- APIを介した次世代の高度な機能への対応。

Gemini APIをAnakin AIで使用する方法

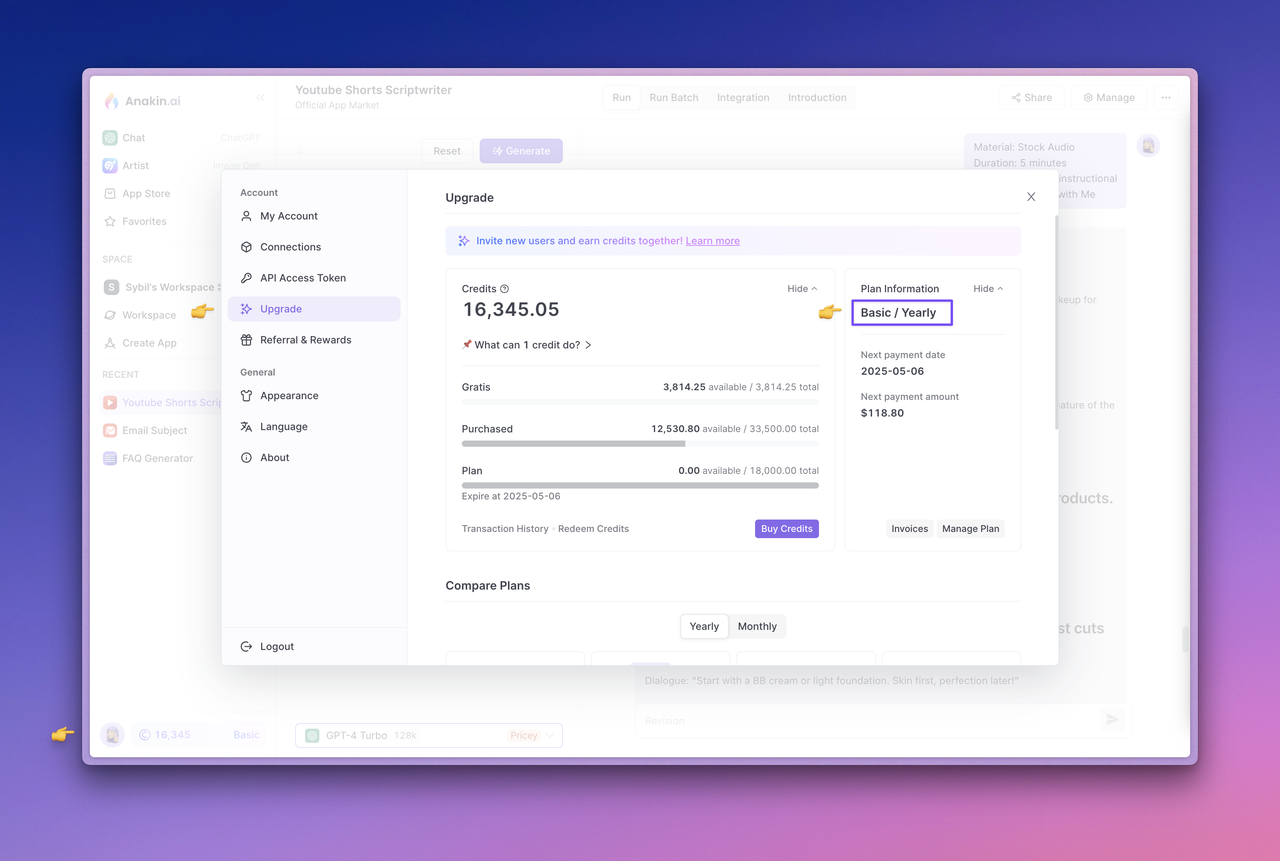

ステップ1:プランのアップグレードとアカウントのクレジットの確認

現在、APIサービスは購読者に限定的に提供されています。API呼び出しを通じてAIモデルを使用する際には、アカウント残高からクレジットが消費されます。サブスクリプションのステータスを確認したり、プランをアップグレードするには、Anakin.aiのWebアプリに移動してください。左下隅にあるアバターをクリックしてアップグレードページにアクセスします。現在のアカウントに十分なクレジットがあることを確認してください。

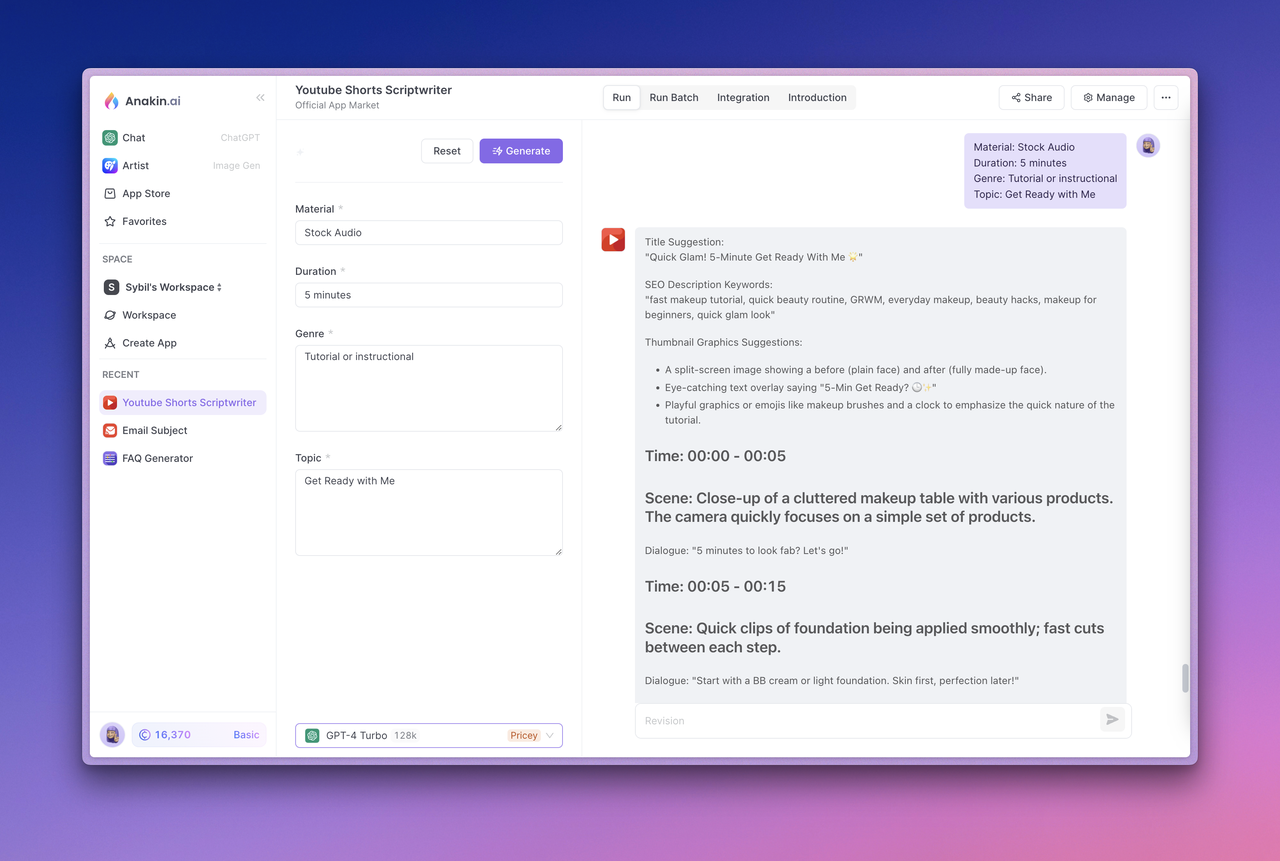

ステップ2:アプリのテスト

アプリをテストするには、アプリを選択してGenerateボタンをクリックします。正常に実行され、予想される出力を生成することを確認してから、次に進んでください。

ステップ3:APIドキュメントの表示とAPIアクセストークンの管理

次に、トップのアプリ統合セクションにアクセスします。このセクションでは、APIドキュメントの表示、アクセストークンの管理、およびアプリIDの表示などが行えます。

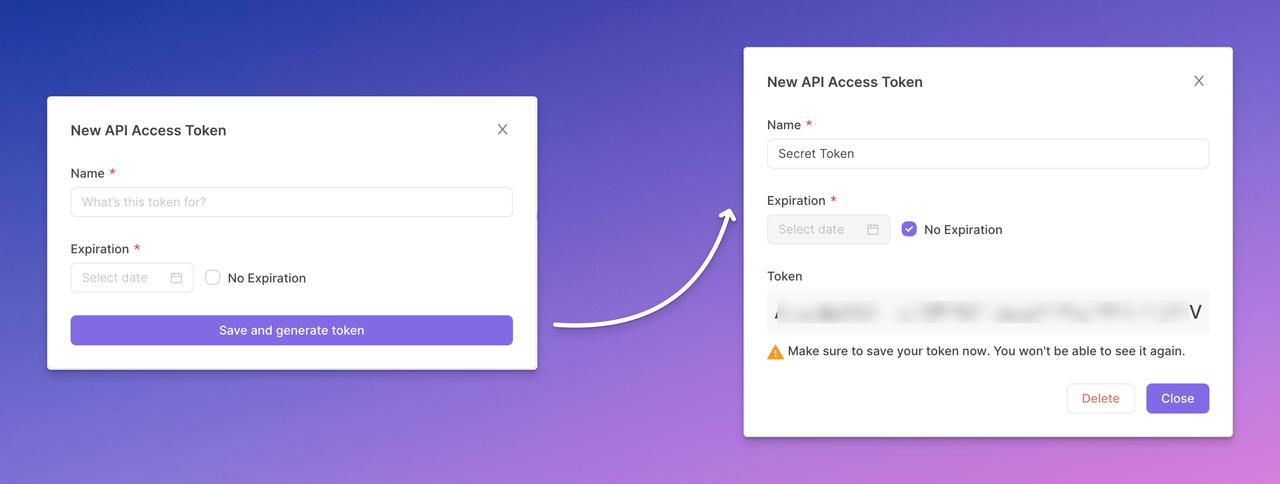

ステップ4:APIアクセストークンの生成

APIアクセストークンの管理ボタンをクリックし、APIアクセストークンの管理を行い、新しいトークンの生成を選択します。トークンの設定を完了し、保存してトークンを生成し、最後にAPIアクセストークンを安全にコピーして保存します。

注意:生成されたAPIアクセストークンは1回だけ表示されます。すぐに安全にコピーして保存するようにしてください。APIキーをフロントエンドのコードやリクエストに直接公開するよりも、バックエンドの呼び出しを介してAPIキーをプレーンテキストで公開することがベストプラクティスです。これにより、アプリに対する乱用や攻撃が防止されます。

アプリごとに複数のAPIアクセストークンを作成して、異なるユーザーや開発者に配布することができます。これにより、APIの利用者はアプリ開発者が提供するAI機能にアクセスできる一方で、Promptエンジニアリングや他のツールの機能はそのまま保たれます。

Anakin AIでクイックアプリを構築する

クイックアプリは、ブログ投稿、翻訳、その他のクリエイティブコンテンツなど、高品質なテキストコンテンツを生成することができます。Run a Quick App APIを呼び出すことで、ユーザーの入力コンテンツが送信され、生成されたテキスト結果が取得されます。

テキストの生成に使用するモデルのパラメータとプロンプトテンプレートは、Anakin.aiのApp -> Manage -> Designページの入力設定に依存します。

アプリでのQuick App APIのAPIドキュメントとリクエスト例をApp -> Integration -> API List - > View Detailsで確認できます。

以下は、テキスト補完情報を作成するためのAPIコールの例です:

curl --location --request POST 'https://api.anakin.ai/v1/quickapps/{{appId}}/runs' \

--header 'Authorization: Bearer ANAKINAI_API_ACCESS_TOKEN' \

--header 'X-Anakin-Api-Version: 2024-05-06' \

--header 'Content-Type: application/json' \

--data-raw '{

"inputs": {

"Product/Service": "クラウドサービス",

"Features": "信頼性とパフォーマンス。",

"Advantages": "効率",

"Framework": "Attention-Interest-Desire-Action"

},

"stream": true

}'

ヒント:変数{{appId}}を要求するappIdに置き換え、ANAKINAI_API_ACCESS_TOKENをステップ4で生成したAPIアクセストークンで置き換えてください。

Quick App APIの詳細については、APIリファレンスを参照してください。

Anakin AIで独自のAIチャットボットアプリを構築する

Chatbotアプリは、自然な質問応答形式でユーザーと対話するチャットボットを作成することができます。Conversation with Chatbot APIを呼び出して会話を開始し、返されたパラメータ名を引き継いで会話を継続することができます。

アプリでのChatbot APIのAPIドキュメントおよびサンプルリクエストは、App -> Integration -> API List - > View Detailsで確認できます。

以下は、会話メッセージを送信するためのAPIコールの例です:

curl --location --request POST 'https://api.anakin.ai/v1/chatbots/{{appId}}/messages' \

--header 'Authorization: Bearer ANAKINAI_API_ACCESS_TOKEN' \

--header 'X-Anakin-Api-Version: 2024-05-06' \

--header 'Content-Type: application/json' \

--data-raw '{

"content": "あなたの名前は何ですか?あなたは賢い方ですか?",

"stream": true

}'

ヒント:変数{{appId}}を要求するappIdに置き換え、ANAKINAI_API_ACCESS_TOKENをステップ4で生成したAPIアクセストークンで置き換えてください。

Chatbot APIの詳細については、APIリファレンスを参照してください。

まとめ

Gemini 1.5 Pro APIは、開発者がGoogleの最先端の言語モデルをアプリケーションに統合するための強力なツールです。このガイドに沿って示された手順に従うことで、開発環境の設定、APIキーの生成、Gemini 1.5 Proモデルの機能を活用したアプリケーションの構築を開始することができます。

テキスト生成、質問応答、画像キャプションなど、テキスト処理のタスクに取り組んでいる場合、Gemini 1.5 Pro APIは柔軟でパワフルなソリューションを提供します。さらに、Anakin.aiのAPIサービスと統合することで、高度な機能を追加してアプリケーションをさらに強化し、開発プロセスを効率化することができます。

Gemini 1.5 Pro APIとAnakin.aiのAPI統合を探索し続ける際には、公式ドキュメントを参照し、最新の更新や機能について常に最新情報を確認してください。AIの世界は急速に進化しており、これらのツールは開発者や組織に新たな可能性を開くことを続けます。

それなら、Anakin AIを見逃すことはできません!

Anakin AIは、ワークフローの自動化のためのオールインワンプラットフォームであり、使いやすいノーコードアプリビルダーで強力なAIアプリを作成することができます。Llama 3、Claude、GPT-4、Uncensored LLMs、Stable Diffusionなどを使用して、夢のAIアプリを数分で構築しましょう!