データサイエンスの世界では、言語モデルが新たなフロンティアになっています。これらの情報処理の巨大なネットワークは、かつては人間にしか行えないと考えられていたタスクを実行することができます。長文の要約、人間に似たテキストの生成、言語の翻訳、複雑な質問に回答するなど、大規模な言語モデル(LLM)は、機械ができることの限界を追求しています。しかし、これらの巨大なモデルを扱うことはしばしば多くの計算リソースを必要とし、多くの個人や小規模チームには手の届かないものです。

そこで、Google Colabの登場です。

次の大きなプロジェクトに取り組んでいるデータサイエンティストを想像してください。あなたが手元に持っている強力なLLMは、あなたの仕事を根本的に変える可能性があります。しかし、たった1つの問題があります - あなたのローカルマシンではそのモデルを処理するためのパワーが足りません。高価なハードウェアのアップグレードに投資するか、高性能なクラウドコンピューティングサービスを借りるという2つの選択肢がありますが、どちらも財布に大きな負担をかけます。

もしくは、Google Colabを使うこともできます。

Google Colabは、ブラウザを介してPythonコードを書いて実行できるクラウドベースのプラットフォームで、設定なしで使うことができます。そして、何よりも嬉しいことに、それは完全に無料です。Google Colabは、強力な計算リソースへのアクセスを民主化し、LLMを高額な費用をかけずに実行することが可能になります。

しかし、それだけでなく、Google Colabは以下の機能も提供しています:

- 無料のGPU: Google Colabは無料のGPUサポートを提供し、計算を大幅に高速化するため、大きなモデルを実行することが可能です。

- 簡単なアクセス: Google Driveと統合されており、簡単に作業を保存や共有することができます。

- 使いやすいインターフェース: これらすべてがシンプルで直感的なインターフェースで提供されており、使いやすさを追求しています。

魅力的ですよね?でもあなたは「本当にGoogle Colabで大規模な言語モデルを実行できるの?」と疑問に思っているかもしれません。さあ、確かめてみましょう。

Google ColabでLLMを実行できますか?

もちろんです! Google Colabの無料版では、12GBのRAMを搭載したTesla K80 GPUへのアクセス権が与えられます。これは最大の言語モデルのトレーニングには十分ではないかもしれませんが、微調整したり予測を実行するのには十分です。

実際、様々な大規模な言語モデルプロバイダーが事前にトレーニングされたモデルを提供しています:

- OpenAI: OpenAIのGPT-3は、印象的な人間のようなテキストを生成することができる最先端の言語モデルです。

- Azure OpenAI: マイクロソフトのAzureプラットフォームは、GPT-3をクラウドサービスとして提供しています。

- Hugging Face: Hugging Faceは、さまざまなNLPタスクに使用できる事前トレーニングモデルを提供しています。

- Fireworks AI: Fireworks AIは、企業向けの大規模な言語モデルに特化しています。

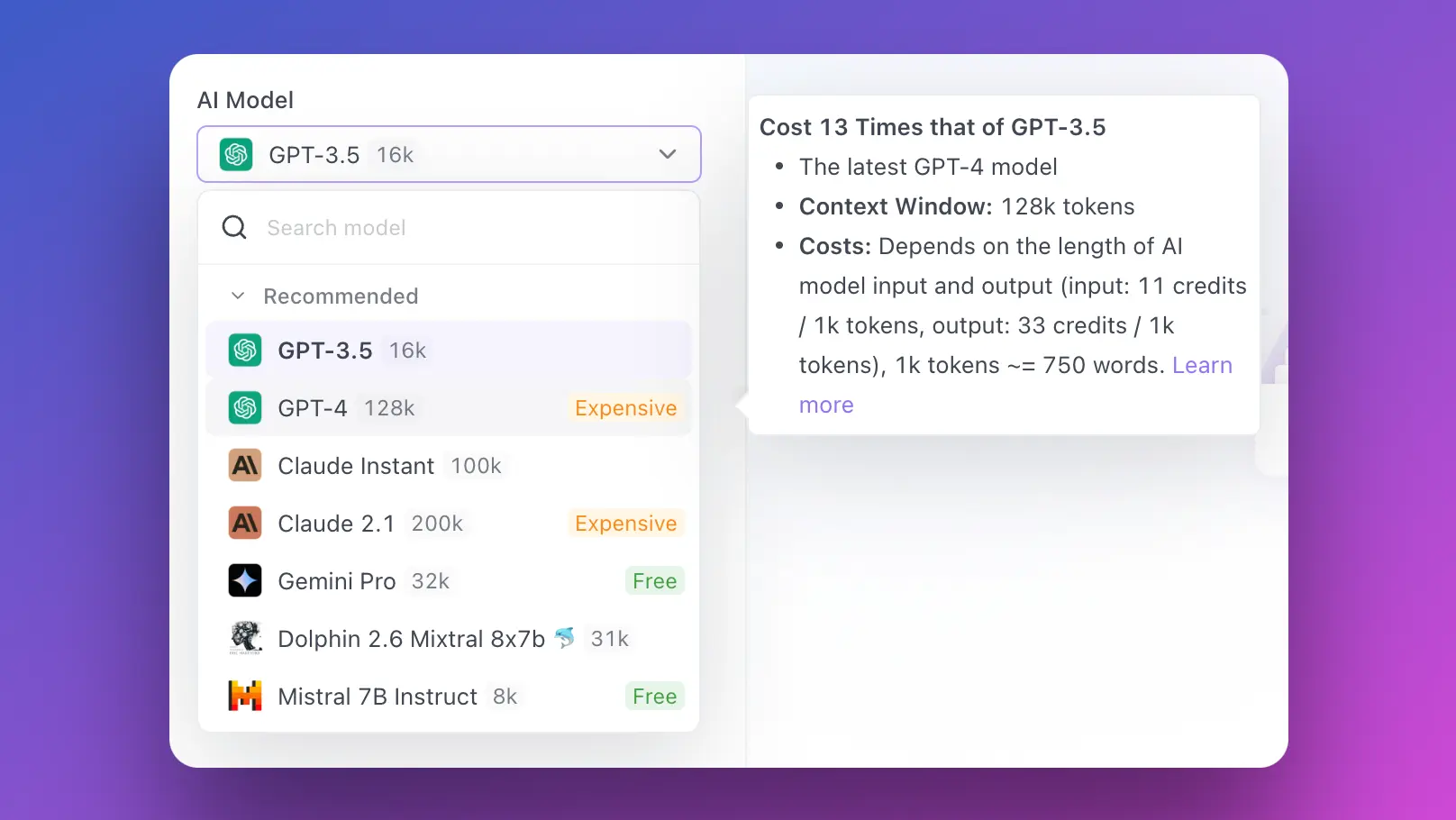

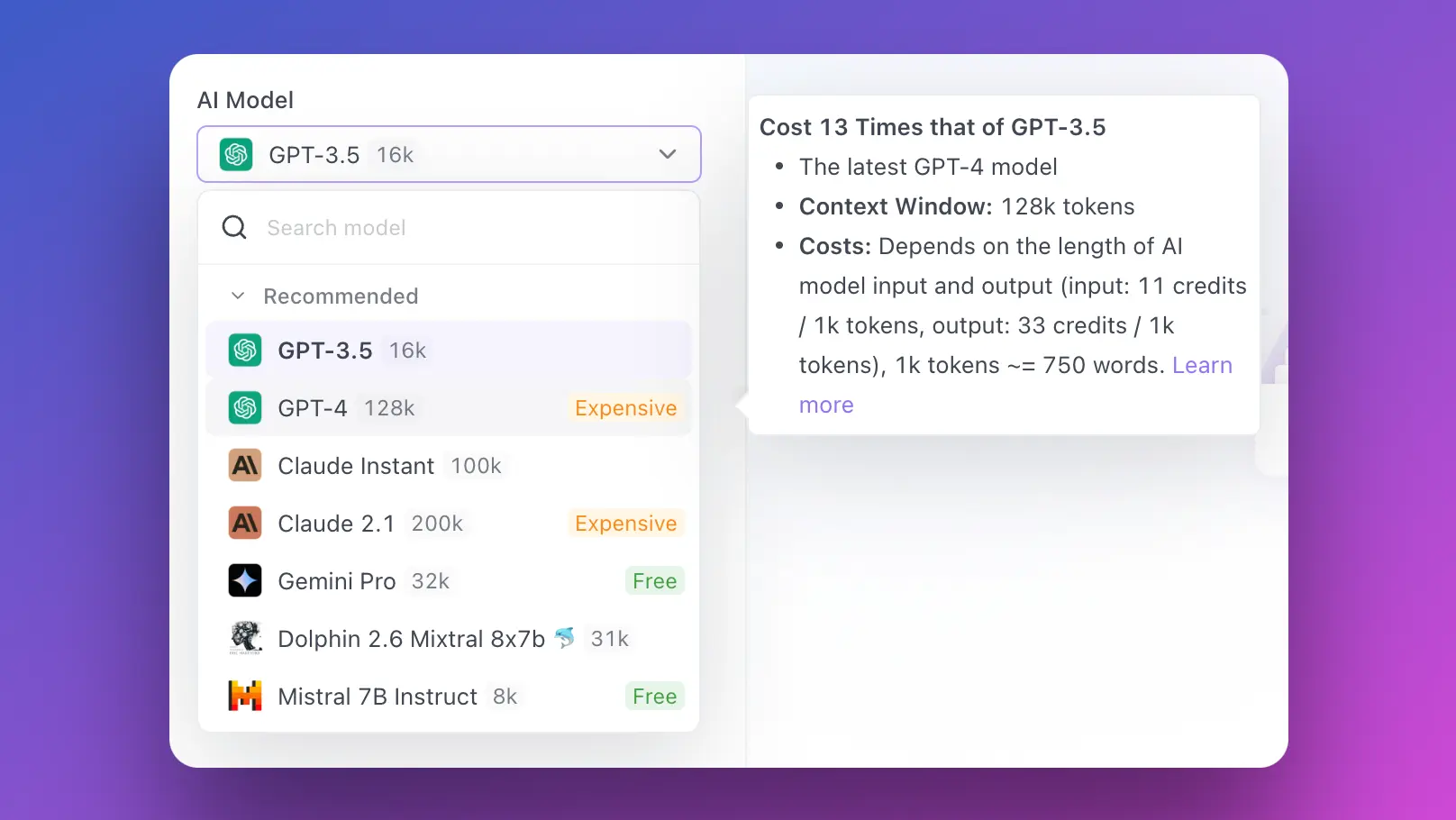

- Anakin AI:No Codeアプリビルダーを使用して、あらゆるAIモデルでAIアプリを構築できる場所!

では、これらのモデルをGoogle Colabで実行するための環境をどのようにセットアップするのか、まっすぐに進んでみましょう。

Google Colabでの環境のセットアップ

LLMsを実行するためのGoogle Colabのセットアップは簡単です。以下は、始めるためのステップバイステップのガイドです:

新しいノートブックの作成: Google Colabのウェブサイトにアクセスし、新しいPython 3ノートブックを開始します。

必要なライブラリのインストール: 必要なPythonライブラリをインストールします。例えば、Hugging Faceのモデルを使用する場合は、transformersライブラリをインストールする必要があります。次のコードを新しいセルで実行してください:

!pip install transformers

正しいランタイムの選択: ランタイム > ランタイムのタイプを変更をクリックし、ハードウェアアクセラレータとしてGPUを選択します。

完了です!基本的なセットアップは完了です。ただし、ワークフローを最適化する場合にはさらなる設定が必要です。

Google ColabでGoogle Driveをマウントする

Google Driveの統合は、データサイエンティストにとって強力なツールになる重要な機能の1つです。Google Driveから直接データにアクセスし、作業を保存して戻すことができます。

次の手順でGoogle ColabでGoogle Driveをマウントすることができます:

以下のコードを新しいセルで実行してください:

from google.colab import drive

drive.mount('/content/drive')

表示されるリンクに移動し、Googleアカウントを選択し、認証コードをコピーします。

コードをColabに貼り付けて完了です!これでColabノートブックから直接Google Driveのファイルにアクセスできます。

次に、Google ColabでGPUアクセラレーションを有効にする方法を見てみましょう。

Google ColabでGPUアクセラレーションを有効にする

LLMsで作業する場合、GPUアクセラレーションを有効にすることは絶対に必要です。幸いなことに、Google Colabはこれを簡単かつ無料で提供しています:

ランタイム > ランタイムのタイプを変更に移動します。

ハードウェアアクセラレータの横にあるドロップダウンメニューをクリックし、GPUを選択します。

以上です!これでGPUアクセラレーションを備えたColabノートブックを作成することができました。

Google Colabで大規模な言語モデルを実行する

これで、Google Colabの環境がセットアップされ、準備が整いました。これから重要な仕事を行っていきましょう。

Hugging Faceのtransformersライブラリを使用したサンプルコードのスニペットを見てみましょう:

from transformers import pipeline

# モデルの初期化

nlp_model = pipeline('sentiment-analysis')

# モデルを使用して予測する

result = nlp_model('We are learning to use Google Colab for running large language models.')

print(result)

この基本的なコードスニペットでは、文章をモデルに入力し、感情分析の予測結果を取得することができます。必要に応じて、'sentiment-analysis'を他のタスク('text-generation'、'translation_en_to_fr'など)に置き換えることができます。

結論

ビッグデータとますます成長していく言語モデルの時代において、データサイエンティストにとって利用可能な計算リソースは重要です。Google Colabは、クラウドベースの使いやすい環境内で、無料のGPUアクセラレーションを含む大規模な計算能力を提供することで、競争の均等化を図っています。

個人のプロジェクトに取り組んでいる個人、小規模チームのデータサイエンティスト、初めてLLMsに取り組む学生であっても、Google ColabでLLMsを実行することで、アクセス可能で費用効果の高い信頼性のあるソリューションが提供されます。

では、なぜ待つのでしょうか?今日、Google Colabの環境をセットアップし、無料で大規模な言語モデルの力を手に入れる旅に出ましょう!

Anakin AIもテストしてみることを忘れないでください。お気に入りのAIモデルを1つの場所にまとめ、No Code AIアプリビルダーでコーディング作業の時間を節約します!