次のHTMLコードを日本語に翻訳してください。 以下のようなURLがあることを確認してください: https://anakin.ai/apps/keyword または https://anakin.ai/blog/keyword を以下のように変換してください: https://anakin.ai/ja-jp/apps/keyword https://anakin.ai/ja-jp/blog/keyword 以下がHTMLコードです:

Anakin AIが解決策です!

Anakin AIは、Llama Models from Meta、Claude 3.5 Sonnet、GPT-4、Google Gemini Flash、Uncensored LLM、DALLE 3、Stable Diffusionへのアクセスが1つの場所で可能なオールインワンのプラットフォームです。さらに、APIサポートにより簡単に統合することができます!

始めて試してみましょう!👇👇👇

MetaのLlama 3.1モデルは、オープンソースの大規模言語モデル(LLM)の最新の進化を代表し、さまざまなタスクで印象的な機能を提供しています。この包括的なガイドでは、これらのモデルをローカルで実行する方法、パフォーマンスを比較する方法、およびそれらを利用するための代替プラットフォームについて探っていきます。

Llama 3.1モデルの理解

Llama 3.1には3つのサイズがあります:8B、70B、および405Bのパラメータ。それぞれのモデルサイズには異なる機能とリソース要件があります:

- Llama 3.1 8B:限られた計算リソースに最適であり、テキスト要約、分類、感情分析、および低遅延言語翻訳に優れています。

- Llama 3.1 70B:コンテンツの作成、対話型AI、言語理解、エンタープライズアプリケーションに適しています。

- Llama 3.1 405B:最も大きな公開可能なLLMであり、エンタープライズレベルのアプリケーション、研究、合成データ生成に適しています。

ベンチマークとパフォーマンスの比較

Llama 3.1モデルは、さまざまなベンチマークでその前のバージョンよりも大幅な改善が示されています。以下は、いくつかの主要なパフォーマンス指標を示す比較表です:

| ベンチマーク | Llama 3.1 8B | Llama 3.1 70B | Llama 3.1 405B | GPT-4 | Claude 3.5 Sonnet |

|---|---|---|---|---|---|

| MATH | 35.2 | 68.3 | 73.8 | 76.6 | 71.1 |

| MMLU | 45.3 | 69.7 | 75.1 | 86.4 | 79.3 |

| HumanEval | 18.3 | 42.2 | 48.9 | 67.0 | 65.2 |

| GSM8K | 22.1 | 63.5 | 69.7 | 92.0 | 88.4 |

Llama 3.1 405Bは全体的に印象的なパフォーマンスを示していますが、すべてのタスクで70Bモデルよりも優れるわけではありません。この変動性は、特定のユースケースに適したモデルサイズを選ぶことの重要性を示しています。

Llama 3.1モデルをローカルで実行する

1. Ollamaを使用してローカルのLlama 3.1モデルを展開する(8B、70B、405B)

Ollamaは、ローカルでLlamaモデルを実行するための軽量で拡張性のあるフレームワークです。使いやすいコマンドラインインターフェースを提供し、さまざまなモデルサイズをサポートしています。

Ollamaを使って始めるには:

- 公式ウェブサイト(https://ollama.ai)からOllamaをインストールします。

- ターミナルを開き、以下のコマンドを実行してLlama 3.1をダウンロードして実行します:

ollama run llama3

- モデルが読み込まれると、それと対話を始めることができます:

ollama run llama3 "量子もつれの概念を説明してください"

より高度な使用法では、パラメータを微調整するためのカスタムモデルファイル(Modelfile)を作成することができます:

FROM llama3:8b

PARAMETER temperature 0.7

PARAMETER top_k 50

PARAMETER top_p 0.95

PARAMETER repeat_penalty 1.1

これをModelfileとして保存し、カスタムモデルを作成します:

ollama create mymodel -f Modelfile

ollama run mymodel

Ollamaは、Llama 3.1をアプリケーションに統合するためのREST APIも提供しています:

curl http://localhost:11434/api/generate -d '{

"model": "llama3",

"prompt": "フランスの首都はどこですか?"

}'

2. LM Studioを使用してローカルにLlamaモデルを展開する(8B、70B、405B)

LM Studioは、Llama 3.1モデルをローカルで実行し対話するための使いやすいグラフィカルインターフェースを提供しています。始める方法は次のとおりです:

- https://lmstudio.aiからLM Studioをダウンロードしてインストールします。

- LM Studioを起動し、モデル検索ページに移動します。

- 利用可能なLlama 3.1モデルを見つけるために「lmstudio-community/llama-3」を検索します。

- 希望するモデルサイズ(8Bまたは70B)とバリアント(BaseまたはInstruct)を選択します。

- 選択したモデルをダウンロードします。

- ダウンロードした後、LM Studioでモデルをロードします。

- モデルと対話するためにチャットインターフェースを使用するか、プログラムによるアクセスのためにローカルAPIサーバーをセットアップします。

LM Studioには、Llama 3.1の2つの主要なバリアントがあります:

- Base:フューショットプロンプティングやコンテキスト学習などのプロンプトエンジニアリングの技術が必要です。

- Instruct:指示の従順や対話への関与に特化しています。

Instructバリアントで最高のエクスペリエンスを得るには、LM Studioの設定で「Llama 3」プリセットを使用します。

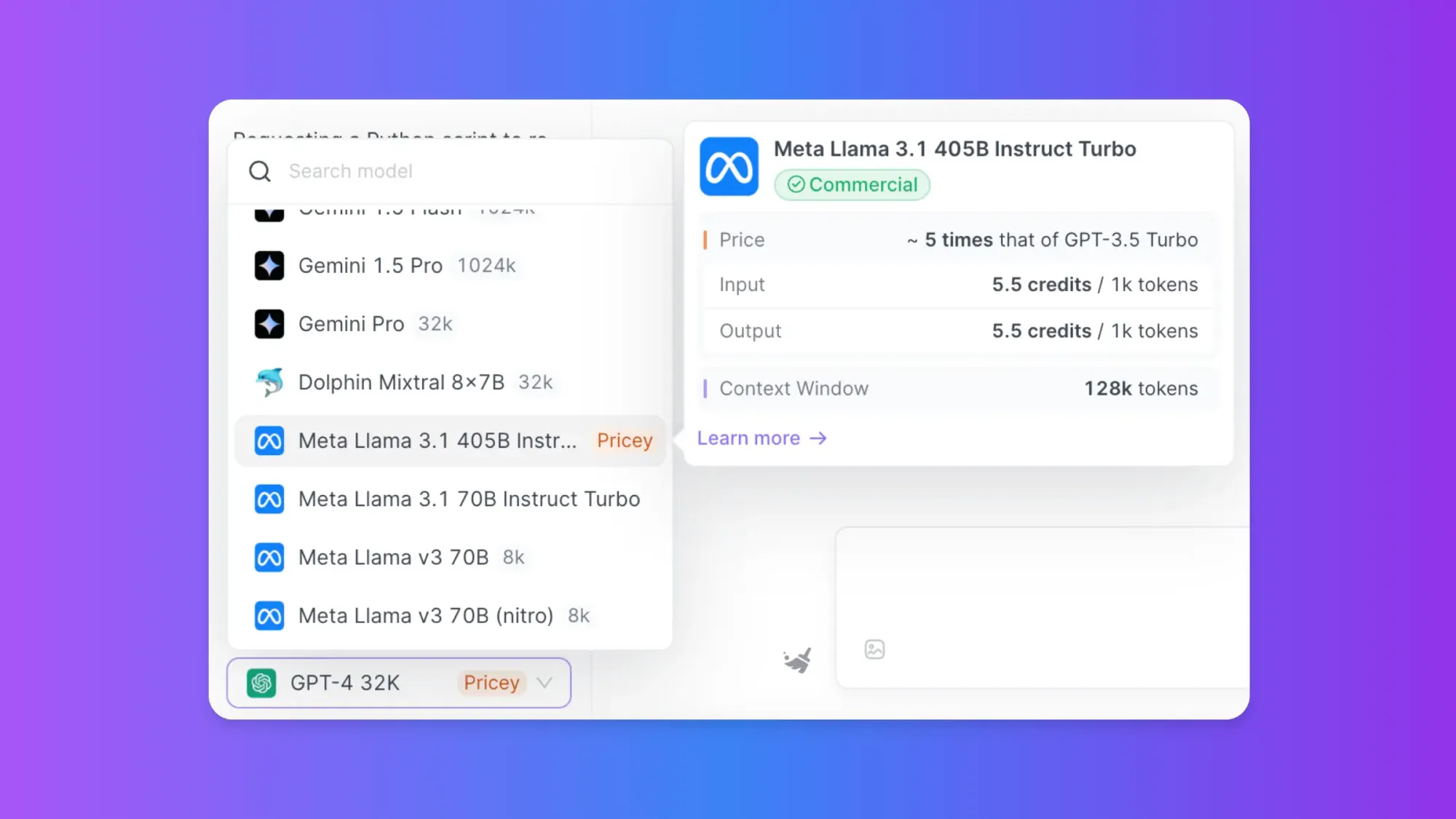

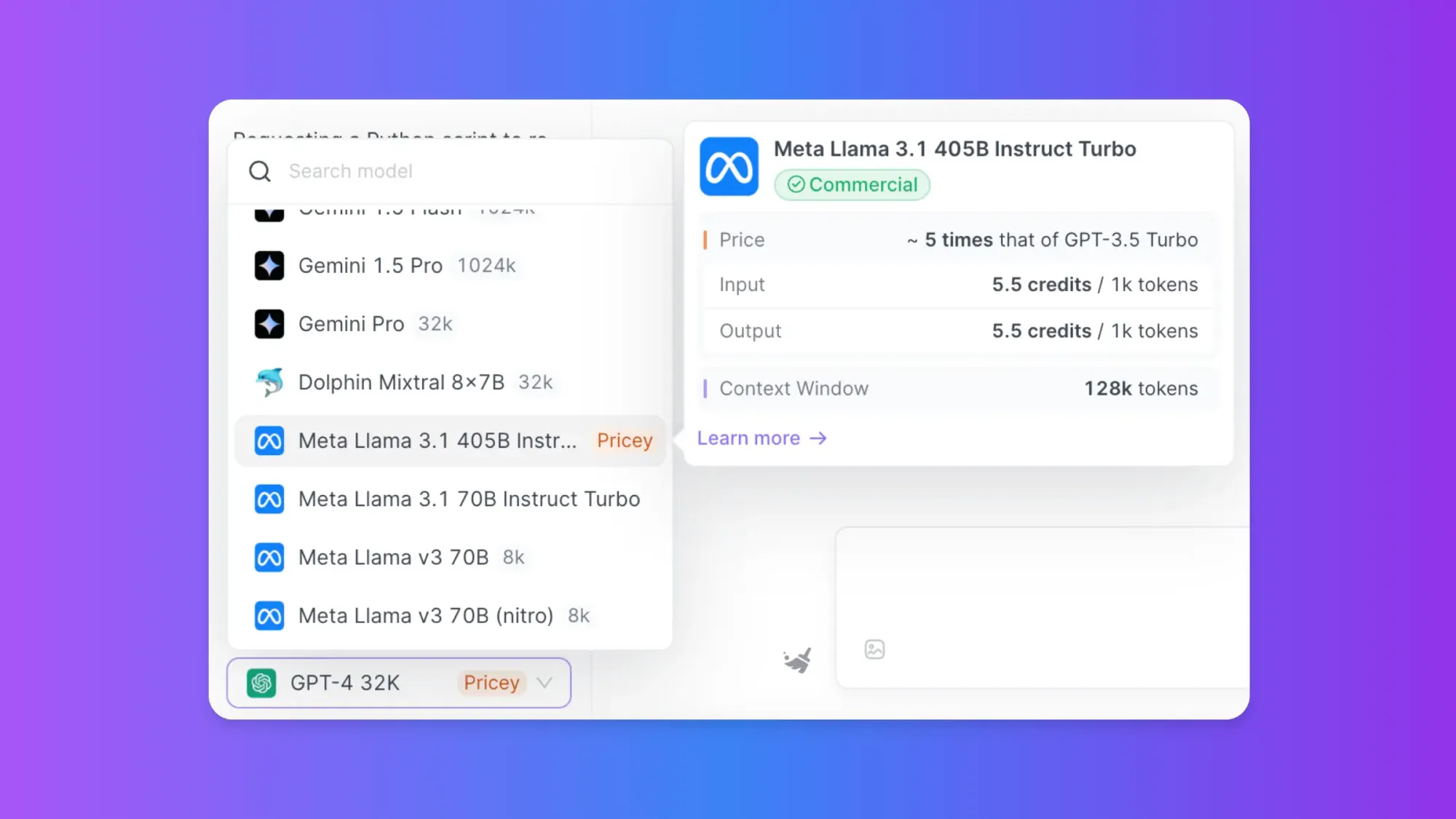

オンラインアクセスにAnakin AIを使用する

Llama 3.1モデルをローカルで実行することは柔軟性がありますが、特に大きなモデルの場合は大量の計算リソースを必要とします。Anakin AIは、このようなモデルのパワーを利用したいユーザーに、ローカルセットアップの複雑さを排除した代替ソリューションを提供します。

Anakin AIは、Llamaシリーズを含むさまざまなAIモデルを統合し、コーディングなしでAIアプリケーションを作成およびカスタマイズできる多機能なプラットフォームです。Anakin AIを介してLlama 3.1モデルを使用する方法は次のとおりです:

- Anakin AIのウェブサイトにアクセスしてアカウントを作成します。

- 1,000以上のプレビルトAIアプリがあるアプリストアを探索します。

- Llama 3.1ベースのアプリを選択するか、プラットフォームのツールを使用してカスタムアプリを作成します。

- アプリを特定の要件に合わせてカスタマイズします。

- Anakin AIのインターフェースを介してアプリを展開して使用します。

Anakin AIを使用すれば、コーディングの知識は必要ありません。Google Gemini 1.5やStable Diffusionも無料で使用できるため、複雑なコーディングを忘れて、日常の作業を自動化しましょう!

Anakin AIを使用すると、次のようなLlama 3.1モデルの利点があります:

- ローカルセットアップが不要:ハードウェア要件や複雑なインストールのことを心配せずに、強力なAIモデルにアクセスできます。

- 他のAIモデルとの統合:GPT-3.5、DALL-E、Stable Diffusionなど、Llama 3.1と組み合わせた総合的なソリューションを実現します。

- 使いやすいインターフェース:コーディングスキルなしでAIアプリケーションを作成および展開できます。

- スケーラビリティ:必要に応じてAIソリューションを簡単にスケールアップできます。

- さまざまなユースケースに対応:コンテンツ生成、カスタマーサポート、データ分析などに適しています。

適切なアプローチの選択

Llama 3.1モデルを実行する方法を決定する際には、以下の要素を考慮してください:

- 計算リソース:ローカル実行には大きなCPU/GPUパワーが必要であり、特に大きなモデルの場合はリソースが必要です。

- プライバシーとデータセキュリティ:ローカルでの実行はデータの制御をより保護します。

- カスタマイズの必要性:ローカルセットアップでは、微調整やカスタマイズに対する柔軟性があります。

- 使いやすさ:Anakin AIなどのプラットフォームは、テクニカルではないユーザーにとってより使いやすい経験を提供します。

- 統合要件:モデルが既存のシステムとどのように統合する必要があるかを考慮してください。

Llama 3.1モデルのベストプラクティス

Llama 3.1モデルを実行する方法に関係なく、次のベストプラクティスに注意してください:

- 適切なモデルサイズから始める:8Bモデルから始め、必要に応じてスケールアップします。

- 特定のタスクに合わせて微調整する:パフォーマンスを向上させるために特定のユースケースにモデルを適応させます。

- リソース使用状況の監視:特にローカルで実行する場合、CPU、GPU、およびメモリの使用状況に注意してください。

- 適切なプロンプティング技術の実装:最適な結果を得るために、明確で具体的なプロンプトを使用します。

- 最新に保つ:最新の改良点を享受するために、ローカルのインストールまたはプラットフォームのサブスクリプションを最新の状態に保ちます。

結論

Llama 3.1モデルは、さまざまな自然言語処理タスクにおいて印象的な機能を提供します。OllamaやLM Studioなどのツールを使ってローカルで実行するか、Anakin AIなどのクラウドプラットフォームを利用して、これらのパワフルな言語モデルを活用するための基盤として活用できます。

ローカルセットアップは制御性とカスタマイズオプションがより大きいですが、技術的な専門知識と計算リソースが必要です。一方、Anakin AIのようなプラットフォームは、ローカル展開の複雑さを排除したアクセス可能でスケーラブルなソリューションを提供します。

AIの分野が急速に進化し続ける中で、これらの強力な言語モデルの最大限の活用には、最新の動向とベストプラクティスに関する情報を把握しておくことが重要です。さまざまなアプローチ、モデルサイズ、およびユースケースを実験して、特定のニーズに最適なソリューションを見つけてください。

Anakin AIが解決策です!

Anakin AIは、Llama Models from Meta、Claude 3.5 Sonnet、GPT-4、Google Gemini Flash、Uncensored LLM、DALLE 3、Stable Diffusionへのアクセスが1つの場所で可能なオールインワンのプラットフォームです。さらに、APIサポートにより簡単に統合することができます!

始めて試してみましょう!👇👇👇