はじめに

AIの世界は急速に進化しており、Codestral 22Bのような強力なモデルの登場により、コード生成や自然言語処理の可能性が広がっています。しかし、これらのモデルを効率的に実行するには、特にGPUメモリ(VRAM)のハードウェアリソースへの注意が必要です。

それなら、Anakin AIを見逃せません!

Anakin AIは、ノーコードのアプリビルダーを使用して強力なAIアプリを作成するためのオールインワンプラットフォームです。Llama 3、Claude、GPT-4、Uncensored LLMs、Stable Diffusionなど、簡単に使えるアプリビルダーであなたの夢のAIアプリを数分で構築できます!

Codestral 22Bをローカルで実行できますか?

最近の包括的なラボテストでは、Codestral 22Bのパフォーマンスが、2つのNvidia RTX 4060 Ti GPUからなる予算に優しいセットアップを使用してテストされました。各GPUには16GBのGDDR6メモリが搭載されています。この構成では合計32GBのVRAMが提供され、消費者向けシステムには異常な量と考えられていました。テストでは、VRAM使用量へのコンテキストサイズの影響、異なる量子化レベル(Q4、Q6、およびQ8)のスループット(t/s)、消費電力などに関する重要な問題に答えることを目的としています。

手頃な高VRAMビルドの実現可能性をさらに探るために、予算に応じたさまざまなGPUのメモリ帯域幅を調べる価値があります。以下の表は、いくつかのモデルの比較を示しています。

| GPUモデル | アーキテクチャ | メモリサイズ | メモリタイプ | メモリ帯域幅 | 消費電力(TDP) |

|---|---|---|---|---|---|

| Nvidia A4000 | Ampere | 16 GB GDDR6 | GDDR6 | 448 GB/s | 140 W |

| Nvidia RTX 4060 Ti 16GB | Ada Lovelace | 16 GB GDDR6 | GDDR6 | 288 GB/s | 160 W |

| Nvidia RTX 3060 | Ampere | 12 GB GDDR6 | GDDR6 | 360 GB/s | 170 W |

| Nvidia Quadro P5000 | Pascal | 16 GB GDDR5X | GDDR5X | 288 GB/s | 180 W |

| Nvidia Quadro RTX 5000 | Turing | 16 GB GDDR6 | GDDR6 | 448 GB/s | 230 W |

| Nvidia Quadro P6000 | Pascal | 24 GB GDDR5X | GDDR5X | 432 GB/s | 250 W |

| Nvidia Titan X | Pascal | 12 GB GDDR5X | GDDR5X | 480 GB/s | 250 W |

| Nvidia Tesla P40 | Pascal | 24 GB GDDR5X | GDDR5X | 346 GB/s | 250 W |

最速のカードのメモリ帯域幅を倍にしたRTX 3090は、24GBのVRAMと非常に高いコストを備えていますが、多くのユーザーにとって制約があるかもしれません。データは、16GB VRAMを備えたRTX 4060 Tiなどの手頃なオプションが、性能とコスト効率のバランスを提供できる可能性があることを示唆しています。

次のセクションでは、ラボテストの主な結果を調査し、現実世界のアプリケーションへの影響を検討し、手頃な高VRAMのGPUビルドの可能性を探求します。

Ollamaを使用してCodestral 22Bをローカルで実行する方法

Ollamaは、Mistral AIが開発したコーディングタスクのための先端AIモデルであるCodestral 22Bを含むさまざまなAIモデルとの実行とインタラクションが可能なオープンソースプラットフォームです。この強力なモデルは、コードと自然言語の大規模なデータセットでトレーニングされています。

ステップ1:Ollamaのインストール

Codestral 22Bを実行するためには、まずOllamaをシステムにインストールする必要があります。Ollamaは、Windows、macOS、Linuxなど、さまざまなオペレーティングシステム用に用意されています。公式のOllamaのウェブサイト(https://ollama.com)でインストール手順やダウンロードリンクを見つけることができます。

例えば、Linuxでは次のコマンドでOllamaをインストールすることができます:

curl -fsSL https://ollama.com/install.sh | sh

適切なパッケージをシステムにダウンロードした後、提供されたインストール手順に従います。このプロセスは通常、パッケージを展開してインストールスクリプトを実行するという手順を含みます。

ステップ2:Codestral 22Bモデルのダウンロード

Ollamaをインストールした後、Codestral 22Bモデルをダウンロードする必要があります。このモデルは、AIモデルとデータセットの人気のあるリポジトリであるHugging Faceプラットフォームで利用できます。次のリンクでCodestral 22Bモデルを見つけることができます:https://huggingface.co/mistralai/Codestral-22B-v0.1

モデルをダウンロードするには、Ollamaのコマンドラインインターフェース(CLI)を使用することができます。ターミナルまたはコマンドプロンプトを開き、モデルを保存するディレクトリに移動した後、次のコマンドを実行します:

ollama pull codestral

このコマンドにより、Hugging Faceリポジトリから必要なファイルがダウンロードされ、Codestral 22Bモデルのローカルコピーが作成されます。

ステップ3:Codestral 22Bモデルの実行

モデルがダウンロードされたら、Ollama CLIを使用して実行することができます。ターミナルまたはコマンドプロンプトでOllamaをインストールしたディレクトリに移動し、次のコマンドを実行します:

ollama run codestral

このコマンドにより、Codestral 22Bモデルが起動し、プロンプトを提供して応答を受け取るインタラクティブなセッションが開かれます。

使用例:

人間:与えられた数値の階乗を計算するためのPythonの関数を書いてください。

アシスタント:以下は、指定された数値の階乗を計算するPythonの関数です:

def factorial(n):

"""

指定された数値の階乗を計算します。

Args:

n (int): 階乗を計算するための数値。

Returns:

int: 指定された数値の階乗。

"""

if n == 0:

return 1

else:

return n * factorial(n-1)

# 使用例

print(factorial(5)) # 出力: 120

この例では、Codestral 22Bモデルが再帰を使用して、与えられた数値の階乗を計算するPythonの関数を生成します。関数には、目的、引数、および返り値について説明するdocstringが含まれています。

Anakin AIを使用してAIアプリを構築する

Anakin AIは、コードを1行も書かずにAIアプリケーションを作成できるノーコードプラットフォームです。使いやすいインタフェースと幅広い事前構築済みのAIモデルを提供しており、技術的なエキスパートiseのレベルにかかわらず利用できます。

ステップ1:Anakin AIにサインアップする

Anakin AIを始めるには、ウェブサイト(https://www.anakin.ai)でアカウントを作成する必要があります。サインアッププロセスは簡単で、名前、メールアドレス、パスワードなどの基本情報を提供する必要があります。

ステップ2:事前構築済みのAIアプリを探索する

サインアップしてログインすると、個人用のワークスペースに移動します。Anakin AIでは、すぐに探索して使用できるさまざまな事前構築済みのAIアプリを提供しています。これらのアプリは、コンテンツ生成、画像処理、データ分析など、さまざまな領域をカバーしています。

事前構築アプリを探すには、トップのナビゲーションバーにある「Discover」ボタンをクリックします。これにより、利用可能なアプリのライブラリに移動し、カテゴリに基づいてフィルタリングしたり、特定の機能に対して検索したりすることができます。

ステップ3:新しいAIアプリを作成する

自分のニーズに合った事前構築アプリが見つからない場合は、ゼロから新しいAIアプリを作成することもできます。個人用のワークスペースで、「Create App」ボタンをクリックし、作成したいアプリのタイプを選択します。

Anakin AIでは、次の3つの主要なアプリのタイプが提供されています:

- Quick App:このタイプのアプリは、ブログ記事、翻訳、クリエイティブライティングなどのテキストコンテンツを生成するために設計されています。

- Chatbot App:その名前が示すように、このアプリはユーザーとの自然な会話を行うことができるチャットボットを作成することができます。

- Workflow App:ワークフローアプリは複数のAIモデルと機能を組み合わせて単一のアプリケーションに統合することができる、より複雑なアプリです。

この例では、Quick Appを作成しましょう。

ステップ4:AIアプリをカスタマイズする

アプリのタイプを選択した後、アプリビルダーのインターフェースに移動します。ここでは、アプリのさまざまな側面をカスタマイズすることができます。入力フィールド、使用するAIモデル、出力形式などをカスタマイズできます。

Quick Appの場合、通常以下のように定義します:

- 入力フィールド:ユーザーがコンテンツを生成するために必要な情報を提供するフィールドです。例えば、ブログ投稿のアイデアを生成するためのアプリを作成する場合、トピック、対象読者、望ましいスタイルなどの入力フィールドがあるかもしれません。

- AIモデル:Anakin AIは、OpenAI、Anthropic、Googleなど、さまざまなプロバイダからのAIモデルを提供しています。アプリの要件に最も適したモデルを選択できます。

- プロンプトテンプレート:これは、AIモデルがユーザーの入力に基づいてコンテンツを生成するために使用するテンプレートです。プロンプトテンプレートをカスタマイズして、生成されるコンテンツが特定のニーズに合うようにすることができます。

- 出力形式:最後に、生成されたコンテンツの表示形式(プレーンテキスト、Markdown、HTMLなど)を指定できます。

アプリをカスタマイズしたら、サンプルの入力を提供してコンテンツを生成してテストすることができます。結果に満足したら、アプリを保存して他のユーザーが使用できるようにすることができます。

ステップ5:Anakin AIのAPIを統合する(オプション)

Anakin AIは、すべてのアプリケーションに包括的なAPIサービスを提供しており、開発者や組織は自分たちのプロジェクトをAnakin AIのAPIを使用してシームレスに統合し、拡張することができます。

これらのAPIを活用することで、ユーザーは自分たちのアプリケーション内でAnakin AIの強力な製品機能に簡単にアクセスする柔軟性を得ることができます。これにより、複雑なバックエンドアーキテクチャーやデプロイプロセスを管理する手間をかけずに、開発コストや作業量を大幅に削減し、開発者にとっては前例のない利便性を提供します。

API統合の利点

- Anakin AIの直感的なビジュアルインターフェースを使用して、ビジネスニーズに合わせたAIアプリケーションを迅速に開発し、すべてのクライアントでリアルタイムに実装します。

- プロバイダを切り替える柔軟性とともに、複数のAIモデルプロバイダをサポートします。

- AIモデルの基本的な機能への事前パッケージ化されたアクセス。

- APIを介して提供される今後の高度な機能に対応します。

Codestral 22Bを使用してAnakin AIを利用する方法

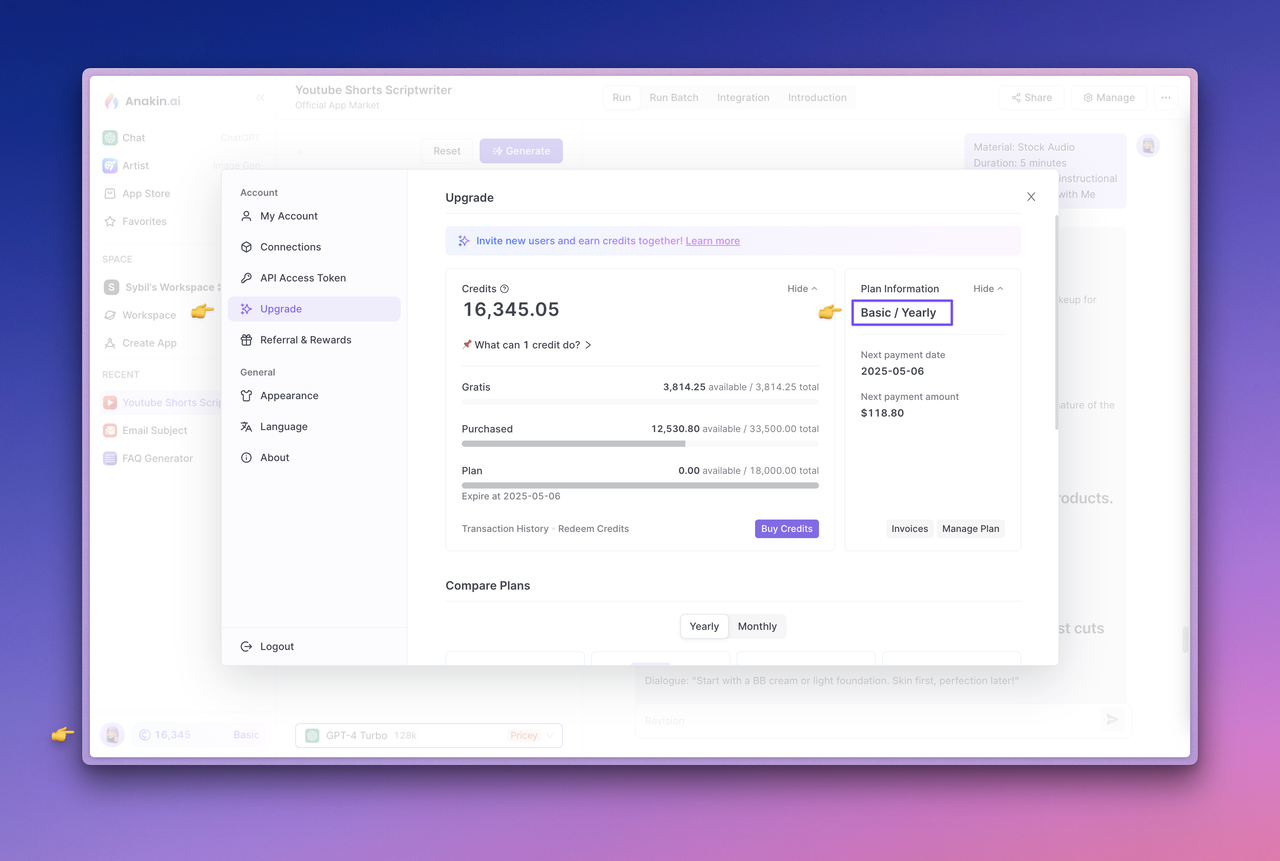

プランをアップグレードし、アカウント残高を確認する:Anakin AIのAPIサービスは現在、定期購読者限定で提供されています。API呼び出しを介してAIモデルを使用する際には、アカウント残高からクレジットが消費されます。サブスクリプションのステータスを確認したり、プランをアップグレードしたりするには、Anakin AI Web Appに移動し、左下隅にあるアバターをクリックしてアップグレードページにアクセスします。現在のアカウントのクレジットが十分であることを確認してください。

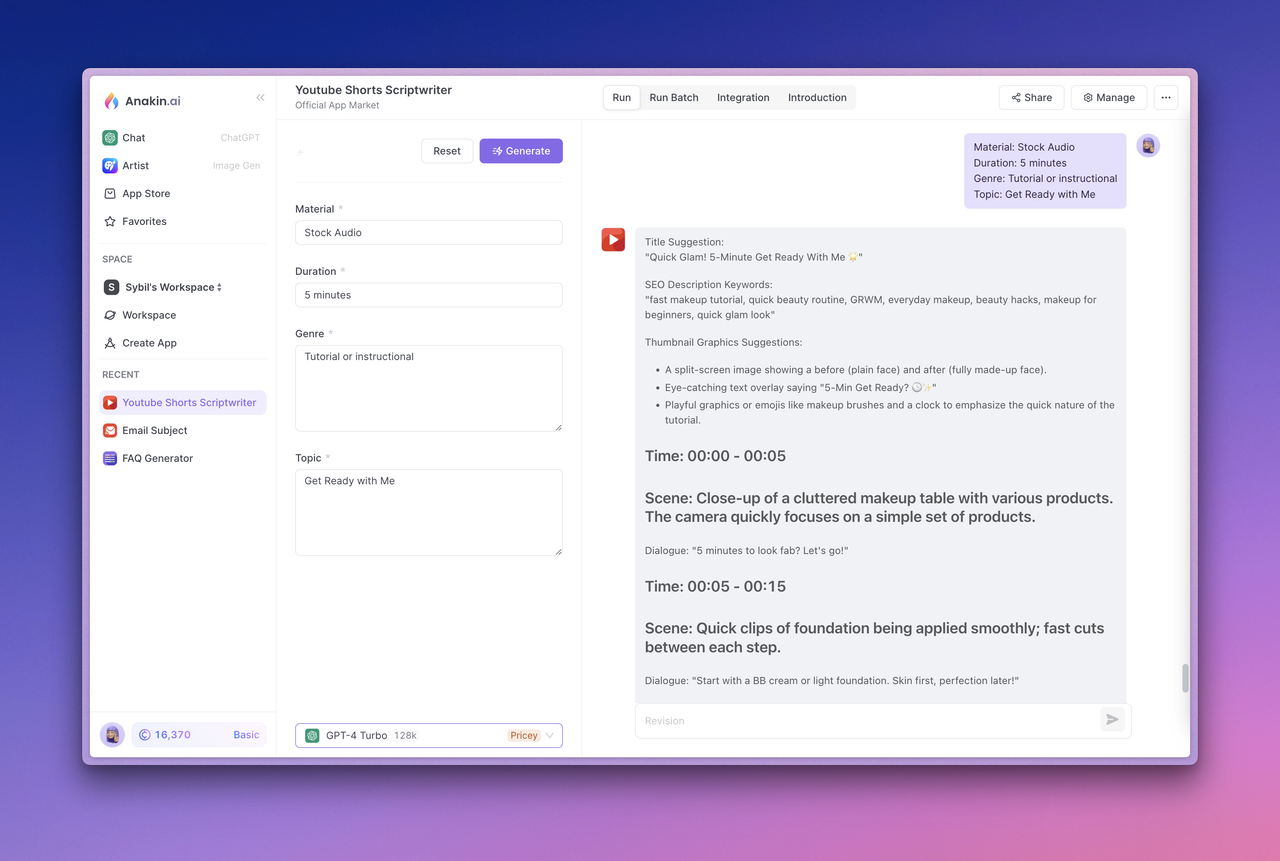

アプリをテストする:アプリをテストするには、アプリを選択し、「Generate」ボタンをクリックします。正常に実行され、期待される出力を生成することを確認してください。

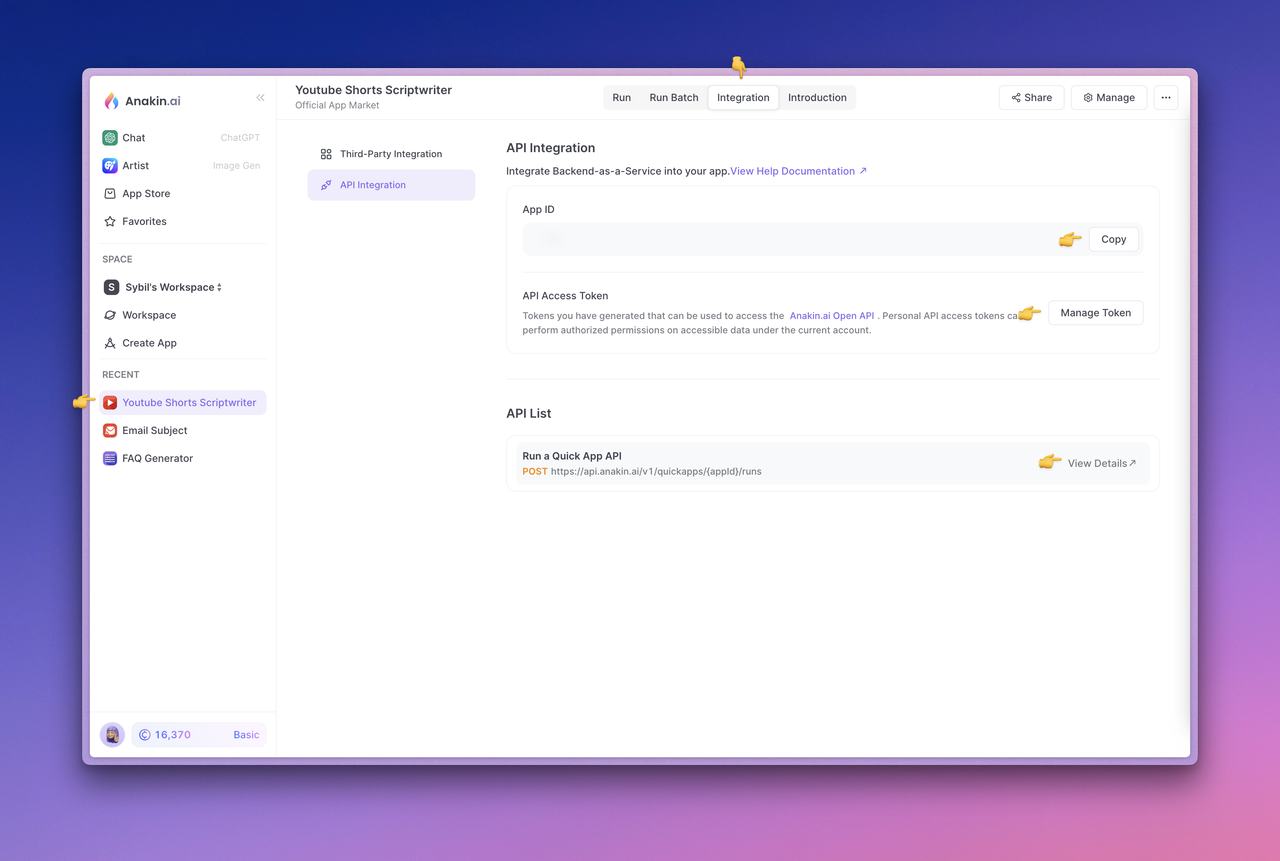

APIドキュメントを表示し、APIアクセストークンを管理する:次に、上部のアプリ統合セクションを訪れます。このセクションでは、「View Details」をクリックして、Anakin AIから提供されるAPIドキュメントを表示したり、アクセストークンを管理したり、App IDを表示したりすることができます。

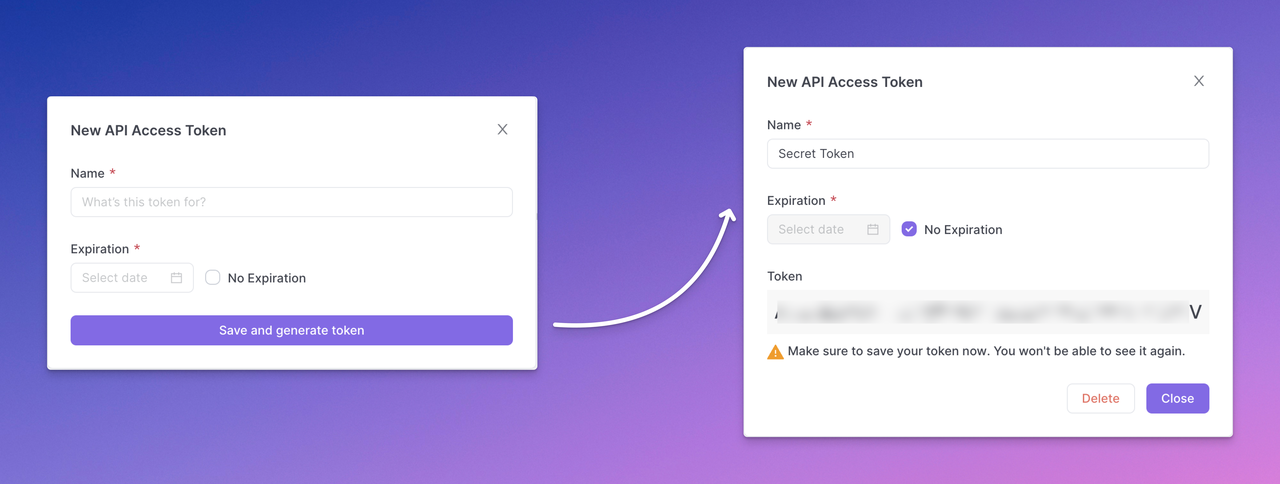

APIアクセストークンを生成する:「Manage Token」ボタンをクリックしてAPIアクセストークンを管理し、「New Token」を選択してAPIアクセストークンを生成します。トークンの設定を完了し、「Save and generate token」をクリックして、APIアクセストークンをコピーして安全に保存します。

生成されたAPIアクセストークンは1度だけ表示されるため、すぐにコピーして安全に保存することを確実にしてください。APIキーを直接フロントエンドのコードやリクエストではなく、バックエンドコールを介して平文で公開することは、悪用や攻撃を防ぐためのベストプラクティスです。アプリ内のユーザーがアプリ開発者の提供するAIの機能を利用できる一方で、プロンプトエンジニアリングやその他のツールの機能は保たれるようにするため、アプリごとに複数のAPIアクセストークンを作成し、異なるユーザーや開発者に配布することができます。

Quick App APIの例

Quick Appでは、ブログ記事、翻訳、その他のクリエイティブなコンテンツなど、高品質なテキストコンテンツを生成することができます。「Run a Quick App」APIを呼び出すことで、ユーザー入力コンテンツが送信され、生成されたテキスト結果が取得できます。

テキストを生成する際に使用するモデルパラメータやプロンプトテンプレートは、Anakin AI App -> Manage -> Designページの入力設定に依存します。

アプリのAPIドキュメントとリクエスト例は、App -> Integration -> API List -> View Detailsで見つけることができます。

以下は、テキスト補完情報を作成するためのAPI呼び出しの例です:

curl --location --request POST 'https://api.anakin.ai/v1/quickapps/{{appId}}/runs' \

--header 'Authorization: Bearer ANAKINAI_API_ACCESS_TOKEN' \

--header 'X-Anakin-Api-Version: 2024-05-06' \

--header 'Content-Type: application/json' \

--data-raw '{

"inputs": {

"Product/Service": "Cloud Service",

"Features": "Reliability and performance.",

"Advantages": "Efficiency",

"Framework": "Attention-Interest-Desire-Action"

},

"stream": true

}'

Chatbot App APIの例

Chatbot Appでは、自然な質問と回答形式でユーザーと対話するチャットボットを作成することができます。会話を開始するには、"Conversation with Chatbot" APIを呼び出して、返されたパラメータ名を継続的に渡します。

アプリのAPIドキュメントとサンプルリクエストは、App -> Integration -> API List -> View Detailsで見つけることができます。

以下は、会話メッセージを送信するAPI呼び出しの例です:

curl --location --request POST 'https://api.anakin.ai/v1/chatbots/{{appId}}/messages' \

--header 'Authorization: Bearer ANAKINAI_API_ACCESS_TOKEN' \

--header 'X-Anakin-Api-Version: 2024-05-06' \

--header 'Content-Type: application/json' \

--data-raw '{

"content": "What's your name? Are you the clever one?",

"stream": true

}'

Anakin AIのAPIをアプリケーションに統合することで、AIモデルや機能のパワーを活用しながら、ユーザーエクスペリエンスやカスタマイズオプションを制御することができます。

結論

この包括的なガイドでは、Ollamaを使用してCodestral 22Bモデルを実行し、AIの解決策を作成および展開するプロセスを簡素化するノーコードプラットフォームであるAnakin AIを使用して、AIアプリケーションを構築する方法を学びました。

この記事で説明された手順に従うことで、コーディングタスクにCodestral 22Bモデルの機能を活用し、特定のニーズに合わせたカスタマイズされたAIアプリをAnakin AIで作成することができます。開発者、起業家、または単にAI愛好家である場合、これらのツールは人工知能の広大な可能性を探求するためのシームレスでアクセスしやすい方法を提供します。

引用:

[1] https://ppl-ai-file-upload.s3.amazonaws.com/web/direct-files/6987700/746022a6-8311-46fa-9fbc-1b22763a6ef6/paste.txt

[2] https://ppl-ai-file-upload.s3.amazonaws.com/web/direct-files/6987700/c1da2cf5-5a8c-4b2e-bfa7-8aa539ee8062/paste.txt

[3] https://github.com/ollama/ollama

[4] https://ollama.com/download

[5] https://www.ollama.com

[6] https://huggingface.co/mistralai/Codestral-22B-v0.1

[7] https://huggingface.co/bartowski/Codestral-22B-v0.1-GGUF

[8] https://mistral.ai/news/codestral/

[9] https://www.youtube.com/watch?v=XGc0Q3tJ7s0

[10] https://ollama.com/blog/continue-code-assistant

[11] https://github.com/ollama/ollama/issues/4706

[12] https://www.jammable.com/anakinskywalker

[13] https://www.eventbrite.com/e/anakinai-promo-code-anakinai-sign-up-now-tickets-892090535807

[14] https://www.aitoolsclub.com/anakin-ai/

[15] https://scrapbox.io/anakin-ai/How_to_Create_AI_Apps_with_No_Code_Effortlessly

[16] https://www.futurepedia.io/tool/anakinai

[17] https://digitaltools.io/ai/anakin-ai/

[18] https://www.youtube.com/watch?v=o_iO-uCuD_I

[19] https://www.youtube.com/watch?v=lK8xsrLhL_E

[20] https://www.youtube.com/watch?v=UkfnC2kT_so