人工知能の急速な進化の世界では、強力なAIモデルをアプリケーションにシームレスに統合する能力は、開発者にとってゲームチェンジャーです。本記事では、LangChainライブラリとAzure OpenAIサービス内でChatOpenAIを活用するための包括的なガイドとして機能します。高度な会話能力を備えたプロジェクトを強化したい場合や、AIの潜在能力を探求している場合にも、ChatOpenAIを効果的に使用する方法を理解することは重要です。単純な実行可能な手順とサンプルコードを交えて、プロセスを解説します。

TL;DR:クイックガイド

- LangChainをインストールし、ChatOpenAIをインポートして、開発環境をセットアップします。

- ChatOpenAIを設定して、OpenAIまたはAzure APIキーを使用して認証します。

- チャット機能を作成して実行し、AIモデルとやり取りします。

- より良い統合のために、OpenAIとChatOpenAIの違いを理解します。

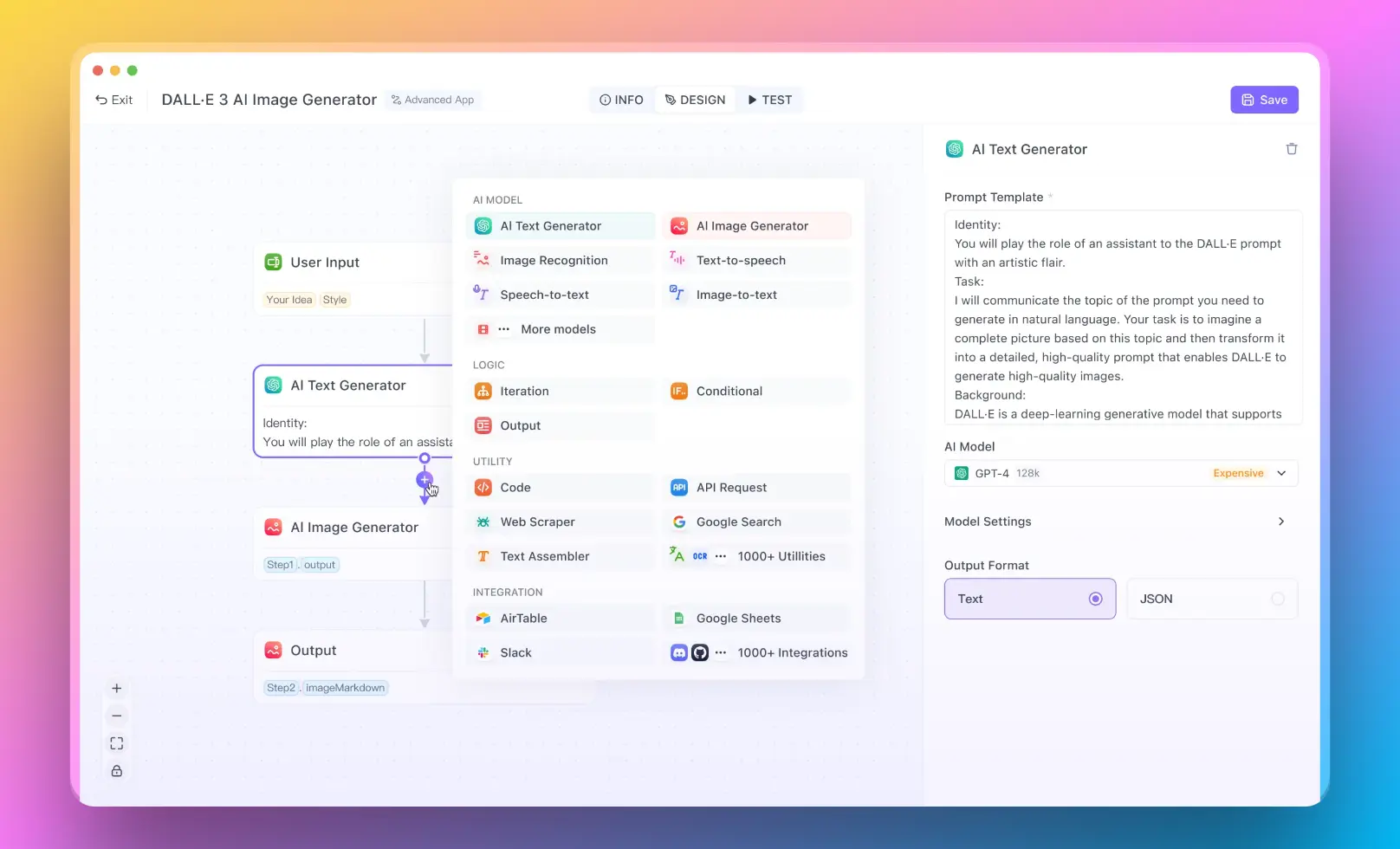

- コーディング経験がないユーザー向けには、Anakin AIを試してみることができます。No Code Builderで素晴らしいAIアプリを作成できます!

上記の情報をすべて備えて、さあ始めましょう!

ChatOpenAIとLangChainの始め方

人間のようにチャットできるロボットを作ると想像してみてください。最初に、ロボットに脳を与える必要があります。それがChatOpenAIの役割です。LangChainは、脳を使いやすくするロボットのボディと考えてください。すべてを一緒に組み立てる方法は次のとおりです。

- セットアップ:作業スペースの準備のようなものです。コンピューターがPythonを理解していることを確認し、それからLangChainについて教えます。

- 脳(ChatOpenAI)を取り入れる:今、脳(ChatOpenAI)をロボットの体(LangChain)に紹介します。Pythonに、「ねえ、ChatOpenAIを使うことにするよ」と言うだけです。

- 脳を起こす:ロボットがチャットできるようにするためには、脳をインターネットに接続する必要があります(OpenAIのAPIキーを使用して)。これは、脳のWi-Fi接続のようなものです。

- チャットする:もうチャットできる準備ができました! AIに小さなメモ(「こんにちは」など)を書いて送信すると、AIが応答します。

Azure OpenAIを介したチャット

ロボットが別のインターネットプロバイダを使用するようにしたい場合、そこでAzureが登場します。手続きは似ていますが、AzureのWi-Fiを使用するだけです:

- Azureでサインアップ:Azureアカウントを取得し、特別なAzure Wi-Fiの詳細を見つけます(APIキーとエンドポイント)。

- 脳をAzureに接続:ロボットの脳にAzureのWi-Fiを使用するように指示します。Azureの詳細を提供してください。

- チャットを開始:前と同様に、AIにメモを送信すると、応答が得られます。

OpenAIとChatOpenAIの違いは何ですか?

- OpenAI:これはさまざまなタスク向けに作られたAIの脳を作る大手企業です。

- ChatOpenAI:これはチャット用に作られた特定のタイプの脳です。使いやすさを重視し、ロボットが迅速にチャットを開始できるように設計されています。

ChatOpenAIをLangChainとAzure OpenAIと統合する

ChatOpenAIをLangChainとAzure OpenAIと統合することで、プロジェクトをLangChainとAzure OpenAIで拡張できる可能性を探ることができます。クリックして可能性を探りましょう!

ChatOpenAIへのイントロダクション

ChatOpenAIは、OpenAIの言語モデルをさまざまなアプリケーションにシームレスに統合するための強力なツールです。この記事では、LangChainライブラリとAzure OpenAIサービス内のChatOpenAIクラスの利用方法について詳しく説明し、OpenAIとChatOpenAIの違いを強調し、ステップとサンプルコードを通じて実用的なガイダンスを提供します。

LangChainでChatOpenAIを使用する方法

LangChainは、言語AIの共通パターンを抽象化することで言語アプリケーションの構築を容易にするライブラリです。LangChain内でChatOpenAIを統合することで、会話AIモデルの展開プロセスを大幅に簡素化できます。

ステップ1: 環境を設定する

ChatOpenAIを統合する前に、Pythonがインストールされており、仮想環境が設定されていることを確認します:

python -m venv langchain-env

source langchain-env/bin/activate

ステップ2: LangChainをインストールする

pipを使用してLangChainをインストールします:

pip install langchain

ステップ3: ChatOpenAIをインポートする

LangChainからChatOpenAIクラスをインポートします:

from langchain.chains import ChatOpenAI

ステップ4: ChatOpenAIの設定

OpenAIのAPIキーでChatOpenAIクラスを初期化します:

chat_model = ChatOpenAI(api_key='your_openai_api_key')

ステップ5: 会話の作成

会話のロジックを処理する関数を作成します:

def chat_with_openai(prompt):

response = chat_model.chat(prompt)

print("AI says:", response)

ステップ6: チャットの実行

セットアップをテストするためにモデルにプロンプトを送信します:

chat_with_openai("Hello, how can I help you today?")

ChatOpenAIクラスをAzure OpenAIと使用する方法

Azure OpenAIもOpenAIモデルの統合をサポートしており、拡張された会話機能の実現にはChatOpenAIの使用が含まれます。

ステップ1: Azure OpenAIリソースを作成する

Azureポータルを介してAzure OpenAIリソースを作成し、APIキーとエンドポイントを取得します。

ステップ2: Azure SDKをインストールする

Azure AI SDKをインストールします:

pip install azure-ai-textanalytics

ステップ3: ChatOpenAIをAzureの資格情報で設定する

ChatOpenAIの初期化を変更して、Azureの資格情報を使用するようにします:

chat_model = ChatOpenAI(api_key='your_azure_api_key', api_endpoint='your_azure_endpoint')

ステップ4: チャット関数の実装

以前と同じチャット関数を使用しますが、エンドポイントが正しくAzure OpenAIを指すように設定されていることを確認します:

def chat_with_azure(prompt):

response = chat_model.chat(prompt)

print("Azure AI says:", response)

ステップ5: Azureの統合をテストする

Azure OpenAIでのパフォーマンスを確認するために、チャット関数を実行します:

chat_with_azure("Hello, how can I assist you today?")

結論

ChatOpenAIをLangChainとAzure OpenAIと統合することで、開発者は高度な会話型AIをアプリケーションに組み込む堅牢なフレームワークを提供できます。上記の手順に従って進めることで、OpenAIのモデルのパワーを最大限に活用した、ニーズに合わせたAIチャットシステムを設定できます。直接のOpenAI統合またはAzureのクラウドプラットフォームを介して。