次のHTMLコードを日本語に翻訳してください。 以下のようなURLがあることを確認してください: https://anakin.ai/apps/keyword または https://anakin.ai/blog/keyword を以下のように変換してください: https://anakin.ai/ja-jp/apps/keyword https://anakin.ai/ja-jp/blog/keyword 以下がHTMLコードです:

人工知能の急速に進化する分野で、Metaは最近、革新的な大規模言語モデルであるLlama 3を公開しました。この強力なツールは、15兆トークンのデータでトレーニングされており、人間のようなテキストの理解と生成能力を有しており、幅広い応用において画期的な存在です。

要約

- MetaのGitHubリポジトリからLlama 3をダウンロードしてインストールします。

- コーディング能力を向上させるためにモデルをファインチューニングします。

- Flaskを使用してWebアプリケーションインターフェースを開発します。

- AIコーディングアシスタントのユーザーフレンドリーなフロントエンドを作成します。

Llama 3とは何ですか?

- Llama 3は、Metaの最新かつ最も高度な大規模言語モデルであり、自然言語処理タスクでの優れた性能で知られています。

- 人間のようなテキストを非常に高い精度で理解し生成できる能力により、Llama 3は論理的な推論、コード生成、クリエイティブライティングなどの領域で新たな基準を確立しました。

- Llama 3のパワーを試してみたいですか?Anakin AIとチャットしてみましょう!(ほぼすべての利用可能なAIモデルをサポート!)

RAG(取得増強生成)とは何ですか?

- Llama 3が採用するRAG(取得増強生成)は、言語生成能力と外部の知識取得を組み合わせる技術です。

- RAGは、膨大な情報の活用により、より情報を豊富にして文脈に即した応答を提供することで、Llama 3の全体的な性能と汎用性を高めます。

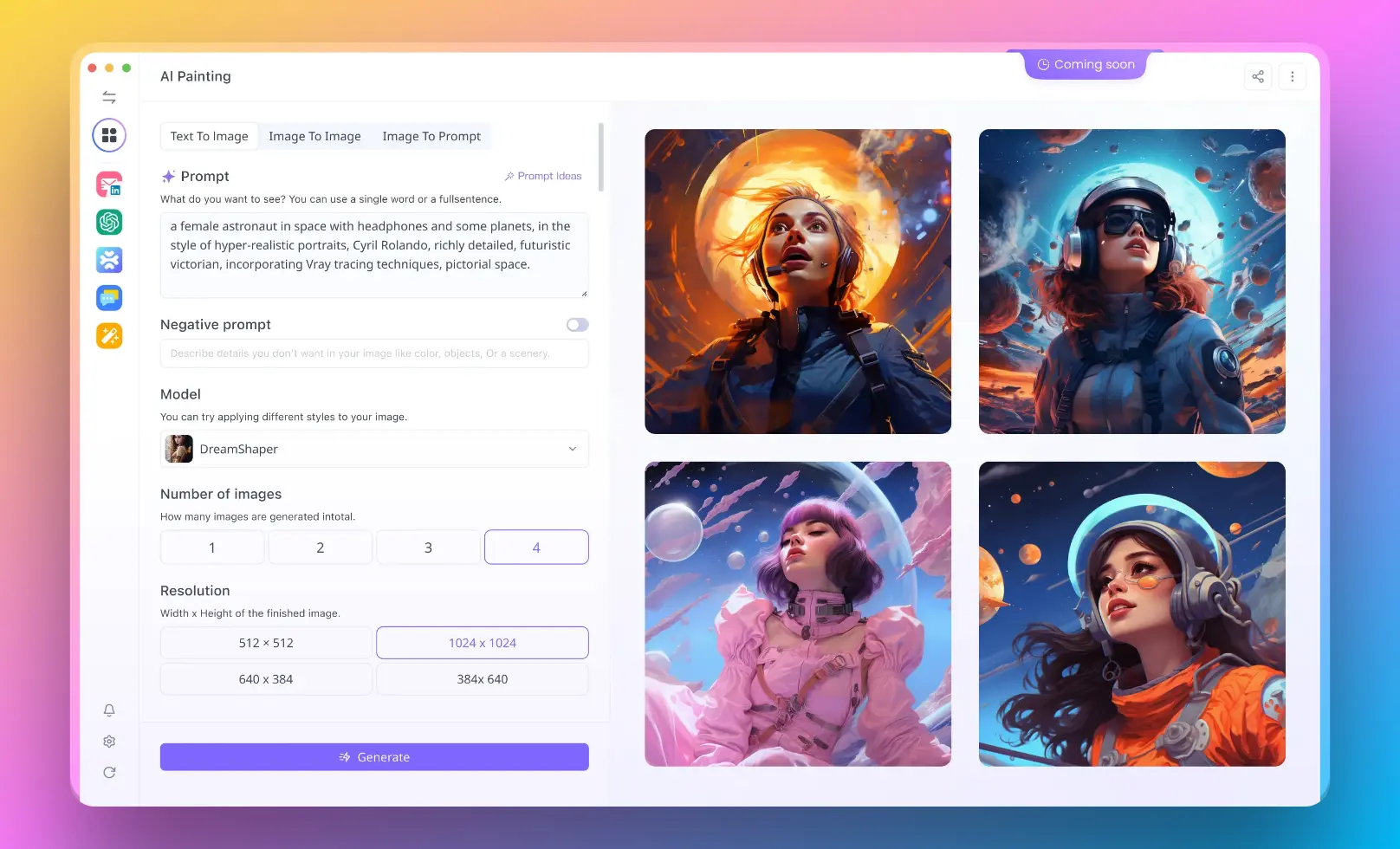

- コーディングの経験がないユーザー向けにRAGシステムを実行したい場合は、AIの無線アプリビルダーアナキンAIを試してみることができます!

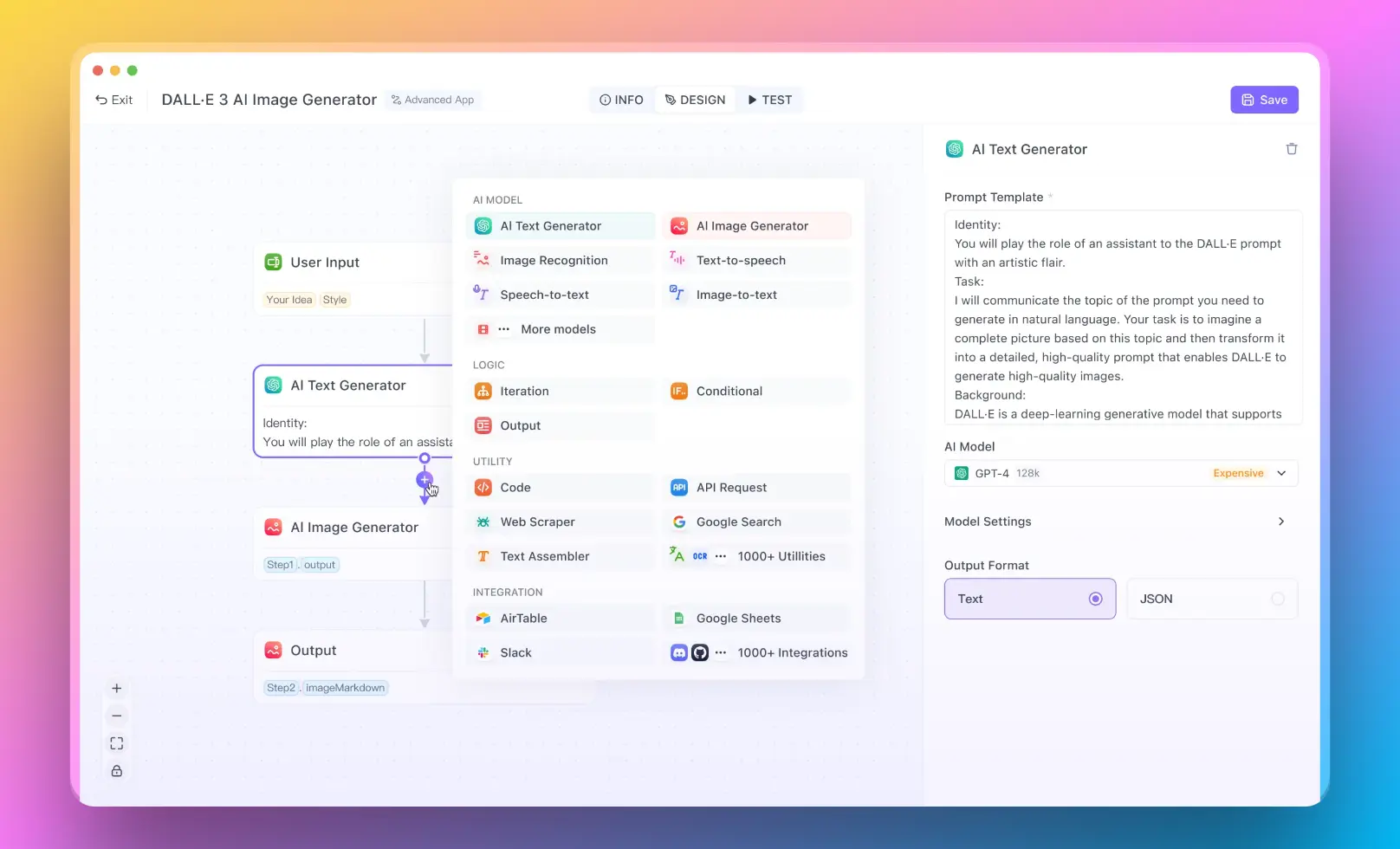

Anakin AIを使用してノーコードRAGアプリを構築する

- Anakin AIは、リトリーバル増強生成(RAG)システムを含むAIパワードアプリケーションを作成するためのノーコードプラットフォームを提供しています。

- 直感的なインターフェースで、データソースを接続し、リトリーバルと生成のコンポーネントを構成し、言語モデルを微調整することにより、カスタムRAGソリューションを構築できます。それをコードを書かずに行うことができます。

- Anakin AIは、プレビルドのテンプレートとコラボレーションツールを提供しており、非技術的なユーザーにも利用可能です。コードベースのアプローチより柔軟性は劣りますが、AIの専門知識がないビジネスにとって効率的なRAG開発が可能です。

上記の情報をすべて確認したら、始めましょう!

前提条件

始める前に、以下のものがあることを確認してください:

- NVIDIA GPUを搭載したコンピュータ(8GB以上のVRAMが推奨)

- LinuxまたはWindows 10/11オペレーティングシステム

- Python 3.7以降がインストールされていること

- Pythonと機械学習の基本知識

ステップ1:Llama 3をインストールする

最初のステップは、Llama 3言語モデルをローカルマシンにインストールすることです。Llama 3はオープンソースで、GitHubで入手できます。

- Llama 3リポジトリをクローンします:

git clone https://github.com/facebookresearch/llama.git

cd llama

- 必要なPythonパッケージをインストールします:

pip install -r requirements.txt

- 事前学習済みのLlama 3の重みをダウンロードします。 Llama 3のウェブサイトのフォームに記入してアクセスを取得する必要があります。ダウンロードした.pthファイルをllama/modelsディレクトリに配置します。

ステップ2:コードでLlama 3をファインチューニングする

次に、コードのデータセットでLlama 3をファインチューニングして、ソースコードの理解と生成を学習させる必要があります。

- コードスニペットとドキュメントストリングのデータセットを準備します。CodeSearchNetデータセットが良いオプションです。Pythonのサブセットをダウンロードして抽出します:

wget https://s3.amazonaws.com/code-search-net/CodeSearchNet/v2/python.zip

unzip python.zip

- finetune.pyスクリプトを使用して、コードデータセットでLlama 3をトレーニングします:

python finetune.py \

--base_model decapoda-research/llama-7b-hf \

--data_path python/train \

--output_dir python_model \

--num_train_epochs 3 \

--batch_size 128

これにより、Llama 3がPythonコードデータセットを3エポックでファインチューニングし、ファインチューニングされたモデルをpython_modelディレクトリに保存します。

ステップ3:コーディングアシスタントのインターフェースを開発する

コードの理解ができる言語モデルを持っているので、AIコーディングアシスタントのユーザーインターフェースを作成しましょう。Flaskフレームワークを使用してシンプルなWebアプリを作成します。

- Flaskをインストールします:

pip install flask

- 次のコードでapp.pyという新しいファイルを作成します:

from flask import Flask, request, jsonify

from transformers import AutoModelForCausalLM, AutoTokenizer

app = Flask(__name__)

model_path = "python_model"

tokenizer = AutoTokenizer.from_pretrained(model_path)

model = AutoModelForCausalLM.from_pretrained(model_path)

@app.route('/complete', methods=['POST'])

def complete():

data = request.get_json()

code = data['code']

input_ids = tokenizer.encode(code, return_tensors='pt')

output = model.generate(input_ids, max_length=100, num_return_sequences=1)

generated_code = tokenizer.decode(output[0])

return jsonify({'generated_code': generated_code})

if __name__ == '__main__':

app.run()

これにより、FlaskのWebサーバーが作成され、/completeエンドポイントが作成されます。それはファインチューニングされたLlama 3モデルとトークナイザをロードし、JSONデータとして現在のコードを/completeに送信するとコード補完を生成します。

- Flaskアプリを実行します:

flask run

ステップ4:フロントエンドUIを作成する

最後に、コーディングアシスタントのための基本的なフロントエンドを作成しましょう。

- 以下のコードでindex.htmlというファイルを作成します:

<!DOCTYPE html>

<html>

<head>

<title>AI Coding Assistant</title>

</head>

<body>

<h1>AI Coding Assistant</h1>

<textarea id="code" rows="10" cols="50"></textarea>

<br>

<button onclick="complete()">Complete Code</button>

<p>Generated Code:</p>

<pre id="generated-code"></pre>

<script>

function complete() {

var code = document.getElementById("code").value;

fetch('/complete', {

method: 'POST',

headers: {

'Content-Type': 'application/json'

},

body: JSON.stringify({code: code})

})

.then(response => response.json())

.then(data => {

document.getElementById("generated-code").textContent = data.generated_code;

});

}

</script>

</body>

</html>

これにより、ユーザーがコードを入力するためのテキストエリアと、現在のコードを/complete APIエンドポイントに送信するためのボタンが表示されます。生成されたコードの補完は以下に表示されます。

- Webブラウザで

index.htmlを開き、AIアシスタントの助けを借りてコーディングを開始します!

展開と次のステップ

おめでとうございます、これでLlama 3によってパワードされる動作するAIコーディングアシスタントが完成しました!試してみる他のいくつかの追加事項:

- 他のユーザーが利用できるように、アプリをAWSやHerokuなどのクラウドプラットフォームにデプロイする

- シンタックスハイライト、マルチファイルサポートなどでフロントエンドを拡張する

- さまざまなプログラミング言語でLlama 3をファイントゥーンする

- 代替のモデルアーキテクチャやハイパーパラメータを試して実験する

Llama 3などの大規模言語モデルの驚異的な能力により、可能性は無限大です。このガイドが独自のAIコーディングツールの構築を始めるお手伝いになれば幸いです。楽しいコーディングを!