Step-Video-T2Vは、テキストからビデオへの生成における画期的な進歩を表し、大規模なニューラルアーキテクチャと革新的な圧縮技術を組み合わせて、最先端の結果を達成します。30億のパラメータを持つオープンソースモデルとして、独自の技術実装を通じてAI生成ビデオコンテンツの限界を押し広げています。

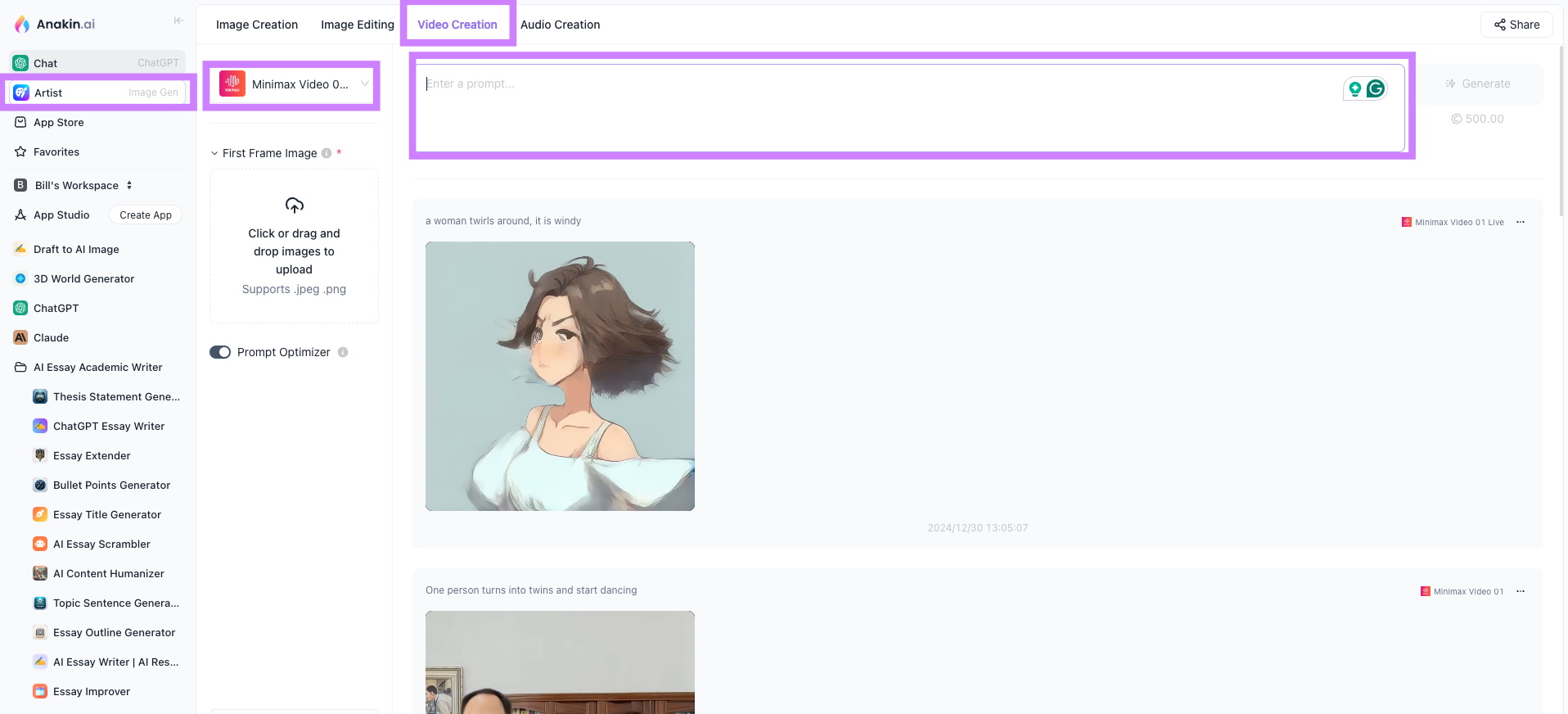

Anakin AI

Step-Video-T2Vのアーキテクチャの基盤

モデルのアーキテクチャは、協調して動作する3つのコアコンポーネントで構成されています。

Video-VAE圧縮エンジン

中心には、前例のない16x16の空間圧縮率と8xの時間圧縮率を達成する深い圧縮変分オートエンコーダがあります。これにより、

- 544x992解像度ビデオの潜在空間表現

- 34x62の空間次元に圧縮されたフレームシーケンス

- 204フレームのビデオを25の潜在ステップに減少させる時間的圧縮

VAEは、新しい量子化認識トレーニング技術を通じて再構成の忠実度を維持し、長いビデオシーケンスの効率的な処理を可能にします。

拡散トランスフォーマー(DiT)バックボーン

48層のトランスフォーマーアーキテクチャは、

- 空間的および時間的次元にわたる完全な3D注意メカニズム

- 各ヘッドにつき128次元埋め込みを持つ48の注意ヘッド

- シーケンスアライメント用の3D回転位置埋め込み(RoPE)

- トレーニングの安定性のためのQK-Normの安定化

- ノイズ予測のためのフローマッチング目的関数

バイリンガルテキストエンコーディングシステム

二重テキストプロセッサが多言語入力を処理します:

- Hunyuan-CLIP - 短いプロンプト(<77トークン)のための双方向エンコーダ

- Step-LLM - 複雑または長い説明のための自己回帰エンコーダ

ハイブリッドシステムは、クロスリンガルアラインメントを通じて英語と中国語のプロンプト両方の微妙な理解をサポートします。

Step-Video-T2Vのトレーニング手法

トレーニングパイプラインは4段階のアプローチを採用しています:

テキストから画像への事前訓練

- 視覚概念の理解を初期化

- 500M以上の画像-テキストペアでトレーニング

- 空間関係モデリングを確立

テキストからビデオへの基礎トレーニング

- 10Mのビデオクリップ(3-15秒)を処理

- 256x448解像度での動きのダイナミクスに焦点を当て

- 安定した収束のためにカリキュラム学習を実装

監視付きファインチューニング(SFT)

- 100万の高品質な人手注釈付きビデオを使用

- 美的品質とプロンプトアラインメントを強化

- スタイル転送機能を導入

直接好み最適化(DPO)

- ペアワイズ比較を通じた人間のフィードバック統合

- 視覚アーティファクトを37%削減(ベンチマークメトリクスによる)

- 報酬モデリングを通じて動きの滑らかさを改善

全体のトレーニングプロセスは、次のような分散インフラストラクチャを活用しています:

- 複数のクラスターにわたる4,096のNVIDIA H800 GPU

- クラスター間通信のためのカスタムRPCフレームワーク(StepRPC)

- 98%の帯域幅利用率を達成するハイブリッドTCP/RDMAプロトコル

Step-Video-T2Vの推論特性

モデルはユニークな操作要件を示します:

ハードウェア仕様

- 最小4x NVIDIA A100/A800 GPU(80GB VRAM)

- 204フレームのビデオ(544x992)の生成時間743秒

- 推論中のピ Peak メモリ使用量77.64GB

最適化技術

- テキストエンコーダ/VAE/DiT処理の分離

- フラッシュアテンションv2アクセラレーション

- 動的並列性管理

- 適応潜在空間キャッシング

主要推論パラメータ

| パラメータ | 推奨値 |

|---|---|

| 推論ステップ | 30-50 |

| CFGスケール | 9.0 |

| 時間シフト | 13.0 |

| 並列プロセス | 4-8 |

Step-Video-T2Vのパフォーマンスメトリック

独自のStep-Video-T2V-Evalベンチマークでの評価は以下を明らかにします:

- 人間の評価において商業ソリューションに対して89%の好ましさ率

- 以前のSOTAに対して23%の時間的一貫性の改善

- 41のFVDスコア(Fréchet Video Distance)

- テキスト-ビデオアラインメントのための0.82 CLIP-TScore

モデルは特に以下で優れています:

- 複雑なカメラモーション合成

- 複数のオブジェクトインタラクションシナリオ

- 長距離の時間的一貫性(150フレーム以上)

- クロスリンガルプロンプト理解

Step-Video-T2Vの技術的課題

現在の制限は研究の最前線を際立たせます:

物理シミュレーション

以下の正確なモデリングに苦戦しています:

- 流体力学(水流、煙)

- 剛体衝突

- 光の屈折/反射

構成理解

稀な概念の組み合わせに関する困難:

- 「砂漠を自転車で乗るペンギン」

- 「氷でできた透明な車」

計算スケーリング

トレーニングコストはフルパイプラインで800万ドルを超えます:

- 4,096のGPUで28日

- 9.7エクサFLOPの計算予算

時間的文脈

最大204フレーム(8.5秒)の生成制限:

- 物語のストーリーテリング

- 徐々に変化するシーンの移行

Step-Video-T2Vの実用的応用

オープンソースのリリースは多様な実装を可能にします:

コンテンツ作成

- 製品説明からの自動ビデオ広告

- ソーシャルメディアクリップの生成

- アニメスタイルのアニメーションプロトタイピング

映画制作

- 予視覚化ストーリーボード

- 背景シーンの生成

- 特殊効果の増強

教育ツール

- 歴史的イベント再現

- 科学的プロセスの可視化

- 状況ビデオを通じた言語学習

研究プラットフォーム

- ビデオ理解モデルのベースライン

- 新しい圧縮アルゴリズムのテストベッド

- 分散トレーニングシステムのベンチマーク

結論

Step-Video-T2Vは、大規模トランスフォーマー、先進的な圧縮技術、人間に alignedした最適化戦略の革新的な統合を通じて、オープンソースビデオ生成のための新しい技術基準を確立します。物理モデリングや計算要求の現在の制限が存在する一方で、モデルのアーキテクチャの革新とオープンな利用可能性は、動的視覚合成における将来の進歩に向けた重要な基盤を提供します。この作業を基にコミュニティが進展を遂げるにつれ、より効率的でアクセス可能かつ能力のあるビデオ生成システムに向けての迅速な進展を期待します。