Googleは、コンパクトでありながらパワフルなオープンソースの言語モデルであるGemma 2 2Bをリリースすることで、人工知能の世界で重要な動きを行いました。このGemmaファミリーの新しい追加は、AI技術の民主化を進める戦略的な一歩となりつつ、Googleの責任を持った効率的なAI開発に対する取り組みを継続しています。

Gemma 2 2Bのパワー

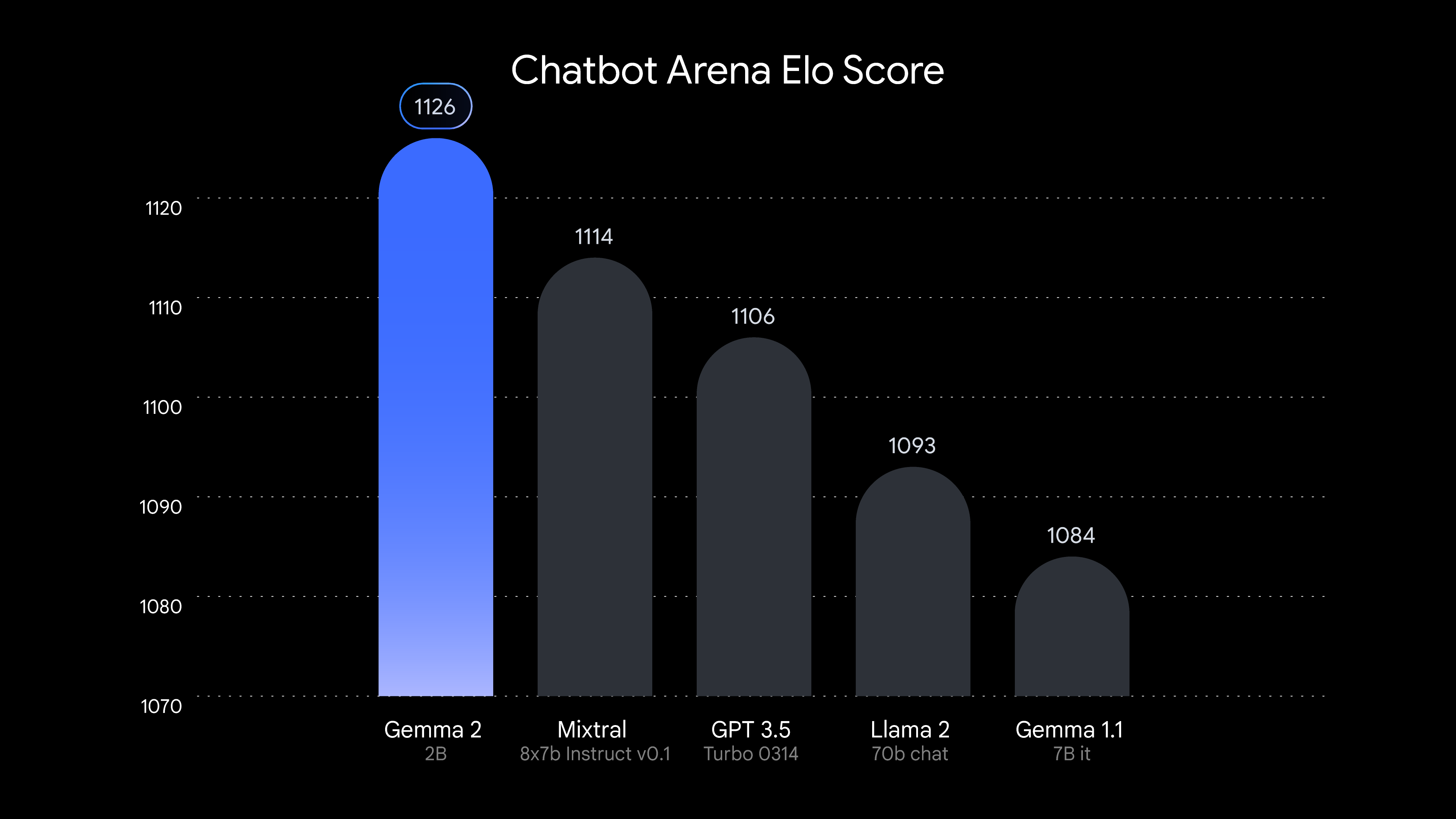

たった20億のパラメータしか持たないGemma 2 2Bは、意外なほどの能力を秘めています。LMSYS Chatbot Arenaのリーダーボードでは、GPT-3.5のいくつかのバリエーションを含む多くの大型モデルを上回る会話タスクでのパフォーマンスを発揮しています。この成果は、モデルの効率性とGoogleの先進的なトレーニング技術の有効性を示しています。

Gemma 2 2Bの技術仕様

Gemma 2 2Bは、さまざまな自然言語処理タスクに対応するテキストからテキストのデコーダだけの大規模な言語モデルです。以下はいくつかの主な技術的な詳細です。

- アーキテクチャ:デコーダ専用トランスフォーマー

- パラメータ:200億

- コンテキストの長さ:8,192トークン

- ボキャブラリーサイズ:256,000トークン

- トレーニングデータ:約2兆トークン

- モデルフォーマット:PyTorch、JAX、Hugging Face Transformersなどの人気フレームワークと互換性があります

Gemma 2 2Bは、質問応答、要約、創造的な文章作成、コード生成、推論など、さまざまなテキスト生成タスクで優れたパフォーマンスを発揮します。そのコンパクトなサイズにもかかわらず、ノートパソコン、デスクトップ、エッジコンピューティングプラットフォームなどのリソース制約のあるデバイスへの展開に適しています。

GoogleがGemma 2 2Bを最適化した方法

Googleは、Gemma 2 2Bをさまざまなハードウェア構成に最適化しました:

- NVIDIA GPU:広範なNVIDIA GPUで効率的な推論を可能にするTensorRT-LLMライブラリに最適化

- Google TPU:Tensor Processing Unitsのパワーを活用して、高速なトレーニングと推論を実現

- CPUの互換性:標準的なCPU上で実行可能であり、より多くの開発者にアクセス可能

Gemma 2 2B:オープンソースで、より良い

GoogleはGemma 2 2Bをオープンソースモデルとしてリリースすることで、AIコミュニティ内でのイノベーションとコラボレーションを促進しています。この動きにより、研究者や開発者は以下のことができます:

- モデルのアーキテクチャを調査および変更する

- モデルを特定のアプリケーションに合わせて微調整する

- モデルの改善に貢献する

- Gemmaのアーキテクチャに基づいた新しい技術を開発する

Gemma 2 vs Gemini:オープンソースの競争

Gemma 2 2Bはオープンソースですが、GoogleのクローズドソースモデルであるGeminiとの関係には注意が必要です。GemmaとGeminiは技術的な基盤を共有していますが、GoogleのAI戦略において異なる目的を持っています:

Gemma 2(オープンソース)

- 普及と実験に向けて設計されています

- 効率性とアクセシビリティに重点を置いています

- コミュニティ主導のイノベーションを推進します

Gemini(クローズドソース)

- 商業アプリケーション向けのGoogleの主力AIモデル

- 最大のパフォーマンスと高度な機能を提供します

- 特定のユースケースに厳密に制御されます

Gemma 2 2Bのリリースは、GoogleがオープンソースAIの進展を進める一方で、Geminiとの競争力を維持するというGoogleの取り組みを示しています。この二つの手法を組み合わせることで、Googleは以下のことができます:

- AI開発者や研究者のエコシステムを育成する

- オープンソースコミュニティからの洞察を収集する

- 進歩をGeminiモデルに組み込む可能性がある

Gemma 2が進化するにつれて、特定の領域でGeminiとのギャップが縮まり、GoogleによるオープンソースとクローズドソースのAI開発の間に魅力的なダイナミックが生まれる可能性があります。

責任あるAI開発:Gemma 2 2Bで組み込まれたもの

Googleは、Gemma 2 2Bの開発において責任あるAIの実践を優先しています:

データ前処理

- トレーニングデータの厳格なフィルタリングによる機密情報や有害なコンテンツの削除

- 個人情報を排除するための自動化技術

安全対策

- 人間のフィードバックに基づいた厳格な微調整と強化学習(RLHF)

- 責任ある行動および倫理的ガイドラインとの整合性

評価とテスト

- 潜在的な脆弱性の特定のための手動のレッドチーミング

- モデルのロバスト性を評価するための自動的な敵対的テスト

- リスクを軽減するためのモデル能力の包括的な評価

ShieldGemma:高度な安全機能

Gemma 2 2Bと並行して、GoogleはShieldGemmaを導入しました。これはGemma 2のアーキテクチャをベースにした一連の安全分類器であり、モデルの入力と出力の両方で有害なコンテンツを検出およびフィルタリングするために設計されています。主な関心事を対象にしています:

- ヘイトスピーチと露骨なコンテンツ

- 暴力とグロテスクなコンテンツ

- 嫌がらせといじめ

- 危険なまたは違法な活動

ShieldGemmaはさまざまなサイズで利用可能であり、異なるユースケースに対応する柔軟性を提供しています:

- リアルタイム分類用の2Bバージョン

- 時間の制約が少ないアプリケーションでの高い精度を持つ大きな9Bおよび27Bバリアント

Gemma Scope:モデルの解釈性の解明

透明性を促進し、責任あるAIの開発を支援するために、GoogleはGemma Scopeというツールセットをリリースしました。このスイートには400以上のスパース自己符号器(SAE)が含まれており、研究者は以下のことができます:

- モデルの活性化を視覚化および分析する

- モデル内の特定のパターンや動作を特定する

- 意思決定プロセスに対する洞察を得る

Gemma Scopeは、より解釈可能で責任あるAIシステムに向けた重要な一歩であり、モデルのデザインの改善とより安全なAIアプリケーションの実現につながる可能性があります。

開発と展開

Gemma 2 2Bは、プロジェクトにモデルを統合する開発者にさまざまなオプションを提供しています:

フレームワークとツール

- マルチフレームワークのサポート:Keras 3.0、PyTorch、JAX、Hugging Face Transformers

- クイックな実験のためのGoogle AI Studio

- スケーラブルな展開とMLOpsのためのGoogle Cloud上のVertex AI

ファインチューニングとカスタマイズ

- カスタムデータセットでのファインチューニングのサポート

- 要約や検索拡張生成(RAG)などの特定のアプリケーションに適応可能

展開オプション

- ノートパソコンやデスクトップ上のローカル展開

- エッジコンピューティングデバイス

- Google Cloudまたは他のプロバイダを介したクラウドベースのソリューション

コード例

以下はHugging Face Transformersライブラリを使用してGemma 2 2Bを使用するシンプルな例です:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# モデルとトークナイザーをロードする

tokenizer = AutoTokenizer.from_pretrained("google/gemma-2-2b")

model = AutoModelForCausalLM.from_pretrained("google/gemma-2-2b", device_map="auto")

# 入力テキストを準備する

input_text = "単純な言葉で人工知能の概念を説明してください。"

input_ids = tokenizer(input_text, return_tensors="pt").to(model.device)

# 応答を生成する

outputs = model.generate(**input_ids, max_new_tokens=100)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)

より高度なユースケースに向けて、開発者は量子化などの技術を利用してパフォーマンスをさらに最適化することができます:

from transformers import AutoTokenizer, AutoModelForCausalLM, BitsAndBytesConfig

# 4ビットの量子化を構成する

quantization_config = BitsAndBytesConfig(load_in_4bit=True)

# 量子化されたモデルをロードする

model = AutoModelForCausalLM.from_pretrained(

"google/gemma-2-2b",

quantization_config=quantization_config,

device_map="auto"

)

# 以前と同じようにモデルを使用する

今後の展開

Gemma 2 2BがAIコミュニティで注目を集めるにつれて、以下のようなことが期待されます:

- コミュニティ主導の改善と最適化

- モデルの効率性を活用した新しいアプリケーション

- 他のオープンソースAIツールやフレームワークとの統合

- 追加の言語やタスクのサポートへの拡張の可能性

Googleは、さまざまなアプリケーションに向けた新しいバリアントのGemmaを導入する計画を示唆しており、オープンソースのAIエコシステムへの継続的な取り組みを示しています。

結論

Gemma 2 2Bは、GoogleのAI戦略における重要なマイルストーンであり、先進的なクローズドソースモデルであるGeminiと広範なAI開発コミュニティとのギャップを埋める役割を果たしています。強力で効率的かつ責任ある設計のオープンソースモデルを提供することで、Googleは開発者と研究者にAI技術の限界を押し広げる機会を与えながら、安全性と倫理的考慮を重視しています。

AIの現場が進化を続ける中、GemmaとGeminiの相互作用が両面でのイノベーションを推進し、最終的には人工知能の分野全体に利益をもたらすでしょう。印象的なパフォーマンス、アクセシビリティ、堅牢な安全機能により、Gemma 2 2Bは、学術研究から商業アプリケーションまで、さまざまな領域のAI実践者にとって貴重なツールになることでしょう。